Dalle prime storie di robot di Isaac Asimov ad AlphaGo, l’IA ha avuto i suoi alti e bassi. Ma la sua storia è appena iniziata.

Di Mark Sullivan

L’intelligenza artificiale è ancora nella sua giovinezza. Ma sono già successe cose molto grandi. Alcuni di loro hanno catturato l’attenzione della cultura, mentre altri hanno prodotto onde d’urto avvertite principalmente all’interno dei confini soffocanti del mondo accademico. Questi sono alcuni dei momenti chiave che hanno spinto l’IA in avanti nei modi più profondi.

Dalle prime storie di robot di Isaac Asimov ad AlphaGo, l’IA ha avuto i suoi alti e bassi. Ma la sua storia è appena iniziata.

Di Mark Sullivan

L’intelligenza artificiale è ancora nella sua giovinezza. Ma sono già successe cose molto grandi. Alcuni di loro hanno catturato l’attenzione della cultura, mentre altri hanno prodotto onde d’urto avvertite principalmente all’interno dei confini soffocanti del mondo accademico. Questi sono alcuni dei momenti chiave che hanno spinto l’IA in avanti nei modi più profondi.

- Isaac Asimov scrive le tre leggi della robotica (1942)

La storia di Asimov “Runaround” segna la prima volta che il famoso autore di fantascienza ha elencato per intero le sue ” Tre leggi della robotica “:

Prima legge: un robot non può ferire un essere umano o, per inazione, permettere a un essere umano di farsi del male.

Seconda legge: un robot deve obbedire agli ordini impartiti dagli esseri umani, tranne nei casi in cui tali ordini vadano in conflitto con la prima legge.

Terza legge: un robot deve proteggere la propria esistenza purché tale protezione non sia in conflitto con la Prima o la Seconda Legge.

“Runaround” racconta la storia di Speedy, un robot messo in una situazione in cui il bilanciamento della terza legge con i primi due sembra impossibile. Le storie di Asimov nella serie Robot hanno portato i fan della fantascienza, alcuni dei quali scienziati, a pensare alla possibilità di pensare alle macchine. Ancora oggi, molte persone passano attraverso l’esercizio intellettuale dell’applicazione delle leggi di Asimov alla moderna IA . - Alan Turing propone il gioco dell’imitazione (1950)

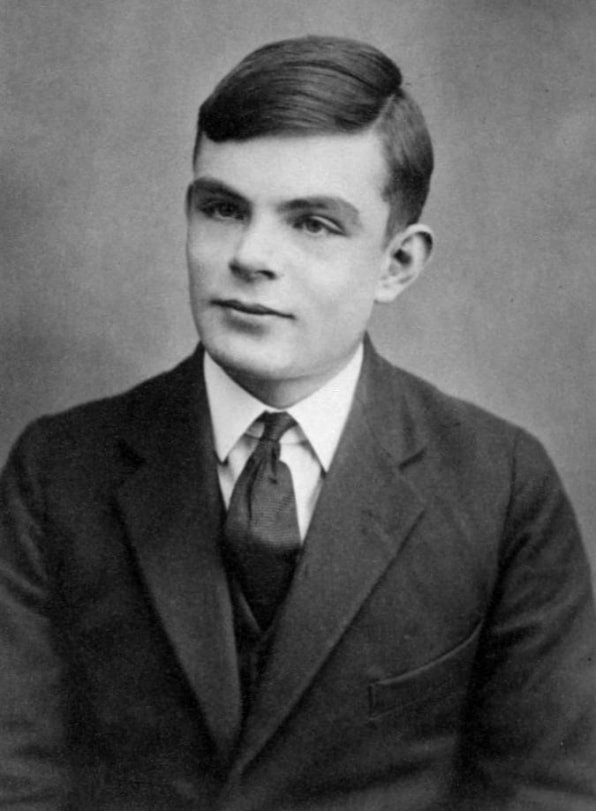

Alan Turing ha creato il primo punto di riferimento per misurare la sensibilità della macchina nel 1950. Foto: sconosciuto / Wikimedia Commons

“Propongo di considerare la questione ‘macchine possono pensare?’” Allora cominciò di Alan Turing seminale 1950 documento di ricerca che ha sviluppato un quadro di riflessione sulla intelligenza artificiale. Ha chiesto perché, se una macchina potesse imitare il comportamento senziente di un essere umano, non sarebbe essa stessa senziente.

Questa domanda teorica ha dato origine al famoso “Gioco d’imitazione” di Turing, un esercizio in cui un “interrogatore” umano è sfidato a distinguere tra le risposte di solo testo di una macchina e un essere umano. Nessuna macchina in grado di superare un test del genere esisteva nell’era di Turing, o lo è oggi. Ma il suo test ha fornito un semplice punto di riferimento per identificare l’intelligenza in una macchina. Ha contribuito a dare forma a una filosofia di intelligenza artificiale.

- Dartmouth tiene una conferenza AI (1956)

Nel 1955, gli scienziati di tutto il mondo avevano iniziato a pensare concettualmente a cose come le reti neurali e il linguaggio naturale, ma non esisteva un concetto unificante per avvolgere vari tipi di intelligenza artificiale. Un professore di matematica del Dartmouth College di nome John McCarthy ha coniato il termine “intelligenza artificiale” per incapsulare tutto.

McCarthy guidò un gruppo che fece domanda per una sovvenzione per tenere una conferenza di intelligenza artificiale l’anno successivo. Hanno invitato a Dartmouth Hall molti dei migliori ricercatori scientifici avanzati del giorno per l’evento nell’estate del 1956. Gli scienziati hanno discusso di numerose potenziali aree di studio dell’IA, tra cui apprendimento e ricerca, visione, ragionamento, linguaggio e cognizione, giochi (in particolare gli scacchi) e interazioni umane con macchine intelligenti come robot personali.

Il consenso generale delle discussioni era che l’IA aveva un grande potenziale a beneficio degli esseri umani. Hanno prodotto un quadro generale di aree di ricerca in cui l’intelligenza artificiale potrebbe avere un impatto. La conferenza ha organizzato ed energizzato l’IA come disciplina di ricerca per gli anni a venire. - Frank Rosenblatt costruisce Perceptron (1957)

Frank Rosenblatt costruì una rete neurale meccanica presso il Cornell Aeronautical Laboratory nel 1957.

La struttura di base di una rete neurale è chiamata ” perceptron ” . È una serie di input che riportano i dati a un nodo che quindi calcola gli input e arriva a una classificazione ea un livello di confidenza. Ad esempio, gli input potrebbero analizzare diversi aspetti di un’immagine e “votare” (con vari livelli di sicurezza) sulla presenza di un volto rappresentato in esso. Il nodo potrebbe quindi calcolare i “voti” e i livelli di confidenza e ottenere un consenso. Le reti neurali di oggi, in esecuzione su potenti computer, collegano miliardi di queste strutture.

Ma i percettroni esistevano ben prima dei potenti computer. Alla fine degli anni ’50, un giovane psicologo ricercatore di nome Frank Rosenblatt costruì un modello elettromeccanico di un percettrone chiamato Mark I Perceptron , che oggi siede nello Smithsonian. Era una rete neurale analogica che consisteva in una griglia di celle fotoelettriche sensibili alla luce collegate da fili a banche di nodi contenenti motori elettrici con resistori rotanti. Rosenblatt ha sviluppato un “algoritmo di Perceptron” che ha diretto la rete per ottimizzare gradualmente i suoi punti di forza di input fino a quando non hanno identificato correttamente gli oggetti in modo coerente, permettendogli così di imparare.

Gli scienziati hanno discusso della rilevanza del Perceptron negli anni ’80. Era importante per creare un’incarnazione fisica della rete neurale, che fino a quel momento era stata principalmente un concetto accademico.

- Ai il primo inverno della intelligenza artificiale (anni ’70)

L’intelligenza artificiale ha trascorso gran parte della sua storia nel regno della ricerca. Per gran parte degli anni ’60, agenzie governative come la DARPA (Defense Advanced Research Projects Agency) degli Stati Uniti hanno investito denaro nella ricerca e chiesto poco sull’eventuale ritorno sul loro investimento. E i ricercatori dell’IA spesso sovraprendono il potenziale del loro lavoro in modo da poter mantenere i loro finanziamenti. Tutto è cambiato tra la fine degli anni ’60 e l’inizio degli anni ’70. Due rapporti, il Comitato consultivo per l’elaborazione automatica delle lingue (ALPAC) riportano al governo degli Stati Uniti nel 1966 e il rapporto Lighthillper il governo britannico nel 1973, ha esaminato la ricerca dell’intelligenza artificiale in modo pragmatico e ha restituito analisi molto pessimistiche sul potenziale della tecnologia. Entrambe le relazioni hanno messo in dubbio il progresso tangibile di varie aree della ricerca sull’IA. Il rapporto Lighthill sosteneva che l’IA per compiti come il riconoscimento vocale sarebbe molto difficile da ridimensionare a dimensioni utili al governo o ai militari.

Di conseguenza, sia il governo degli Stati Uniti che il governo britannico hanno iniziato a tagliare i finanziamenti per la ricerca universitaria sull’IA. Il DARPA, attraverso il quale i finanziamenti per la ricerca sull’IA erano fluiti liberamente durante la maggior parte degli anni ’60, chiedeva ora che le proposte di ricerca arrivassero con tempistiche chiare e descrizioni dettagliate dei risultati. Ciò ha fatto apparire l’IA come una delusione che potrebbe non raggiungere mai le capacità a livello umano. Il primo “inverno” di AI è durato negli anni ’70 e negli anni ’80. - Il secondo inverno della intelligenza artificiale (1987)

Gli anni ’80 si aprirono con lo sviluppo e il successo di ” sistemi esperti ” , che immagazzinavano grandi quantità di conoscenza del dominio ed emulavano il processo decisionale di esperti umani. La tecnologia è stata originariamente sviluppata da Carnegie Mellon per Digital Equipment Corporation e le aziende hanno implementato rapidamente la tecnologia. Ma i sistemi esperti richiedevano hardware costoso e specializzato, che divenne un problema quando le workstation Sun Microsystems e i personal computer Apple e IBM diventarono disponibili con potenza comparabile e prezzi più bassi. Il mercato dei computer di sistemi esperti è crollato nel 1987, con i principali fornitori di macchine che hanno lasciato il mercato.

Il successo dei sistemi di esperti nei primi anni ’80 aveva incoraggiato la DARPA ad aumentare i finanziamenti per la ricerca sull’IA, ma ciò è cambiato di nuovo quando l’agenzia ha soffocato di nuovo gran parte dei finanziamenti verso l’IA per tutti tranne alcuni programmi scelti manualmente. Ancora una volta il termine “intelligenza artificiale” divenne quasi un tabù nella comunità di ricerca. Per evitare di essere visti come sognatori impraticabili che chiedono finanziamenti, i ricercatori hanno iniziato a usare nomi diversi per il lavoro relativo all’intelligenza artificiale, come “informatica”, “apprendimento automatico” e “analisi”. Questo secondo “inverno AI” è durato fino agli anni 2000. - Deep Blue di IBM batte Kasparov (1997)

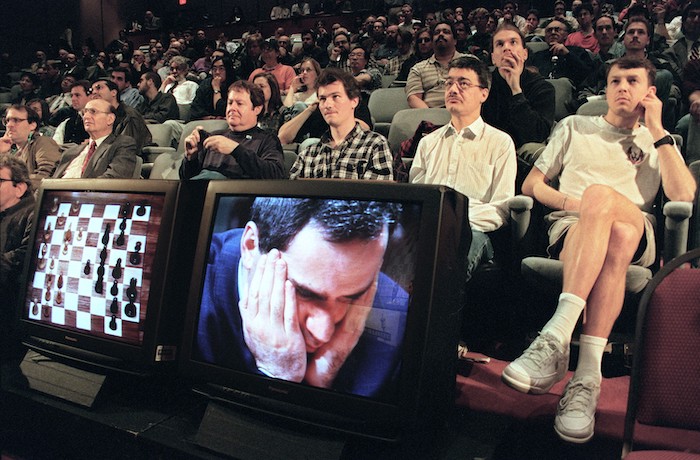

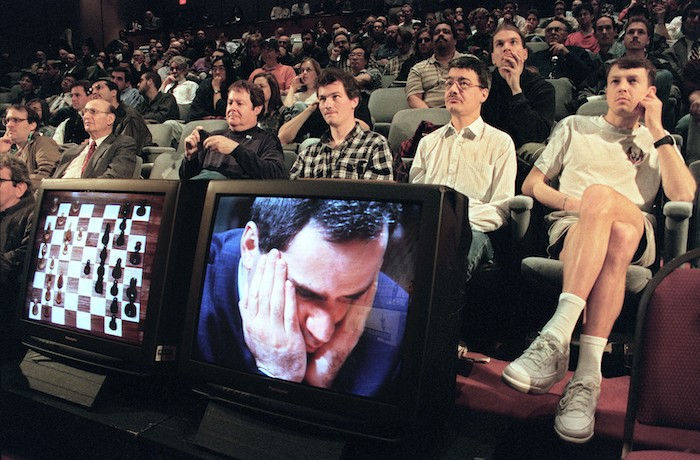

Deep Blue di IBM ha sconfitto il miglior giocatore di scacchi umano del mondo, Gary Kasparov, nel 1997.

Il profilo pubblico dell’intelligenza artificiale ebbe una spinta nel 1997 quando il computer per scacchi Deep Blue di IBM sconfisse il campione del mondo di allora Garry Kasparov negli scacchi. In una serie di sei partite giocate in uno studio televisivo, Deep Blue ne vinse due, Kasparov ne vinse una e tre partite terminarono in parità. Kasparov aveva sconfitto una versione precedente di Deep Blue l’anno prima.

Deep Blue aveva molta potenza di calcolo e utilizzava un approccio a “forza bruta”, valutando 200 milioni di possibili mosse al secondo per trovare la migliore possibile. Gli umani hanno la capacità di esaminare solo circa 50 mosse per turno. L’effetto di Deep Blue era simile all’intelligenza artificiale, ma il computer in realtà non stava pensando alla strategia e all’apprendimento come giocava, come farebbero i sistemi successivi.

Tuttavia, la vittoria di Deep Blue su Kasparov ha riportato l’IA alla mente del pubblico in modo impressionante. Alcune persone erano affascinate. Altri erano a disagio con una macchina che batteva un giocatore di scacchi umano di livello esperto. Gli investitori sono rimasti colpiti: la vittoria di Deep Blue ha spinto le azioni IBM a salire di $ 10 a un massimo storico.

- Una rete neurale vede i gatti (2011)

Entro il 2011, gli scienziati delle università di tutto il mondo stavano parlando e creando reti neurali. Quell’anno, l’ingegnere di Google Jeff Dean incontrò un professore di informatica di Stanford di nome Andrew Ng. I due nacquero l’idea di costruire una grande rete neurale, dandole un’enorme potenza di calcolo utilizzando le risorse del server di Google e alimentandolo con un enorme set di immagini.

La rete neurale che costruirono attraversava 16.000 processori server. Gli hanno fornito 10 milioni di schermate casuali senza etichetta da YouTube. Dean e Ng non hanno chiesto alla rete neurale di fornire informazioni specifiche o di etichettare le immagini. Quando le reti neurali funzionano in questo modo senza supervisione, cercheranno naturalmente di trovare modelli nei dati e classificare i moduli.

La rete neurale ha elaborato i dati dell’immagine per tre giorni. Ha quindi restituito un output contenente tre immagini sfocate che descrivevano schemi visivi che aveva visto più volte nelle immagini di prova: un volto umano, un corpo umano e un gatto. Quella ricerca è stata un importante passo avanti nell’uso delle reti neurali e dell’apprendimento senza supervisione nei compiti di visione artificiale. L’evento ha anche segnato l’inizio del progetto Google Brain. - Geoffrey Hinton libera le reti neurali profonde (2012)

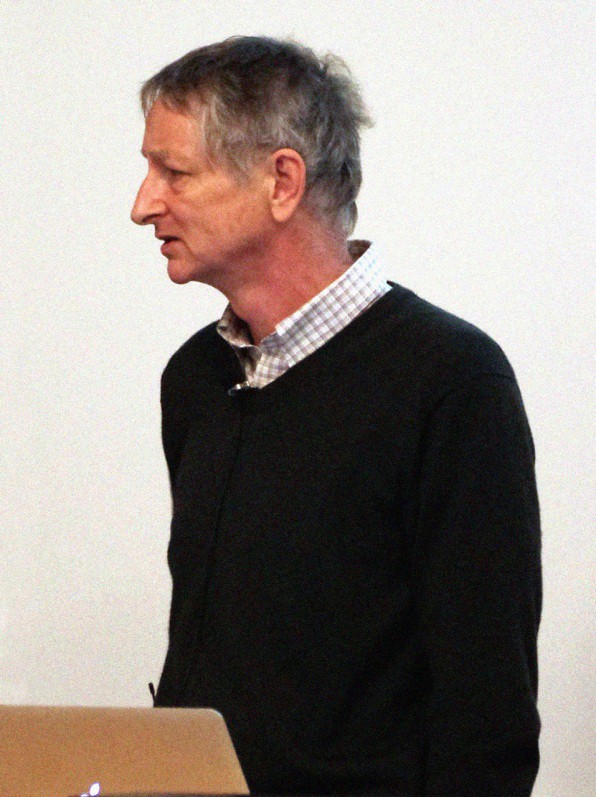

La ricerca di Geoffrey Hinton presso l’Università di Toronto ha contribuito alla rinascita dell’apprendimento profondo. Foto: Eviatar Bach / Wikimedia Commons

L’anno dopo la svolta di Dean e Ng, il professore Geoffrey Hinton dell’Università di Toronto e due suoi studenti hanno costruito un modello di rete neurale di visione artificiale chiamato AlexNet per competere in un concorso di riconoscimento delle immagini chiamato ImageNet . I partecipanti dovevano utilizzare i loro sistemi per elaborare milioni di immagini di prova e identificarle con la massima precisione possibile. AlexNet ha vinto il concorso con un tasso di errore inferiore alla metà di quello del secondo classificato. Solo nel 15,3% dei casi l’etichetta corretta non era tra le prime cinque risposte più probabili di AlexNet. Il precedente miglior punteggio era stato del 26%.

La vittoria ha dimostrato chiaramente che le reti neurali profonde in esecuzione su processori grafici erano di gran lunga migliori rispetto ad altri sistemi per identificare e classificare accuratamente le immagini. Questo, forse più di ogni altro singolo evento, ha dato il via all’attuale rinascimento nelle reti neurali profonde, guadagnando a Hinton il soprannome di “padrino dell’apprendimento profondo”. Insieme ai compagni guru dell’IA Yoshua Bengio e Yann LeCun, Hinton ha vinto l’ambito premio Turing per 2018.

- AlphaGo batte i i campioni mondiali di Go (2016)

Nel 2013, i ricercatori di una startup britannica chiamata DeepMind hanno pubblicato un documento che mostrava come potevano usare una rete neurale per giocare e battere 50 vecchi giochi Atari. Impressionato, Google ha rapito l’azienda per un valore di $ 400 milioni. Ma i giorni di gloria di DeepMind erano in anticipo.

Diversi anni dopo, gli scienziati di DeepMind, ora all’interno di Google, passarono dai giochi Atari a una delle sfide più antiche di AI, il gioco da tavolo giapponese Go. Hanno sviluppato un modello di rete neurale chiamato AlphaGo progettato per giocare a Go e imparare giocando. Il software ha giocato a migliaia di giochi contro altre versioni AlphaGo, imparando sia dalle sue strategie vincenti che da quelle perdenti.

Ha funzionato. AlphaGo ha sconfitto il più grande giocatore Go del mondo, Lee Sedol, quattro partite in una in una serie di partite nel marzo 2016. L’intera vicenda è stata catturata in un documentario . Guardandolo, è difficile perdere il senso di tristezza quando Sedol viene sconfitto. Sembrava che gli umani – non solo un umano – fossero stati sconfitti.

I recenti progressi nelle reti neurali profonde hanno avuto un impatto così radicale che la vera storia dell’intelligenza artificiale potrebbe essere solo all’inizio. Ci sarà ancora molta speranza, clamore e impazienza, ma ora sembra chiaro che l’intelligenza artificiale avrà un impatto su ogni aspetto della vita del 21 ° secolo, forse in modi persino più profondi di Internet.

Di Mark Sullivan

L’intelligenza artificiale è ancora nella sua giovinezza. Ma sono già successe cose molto grandi. Alcuni di loro hanno catturato l’attenzione della cultura, mentre altri hanno prodotto onde d’urto avvertite principalmente all’interno dei confini soffocanti del mondo accademico. Questi sono alcuni dei momenti chiave che hanno spinto l’IA in avanti nei modi più profondi.

- Isaac Asimov scrive le tre leggi della robotica (1942)

La storia di Asimov “Runaround” segna la prima volta che il famoso autore di fantascienza ha elencato per intero le sue ” Tre leggi della robotica “:

Prima legge: un robot non può ferire un essere umano o, per inazione, permettere a un essere umano di farsi del male.

Seconda legge: un robot deve obbedire agli ordini impartiti dagli esseri umani, tranne nei casi in cui tali ordini vadano in conflitto con la prima legge.

Terza legge: un robot deve proteggere la propria esistenza purché tale protezione non sia in conflitto con la Prima o la Seconda Legge.

“Runaround” racconta la storia di Speedy, un robot messo in una situazione in cui il bilanciamento della terza legge con i primi due sembra impossibile. Le storie di Asimov nella serie Robot hanno portato i fan della fantascienza, alcuni dei quali scienziati, a pensare alla possibilità di pensare alle macchine. Ancora oggi, molte persone passano attraverso l’esercizio intellettuale dell’applicazione delle leggi di Asimov alla moderna IA . - Alan Turing propone il gioco dell’imitazione (1950)

Alan Turing ha creato il primo punto di riferimento per misurare la sensibilità della macchina nel 1950. Foto: sconosciuto / Wikimedia Commons

“Propongo di considerare la questione ‘macchine possono pensare?’” Allora cominciò di Alan Turing seminale 1950 documento di ricerca che ha sviluppato un quadro di riflessione sulla intelligenza artificiale. Ha chiesto perché, se una macchina potesse imitare il comportamento senziente di un essere umano, non sarebbe essa stessa senziente.

Questa domanda teorica ha dato origine al famoso “Gioco d’imitazione” di Turing, un esercizio in cui un “interrogatore” umano è sfidato a distinguere tra le risposte di solo testo di una macchina e un essere umano. Nessuna macchina in grado di superare un test del genere esisteva nell’era di Turing, o lo è oggi. Ma il suo test ha fornito un semplice punto di riferimento per identificare l’intelligenza in una macchina. Ha contribuito a dare forma a una filosofia di intelligenza artificiale.

- Dartmouth tiene una conferenza AI (1956)

Nel 1955, gli scienziati di tutto il mondo avevano iniziato a pensare concettualmente a cose come le reti neurali e il linguaggio naturale, ma non esisteva un concetto unificante per avvolgere vari tipi di intelligenza artificiale. Un professore di matematica del Dartmouth College di nome John McCarthy ha coniato il termine “intelligenza artificiale” per incapsulare tutto.

McCarthy guidò un gruppo che fece domanda per una sovvenzione per tenere una conferenza di intelligenza artificiale l’anno successivo. Hanno invitato a Dartmouth Hall molti dei migliori ricercatori scientifici avanzati del giorno per l’evento nell’estate del 1956. Gli scienziati hanno discusso di numerose potenziali aree di studio dell’IA, tra cui apprendimento e ricerca, visione, ragionamento, linguaggio e cognizione, giochi (in particolare gli scacchi) e interazioni umane con macchine intelligenti come robot personali.

Il consenso generale delle discussioni era che l’IA aveva un grande potenziale a beneficio degli esseri umani. Hanno prodotto un quadro generale di aree di ricerca in cui l’intelligenza artificiale potrebbe avere un impatto. La conferenza ha organizzato ed energizzato l’IA come disciplina di ricerca per gli anni a venire. - Frank Rosenblatt costruisce Perceptron (1957)

Frank Rosenblatt costruì una rete neurale meccanica presso il Cornell Aeronautical Laboratory nel 1957.

La struttura di base di una rete neurale è chiamata ” perceptron ” . È una serie di input che riportano i dati a un nodo che quindi calcola gli input e arriva a una classificazione ea un livello di confidenza. Ad esempio, gli input potrebbero analizzare diversi aspetti di un’immagine e “votare” (con vari livelli di sicurezza) sulla presenza di un volto rappresentato in esso. Il nodo potrebbe quindi calcolare i “voti” e i livelli di confidenza e ottenere un consenso. Le reti neurali di oggi, in esecuzione su potenti computer, collegano miliardi di queste strutture.

Ma i percettroni esistevano ben prima dei potenti computer. Alla fine degli anni ’50, un giovane psicologo ricercatore di nome Frank Rosenblatt costruì un modello elettromeccanico di un percettrone chiamato Mark I Perceptron , che oggi siede nello Smithsonian. Era una rete neurale analogica che consisteva in una griglia di celle fotoelettriche sensibili alla luce collegate da fili a banche di nodi contenenti motori elettrici con resistori rotanti. Rosenblatt ha sviluppato un “algoritmo di Perceptron” che ha diretto la rete per ottimizzare gradualmente i suoi punti di forza di input fino a quando non hanno identificato correttamente gli oggetti in modo coerente, permettendogli così di imparare.

Gli scienziati hanno discusso della rilevanza del Perceptron negli anni ’80. Era importante per creare un’incarnazione fisica della rete neurale, che fino a quel momento era stata principalmente un concetto accademico.

- Ai il primo inverno della intelligenza artificiale (anni ’70)

L’intelligenza artificiale ha trascorso gran parte della sua storia nel regno della ricerca. Per gran parte degli anni ’60, agenzie governative come la DARPA (Defense Advanced Research Projects Agency) degli Stati Uniti hanno investito denaro nella ricerca e chiesto poco sull’eventuale ritorno sul loro investimento. E i ricercatori dell’IA spesso sovraprendono il potenziale del loro lavoro in modo da poter mantenere i loro finanziamenti. Tutto è cambiato tra la fine degli anni ’60 e l’inizio degli anni ’70. Due rapporti, il Comitato consultivo per l’elaborazione automatica delle lingue (ALPAC) riportano al governo degli Stati Uniti nel 1966 e il rapporto Lighthillper il governo britannico nel 1973, ha esaminato la ricerca dell’intelligenza artificiale in modo pragmatico e ha restituito analisi molto pessimistiche sul potenziale della tecnologia. Entrambe le relazioni hanno messo in dubbio il progresso tangibile di varie aree della ricerca sull’IA. Il rapporto Lighthill sosteneva che l’IA per compiti come il riconoscimento vocale sarebbe molto difficile da ridimensionare a dimensioni utili al governo o ai militari.

Di conseguenza, sia il governo degli Stati Uniti che il governo britannico hanno iniziato a tagliare i finanziamenti per la ricerca universitaria sull’IA. Il DARPA, attraverso il quale i finanziamenti per la ricerca sull’IA erano fluiti liberamente durante la maggior parte degli anni ’60, chiedeva ora che le proposte di ricerca arrivassero con tempistiche chiare e descrizioni dettagliate dei risultati. Ciò ha fatto apparire l’IA come una delusione che potrebbe non raggiungere mai le capacità a livello umano. Il primo “inverno” di AI è durato negli anni ’70 e negli anni ’80. - Il secondo inverno della intelligenza artificiale (1987)

Gli anni ’80 si aprirono con lo sviluppo e il successo di ” sistemi esperti ” , che immagazzinavano grandi quantità di conoscenza del dominio ed emulavano il processo decisionale di esperti umani. La tecnologia è stata originariamente sviluppata da Carnegie Mellon per Digital Equipment Corporation e le aziende hanno implementato rapidamente la tecnologia. Ma i sistemi esperti richiedevano hardware costoso e specializzato, che divenne un problema quando le workstation Sun Microsystems e i personal computer Apple e IBM diventarono disponibili con potenza comparabile e prezzi più bassi. Il mercato dei computer di sistemi esperti è crollato nel 1987, con i principali fornitori di macchine che hanno lasciato il mercato.

Il successo dei sistemi di esperti nei primi anni ’80 aveva incoraggiato la DARPA ad aumentare i finanziamenti per la ricerca sull’IA, ma ciò è cambiato di nuovo quando l’agenzia ha soffocato di nuovo gran parte dei finanziamenti verso l’IA per tutti tranne alcuni programmi scelti manualmente. Ancora una volta il termine “intelligenza artificiale” divenne quasi un tabù nella comunità di ricerca. Per evitare di essere visti come sognatori impraticabili che chiedono finanziamenti, i ricercatori hanno iniziato a usare nomi diversi per il lavoro relativo all’intelligenza artificiale, come “informatica”, “apprendimento automatico” e “analisi”. Questo secondo “inverno AI” è durato fino agli anni 2000. - Deep Blue di IBM batte Kasparov (1997)

Deep Blue di IBM ha sconfitto il miglior giocatore di scacchi umano del mondo, Gary Kasparov, nel 1997.

Il profilo pubblico dell’intelligenza artificiale ebbe una spinta nel 1997 quando il computer per scacchi Deep Blue di IBM sconfisse il campione del mondo di allora Garry Kasparov negli scacchi. In una serie di sei partite giocate in uno studio televisivo, Deep Blue ne vinse due, Kasparov ne vinse una e tre partite terminarono in parità. Kasparov aveva sconfitto una versione precedente di Deep Blue l’anno prima.

Deep Blue aveva molta potenza di calcolo e utilizzava un approccio a “forza bruta”, valutando 200 milioni di possibili mosse al secondo per trovare la migliore possibile. Gli umani hanno la capacità di esaminare solo circa 50 mosse per turno. L’effetto di Deep Blue era simile all’intelligenza artificiale, ma il computer in realtà non stava pensando alla strategia e all’apprendimento come giocava, come farebbero i sistemi successivi.

Tuttavia, la vittoria di Deep Blue su Kasparov ha riportato l’IA alla mente del pubblico in modo impressionante. Alcune persone erano affascinate. Altri erano a disagio con una macchina che batteva un giocatore di scacchi umano di livello esperto. Gli investitori sono rimasti colpiti: la vittoria di Deep Blue ha spinto le azioni IBM a salire di $ 10 a un massimo storico.

- Una rete neurale vede i gatti (2011)

Entro il 2011, gli scienziati delle università di tutto il mondo stavano parlando e creando reti neurali. Quell’anno, l’ingegnere di Google Jeff Dean incontrò un professore di informatica di Stanford di nome Andrew Ng. I due nacquero l’idea di costruire una grande rete neurale, dandole un’enorme potenza di calcolo utilizzando le risorse del server di Google e alimentandolo con un enorme set di immagini.

La rete neurale che costruirono attraversava 16.000 processori server. Gli hanno fornito 10 milioni di schermate casuali senza etichetta da YouTube. Dean e Ng non hanno chiesto alla rete neurale di fornire informazioni specifiche o di etichettare le immagini. Quando le reti neurali funzionano in questo modo senza supervisione, cercheranno naturalmente di trovare modelli nei dati e classificare i moduli.

La rete neurale ha elaborato i dati dell’immagine per tre giorni. Ha quindi restituito un output contenente tre immagini sfocate che descrivevano schemi visivi che aveva visto più volte nelle immagini di prova: un volto umano, un corpo umano e un gatto. Quella ricerca è stata un importante passo avanti nell’uso delle reti neurali e dell’apprendimento senza supervisione nei compiti di visione artificiale. L’evento ha anche segnato l’inizio del progetto Google Brain. - Geoffrey Hinton libera le reti neurali profonde (2012)

La ricerca di Geoffrey Hinton presso l’Università di Toronto ha contribuito alla rinascita dell’apprendimento profondo. Foto: Eviatar Bach / Wikimedia Commons

L’anno dopo la svolta di Dean e Ng, il professore Geoffrey Hinton dell’Università di Toronto e due suoi studenti hanno costruito un modello di rete neurale di visione artificiale chiamato AlexNet per competere in un concorso di riconoscimento delle immagini chiamato ImageNet . I partecipanti dovevano utilizzare i loro sistemi per elaborare milioni di immagini di prova e identificarle con la massima precisione possibile. AlexNet ha vinto il concorso con un tasso di errore inferiore alla metà di quello del secondo classificato. Solo nel 15,3% dei casi l’etichetta corretta non era tra le prime cinque risposte più probabili di AlexNet. Il precedente miglior punteggio era stato del 26%.

La vittoria ha dimostrato chiaramente che le reti neurali profonde in esecuzione su processori grafici erano di gran lunga migliori rispetto ad altri sistemi per identificare e classificare accuratamente le immagini. Questo, forse più di ogni altro singolo evento, ha dato il via all’attuale rinascimento nelle reti neurali profonde, guadagnando a Hinton il soprannome di “padrino dell’apprendimento profondo”. Insieme ai compagni guru dell’IA Yoshua Bengio e Yann LeCun, Hinton ha vinto l’ambito premio Turing per 2018.

- AlphaGo batte i i campioni mondiali di Go (2016)

Nel 2013, i ricercatori di una startup britannica chiamata DeepMind hanno pubblicato un documento che mostrava come potevano usare una rete neurale per giocare e battere 50 vecchi giochi Atari. Impressionato, Google ha rapito l’azienda per un valore di $ 400 milioni. Ma i giorni di gloria di DeepMind erano in anticipo.

Diversi anni dopo, gli scienziati di DeepMind, ora all’interno di Google, passarono dai giochi Atari a una delle sfide più antiche di AI, il gioco da tavolo giapponese Go. Hanno sviluppato un modello di rete neurale chiamato AlphaGo progettato per giocare a Go e imparare giocando. Il software ha giocato a migliaia di giochi contro altre versioni AlphaGo, imparando sia dalle sue strategie vincenti che da quelle perdenti.

Ha funzionato. AlphaGo ha sconfitto il più grande giocatore Go del mondo, Lee Sedol, quattro partite in una in una serie di partite nel marzo 2016. L’intera vicenda è stata catturata in un documentario . Guardandolo, è difficile perdere il senso di tristezza quando Sedol viene sconfitto. Sembrava che gli umani – non solo un umano – fossero stati sconfitti.

I recenti progressi nelle reti neurali profonde hanno avuto un impatto così radicale che la vera storia dell’intelligenza artificiale potrebbe essere solo all’inizio. Ci sarà ancora molta speranza, clamore e impazienza, ma ora sembra chiaro che l’intelligenza artificiale avrà un impatto su ogni aspetto della vita del 21 ° secolo, forse in modi persino più profondi di Internet.