La rivoluzione del generatore da testo a immagine è in pieno svolgimento con strumenti come DALL-E 2 e GLIDE di OpenAI, nonché Imagen di Google, che stanno guadagnando enorme popolarità, anche in versione beta, da quando ciascuno è stato introdotto nell’ultimo anno.

Questi tre strumenti sono tutti esempi di una tendenza nei sistemi di intelligence: sintesi da testo a immagine o un modello generativo esteso alle didascalie delle immagini per produrre nuove scene visive.

Il futuro del servizio clienti basato sull’intelligenza artificiale

I sistemi intelligenti in grado di creare immagini e video hanno un’ampia gamma di applicazioni, dall’intrattenimento all’istruzione, con il potenziale per essere utilizzati come soluzioni accessibili per le persone con disabilità fisiche. Gli strumenti di progettazione grafica digitale sono ampiamente utilizzati nella creazione e nella modifica di molte moderne opere culturali e artistiche. Tuttavia, la loro complessità può renderli inaccessibili a chiunque non abbia le necessarie conoscenze tecniche o infrastrutture.

Ecco perché i sistemi in grado di seguire istruzioni basate su testo e quindi eseguire un’attività di modifica delle immagini corrispondente stanno cambiando il gioco quando si tratta di accessibilità. Questi vantaggi possono essere facilmente estesi anche ad altri domini della generazione di immagini, come i giochi, l’animazione e la creazione di materiale didattico visivo.

L’ascesa dei generatori di intelligenza artificiale da testo a immagine

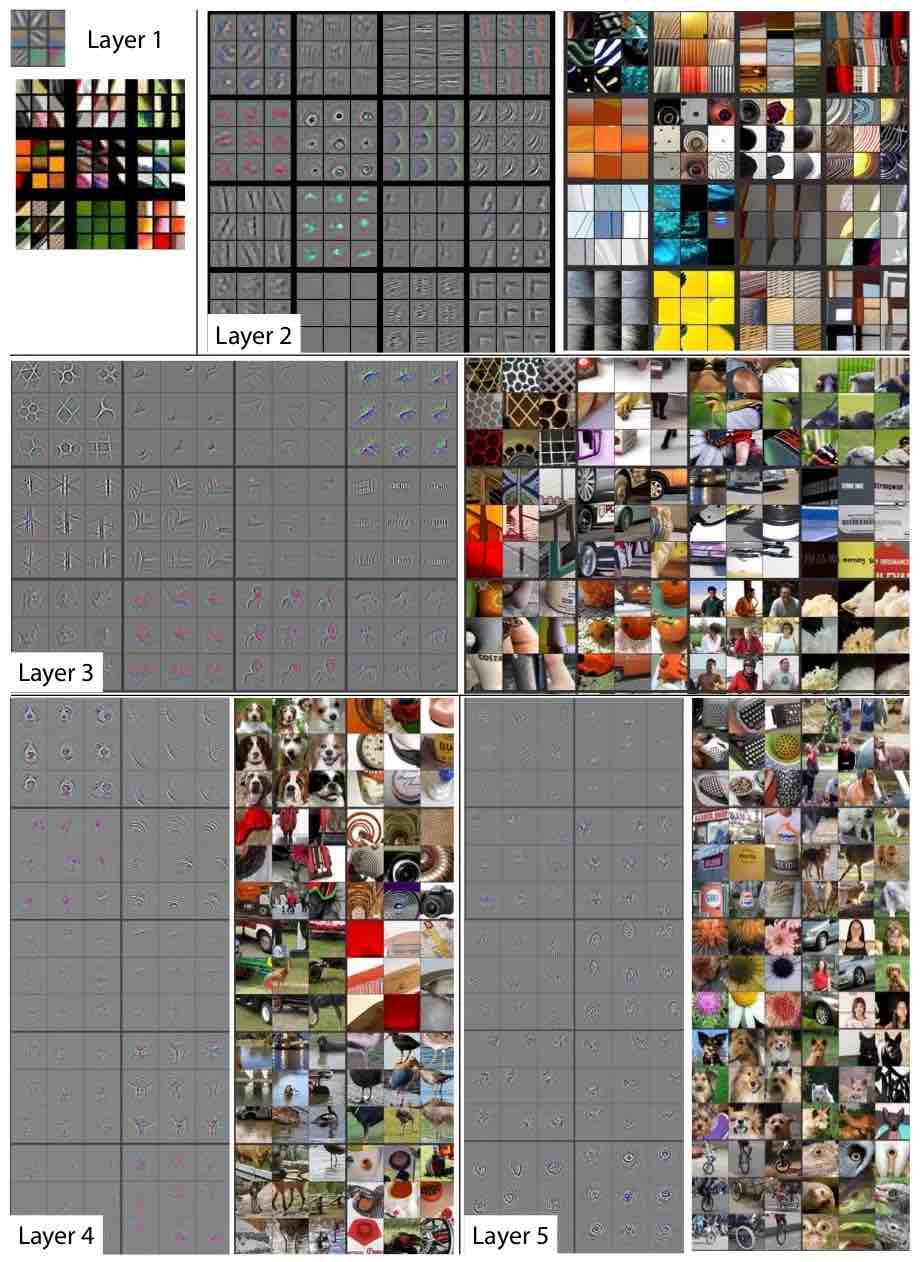

L’intelligenza artificiale è progredita negli ultimi dieci anni a causa di tre fattori significativi: l’aumento dei big data, l’emergere di potenti GPU e il riemergere del deep learning. I sistemi di intelligenza artificiale del generatore stanno aiutando il settore tecnologico a realizzare la sua visione del futuro dell’informatica ambientale: l’idea che un giorno le persone saranno in grado di utilizzare i computer in modo intuitivo senza dover essere a conoscenza di particolari sistemi o codifica.

I generatori di intelligenza artificiale da testo a immagine ora si stanno lentamente trasformando dalla generazione di immagini oniriche alla produzione di ritratti realistici. Alcuni addirittura ipotizzano che l’ arte dell’IA supererà le creazioni umane . Molti degli odierni sistemi di generazione da testo a immagine si concentrano sull’apprendimento della generazione iterativa di immagini basate su input linguistici continui, proprio come può fare un artista umano.

Questo processo è noto come visuale neurale generativa, un processo fondamentale per i trasformatori, ispirato al processo di trasformazione graduale di una tela bianca in una scena. I sistemi addestrati per eseguire questa attività possono sfruttare i progressi nella generazione di immagini singole condizionate dal testo.

Come si distinguono 3 strumenti di intelligenza artificiale da testo a immagine

Gli strumenti di intelligenza artificiale che imitano la comunicazione e la creatività simili a quelle umane sono sempre stati interessanti. Negli ultimi quattro anni, i grandi giganti della tecnologia hanno dato la priorità alla creazione di strumenti per produrre immagini automatizzate.

Ci sono stati diversi rilasci degni di nota negli ultimi mesi: alcuni sono stati fenomeni immediati non appena sono stati rilasciati, anche se erano disponibili solo per un gruppo relativamente piccolo per i test.

Esaminiamo la tecnologia di tre dei generatori di testo a immagine più discussi rilasciati di recente e cosa li distingue.

DALL-E 2: Diffusion di OpenAI crea immagini all’avanguardia

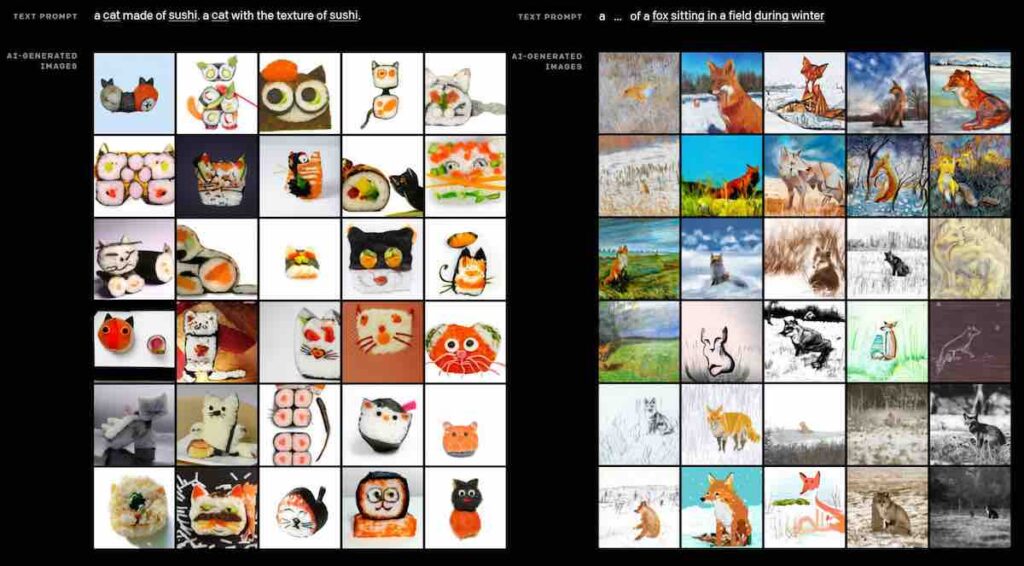

Rilasciato ad aprile, DALL-E 2 è il più recente generatore di testo a immagine di OpenAI e successore di DALL-E, un modello di linguaggio generativo che prende frasi e crea immagini originali.

Un modello di diffusione è il cuore di DALL-E 2, che può aggiungere e rimuovere istantaneamente elementi tenendo conto di ombre, riflessi e trame. La ricerca attuale mostra che i modelli di diffusione sono emersi come un promettente quadro di modellazione generativa, spingendo le attività di generazione di immagini e video all’avanguardia. Per ottenere i migliori risultati, il modello di diffusione in DALL-E 2 utilizza un metodo guida per ottimizzare la fedeltà del campione (per il fotorealismo) al prezzo della diversità del campione.

DALL-E 2 apprende la relazione tra immagini e testo attraverso la “diffusione”, che inizia con uno schema di punti casuali, alterandosi gradualmente verso un’immagine in cui riconosce aspetti specifici dell’immagine. Con una dimensione di 3,5 miliardi di parametri, DALL-E 2 è un modello grande ma, cosa interessante, non è grande quanto GPT-3 ed è più piccolo del suo predecessore DALL-E (che era di 12 miliardi). Nonostante le sue dimensioni, DALL-E 2 genera una risoluzione quattro volte migliore di DALL-E ed è preferita dai giudici umani più del 70% delle volte sia per la corrispondenza dei sottotitoli che per il fotorealismo.

Il modello versatile può andare oltre le generazioni da frase a immagine e utilizzando robusti incorporamenti di CLIP , un sistema di visione artificiale di OpenAI per mettere in relazione il testo con l’immagine, può creare diverse varianti di output per un dato input, preservando le informazioni semantiche e stilistiche elementi. Inoltre, rispetto ad altri modelli di rappresentazione delle immagini, CLIP incorpora immagini e testo nello stesso spazio latente, consentendo manipolazioni di immagini guidate dal linguaggio.

Sebbene il condizionamento della generazione di immagini sugli incorporamenti CLIP migliori la diversità, uno svantaggio specifico è che presenta alcune limitazioni. Ad esempio, unCLIP, che genera immagini invertendo il decodificatore di immagini CLIP, è peggiore nel vincolare gli attributi agli oggetti rispetto a un modello GLIDE corrispondente. Questo perché l’incorporamento CLIP stesso non lega in modo esplicito le caratteristiche agli oggetti ed è stato riscontrato che le ricostruzioni dal decoder spesso confondono attributi e oggetti. Alle scale di guida più elevate utilizzate per generare immagini fotorealistiche, unCLIP offre una maggiore diversità per fotorealismo comparabile e somiglianza delle didascalie.

GLIDE di OpenAI: modifiche realistiche alle immagini esistenti

La diffusione guidata da lingua a immagine per la generazione e l’editing di OpenAI, nota anche come GLIDE , è stata rilasciata a dicembre 2021. GLIDE può creare automaticamente immagini fotorealistiche da prompt in linguaggio naturale, consentendo agli utenti di creare materiale visivo attraverso un perfezionamento iterativo più semplice e una gestione a grana fine delle immagini create.

Questo modello di diffusione raggiunge prestazioni paragonabili a DALL-E, nonostante utilizzi solo un terzo dei parametri (3,5 miliardi rispetto ai 12 miliardi di parametri di DALL-E). GLIDE può anche convertire i disegni al tratto di base in foto fotorealistiche grazie alle sue potenti capacità di produzione e riparazione senza campioni per circostanze complicate. Inoltre, GLIDE utilizza un ritardo di campionamento minore e non richiede il riordino CLIP.

In particolare, il modello può anche eseguire la pittura di immagini o apportare modifiche realistiche alle immagini esistenti tramite prompt in linguaggio naturale. Questo lo rende uguale in funzione a editor come Adobe Photoshop, ma più facile da usare.

Le modifiche prodotte dal modello si adattano allo stile e all’illuminazione del contesto circostante, comprese ombre e riflessi convincenti. Questi modelli possono potenzialmente aiutare gli esseri umani a creare immagini personalizzate accattivanti con velocità e facilità senza precedenti, riducendo significativamente la produzione di disinformazione efficace o Deepfake. Per salvaguardarsi da questi casi d’uso aiutando al contempo la ricerca futura, il team di OpenAI ha anche rilasciato un modello di diffusione più piccolo e un modello CLIP rumoroso addestrato su set di dati filtrati.

Fonte immagine: IA aperta

Imagen by Google: maggiore comprensione degli input basati su testo

Annunciato a giugno , Imagen è un generatore di testo in immagine creato dal Brain Team di Google Research. È simile, ma diverso da DALL-E 2 e GLIDE.

Il Brain Team di Google mirava a generare immagini con maggiore precisione e fedeltà utilizzando il metodo delle frasi brevi e descrittive. Il modello analizza ogni sezione della frase come un pezzo di informazione digeribile e tenta di produrre un’immagine che sia il più vicino possibile a quella frase.

Imagen si basa sull’abilità di modelli di linguaggio di trasformazione di grandi dimensioni per la comprensione sintattica, mentre disegna la forza dei modelli di diffusione per la generazione di immagini ad alta fedeltà. Contrariamente al lavoro precedente che utilizzava solo dati immagine-testo per l’addestramento del modello, la scoperta fondamentale di Google è stata che gli incorporamenti di testo da modelli linguistici di grandi dimensioni, se pre-addestrati su corpora di solo testo (set di testi grandi e strutturati), sono notevolmente efficaci per il testo- sintesi per immagine. Inoltre, attraverso l’aumento delle dimensioni del modello linguistico, Imagen aumenta sia la fedeltà del campione che l’allineamento del testo dell’immagine molto più che aumentare le dimensioni del modello di diffusione dell’immagine.

Invece di utilizzare un set di dati immagine-testo per l’addestramento di Imagen , il team di Google ha semplicemente utilizzato un codificatore di testo “pronto all’uso”, T5, per convertire il testo di input in incorporamenti. Il codificatore T5-XXL congelato mappa il testo di input in una sequenza di incorporamenti e un modello di diffusione dell’immagine 64 × 64, seguito da due modelli di diffusione a super risoluzione per la generazione di immagini 256 × 256 e 1024 × 1024. I modelli di diffusione sono condizionati dalla sequenza di incorporamento del testo e utilizzano una guida priva di classificatore, basandosi su nuove tecniche di campionamento per utilizzare grandi pesi di guida senza degrado della qualità del campione.

Imagen ha ottenuto un punteggio FID all’avanguardia di 7,27 sul set di dati COCO senza essere mai stato addestrato su COCO. Quando è stato valutato su DrawBench con i metodi attuali, tra cui VQ-GAN+CLIP, Latent Diffusion Models, GLIDE e DALL-E 2, Imagen ha dimostrato di offrire risultati migliori sia in termini di qualità del campione che di allineamento immagine-testo.

Opportunità e sfide future del text-to-image

Non c’è dubbio che la rapida evoluzione della tecnologia del generatore di intelligenza artificiale da testo a immagine sta aprendo la strada a opportunità senza precedenti per l’editing istantaneo e l’output creativo generato.

Ci sono anche molte sfide da affrontare, che vanno da domande su etica e pregiudizi (sebbene i creatori abbiano implementato salvaguardie all’interno dei modelli progettati per limitare le applicazioni potenzialmente distruttive) a questioni relative al diritto d’autore e alla proprietà . L’enorme quantità di potenza di calcolo richiesta per addestrare modelli da testo a immagine attraverso enormi quantità di dati limita anche il lavoro ai soli giocatori significativi e con risorse adeguate.

Ma non c’è dubbio che ciascuno di questi tre modelli di intelligenza artificiale da testo a immagine rappresenti da solo un modo per i professionisti creativi di dare libero sfogo alla loro immaginazione.