Un team di ricercatori ha recentemente applicato processori fotonici ad applicazioni di intelligenza artificiale , dimostrando che i processori fotonici possono superare notevolmente la capacità di elaborazione delle informazioni dei normali chip elettronici.

Il team di ricerca ha sviluppato una nuova architettura di chip e un nuovo approccio che combina capacità di archiviazione e elaborazione dei dati in un unico dispositivo. I chip sono stati realizzati con materiali a cambiamento di fase (come quelli usati nei DVD). I processori fotonici (basati sulla luce) vengono utilizzati per produrre un chip per computer in grado di eseguire calcoli ad alta velocità e in uno studio recentemente pubblicato su Nature, il team di ricerca è stato in grado di dimostrare che questi nuovi chip erano in grado di migliorare notevolmente rispetto ai tradizionali chip elettronici, grazie alla loro capacità di elaborare rapidamente le informazioni in parallelo.

Moltiplicazioni matrice-vettore

Le reti neurali che sono alla base di molte delle applicazioni AI più all’avanguardia operano attraverso moltiplicazioni matrice-vettore. Il team di ricerca ha creato un sistema di accelerazione basato su hardware che consente di eseguire queste moltiplicazioni in parallelo. I chip ottici sfruttano il fatto che diverse lunghezze d’onda della luce non interferiscono tra loro, il che significa che possono essere utilizzate per eseguire calcoli in parallelo. Il team di ricerca si è basato su un “pettine di frequenza” sviluppato dall’EPFL, utilizzandolo come sorgente di luce per fornire al chip fotonico le varie lunghezze d’onda.

Lo sviluppo del pettine di frequenza è stato guidato dal professor Tobias Kippenberg all’EPFL. Kippenburg è uno degli autori principali dello studio insieme al coautore Wolfram Pernice dell’Università di Münster. Secondo Pernice, i processori basati sulla luce possono accelerare le attività computazionalmente intense coinvolte nell’apprendimento automatico , eseguendo calcoli a velocità ancora più elevate rispetto a hardware specializzato come Tensor Processing Unit (TPU) e le GPU più avanzate.

Formazione sulla rete neurale

Dopo che i chip fotonici sono stati progettati e costruiti, i ricercatori li hanno messi alla prova testandoli su una rete neurale progettata per riconoscere numeri scritti a mano. Il processo di addestramento della rete neurale ha sfruttato il multiplexing della lunghezza d’onda abilitato dai chip ed è stato in grado di raggiungere velocità di trasmissione dati e densità di elaborazione più elevate rispetto a quelle mai raggiunte prima.

Come Johannes Feldmann, autore principale dello studio e studente laureato presso l’Università di Münster, ha spiegato tramite TechXplore :

“L’operazione convoluzionale tra i dati di input e uno o più filtri, che può essere un’evidenziazione dei bordi in una foto, ad esempio, può essere trasferita molto bene alla nostra architettura a matrice. Lo sfruttamento della luce per il trasferimento del segnale consente al processore di eseguire l’elaborazione parallela dei dati attraverso il multiplexing della lunghezza d’onda, che porta a una densità di calcolo più elevata e molte moltiplicazioni di matrici eseguite in un solo passo temporale. “

Il lavoro è notevole grazie al fatto che potrebbe consentire di addestrare reti neurali su grandi set di dati in quello che potrebbe essere una frazione del tempo tipico necessario per addestrare una rete. Man mano che i big data diventano sempre più grandi, gonfiati dall’Internet delle cose e dalla crescente proliferazione di dispositivi intelligenti, i data scientist avranno bisogno di nuovi modi per mantenere i tempi di formazione su enormi set di dati il più bassi possibile. L’elettronica tradizionale opera tipicamente nella gamma dei bassi GHz, mentre le velocità di modulazione ottica possono arrivare fino alla gamma da 50 GHz a 100 GHz.

La ricerca potrebbe avere importanti implicazioni per applicazioni come il cloud computing, l’imaging medico e i veicoli autonomi, che richiedono tutti la capacità di elaborare grandi volumi di dati provenienti da più fonti il più rapidamente possibile.

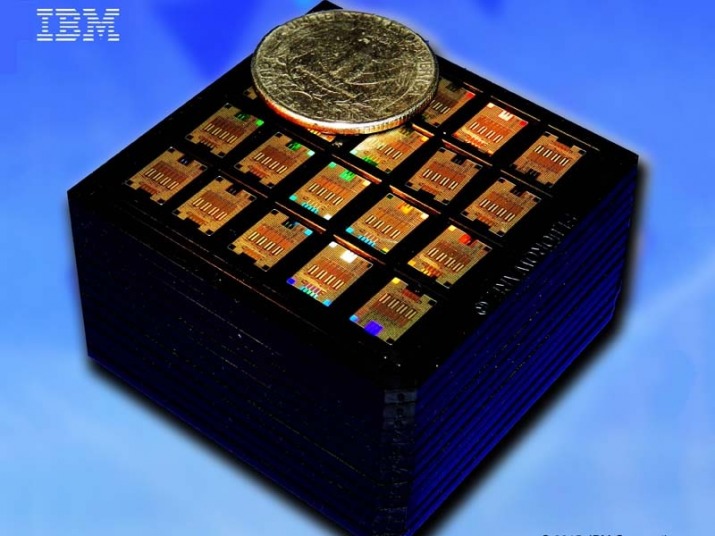

Il progetto di ricerca è stato il risultato di una collaborazione tra un team internazionale di ricercatori della Pitt Univesity, l’Università di Münster in Germania, le università inglesi di Exeter e Oxford, IBM di Zurigo e l’École Polytechnique Fédérale (EPFL) in Svizzera.