In che modo la lingua può essere utilizzata per compiti di esplorazione nell’apprendimento per rinforzo

I ricercatori di DeepMind hanno introdotto un nuovo metodo in cui gli agenti sono dotati di conoscenze pregresse sotto forma di astrazioni derivate da modelli linguistici di visione ampia che sono preaddestrati sui dati dei sottotitoli delle immagini.

L’esplorazione è una parte importante dell’apprendimento per rinforzo ; qui, gli agenti imparano a prevedere e controllare ambienti stocastici e sconosciuti. L’esplorazione è essenziale perché recupera informazioni importanti, la cui mancanza potrebbe ostacolare un apprendimento efficace. Detto questo, è uno dei compiti impegnativi. Nel corso degli anni di ricerca, è stato scoperto che un modo efficace per aumentare la tendenza di un agente all’esplorazione è aumentare le traiettorie con ricompense intrinseche per il raggiungimento di nuovi stati ambientali. Tuttavia, la sfida qui ancora è su quali stati siano considerati nuovi: questo, a sua volta, si basa su come sono rappresentati gli stati ambientali.

Per affrontare questa sfida, i ricercatori di DeepMind hanno introdotto un nuovo metodo in cui gli agenti sono dotati di conoscenze pregresse sotto forma di astrazioni derivate da modelli linguistici di visione ampia che sono preaddestrati sui dati dei sottotitoli delle immagini.

La ricerca

In precedenza, il lavoro di ricerca sull’esplorazione guidata dalla novità ha offerto diversi approcci per derivare la rappresentazione dello stato negli agenti di apprendimento per rinforzo. Tra i metodi più popolari c’è l’utilizzo di funzionalità casuali in cui lo stato è rappresentato dall’incorporamento di osservazioni visive con reti target fisse e inizializzate in modo casuale. Un altro metodo popolare è l’apprendimento delle caratteristiche visive tratte da un modello di dinamica inversa.

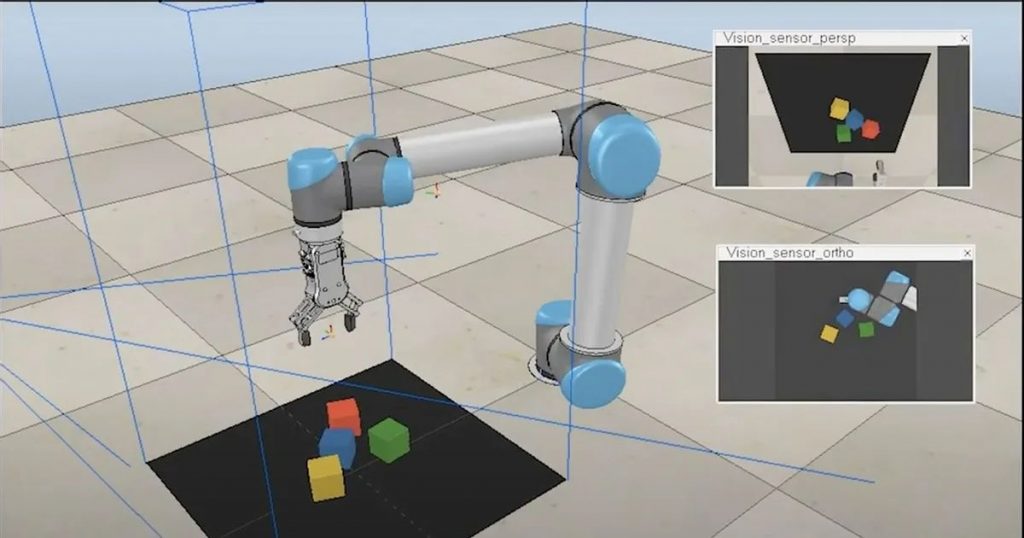

Entrambi questi metodi, e altri simili, funzionano bene per gli ambienti 2D classici; la loro efficacia per ambienti 3D ad alta dimensionalità e parzialmente osservabili non è ancora dimostrata. Negli ambienti 3D, ci sono sfide come diversi punti di vista della stessa mappa della scena su caratteristiche distinte; pertanto, c’è difficoltà nell’identificare una buona mappatura tra stato visivo e spazio delle caratteristiche, che è ulteriormente esacerbata dal fatto che le astrazioni di stato utili dipendono fortemente dal compito. I ricercatori di DeepMind nel loro articolo chiamano l’acquisizione di rappresentazioni dell’ambiente che supportano un’esplorazione efficace come un problema di “uovo e gallina”. Ciò significa che un agente può capire se due stati devono essere considerati simili o diversi solo dopo aver esplorato efficacemente il proprio ambiente.

Ora, cosa succede se a un agente vengono insegnate rappresentazioni sotto forma di astrazioni derivate da modelli linguistici? Questo è ciò che hanno fatto i ricercatori di DeepMind. Hanno ipotizzato che le rappresentazioni acquisite da questi pre-allenamento di visione-linguaggio si traducano in un’esplorazione efficace degli ambienti 3D perché sono modellati dalla natura astratta unica dei modelli linguistici.

I ricercatori sono stati in grado di dimostrare che l’astrazione del linguaggio e il linguaggio visivo preaddestrato migliorano l’efficienza del campione dei metodi di esplorazione esistenti. Il vantaggio di questo modello è visibile in algoritmi on e off-policy, diversi domini 3D e altre specifiche di attività. Il team ha anche progettato esperimenti di controllo per capire in che modo il linguaggio contribuisce a una migliore esplorazione e ha scoperto che i loro risultati sono coerenti con le prospettive delle scienze cognitive sull’utilità del linguaggio umano.

Linguaggio da esplorare

Usare la lingua per imparare l’esplorazione non è un metodo nuovo. Molti ricercatori prima hanno anche esplorato questa tecnica. Nel 2021, un gruppo di ricercatori di Stanford ha introdotto Exploration through Learned Language Abstraction (ELLA), un approccio di modellazione della ricompensa per aumentare l’efficienza del campione in ambienti di ricompensa scarsa correlando istruzioni di alto livello con componenti più semplici. Più specificamente, questo approccio aveva due componenti importanti: un classificatore di terminazione per identificare quando gli agenti completano le istruzioni di basso livello e un classificatore di rilevanza che correla le istruzioni di basso livello con il successo su attività di alto livello.

All’inizio di quest’anno, un gruppo di ricercatori ha pubblicato un documento intitolato – Migliorare l’esplorazione intrinseca con le astrazioni linguistiche, che ha mostrato come il linguaggio naturale potrebbe essere utilizzato come mezzo generale per evidenziare le astrazioni rilevanti in un ambiente. Questo lavoro era diverso dai precedenti perché i ricercatori hanno valutato se il linguaggio potesse migliorare rispetto ai metodi di esplorazione esistenti estendendosi direttamente alle linee di base dell’esplorazione competitiva come AMIGo e NovelD. Hanno riscontrato un miglioramento del 45-85% rispetto alle loro controparti non linguistiche.