Riceviamo un gran numero di e-mail ogni giorno. Contengono una combinazione di e-mail spam e non spam. Il filtraggio automatico delle e-mail per la classificazione delle e-mail spam e non spam è un’applicazione molto importante. Scoprire il sentimento intorno a una certa quantità di testo aiuta a determinare la percezione di un prodotto o di un evento o simile da parte del pubblico in generale. Questa è definita analisi del sentiment ed è un’altra applicazione di testo comune. L’analisi del sentiment di Twitter è una delle applicazioni più comunemente viste per misurare il sentimento dei consumatori a causa di un evento recente o del lancio di un determinato prodotto, ecc.

Il tipo di applicazioni menzionate sopra sono problemi di classificazione binaria o multiclasse , cioè avrebbero la possibilità di due o più esiti di un evento. Questo tipo di problema ci dice di optare per alcuni algoritmi di classificazione come la regressione logistica, gli algoritmi basati su alberi, le macchine a vettori di supporto , le Naive Bayes ecc. sono desiderati. In applicazioni come il filtraggio dello spam e l’analisi del sentiment, i dati consistono principalmente nei dati testuali sotto forma di recensioni o nel contenuto di un’e-mail.

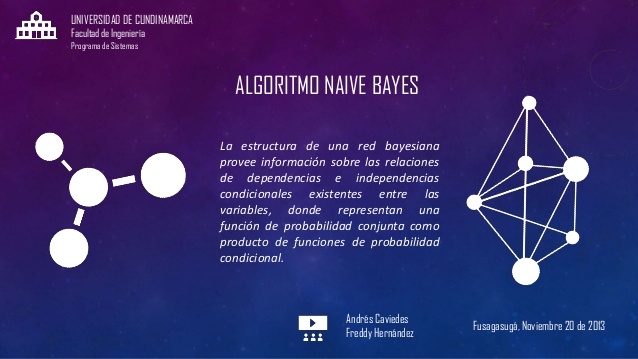

L’algoritmo bayesiano ingenuo è un semplice algoritmo di classificazione che utilizza la probabilità degli eventi per il suo scopo. Si basa sul teorema di Bayes che presuppone che non vi sia interdipendenza tra le variabili. Ad esempio, se un frutto è una banana e deve essere di colore giallo / verde, a forma di banana e con un raggio di 1-2 cm. Tutte le proprietà sopra indicate contribuiscono individualmente al fatto che il frutto sia una banana e quindi queste caratteristiche sono chiamate “ingenue”. Poiché considerava il set di funzionalità Naive, l’algoritmo bayesiano Naive può essere addestrato utilizzando meno dati di addestramento e anche dati con etichette errate.

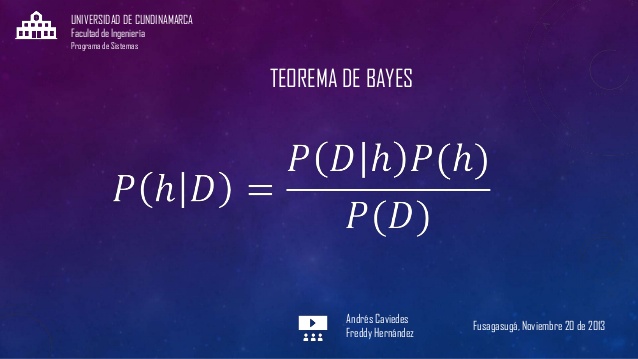

Il teorema di Bayes si basa sulla seguente formula:

P (A / B) = P (A) x P (B / A) P (B)

Qui stiamo calcolando la probabilità a posteriori della classe A quando ci viene fornito il predittore B, es. P (A / B). P (A) è la probabilità a priori della classe. P (B / A) è la probabilità del predittore B data la probabilità di classe A. P (B) è la probabilità a priori del predittore B. Il calcolo di queste probabilità ci aiuterà a calcolare le probabilità delle parole nel testo.

La statistica bayesiana è diversa dalla statistica generale in vari modi che un calcolo di probabilità generale viene sempre fatto intorno a eventi casuali con un numero ripetuto di prove mentre la statistica bayesiana è coinvolta nel calcolo delle probabilità a priori e a posteriori. La statistica bayesiana fornisce la leva sulle probabilità di cambiamento che possono verificarsi prima e dopo un determinato evento.

Il classificatore bayesiano ingenuo consiste nell’eseguire i passaggi seguenti:

Crea una tabella delle frequenze basata sulle parole

Calcola la probabilità per ciascuna delle classi in base alla tabella delle frequenze

Calcola la probabilità a posteriori per ogni classe

La più alta probabilità a posteriori è il risultato dell’esperimento di previsione

Tutte queste probabilità sono calcolate utilizzando il teorema di Bayes. Poiché l’algoritmo Naive Bayes presuppone le caratteristiche “Naive”, funziona molto meglio di altri algoritmi come la regressione logistica, gli algoritmi basati su albero ecc. Il classificatore Naive Bayes è molto più veloce con i suoi calcoli di probabilità.

Esistono diversi tipi di implementazioni bayesiane ingenue –

Gaussian Naive Bayes

Questo è il tipo di algoritmo utilizzato quando tutte le caratteristiche seguono una distribuzione normale. Tutte le caratteristiche sono valutate continuamente. Il presupposto è che non vi sia covarianza tra le caratteristiche indipendenti.

Naive Bayes multinomiale

Viene generalmente utilizzato in presenza di funzionalità discrete (ad esempio, il conteggio delle parole in un problema di classificazione del testo). Generalmente funziona con i conteggi interi generati come frequenza per ogni parola. Tutte le funzionalità seguono la distribuzione multinomiale. In questi casi funziona anche TF-IDF (Term Frequency, Inverse Document Frequency).

Bernoulli Naive Bayes

Questo classificatore funziona anche con dati discreti. La principale differenza tra Multinomial Naive Bayes e Bernoulli è che Multinomial Naive Bayes funziona con i conteggi delle occorrenze mentre Bernoulli lavora con le caratteristiche binarie / booleane. Ad esempio, i valori delle caratteristiche sono nella forma vero / falso, sì / no, 1/0, ecc. È meglio visualizzarlo con l’aiuto di un istogramma.

Diverse varianti del classificatore Naive Bayes funzionano tutte con la stessa analogia di indipendenza delle caratteristiche. Il modo in cui sono stati progettati i diversi tipi di classificatori bayesiani ingenui funzionano molto bene su tutti i tipi di problemi relativi al testo. La classificazione dei documenti è uno di questi esempi di un problema di classificazione del testo che può essere risolto utilizzando sia Multinomial che Bernoulli Naive Bayes. Il calcolo delle probabilità è la ragione principale per cui questo algoritmo è un algoritmo amichevole per la classificazione del testo e uno dei preferiti tra le masse. Questo classificatore è molto utilizzato per le previsioni in tempo reale e anche nei sistemi di raccomandazione insieme al filtro collaborativo.