Un’esplosione cambriana nell’apprendimento profondo, parte 2: le startup

Approfondimenti e strategia

Questo è il secondo dei tre articoli sullo stato del mercato dei chip di intelligenza artificiale e cosa succederà nel 2019. L’anno sarà un festival di nuovi chip e battaglie di riferimento, guidati dalle grandi aziende che ho citato nel primo blog ( Intel INTC -5,47%, Google GOOGL + 1,49%, AMD , Xilinx XLNX + 4,1%, Apple AAPL + 3,31%, Qualcomm QCOM + 0,96%), e si è unito a dozzine di startup della Silicon Valley e di Unicorni cinesi con valutazioni superiori a un miliardo di dollari USA. In questa sezione, parlerò delle più importanti, o almeno le più rumorose, delle startup in Occidente e in Cina, dove il governo è intento a creare un’industria di chip di intelligenza artificiale indigena. Inizieremo con Wave, che sembra essere il primo sul mercato con il silicio per l’allenamento.

Wave Computing

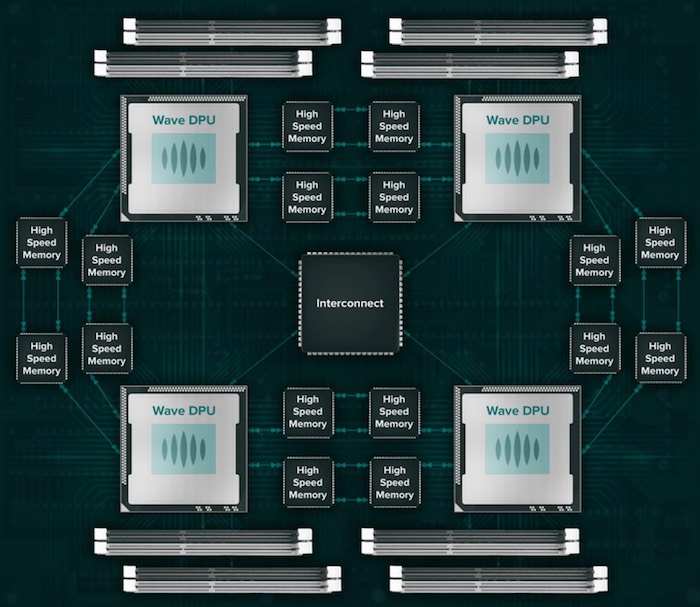

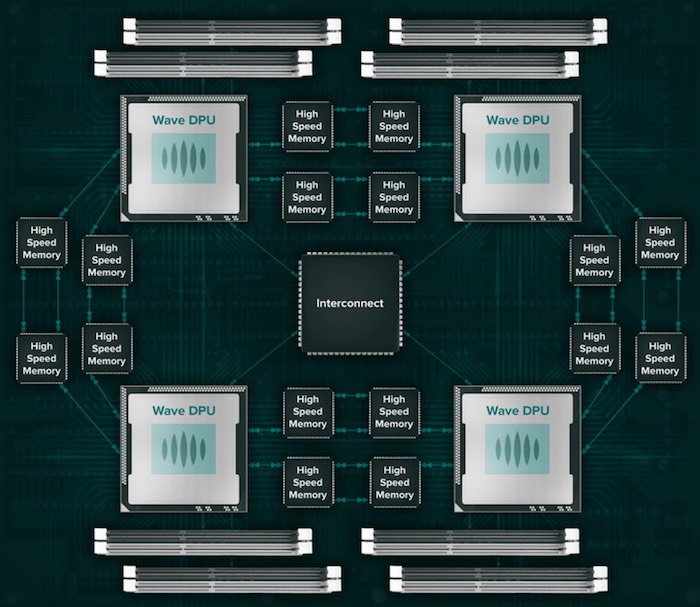

Wave Computing ha avuto un intenso evento nel 2018, registrando la sua prima unità di elaborazione DataFlow, acquisendo MIPS, creando MIPS Open e inviando i suoi primi sistemi iniziali a pochi fortunati clienti. Mentre l’architettura Wave ha alcune caratteristiche molto interessanti, che ho esplorato a fondo qui , siamo in attesa di informazioni sull’esperienza del cliente con carichi di lavoro reali su larga scala.

Wave non è un acceleratore che si collega a un server; è un processore standalone per il calcolo grafico. Questo approccio ha vantaggi e svantaggi. Tra i lati positivi del registro, Wave non soffrirà dei colli di bottiglia della memoria che esistono negli acceleratori come le GPU. Sul lato negativo, l’installazione di un’appliance Wave sarebbe un aggiornamento del carrello elevatore, che richiede la sostituzione completa dei server X86 tradizionali e sarebbe un concorrente per tutti i produttori di server.

Non mi aspetto che Wave fornisca risultati vincenti per NVIDIA per un singolo nodo, ma l’architettura è progettata per scalare abbastanza bene e la società ha indicato che dovrebbe avere i risultati dei clienti molto presto. Rimanete sintonizzati!

Graphcore

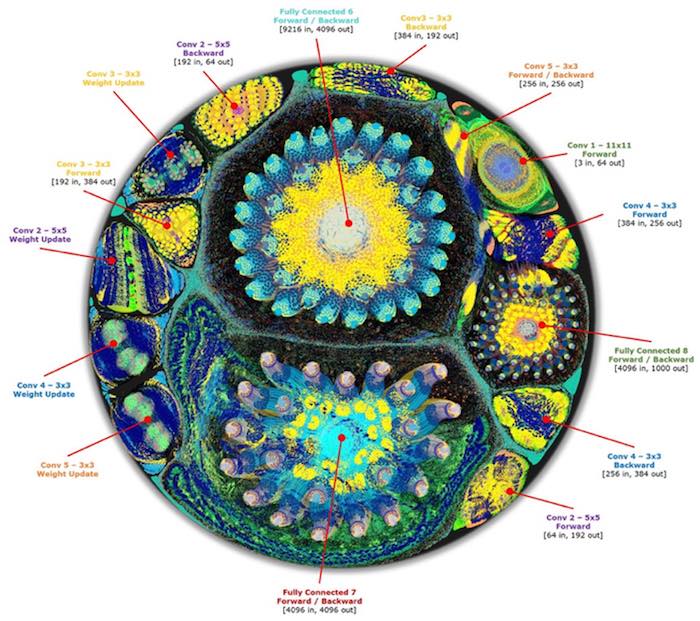

Graphcore è una startup unicorno con sede nel Regno Unito con un team di livello mondiale ben finanziata ($ 310M investiti all’attuale valutazione di $ 1,7 miliardi). Sta costruendo una nuova architettura di processore grafico con memoria situata sullo stesso chip della sua logica, che dovrebbe consentire prestazioni dell’applicazione più elevate nel mondo reale. Il team ha iniziato a stuzzicare il lancio del prodotto per un bel po ‘. Era “quasi pronto al lancio” lo scorso aprile e le informazioni più recenti dell’azienda lo scorso dicembre indicavano che avrebbero iniziato le spedizioni di produzione a breve. La sua lista di investitori è impressionante, tra cui Sequoia Capital, BMW, Microsoft MSFT + 0,91%, Bosch , e Dell Technologies DVMT + 0%.

Sono stato informato sull’architettura della società, e mi sembra piuttosto impressionante: il ridimensionamento dai dispositivi periferici al pacchetto dual chips “Colossus” per l’addestramento e l’inferenza dei data center. Al recente evento NeurIPS, Graphcore ha mostrato il suo Pod RackScale IPU, che offre oltre 16 petaflops in un rack con 32 server. Mentre la società afferma spesso che fornirà oltre 100 volte le prestazioni di una GPU best-in-class, la mia matematica si chiede di dissentire.

La società afferma che un server GC2 (8-chip) di 4 “Colossus” offre 500 TFlops (trilioni di operazioni al secondo) di prestazioni di precisione mista. Un singolo NVIDIA V100 eroga 125 TFlop, quindi 4 V100 dovrebbero fornire le stesse prestazioni, in teoria. Come al solito, il diavolo si trova nei dettagli: le prestazioni di picco V100 sono disponibili solo quando il codice viene refactored per eseguire moltiplicazioni di matrice 4×4 per l’esecuzione di TensorCore, una limitazione che l’architettura Graphcore evita abilmente. Per non parlare del fatto che un V100 consuma 300 watt e mazzette di denaro dal tuo portafoglio. Inoltre, Graphcore supporta un interconnessione on-die e un approccio “memoria in processore” (memoria on-die) che potrebbe portare a prestazioni eccellenti dell’applicazione oltre a quelle che il benchmark TFlops implicherebbe. In alcune reti neurali, come le reti generative dell’avversario, la memoria è il collo di bottiglia.

Ancora una volta, dovremo attendere i risultati dell’applicazione utente reale per valutare correttamente questa architettura. Eppure, la lista di investitori di Graphcore, il roster di esperti e la valutazione altissima mi dicono che probabilmente andrà a qualcosa di buono.

Habana Labs

Habana Labs, una startup israeliana, ha sorpreso molte persone lo scorso settembre annunciando al primo Vertice sull’hardware di IA che era pronta a spedire il suo primo silicio per l’inferenza, con prestazioni record che eseguivano reti neurali convoluzionali per l’elaborazione delle immagini. Ha mostrato benchmark di categorizzazione di 15.000 immagini al secondo nel database di classificazione delle immagini Resnet50, superando di circa il 50% il dispositivo T4 di NVIDIA, consumando solo 100 watt. Il suo ultimo round di finanziamento (dicembre 2018) è stato guidato da Intel Venture Capital e si è unito a WRV Capital, Bessemer Venture Partners e Battery Ventures, aggiungendo $ 75 milioni ai precedenti $ 45 milioni della startup. I recenti finanziamenti andranno in parte a registrare il suo secondo chip, denominato “Gaudi”, che si concentrerà sul mercato della formazione e presumibilmente si ridurrà a migliaia di processori. In un campo affollato, Habana mostra molte promesse.

Altre startup

Conosco più di 40 aziende in tutto il mondo che costruiscono chip per l’addestramento e l’inferenza di IA. Non sarei sorpreso di scoprire che la maggior parte di queste aziende sta facendo semplici FMA (Floating point Multiply Accumula) e matematica a precisione mista (interi a 8 bit, 16 e 32 bit in virgola mobile). Questo approccio è relativamente facile da costruire e raccoglierà un po ‘di frutta bassa, ma non fornirà un vantaggio architettonico duraturo contro i grandi giocatori come NVIDIA, Intel e le poche startup che fanno architetture cool come Wave e GraphCore. Eccone alcuni che hanno attirato la mia attenzione e con cui ho avuto un briefing:

Groq: ex-googlers che hanno lavorato su TPU, con ambizioni di governare il resto del mondo.

Tenstorrent: ditta canadese di ex-AMDers; rimane in modalità invisibile. Posso solo dire di essere colpito dalla visione e dall’architettura del suo CEO.

ThinCi: azienda indiana focalizzata su dispositivi periferici e veicoli autonomi, vantando partnership con Samsung e Denso.

Cerebras: guidate da ex dirigenti Sea Micro, tra cui Andrew Feldman; rimane in modalità invisibile.

Mitica: una startup che sta adottando un approccio unico per l’elaborazione dell’inferenza di bordo, simile all’elaborazione analogica su memoria non volatile; dovrebbe avere chip nel 2019.

China, Inc.

La Cina ha cercato di trovare un modo per svezzarsi dai semiconduttori statunitensi e gli acceleratori di intelligenza artificiale potrebbero fornire la rampa di uscita che stava cercando. Il governo centrale cinese ha fissato l’obiettivo del 2030 di costruire un settore di intelligenza artificiale da 1.000 miliardi di dollari e gli investitori hanno già investito ben oltre 4 miliardi di dollari in start-up dal 2012. Il Congresso degli Stati Uniti ha definito questa una corsa agli armamenti di intelligenza artificiale. Le aziende cinesi e gli istituti di ricerca guidano l’innovazione con meno attenzione alla privacy e alle preoccupazioni etiche che ostacolano i progressi nell’Occidente.

Cambricon e SenseTime sono forse i più grandi giocatori di IA cinesi da guardare, ma i giocatori come Horizon Robotics edge-AI sono attenti. Inoltre, tenere d’occhio le grandi aziende di Internet come Baidu BIDU + 2,65%, Huawei , Tencent e Alibaba BABA + 2,15%, che hanno tutti degli investimenti significativi nel software e nell’hardware della IA.

Con una valutazione di $ 2,5 miliardi, Cambricon è un unicorno cinese che ha già rilasciato il suo chip AI di terza generazione. La società afferma di poter offrire circa il 30% di prestazioni in più rispetto a NVIDIA V100 per l’intelligenza artificiale con meno energia. L’azienda vende anche il suo IP con i clienti e fornisce l’hardware AI che entra nel chipset mobile Huawei Kirin 970.

SenseTime, forse la startup AI con la valutazione più ampia, è meglio conosciuta per la diffusione di telecamere di sorveglianza intelligenti in tutta la Cina. Queste telecamere superano i 175 milioni e includono videocamere realizzate da altre società. Fondato a Hong Kong, l’ultimo round di finanziamenti di SenseTime ha raccolto $ 600 milioni, guidati da Alibaba. L’avvio è ora valutato a $ 4,5 miliardi, secondo diversi rapporti stampa. SenseTime ha stretto partnership strategiche con importanti aziende come Alibaba, Qualcomm, Honda e persino NVIDIA. Oggi la società ha un supercomputer con circa 8000 GPU (presumibilmente NVIDIA?), Con l’intenzione di costruire altri 5 supercomputer per elaborare i feed di riconoscimento facciale dai suoi milioni di fotocamere.