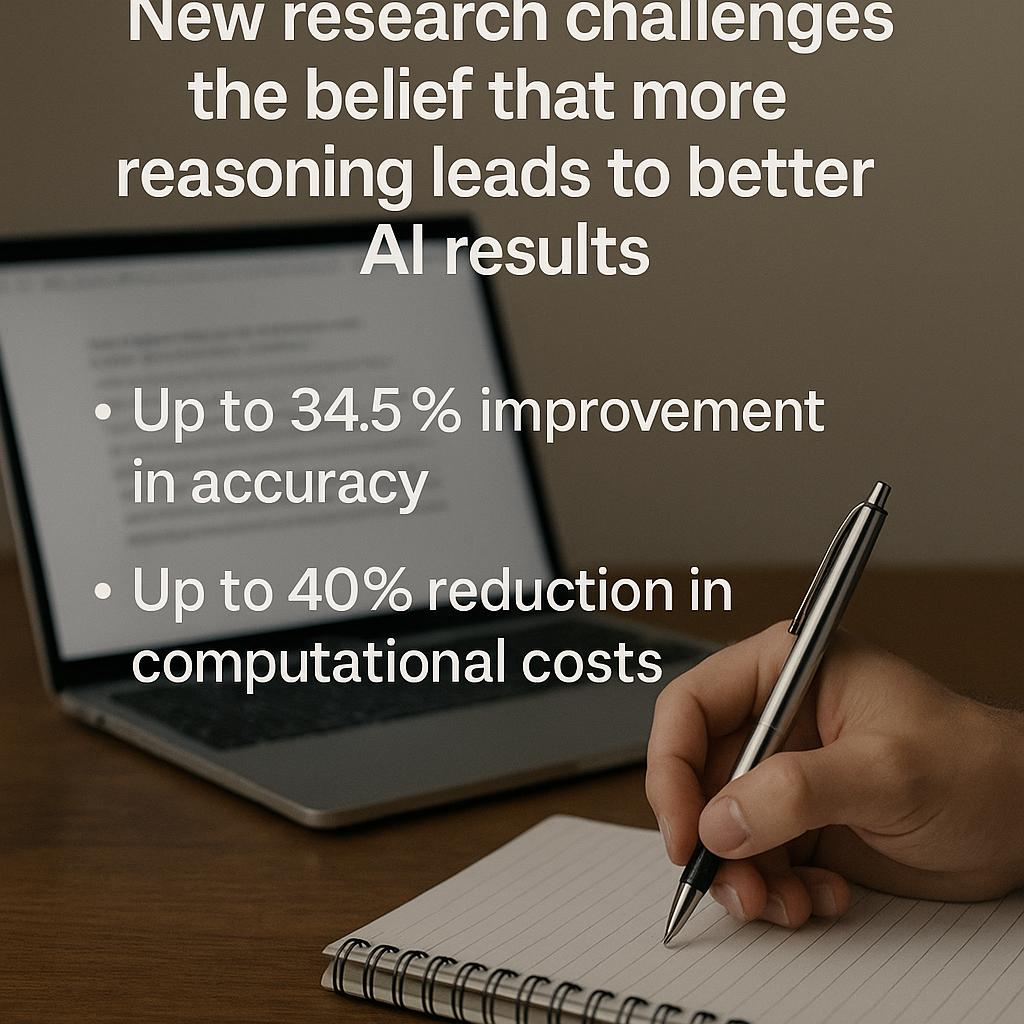

Una nuova ricerca di Meta e dell’Università Ebraica di Gerusalemme sfida una convinzione consolidata sull’intelligenza artificiale: non sempre più ragionamento porta a migliori risultati. Anzi, secondo lo studio, ridurre la lunghezza dei processi di ragionamento nei modelli di linguaggio di grandi dimensioni (LLM) può migliorare l’accuratezza delle risposte fino al 34,5% e ridurre i costi computazionali fino al 40%.

Tradizionalmente, per affrontare compiti complessi, i modelli AI sono stati progettati per eseguire catene di pensiero estese, ovvero sequenze dettagliate di passaggi logici. Questa strategia si basa sull’idea che più passaggi equivalgano a una maggiore accuratezza. Tuttavia, la ricerca di Meta mette in discussione questa ipotesi, evidenziando che catene di pensiero più brevi possono essere altrettanto, se non più, efficaci.

Per ottimizzare il processo, i ricercatori hanno sviluppato un nuovo approccio chiamato “short-m@k”. Questo metodo esegue più tentativi di ragionamento in parallelo, interrompendo il calcolo non appena i primi processi completano. La risposta finale viene quindi selezionata tramite un voto di maggioranza tra queste catene più brevi. Rispetto ai metodi tradizionali, “short-m@k” ha mostrato una riduzione dei tempi di esecuzione fino al 33% e una diminuzione dei costi computazionali fino al 40%, mantenendo o migliorando l’accuratezza.

Questi risultati hanno implicazioni significative per l’industria dell’AI. Le aziende che sviluppano e implementano modelli di linguaggio possono beneficiare di una maggiore efficienza, riducendo i costi e migliorando le prestazioni. Inoltre, l’approccio suggerisce che l’ottimizzazione dei modelli non deve necessariamente passare attraverso l’aumento della complessità, ma può essere ottenuta anche semplificando i processi di ragionamento.