Come l’open banking sta guidando un’enorme innovazione

Scopri come le fintech e le FI lungimiranti stanno accelerando i prodotti finanziari personalizzati attraverso API ricche di dati.

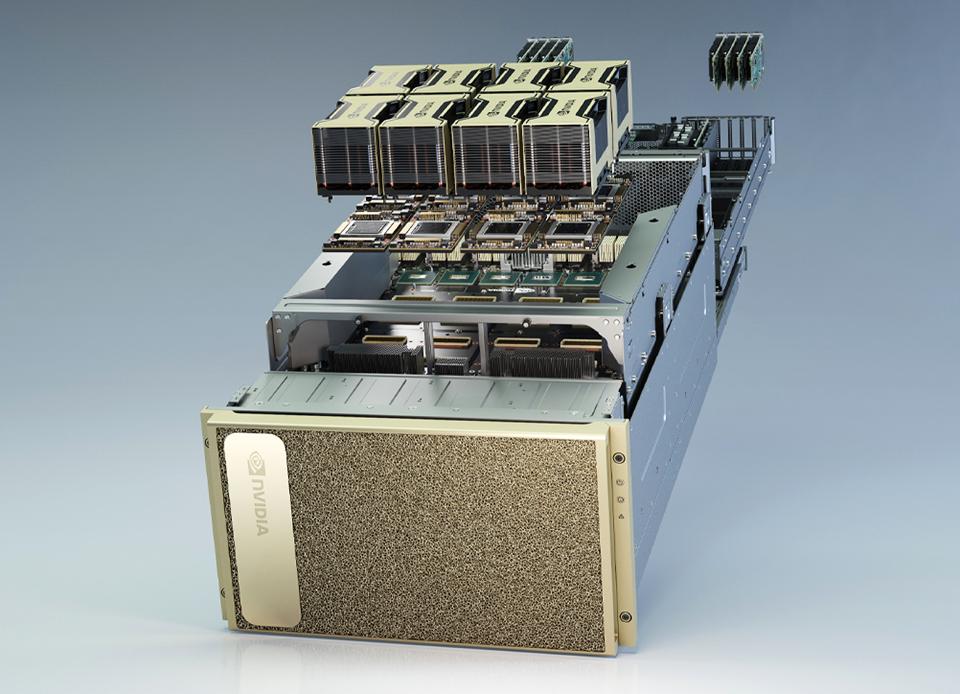

Nvidia ha lanciato oggi un programma di certificazione formale per i sistemi basati su unità di processore grafiche (GPU) distribuite in ambienti IT locali dai suoi partner OEM. L’iniziativa Nvidia-Certified Systems arriva in un momento in cui i modelli AI stanno iniziando a essere addestrati e distribuiti ai margini della rete piuttosto che addestrati solo nel cloud.

I partecipanti iniziali al programma includono Dell Technologies, Hewlett-Packard Enterprise (HPE), Super Micro, Gigabyte e Inspur Technologies. Ciascuno dei sistemi forniti da questi fornitori incorpora sia le GPU Nvidia che gli switch di archiviazione che l’azienda ha acquisito con l’ acquisizione di Mellanox . I sistemi certificati avranno diritto al supporto di Nvidia che verrà fornito tramite i partner OEM dell’azienda.

La formazione dei modelli di intelligenza artificiale si sta avvicinando all’edge della rete perché le organizzazioni IT aziendali si stanno rendendo conto che non appena diventano disponibili nuove fonti di dati, non è pratico riqualificare completamente un modello di intelligenza artificiale nel cloud e quindi aggiornare un motore di inferenza in esecuzione sull’edge. Le organizzazioni dovranno essere in grado di aggiornare i modelli di intelligenza artificiale mentre eseguono, ad esempio, un’applicazione che incorpora la visione artificiale ai margini della rete, ha affermato Adel El Hallak, dirigente di Nvidia.

“Devi essere in grado di portare il modello nel luogo in cui si svolge l’azione”, ha detto El Hallak.

Nvidia cita American Express come un esempio di organizzazione che sta già impiegando modelli di intelligenza artificiale in tempo reale per identificare le frodi, mentre Ford sta incorporando dati nei modelli di intelligenza artificiale in tempo reale per testare le auto a guida autonoma. Domino’s Pizza, nel frattempo, sta applicando l’intelligenza artificiale in tempo reale per migliorare le previsioni su quando gli ordini saranno pronti per i clienti.

Le organizzazioni IT dovranno essere in grado di aggiornare continuamente i modelli di intelligenza artificiale senza dover trasferire un’enorme quantità di dati su una rete geografica, ha aggiunto El Hallak. In effetti, la necessità di addestrare e aggiornare continuamente i modelli di intelligenza artificiale sta guidando l’ascesa delle operazioni di apprendimento automatico (MLOps) come disciplina IT distinta, ha osservato El Hallak.

Esistono, ovviamente, più classi di piattaforme di edge computing. Nvidia è in procinto di acquisire Arm per $ 40 miliardi come parte di uno sforzo per estendere la portata del suo software AI non solo alle piattaforme di edge computing ma anche ai singoli dispositivi. Poiché più piattaforme e dispositivi incorporano modelli di intelligenza artificiale, i nuovi dati a cui sono esposti creeranno un circolo virtuoso attraverso il quale quei modelli di intelligenza artificiale saranno in grado di adattarsi più facilmente alle mutevoli condizioni, ha aggiunto El Hallak.

A lungo termine, El Hallak ha affermato che Nvidia prevede di estendere l’iniziativa Nvidia-Certified Systems per includere piattaforme basate sulle sue GPU che potrebbero non essere necessariamente collegate a uno switch Mellanox. Nel frattempo, Nvidia si impegna a lavorare a stretto contatto con i partner OEM che sono disposti a pagare per il supporto che fornisce ai propri clienti finali, ha osservato El Hallak.

Potrebbe volerci del tempo prima che i modelli di intelligenza artificiale ei sistemi su cui vengono eseguiti vengano distribuiti in modo pervasivo ai margini della rete e oltre. Tuttavia, è chiaro che l’IA sarà incorporata in quasi tutte le piattaforme di edge computing in un modo o nell’altro. Nella maggior parte dei casi, quelle piattaforme di edge computing eseguiranno un qualche tipo di motore di inferenza basato su un modello di intelligenza artificiale che è stato addestrato nel cloud. Gli attuali processi impiegati per aggiornare i motori di inferenza riqualificando i modelli di IA che risiedono su piattaforme di cloud computing sono in molti casi semplicemente troppo lenti e macchinosi. Le applicazioni hanno sempre più bisogno di elaborare e analizzare i dati in tempo reale mentre vengono creati o raccolti su un dispositivo o una piattaforma di edge computing.