NVIDIA ha annunciato un nuovo modello di riconoscimento vocale progettato per affrontare uno dei problemi più complessi e sottovalutati degli agenti vocali moderni: la combinazione di latenza ridotta, stabilità sotto carico e capacità di gestire un elevato numero di connessioni simultanee. Il modello, chiamato Nemotron Speech ASR, è stato presentato il 5 del mese (ora locale) ed è pensato specificamente per il riconoscimento vocale in streaming in lingua inglese, con un’attenzione particolare agli agenti vocali conversazionali e ai servizi di sottotitolazione in tempo reale.

A differenza di molti sistemi di ASR attualmente in uso, Nemotron Speech ASR nasce con un obiettivo chiaro: superare i limiti strutturali del riconoscimento vocale tradizionale, che deriva in gran parte da modelli concepiti originariamente per la trascrizione offline. In quei sistemi, il parlato viene elaborato a blocchi sovrapposti per mantenere il contesto, costringendo il modello a ricalcolare più volte le stesse informazioni. Questo approccio, sebbene efficace dal punto di vista dell’accuratezza, diventa rapidamente inefficiente quando il numero di utenti simultanei cresce, aumentando sia il carico computazionale sia la latenza complessiva.

NVIDIA descrive questo meccanismo come l’equivalente di “rileggere le ultime pagine di un libro ogni volta che si gira pagina”: un metodo funzionale, ma estremamente costoso. Nemotron Speech ASR affronta il problema in modo radicalmente diverso, adottando un’architettura basata sulla cache che consente di memorizzare i risultati intermedi dell’encoder. Quando arriva un nuovo segmento audio, il modello elabora solo la parte effettivamente nuova, riutilizzando tutto ciò che è già stato calcolato in precedenza. In questo modo, il parlato viene processato una sola volta, eliminando i calcoli ridondanti che caratterizzano gli approcci convenzionali.

Dal punto di vista tecnico, il modello conta circa 600 milioni di parametri e utilizza un encoder FastConformer combinato con un decoder RNNT, entrambi ottimizzati per lo streaming e per l’uso intensivo della cache. L’input audio è mono a 16 kHz e viene segmentato in intervalli minimi di 80 millisecondi, rendendo il sistema particolarmente adatto alle interazioni in tempo reale. Il modello è stato progettato per funzionare al meglio sulle GPU NVIDIA di ultima generazione, ma supporta anche scenari di elaborazione batch, ampliando così il suo spettro di utilizzo.

Uno degli aspetti più interessanti di Nemotron Speech ASR è la possibilità di bilanciare in modo flessibile latenza e accuratezza senza dover riaddestrare il modello. Durante la fase di inferenza è possibile modificare un singolo parametro, chiamato att_context_size, per adattare il comportamento del sistema a contesti diversi. NVIDIA ha previsto quattro configurazioni di riferimento, che spaziano da circa 80 millisecondi fino a oltre un secondo. Questo significa che lo stesso modello può essere impiegato sia in conversazioni vocali dove la rapidità di risposta è cruciale, sia in applicazioni di trascrizione più tradizionali dove conta soprattutto la precisione del testo prodotto.

I risultati in termini di accuratezza confermano la solidità dell’approccio. Nei test condotti su dataset di riferimento come AMI, Earnings22, Gigaspeech e LibriSpeech, Nemotron Speech ASR ha mostrato un tasso medio di errore delle parole che migliora progressivamente all’aumentare della dimensione del blocco audio. Con finestre molto brevi, intorno ai 160 millisecondi, il WER si attesta sotto l’8%, mentre con contesti più ampi, superiori al mezzo secondo, scende ulteriormente. Questo comportamento riflette un compromesso ben controllato tra velocità e qualità, che può essere regolato in base alle esigenze dell’applicazione.

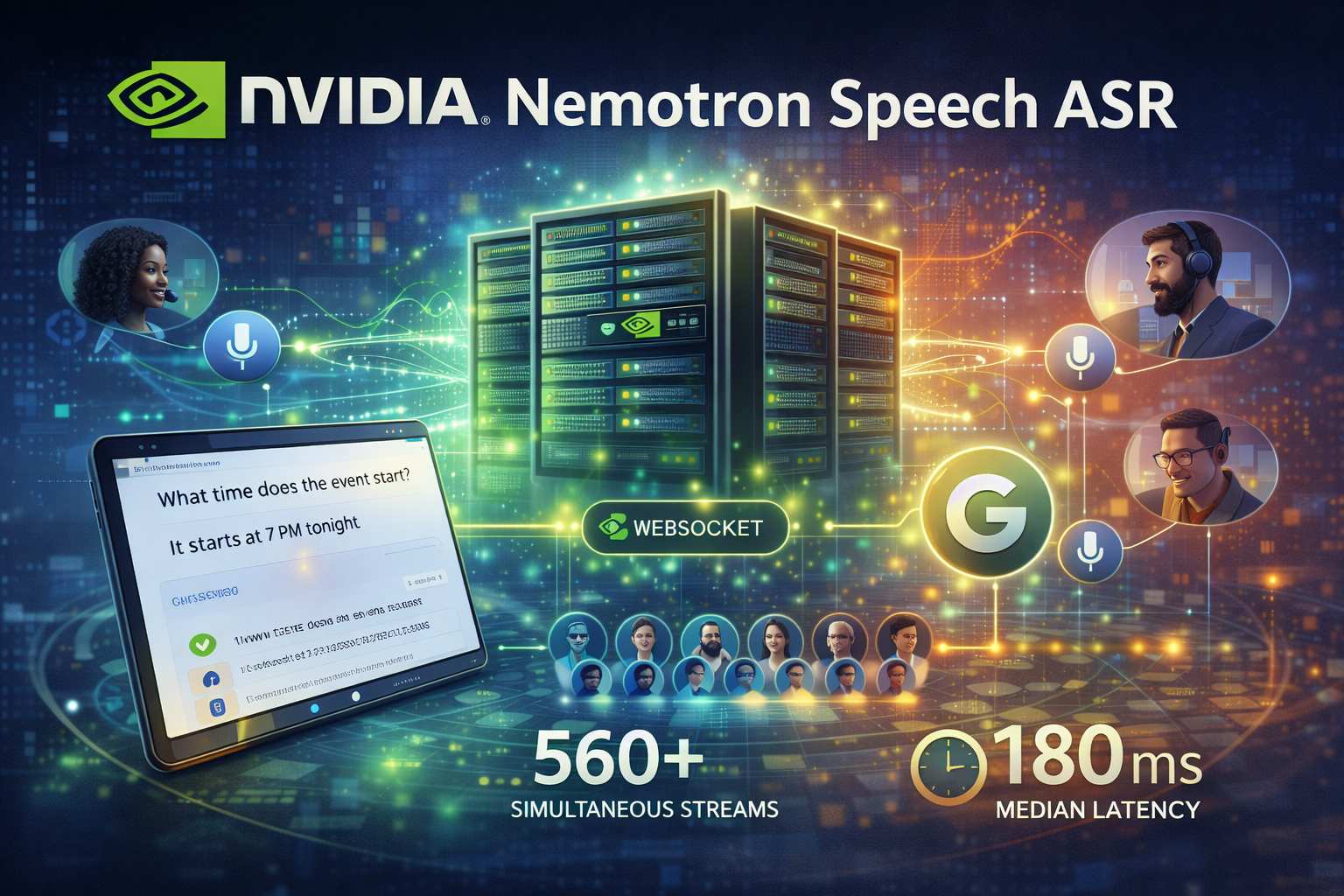

Il vero salto di qualità, tuttavia, emerge quando si osservano le prestazioni in scenari ad alta concorrenza. Grazie al design basato sulla cache, il carico computazionale cresce in modo lineare e prevedibile con l’aumentare della durata delle conversazioni e del numero di utenti. Su una GPU NVIDIA H100, il sistema è riuscito a gestire circa 560 flussi vocali simultanei con una latenza paragonabile a quella dei metodi di streaming tradizionali, ma con una capacità circa tre volte superiore. Anche su hardware meno estremo, come la RTX A5000 o sistemi DGX B200, i miglioramenti in termini di throughput risultano significativi.

Ancora più rilevante è il comportamento della latenza sotto carico. Nei test con oltre cento client WebSocket simultanei, la latenza mediana complessiva è rimasta stabile intorno ai 180 millisecondi, senza fenomeni di accumulo o disallineamento tra audio e risposta, nemmeno in conversazioni vocali prolungate di diversi minuti. Questo aspetto è fondamentale per gli agenti vocali, dove anche piccoli ritardi percepiti possono compromettere l’esperienza dell’utente e rendere l’interazione innaturale.

Nemotron Speech ASR è stato addestrato su circa 285.000 ore di dati vocali, principalmente in inglese, provenienti dal dataset proprietario Granary di NVIDIA e integrati con numerosi corpora pubblici. Tra le fonti utilizzate figurano YouTube Commons, Fisher, Switchboard, The Wall Street Journal, Vox Populi e Mozilla Common Voice. Per migliorare l’efficienza dell’addestramento, NVIDIA ha combinato trascrizioni umane con trascrizioni generate automaticamente da sistemi ASR, una scelta che riflette un approccio pragmatico alla scalabilità dei dati.

Un elemento non secondario è la scelta di rilasciare il modello in versione open-weight su Hugging Face, rendendolo accessibile a ricercatori e sviluppatori. Questo posiziona Nemotron Speech ASR non solo come una soluzione commerciale, ma anche come un punto di riferimento tecnologico per chi lavora su sistemi vocali in tempo reale e desidera sperimentare architetture più efficienti.

Nel commentare il rilascio, NVIDIA ha sottolineato come i requisiti degli agenti vocali siano profondamente diversi da quelli della trascrizione offline tradizionale. Con Nemotron Speech ASR, l’azienda afferma di aver eliminato la necessità di scegliere tra velocità, accuratezza e scalabilità, offrendo invece un sistema capace di mantenere latenze molto basse, stabili anche in ambienti ad alta concorrenza, e prestazioni elevate su larga scala. È un segnale chiaro di come il riconoscimento vocale stia entrando in una nuova fase, sempre più orientata alle interazioni in tempo reale e ai servizi conversazionali, dove l’efficienza architetturale diventa tanto importante quanto la qualità del modello stesso.