Nel mondo dell’intelligenza artificiale, la disponibilità di risorse di calcolo affidabili e scalabili è diventata tanto cruciale quanto i modelli stessi. Con l’espansione delle applicazioni di AI — dall’elaborazione linguistica alla visione artificiale, dal supporto decisionale nel business all’automazione industriale — la domanda per potenza di calcolo cresce in modo esponenziale, mettendo sotto pressione infrastrutture tradizionali centralizzate. In questo contesto, PHIL AI ha recentemente presentato una nuova architettura di compute distribuito ai margini della rete (edge compute), con l’obiettivo di rendere l’accesso all’infrastruttura AI di livello enterprise più ampio e meno dipendente dai grandi data center centralizzati.

L’annuncio, fatto dalla sede di Dubai, riflette una consapevolezza evidente nell’industria: per sostenere la crescita delle tecnologie AI, non è sufficiente aumentare la capacità di pochi centri nevralgici. Le architetture tradizionali richiedono investimenti enormi in infrastrutture fisiche e possono risultare inefficaci nel raggiungere luoghi geografici o realtà aziendali con esigenze specifiche e risorse limitate. PHIL AI propone invece un modello che combina dispositivi di calcolo leggeri, facilmente distribuibili in molteplici ambienti — dagli uffici alle piccole imprese — con un sistema intelligente di orchestrazione delle attività di calcolo. Questo approccio cerca di democratizzare l’accesso alle risorse necessarie per eseguire carichi di lavoro AI impegnativi, quali l’inferenza di modelli e l’elaborazione dati, mantenendo standard di prestazione paragonabili a quelli dei centri dati più grandi.

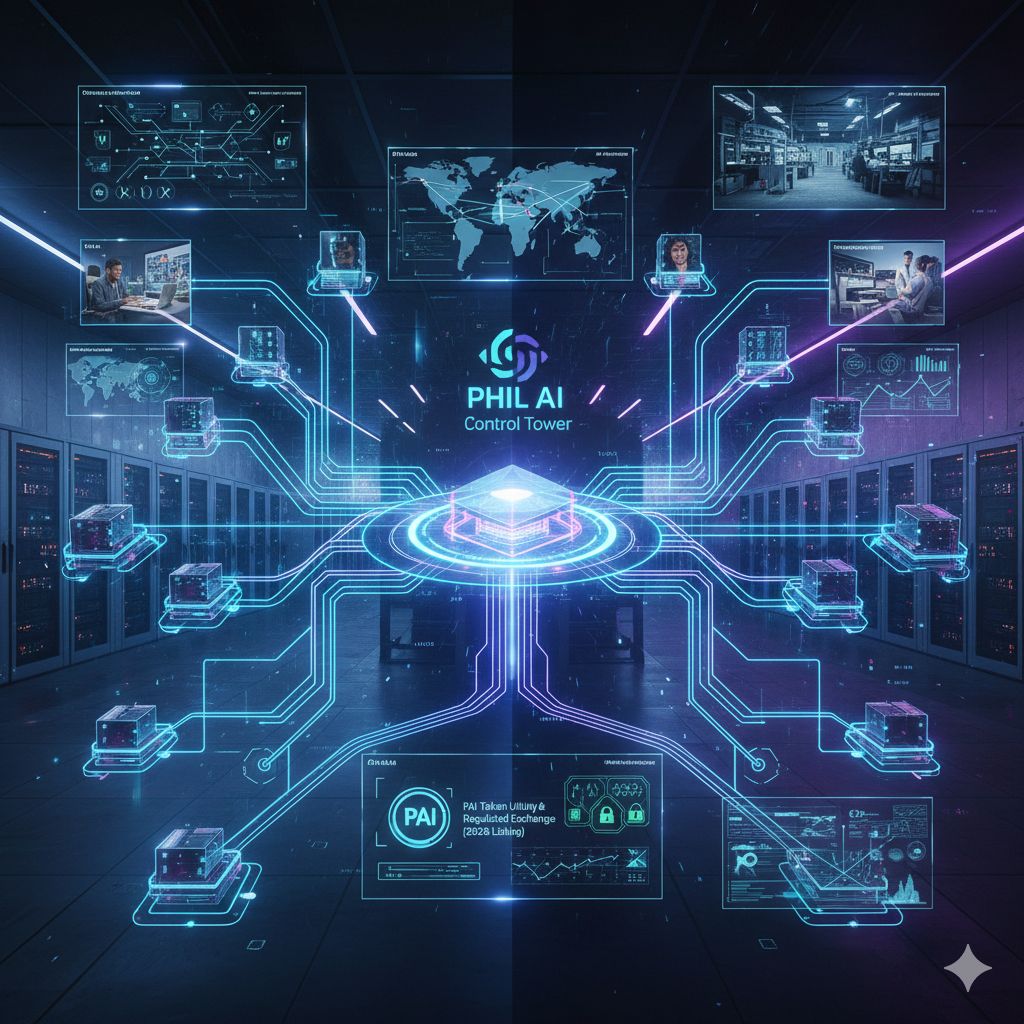

Al cuore dell’architettura proposta da PHIL AI vi è un elemento centrale di coordinamento, chiamato Control Tower, che gestisce la distribuzione dei compiti, l’abbinamento ai nodi disponibili, la verifica delle attività completate e persino i processi di regolazione delle risorse. Questo livello di controllo è fondamentale per garantire che i vari dispositivi collegati possano operare in modo integrato, rendendo possibile l’esecuzione di funzioni tipiche dei servizi AI enterprise nonostante la natura decentralizzata dell’infrastruttura. In un’epoca in cui latenza, affidabilità e requisiti di conformità sono aspetti critici, la capacità di coordinare risorse sparse è ciò che distingue un modello di edge computazionale efficace da soluzioni semplicemente tecniche o sperimentali.

La sicurezza, elemento imprescindibile in qualsiasi discussione sull’AI distribuita, è affrontata dalla piattaforma di PHIL AI con molteplici livelli di protezione: comunicazioni cifrate, routing di rete decentralizzato e meccanismi di verifica crittografica. Questi accorgimenti mirano non solo a tutelare i dati sensibili che possono transitare nei processi di calcolo, ma anche a garantire che applicazioni critiche in settori come la sanità, la finanza e l’analisi aziendale possano essere eseguite con fiducia su risorse distribuite piuttosto che esclusivamente su server centralizzati. La compatibilità con infrastrutture blockchain, integrando ambienti compatibili con Ethereum Virtual Machine (EVM) e servizi di verifica decentralizzati, amplia ulteriormente la possibilità di interoperare con ecosistemi Web3 esistenti e futuri.

Un’altra caratteristica peculiare dell’approccio di PHIL AI è la presenza di un modello di utilità basato su token, denominato PAI, che serve come mezzo per richiedere servizi di calcolo, regolare i costi di utilizzo e sostenere le operazioni all’interno della rete. A differenza di molte criptovalute usate principalmente a fini speculativi, il token PAI è concepito per rispecchiare effettivamente la domanda di risorse di calcolo: più l’infrastruttura è utilizzata per eseguire compiti AI, più il token viene impiegato come strumento operativo. L’intenzione dell’azienda è anche di quotare questo token in borse regolamentate nel corso del 2026, aumentando così la liquidità e l’accessibilità per gli attori dell’ecosistema globale.

PHIL AI non si ferma alla sola infrastruttura fondamentale: sta attivamente perseguendo una strategia di apertura dell’ecosistema, collaborando con partner nel campo delle infrastrutture e dello sviluppo di applicazioni per supportare workflow AI end-to-end. Le API offerte permettono agli sviluppatori di costruire applicazioni AI sfruttando questa rete distribuita, consentendo funzioni che vanno dall’analisi dei dati all’elaborazione dei contenuti, fino all’inferenza di modelli. Per le organizzazioni che non dispongono di competenze tecniche profonde o di strutture IT complesse, PHIL AI propone anche servizi gestiti che coprono monitoraggio, coordinamento della larghezza di banda e supporto tecnico continuo, riducendo le barriere all’ingresso e facilitando la partecipazione a questa nuova infrastruttura globale.

Questa iniziativa si inserisce in una tendenza più ampia nel settore tecnologico: la transizione da modelli di calcolo completamente centralizzati verso architetture più ibride e distribuite, capaci di processare dati e modelli più vicino al punto di origine delle informazioni stesse. Secondo studi recenti, questa spinta verso il edge computing è vista come fondamentale per affrontare problemi di latenza, costi di trasferimento dati, privacy e scalabilità, caratteristiche sempre più critiche man mano che le applicazioni AI permeano industrie e servizi quotidiani.