SambaNova Systems , una startup che sviluppa chip per carichi di lavoro AI, ha annunciato oggi di aver raccolto 676 milioni di dollari, valutando l’azienda a oltre 5 miliardi di dollari post-money. SambaNova afferma che prevede di espandere la propria base di clienti, in particolare nel mercato dei data center, poiché diventerà una delle società di intelligenza artificiale più capitalizzate al mondo con oltre 1 miliardo di dollari raccolti.

Gli acceleratori di intelligenza artificiale sono un tipo di hardware specializzato progettato per accelerare le applicazioni di intelligenza artificiale come reti neurali, deep learning e varie forme di machine learning. Si concentrano su calcoli aritmetici o in-memory a bassa precisione, che possono aumentare le prestazioni di grandi algoritmi di intelligenza artificiale e portare a risultati all’avanguardia nell’elaborazione del linguaggio naturale, visione artificiale e altri domini. Questo è forse il motivo per cui si prevede che avranno una quota crescente di potenza di elaborazione di edge computing, che rappresenterà il 70% previsto entro il 2025, secondo un recente sondaggio di Statista.

SambaNova occupa un’industria artigianale di startup il cui obiettivo è lo sviluppo di infrastrutture per gestire i carichi di lavoro dell’IA. L’azienda californiana di Palo Alto, fondata nel 2017 dal veterano di Oracle e Sun Microsystems Rodrigo Liang e dai professori di Stanford Kunle Olukotun e Chris Ré, fornisce sistemi che eseguono AI e app ad alta intensità di dati dal data center all’edge.

Olukotun, che ha recentemente ricevuto l’Harry H. Goode Memorial Award della IEEE Computer Society, è a capo del progetto di ricerca Stanford Hydra Chip Multiprocessor, che ha prodotto un design di chip che accoppia quattro processori specializzati e le loro cache con una cache secondaria condivisa. Ré, professore associato presso il Dipartimento di Informatica presso l’InfoLab della Stanford University, è un vincitore del premio MacArthur genius che è anche affiliato con Statistical Machine Learning Group, Pervasive Parallelism Lab e Stanford AI Lab.

I chip AI di SambaNova – ei suoi clienti, del resto – rimangono in gran parte sotto chiave. Ma la società aveva precedentemente rivelato che sta sviluppando dispositivi “software-defined” ispirati alla ricerca finanziata dalla DARPA sull’elaborazione efficiente dell’IA. Sfruttando una combinazione di ottimizzazioni algoritmiche e hardware personalizzato basato su scheda, SambaNova afferma di essere in grado di migliorare notevolmente le prestazioni e le capacità della maggior parte delle app imbevute di AI.

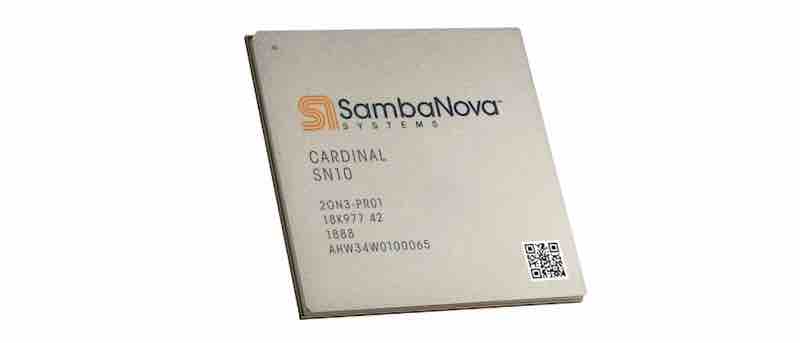

Il Cardinal SN10 RDU (Reconfigurable Dataflow Unit) di SambaNova da 40 miliardi di transistor, basato sul processo N7 di TSMC, è costituito da un array di nodi riconfigurabili per dati, archiviazione e commutazione. È progettato per eseguire l’addestramento in-the-loop e consentire la riclassificazione e l’ottimizzazione del modello al volo durante i carichi di lavoro di inferenza con addestramento. Ogni chip Cardinal ha sei controller per la memoria, che consentono una larghezza di banda di 153 GB / s, e gli otto chip sono collegati in una configurazione all-to-all. Quest’ultimo bit è reso possibile da una rete di commutazione che consente ai chip di scalare.

SambaNova non vende Cardinal da solo, ma piuttosto come soluzione da installare in un datacenter. L’unità di base dell’offerta di SambaNova si chiama DataScale SN10-8R, con un processore AMD accoppiato con otto chip Cardinal e 12 terabyte di memoria DDR4, o 1,5 TB per Cardinal. SambaNova afferma che personalizzerà i suoi prodotti in base alle esigenze dei clienti, con un set predefinito di funzionalità di rete e gestione che SambaNova può gestire in remoto.

L’ampia capacità di memoria offre apparentemente all’SN10-8R un vantaggio su hardware rivale come il V100 di Nvidia. Come ha dichiarato a Next Platform il vicepresidente del prodotto Marshall Choy di SambaNova, l’architettura riconfigurabile del Cardinal può eliminare la necessità di cose come il downsampling delle immagini ad alta risoluzione a bassa risoluzione per l’addestramento e l’inferenza, preservando le informazioni nell’immagine originale. Il risultato è la capacità di addestrare modelli con una qualità complessiva probabilmente superiore, eliminando la necessità di un’etichettatura aggiuntiva.

Sul lato software dell’equazione, SambaNova ha il proprio ottimizzatore e compilatore di grafici, consentendo ai clienti che utilizzano framework di apprendimento automatico come PyTorch e TensorFlow di ricompilare i carichi di lavoro per Cardinal. L’azienda mira a supportare il linguaggio naturale, la visione artificiale e modelli di raccomandazione contenenti oltre 100 miliardi di parametri – le parti del modello apprese dai dati di addestramento storici – nonché un footprint di memoria più ampio che consente l’utilizzo dell’hardware e una maggiore precisione.

SambaNova ha la concorrenza in un mercato che si prevede raggiungerà $ 91,18 miliardi entro il 2025. Hailo, una startup che sviluppa hardware per accelerare l’inferenza AI ai margini, nel marzo 2020 ha raccolto $ 60 milioni in capitale di rischio. Mythic, con sede in California, ha raccolto 85,2 milioni di dollari per sviluppare un’architettura di elaborazione in memoria personalizzata. Graphcore , una startup con sede a Bristol, nel Regno Unito, che crea chip e sistemi per accelerare i carichi di lavoro dell’IA, ha un bottino di guerra di centinaia di milioni di dollari. E la crescente unità di chip AI di Baidu è stata recentemente valutata a $ 2 miliardi dopo il finanziamento.

Ma SambaNova afferma che la prima generazione di Cardinal è stata registrata nella primavera del 2019, con i primi campioni di silicio già nei server dei clienti. In effetti, SambaNova vendeva ai clienti da oltre un anno prima di questo punto – le uniche versioni pubbliche provengono dal Dipartimento dell’Energia di Lawrence Livermore e Los Alamos. Lawrence Livermore ha integrato uno dei sistemi di SambaNova con il suo cluster di supercalcolo Corona, utilizzato principalmente per simulazioni di vari fenomeni fisici.

SambaNova è anche il beneficiario di un mercato che vede una domanda dei clienti senza precedenti e sostenuta. L’impennata negli acquisti di automobili ed elettronica all’inizio della pandemia ha esacerbato una crescente carenza di microchip. In risposta, il presidente degli Stati Uniti Joe Biden ha recentemente impegnato 180 miliardi di dollari in ricerca e sviluppo per l’elaborazione avanzata, nonché per la produzione specializzata di semiconduttori per l’intelligenza artificiale e il calcolo quantistico, che sono diventati centrali per la strategia tecnologica nazionale del paese.

“Abbiamo iniziato a spedire il prodotto durante la pandemia e abbiamo assistito a un’accelerazione del business e dell’adozione rispetto alle aspettative”, ha detto un portavoce a VentureBeat via e-mail. “COVID-19 ha anche portato un rivestimento d’argento in quanto ha generato nuovi casi d’uso per noi. La nostra tecnologia viene utilizzata dai clienti per la ricerca e la scoperta di composti terapeutici e antivirali COVID-19 “.

Secondo Bronis de Supinski, chief technology officer di Lawrence Livermore, la piattaforma di SambaNova viene utilizzata per esplorare una tecnica chiamata simulazione cognitiva, in cui l’intelligenza artificiale viene utilizzata per accelerare l’elaborazione di porzioni di simulazioni. Egli sostiene un miglioramento di circa 5 volte rispetto alle GPU che eseguono gli stessi modelli.

Insieme al nuovo prodotto SN10-8R, SambaNova offre due opzioni di servizio simili al cloud: La prima – SambaNova AI Platform – è un cloud per sviluppatori gratuito per istituti di ricerca con accesso di calcolo all’hardware. Il secondo, DataFlow as a Service, è per i clienti aziendali che desiderano la flessibilità del cloud senza pagare per l’hardware. In entrambi i casi, SambaNova gestirà la gestione e gli aggiornamenti.

Softbank ha guidato l’ultimo round di finanziamento di SambaNova, una serie D. L’azienda, che ha oltre 300 dipendenti, aveva precedentemente chiuso un round di serie C da $ 250 milioni guidato da BlackRock e preceduto da un round di serie B da $ 150 milioni guidato da Intel Capital.