Il team di ricerca del MIT progetta una rete di intelligenza artificiale per resistere agli esempi contraddittori

Un team di ricercatori del MIT ha sviluppato un algoritmo di apprendimento profondo inteso ad aiutare le IA a far fronte a esempi “contraddittori”, che possono indurre un’IA a fare previsioni sbagliate e ad eseguire azioni sbagliate. L’algoritmo progettato dal team del MIT può aiutare i sistemi di intelligenza artificiale a mantenere la loro precisione ed evitare di commettere errori di fronte a punti dati confusi.

I sistemi di intelligenza artificiale analizzano le caratteristiche di input di un evento per decidere come rispondere a quell’evento. Un’IA responsabile della manovra di un veicolo autonomo deve prendere i dati dalle telecamere del veicolo e decidere cosa fare in base ai dati contenuti in quelle immagini. Tuttavia, c’è la possibilità che i dati dell’immagine analizzati dall’intelligenza artificiale non siano una rappresentazione accurata del mondo reale. Un problema tecnico nel sistema della fotocamera potrebbe alterare alcuni pixel, portando l’IA a trarre conclusioni errate sulla linea di condotta appropriata.

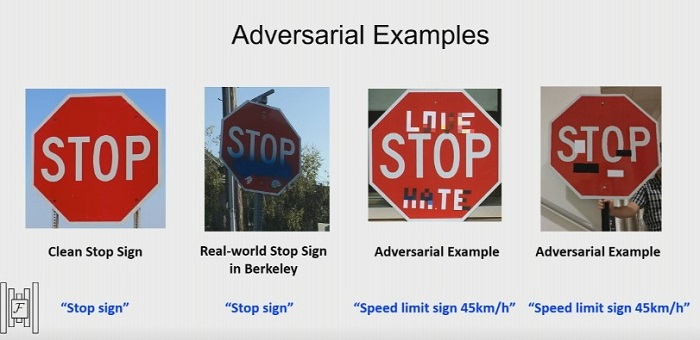

Gli “input del contraddittorio” sono come illusioni ottiche per un sistema di intelligenza artificiale. Sono input che confondono in qualche modo un’intelligenza artificiale. Gli input contraddittori possono essere creati con l’obiettivo esplicito di far commettere errori a un’intelligenza artificiale, rappresentando i dati in un modo che induce l’IA a credere che i contenuti di un esempio siano una cosa invece di un’altra. Ad esempio, è possibile creare un esempio contraddittorio per un sistema di visione artificiale apportando lievi modifiche alle immagini di gatti, facendo sì che l’IA classifichi erroneamente le immagini come monitor di computer. Il team di ricerca del MIT ha progettato un algoritmo per proteggere dagli esempi contraddittori lasciando che il modello mantenga un certo “scetticismo” sugli input che riceve.

I ricercatori del MIT hanno chiamato il loro approccio “Robustezza antagonista certificata per l’ apprendimento del rinforzo profondo ” o CARRL. CARRL è composto da una rete di apprendimento per rinforzo e da una rete neurale profonda tradizionale unite insieme. L’apprendimento per rinforzo utilizza il concetto di “ricompense” per addestrare un modello, dando al modello una ricompensa proporzionalmente maggiore quanto più ci si avvicina al raggiungimento del suo obiettivo. Il modello di apprendimento per rinforzo viene utilizzato per addestrare un Deep Q-Netowrkk o DQN. I DQN funzionano come le reti neurali tradizionali, ma associano anche i valori di input a un livello di ricompensa, proprio come i sistemi di apprendimento per rinforzo.

CARRL opera modellando una gamma di diversi valori possibili per i dati di input.

Supponendo che l’IA stia cercando di tracciare la posizione di un punto all’interno di un’immagine più grande, l’IA ritiene che la posizione del punto potrebbe essere il risultato dell’influenza del contraddittorio e considera le regioni in cui potrebbe essere invece il punto. La rete quindi prende decisioni in base allo scenario peggiore per la posizione del punto, stabilendosi sull’azione che produrrebbe la ricompensa più alta in questo scenario peggiore.

Il metodo tipico di protezione dagli esempi contraddittori prevede l’esecuzione di versioni leggermente modificate dell’immagine di input attraverso la rete AI per vedere se viene sempre presa la stessa decisione. Se le alterazioni dell’immagine non influiscono in modo drammatico sul risultato, ci sono buone probabilità che la rete sia resistente agli esempi contraddittori. Tuttavia, questa non è una strategia praticabile per scenari in cui è necessario prendere decisioni rapide, poiché si tratta di metodi di test dispendiosi in termini di tempo e computazionalmente costosi. Per questo motivo, il team del MIT ha deciso di creare una rete neurale in grado di prendere decisioni sulla base delle ipotesi del caso peggiore, in grado di operare in scenari in cui la sicurezza è fondamentale.

I ricercatori del MIT hanno testato i loro algoritmi facendo giocare l’IA a una partita a Pong. Includevano esempi di contraddittorio alimentando le istanze dell’IA in cui la palla era visualizzata leggermente più in basso sullo schermo di quanto non fosse in realtà. Man mano che l’influenza degli esempi del contraddittorio cresceva, le tecniche correttive standard iniziarono a fallire mentre CARRL riuscì a vincere più partite al confronto. CARRL è stato anche testato su un’attività di prevenzione delle collisioni. L’attività si è svolta in un ambiente virtuale in cui due diversi agenti hanno cercato di cambiare posizione senza urtarsi. Il team di ricerca ha alterato la percezione del primo agente del secondo agente e CARRL è stata in grado di guidare con successo il primo agente attorno all’altro agente, anche in condizioni di elevata incertezza,

Indipendentemente da ciò, il postdoc del Dipartimento di aeronautica e astronautica del MIT Michael Everett, che ha guidato lo studio, ha spiegato che la ricerca potrebbe avere implicazioni per la capacità dei robot di gestire situazioni imprevedibili. Come ha spiegato Everett tramite MIT News:

“Le persone possono essere contraddittorie, come mettersi di fronte a un robot per bloccarne i sensori, o interagire con loro, non necessariamente con le migliori intenzioni”, afferma Everett. “Come può un robot pensare a tutte le cose che le persone potrebbero provare a fare e cercare di evitarle? Da che tipo di modelli contraddittori vogliamo difenderci? È qualcosa che stiamo pensando a come fare “.