Ogni volta che compare un nuovo modello linguistico, potremmo essere tentati di fare “upgrade” ai nostri agenti AI: passare all’ultima versione, cambiare prompt, modificare la pipeline, inserire nuovi tool. Eppure nell’universo dell’IA questo tipo di aggiornamento non è affatto una questione banale e garantita: può migliorare le performance, ma può anche peggiorarle.

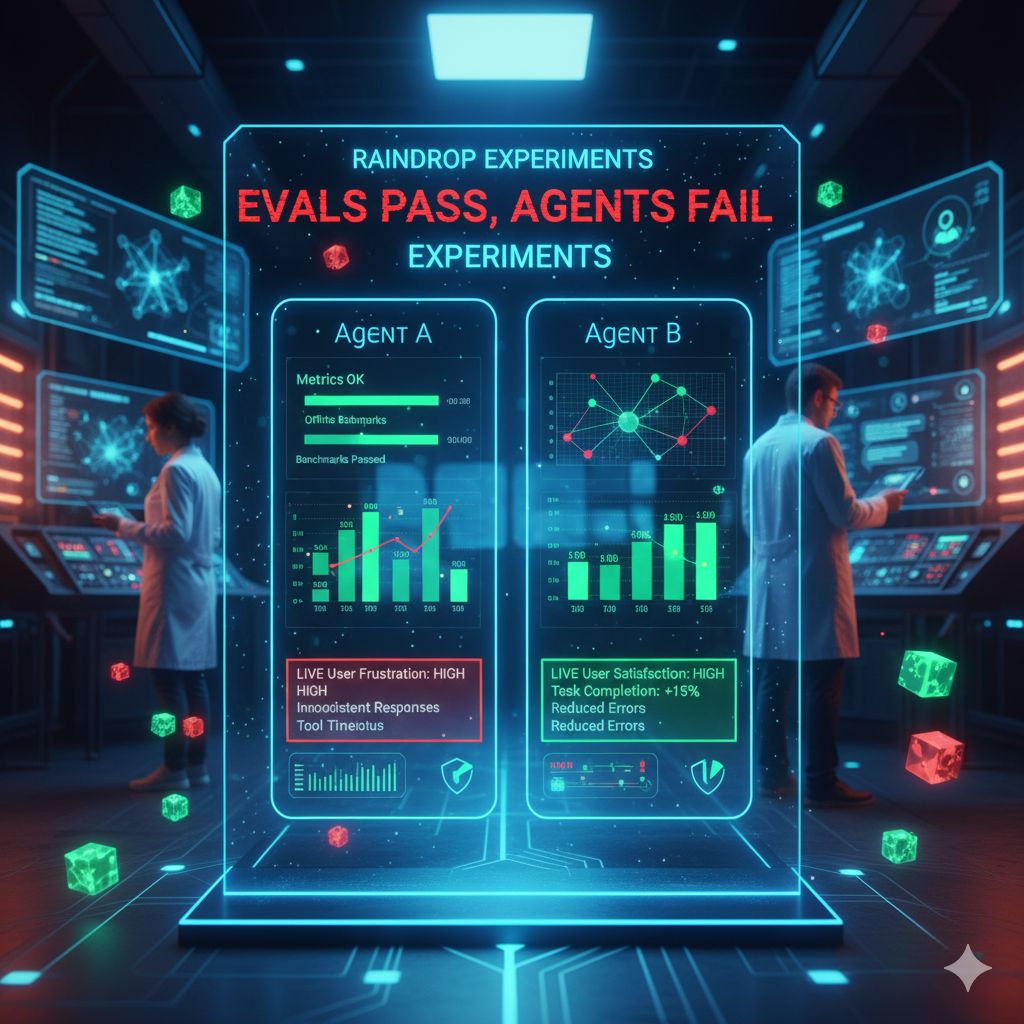

Immagina di avere un agente che interagisce con gli utenti, esegue compiti, integra tool, risponde a richieste complesse. Con il tempo, desideri ottimizzarlo: magari usare un modello più potente per certe parti, aggiungere una libreria utile, cambiare la struttura dei prompt. Ma come sapere se questi cambi migliorano effettivamente l’esperienza dell’utente, o se introducono regressioni, errori, conflitti inattesi o comportamenti imprevedibili? Spesso i test “offline” e le valutazioni tradizionali (le chiamano evals) non riescono a cogliere le dinamiche reali che emergono quando l’agente opera in condizioni vere, con traffico reale, casi limite, usi non previsti. È il noto problema che “le eval passano, ma gli agenti falliscono”.

È qui che entra in scena la proposta di Raindrop: Experiments si presenta come una suite di A/B testing progettata per agenti AI, pensata per confrontare versioni differenti dell’agente (diversi modelli, differenti prompt, tool aggiunti o tolti, modifiche alla pipeline) in parallelo, osservando come si comportano in produzione, sugli utenti reali. Non più ipotesi, ma dati concreti: tassi di errore, utilizzo dei tool, lunghezza delle conversazioni, segnali positivi o negativi dall’utente, regressioni, fallimenti.

Quando un team lancia un esperimento, la piattaforma consente di vedere i risultati visivamente: quali versioni superano il baseline, in quali metriche, dove emergono problemi. Se una modifica porta a un aumento dei segnali negativi — ad esempio più incomprensioni, risposte parziali, loop — questo appare chiaramente. Allo stesso modo, se certe variazioni portano a risposte più coerenti, tempi d’interazione migliori o uso più efficace degli strumenti, questi guadagni emergono con chiarezza.

Una delle intuizioni chiave è che migliorare un agente non significa solo migliorare un singolo prompt, ma capire come tutto l’ecosistema agentico muta: cambiamenti in modello, nuove fonti dati, tool che possono “rompere” il sistema in modi inattesi. Experiments aiuta i team a esplorare questi cambiamenti “in piccolo” e con i numeri davanti, piuttosto che affidarsi solo all’occhio umano o a test limitati.

Per funzionare bene, però, ci sono requisiti: per avere risultati statisticamente significativi, serve un volume sufficiente di utenti (si parla di migliaia di interazioni al giorno). Se il campione è troppo piccolo, le differenze possono essere dovute al rumore, non alle modifiche stesse. E bisogna essere attenti anche al disegno dell’esperimento: cosa isolare, quali variabili cambiare, come segmentare i dati (per demografia, lingua, tipo di utente).

Sul fronte della sicurezza e della privacy, Experiments prevede protezioni come la redazione automatica di dati personali sensibili (PII) e l’opzione on-premise per le aziende che vogliono tenere tutto in casa. Raindrop dichiara che è conforme SOC 2 e pone attenzione al trattamento dei dati utente.