I ricercatori dell’Università di Toronto e LG AI Research hanno sviluppato un algoritmo di intelligenza artificiale (XAI) “spiegabile” che può aiutare a identificare ed eliminare i difetti negli schermi di visualizzazione.

Il nuovo algoritmo, che ha sovraperformato approcci comparabili sui benchmark di settore, è stato sviluppato attraverso una collaborazione di ricerca sull’IA in corso tra LG e U of T che è stata ampliata nel 2019 con un focus sulle applicazioni AI per le aziende.

I ricercatori affermano che l’algoritmo XAI potrebbe essere potenzialmente applicato in altri campi che richiedono una finestra sul modo in cui l’apprendimento automatico prende le sue decisioni, inclusa l’interpretazione dei dati dalle scansioni mediche.

“La spiegabilità e l’interpretabilità riguardano il rispetto degli standard di qualità che ci siamo prefissati come ingegneri e sono richiesti dall’utente finale”, afferma Kostas Plataniotis, professore presso il dipartimento di ingegneria elettrica e informatica di Edward S. Rogers Sr. presso la Facoltà di Applied Scienza e ingegneria. “Con XAI, non esiste una” taglia unica “. Devi chiedere per chi lo stai sviluppando. È per un altro sviluppatore di machine learning? O è per un dottore o un avvocato? “

Il team di ricerca comprendeva anche Mahesh Sudhakar, neolaureato alla U of T Engineering e il candidato al master Sam Sattarzadeh, nonché ricercatori guidati da Jongseong Jang presso LG AI Research Canada, parte del braccio di ricerca e sviluppo globale dell’azienda.

XAI è un campo emergente che affronta i problemi con l’approccio “scatola nera” delle strategie di apprendimento automatico.

In un modello a scatola nera, un computer potrebbe ricevere una serie di dati di addestramento sotto forma di milioni di immagini etichettate. Analizzando i dati, l’algoritmo impara ad associare alcune caratteristiche dell’input (immagini) a determinati output (etichette). Alla fine, può attaccare correttamente etichette a immagini che non ha mai visto prima.

La macchina decide da sola a quali aspetti dell’immagine prestare attenzione e quali ignorare, il che significa che i suoi progettisti non sapranno mai esattamente come si arriva a un risultato.

Ma un tale modello di “scatola nera” presenta delle sfide quando viene applicato ad aree come l’assistenza sanitaria, la legge e le assicurazioni.

“Ad esempio, un modello [di apprendimento automatico] potrebbe determinare che un paziente ha il 90% di probabilità di avere un tumore”, afferma Sudhakar. “Le conseguenze di agire sulla base di informazioni imprecise o distorte sono letteralmente la vita o la morte. Per comprendere e interpretare appieno la previsione del modello, il medico deve sapere come è arrivato l’algoritmo. “

A differenza del tradizionale apprendimento automatico, XAI è progettato per essere un approccio “scatola di vetro” che rende trasparente il processo decisionale. Gli algoritmi XAI vengono eseguiti contemporaneamente agli algoritmi tradizionali per verificare la validità e il livello delle loro prestazioni di apprendimento. L’approccio offre anche opportunità per eseguire il debug e trovare efficienze di formazione.

Sudhakar afferma che, in generale, ci sono due metodologie per sviluppare un algoritmo XAI, ciascuna con vantaggi e svantaggi.

Il primo, noto come back propagation, si basa sull’architettura AI sottostante per calcolare rapidamente in che modo la previsione della rete corrisponde al suo input. Il secondo, noto come perturbazione, sacrifica una certa velocità per l’accuratezza e comporta la modifica degli input di dati e il monitoraggio degli output corrispondenti per determinare la compensazione necessaria.

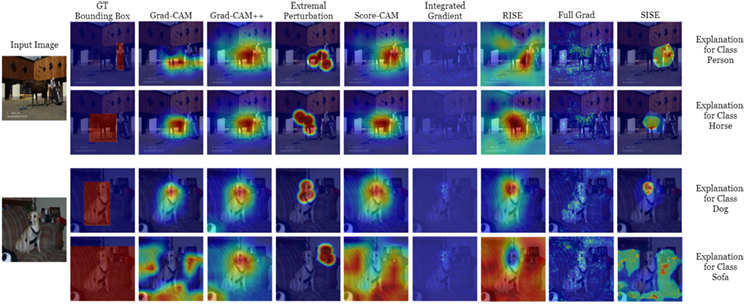

“I nostri partner di LG desideravano una nuova tecnologia che combinasse i vantaggi di entrambi”, afferma Sudhakar. “Avevano un modello [di apprendimento automatico] esistente che identificava le parti difettose nei prodotti LG con display e il nostro compito era migliorare l’accuratezza delle mappe termiche ad alta risoluzione dei possibili difetti mantenendo un tempo di esecuzione accettabile”.

L’algoritmo XAI risultante dal team, Semantic Input Sampling for Explanation (SISE), è descritto in un recente documento per la 35a Conferenza AAAI sull’intelligenza artificiale.

“Vediamo il potenziale in SISE per un’applicazione diffusa”, afferma Plataniotis. “Il problema e l’intento del particolare scenario richiederanno sempre aggiustamenti all’algoritmo, ma queste mappe di calore o” mappe di spiegazione “potrebbero essere interpretate più facilmente, ad esempio, da un medico”.

“L’obiettivo di LG nella collaborazione con l’Università di Toronto è diventare un leader mondiale nell’innovazione dell’IA”, afferma Jang. “Questo primo risultato in XAI parla dei continui sforzi della nostra azienda per dare contributi in più aree, come la funzionalità dei prodotti LG, l’innovazione della produzione, la gestione della catena di fornitura, l’efficienza della scoperta dei materiali e altri, utilizzando l’IA per migliorare la soddisfazione del cliente”.

Il professor Deepa Kundur, presidente del dipartimento di ingegneria elettrica e informatica, afferma che successi come questo sono un buon esempio del valore della collaborazione con i partner del settore.

“Quando entrambi i gruppi di ricercatori si mettono al tavolo con i rispettivi punti di vista, spesso si può accelerare la risoluzione dei problemi”, afferma Kundur. “È inestimabile per gli studenti laureati essere esposti a questo processo.”

Sebbene fosse una sfida per il team raggiungere gli obiettivi aggressivi di precisione e tempo di esecuzione all’interno del progetto lungo un anno – il tutto mentre si destreggiavano tra i fusi orari di Toronto / Seoul e lavoravano sotto i vincoli COVID-19 – Sudhakar afferma che l’opportunità di generare una soluzione pratica per un produttore di fama mondiale è valsa la pena.

“È stato positivo per noi capire esattamente come funziona l’industria”, afferma Sudhakar. “Gli obiettivi di LG erano ambiziosi, ma abbiamo avuto un supporto molto incoraggiante da parte loro, con feedback su idee o analogie da esplorare. È stato molto emozionante”.