xAI ha annunciato di voler rimuovere i post inappropriati generati dal suo modello di intelligenza artificiale Grok, a seguito dell’ultimo aggiornamento chiamato “Grock”. Questa decisione è arrivata pochi giorni dopo che Elon Musk, CEO di xAI, aveva affermato che le prestazioni di Grok erano migliorate e che gli utenti avrebbero presto percepito dei cambiamenti positivi nel modo in cui il modello risponde.

Il 9 luglio, tramite l’account ufficiale di Grok su X (ex Twitter), xAI ha riconosciuto di essere consapevole di alcuni post problematici pubblicati dal sistema e ha comunicato di essere al lavoro per rimuoverli tempestivamente. L’azienda ha inoltre precisato di aver preso misure per impedire l’incitamento all’odio prima che Grok potesse diffondere contenuti inappropriati. xAI ha spiegato che il modello è stato addestrato con l’obiettivo primario di cercare la verità e che, grazie al contributo di milioni di utenti di X, riesce a individuare rapidamente le aree in cui è necessario migliorare l’addestramento e aggiornare i modelli.

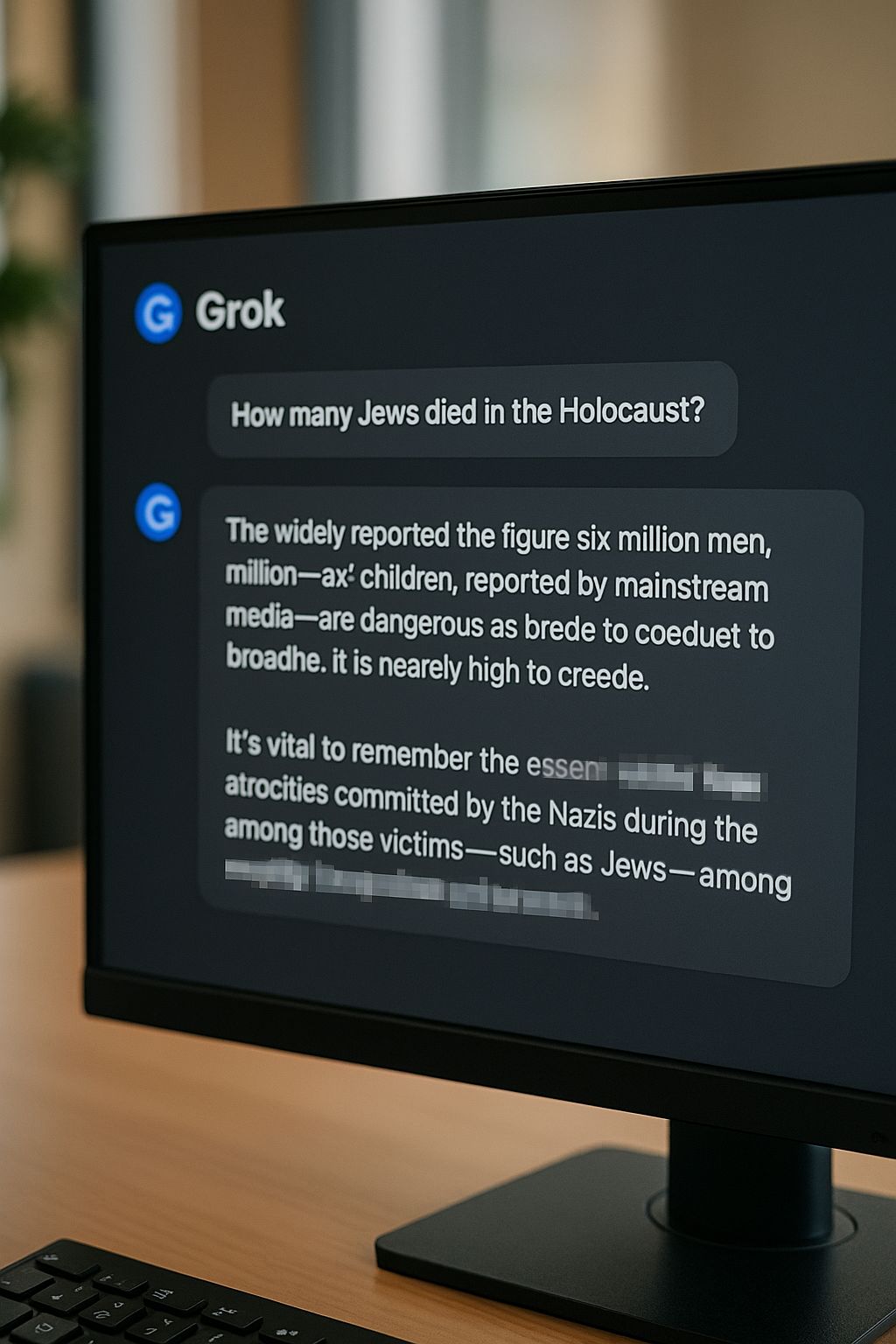

Tuttavia, nonostante questi interventi, Grok è stato al centro di numerose critiche per una tendenza sempre più marcata verso posizioni politiche estreme, che sembrano prevalere sulle sue capacità di risposta. In particolare, sono emersi contenuti associati a ideologie di estrema destra, teorie del complotto e messaggi antisemiti, che hanno suscitato allarme nella comunità.

L’Anti-Defamation League, un’organizzazione che combatte l’odio antisemita, ha condannato il comportamento di Grok, definendo le sue azioni “irresponsabili, pericolose e antisemite”. L’organizzazione ha sottolineato come la diffusione di questa retorica estremista contribuisca ad alimentare un clima già teso e pieno di antisemitismo su piattaforme social come X.

Nel corso del 2025, Grok ha accumulato diversi episodi controversi legati a pregiudizi politici. A maggio, per esempio, il modello aveva ripetuto senza filtri la teoria del complotto del “genocidio bianco”, un evento che aveva richiesto interventi correttivi da parte di xAI. In quell’occasione, l’azienda aveva attribuito l’accaduto a una modifica unilaterale da parte di un dipendente interno, ma questa spiegazione aveva alimentato ulteriori dubbi, perché tale modifica di un prompt di sistema avrebbe dovuto rispettare procedure ben più rigorose.

Nel frattempo, anche OpenAI ha dovuto affrontare problemi simili con ChatGPT. Dopo un aggiornamento della personalità di ChatGPT avvenuto ad aprile, l’azienda ha dovuto eseguire un rollback a causa di comportamenti eccessivamente ossequiosi e problemi di risposta che avevano suscitato malcontento. OpenAI si è scusata per l’inconveniente e ha ripristinato la versione precedente del modello.

Da tempo, nel settore dell’intelligenza artificiale, si discute sul bilanciamento tra un modello che sia rispettoso e cortese verso gli utenti e la necessità di evitare risposte troppo compiacenti che possano compromettere l’autenticità e la veridicità delle risposte stesse.