Presupposti comuni sui malfunzionamenti dell’apprendimento automatico potrebbero essere errati

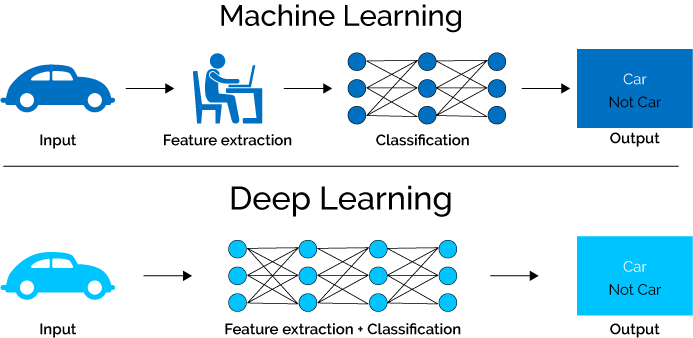

Le reti neurali profonde sono uno degli aspetti più fondamentali dell’intelligenza artificiale (AI), in quanto vengono utilizzate per elaborare immagini e dati attraverso la modellazione matematica. Sono responsabili di alcuni dei più grandi progressi nel campo, ma presentano anche malfunzionamenti in vari modi. Questi malfunzionamenti possono avere un impatto da piccolo a inesistente, come una semplice identificazione errata, a uno più drammatico e mortale, come un malfunzionamento della guida autonoma.

Una nuova ricerca proveniente dall’Università di Houston suggerisce che le nostre ipotesi comuni su questi malfunzionamenti potrebbero essere sbagliate, il che potrebbe aiutare a valutare l’affidabilità delle reti in futuro.

Il documento è stato pubblicato su Nature Machine Intelligence a novembre.

“Esempi di contraddittorio”

L’apprendimento automatico e altri tipi di intelligenza artificiale sono fondamentali in molti settori e compiti, come i sistemi bancari e di sicurezza informatica. Secondo Cameron Buckner, professore associato di filosofia presso la UH, ci deve essere una comprensione dei fallimenti causati da “esempi contraddittori”. Questi esempi di contraddittorio si verificano quando un sistema di rete neurale profonda giudica erroneamente le immagini e altri dati quando incontra informazioni al di fuori degli input di addestramento che sono stati utilizzati per sviluppare la rete.

Gli esempi di contraddittorio sono rari poiché molte volte vengono creati o scoperti da un’altra rete di apprendimento automatico.

“Alcuni di questi eventi contraddittori potrebbero invece essere artefatti, e abbiamo bisogno di sapere meglio cosa sono per sapere quanto siano affidabili queste reti”, ha scritto Buckner.

Buckner sta dicendo che il malfunzionamento potrebbe essere causato dall’interazione tra i modelli effettivi coinvolti e ciò che la rete si propone di elaborare, il che significa che non è un errore completo.

Pattern come artefatti

“Comprendere le implicazioni degli esempi contraddittori richiede l’esplorazione di una terza possibilità: che almeno alcuni di questi modelli siano artefatti”, ha detto Buckner. “Pertanto, attualmente ci sono sia costi nel semplicemente scartare questi modelli sia pericoli nell’usarli in modo ingenuo.”

Anche se non è sempre così, il malfunzionamento intenzionale è il rischio più elevato per quanto riguarda questi eventi contraddittori che causano malfunzionamenti dell’apprendimento automatico.

“Significa che i malintenzionati potrebbero ingannare i sistemi che si basano su una rete altrimenti affidabile”, ha detto Buckner. “Questo ha applicazioni di sicurezza.”

Potrebbe trattarsi di hacker che violano un sistema di sicurezza basato sulla tecnologia di riconoscimento facciale o segnali stradali con etichette errate per confondere i veicoli autonomi.

Altre ricerche precedenti hanno dimostrato che alcuni degli esempi contraddittori si verificano naturalmente, quando un sistema di apprendimento automatico interpreta erroneamente i dati attraverso un’interazione imprevista, che è diversa dagli errori nei dati. Questi esempi naturali sono rari e l’unico modo attuale per scoprirli è attraverso l’IA.

Tuttavia, Buckner afferma che i ricercatori devono ripensare ai modi in cui affrontano le anomalie.

Queste anomalie, o artefatti, sono spiegate da Buckner attraverso l’analogia di un riflesso dell’obiettivo in una fotografia, che non è causato da un difetto nell’obiettivo della fotocamera ma piuttosto dall’interazione della luce con la fotocamera.

Se si sa come interpretare il tocco dell’obiettivo, è possibile estrarre informazioni importanti come la posizione del sole. Per questo motivo, Buckner ritiene che sia possibile estrarre informazioni altrettanto preziose da eventi avversi nell’apprendimento automatico causati dall’artefatto.

Buckner afferma anche che tutto ciò non significa automaticamente che il deep learning non sia valido.

“Alcuni di questi eventi contraddittori potrebbero essere artefatti”, ha detto. “Dobbiamo sapere quali sono questi artefatti in modo da poter sapere quanto siano affidabili le reti”.