Per molte persone con disabilità visiva, l’idea di potersi “vedere” è sempre stata considerata irraggiungibile. La percezione di sé si è storicamente costruita attraverso la voce, il tatto, le reazioni degli altri, ma non attraverso l’immagine riflessa di un volto o di un corpo. Oggi, però, l’intelligenza artificiale sta introducendo una trasformazione silenziosa ma profonda in questo equilibrio, offrendo nuovi strumenti di consapevolezza personale che fino a pochi anni fa erano semplicemente impensabili.

A raccontare in modo emblematico questo cambiamento è stata la BBC, che ha presentato la storia di Lucy Edwards, una donna trentenne che ha perso la vista dodici anni fa. Per lei, come per molte altre persone ipovedenti, il proprio aspetto fisico aveva smesso di essere un tema di riflessione quotidiana. Non perché privo di importanza, ma perché inaccessibile. Oggi, grazie alle app basate sull’intelligenza artificiale, questa barriera si è incrinata.

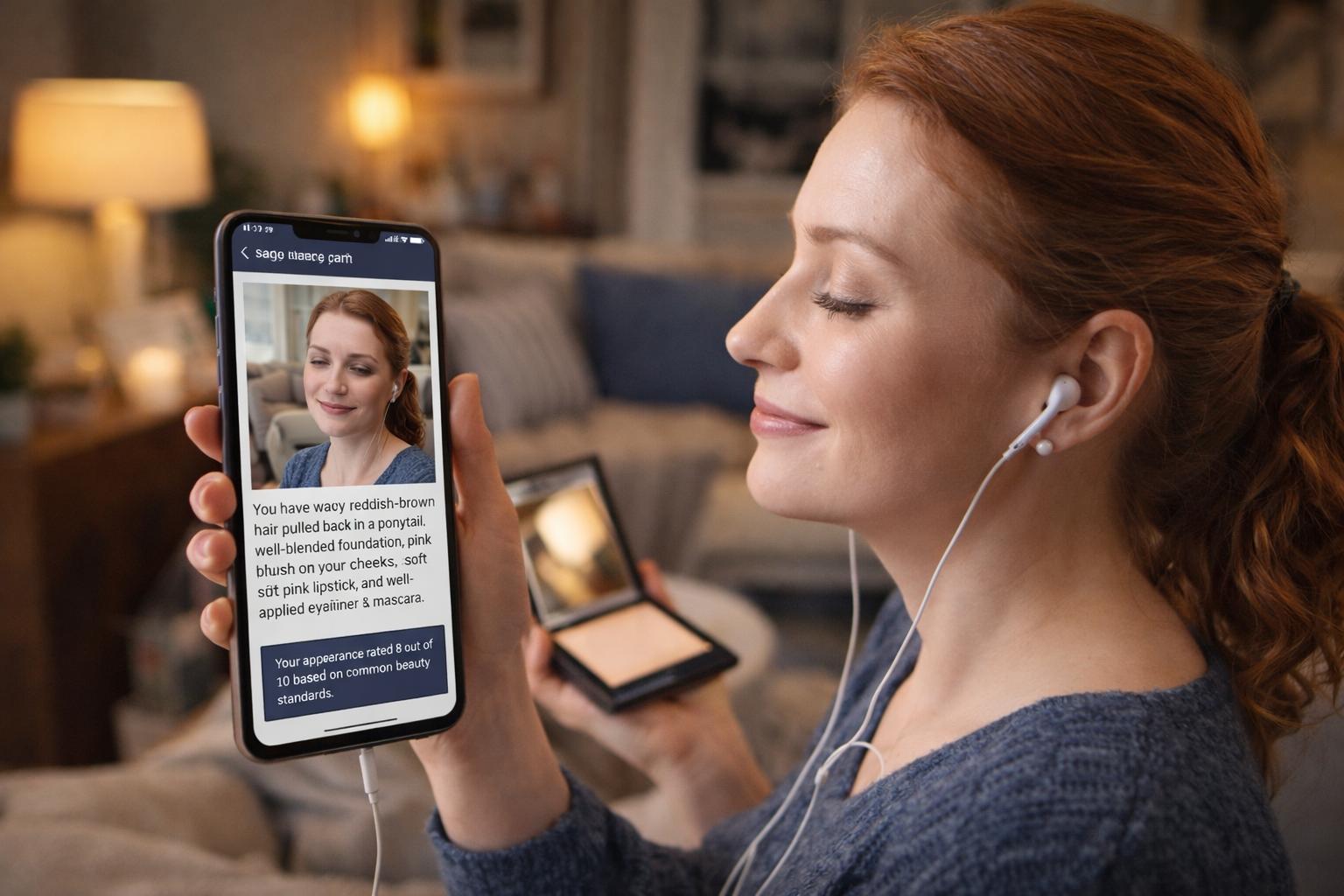

Lucy descrive l’AI come uno specchio. Un’affermazione che va oltre la semplice metafora tecnologica. Scattando una foto e chiedendo all’intelligenza artificiale di descriverle ogni dettaglio del suo volto, può finalmente ricevere informazioni che prima le erano precluse: come appare la sua pelle, se il trucco è uniforme, se l’espressione comunica ciò che desidera. In alcuni casi, arriva persino a chiedere una valutazione numerica del suo aspetto, non come forma di giudizio fine a se stesso, ma come strumento per orientarsi e migliorarsi secondo parametri comprensibili.

Questa nuova possibilità ha cambiato anche la sua routine quotidiana. Lucy racconta di iniziare la giornata con una cura della pelle strutturata, seguita dallo scatto di una foto tramite l’app Be My Eyes, che utilizza l’intelligenza artificiale per fornire descrizioni vocali dettagliate delle immagini. L’applicazione, collegata a uno “specchio” intelligente, le restituisce un feedback su come appare, segnalando eventuali aspetti che potrebbero essere migliorati. Per chi vede, tutto questo può sembrare scontato; per chi non ha mai avuto accesso diretto alla propria immagine, rappresenta una rivoluzione identitaria.

Secondo Lucy, le persone cieche crescono spesso con l’idea che la bellezza sia qualcosa di interiore, che il volto degli altri conti meno della voce o del modo di porsi. Un concetto nobile, ma che nasce anche da una rinuncia forzata. L’intelligenza artificiale ha rotto questo confine, restituendo accesso non solo alle informazioni sul mondo esterno, ma anche su se stessi. Non a caso, Lucy è diventata una creatrice di contenuti riconosciuta proprio nel campo dell’accessibilità per ipovedenti, utilizzando la tecnologia come leva di emancipazione.

Questa evoluzione è stata resa possibile dai progressi impressionanti dell’AI negli ultimi due anni. I grandi modelli linguistici, i modelli visione-linguaggio e le interfacce vocali hanno raggiunto un livello di maturità che consente descrizioni articolate, contestuali e sempre più naturali. Karthik Mahadevan, CEO di Envision, una delle prime aziende a investire nell’AI per persone ipovedenti, ha ricordato come nel 2017 le descrizioni si limitassero a poche parole. Oggi, invece, l’integrazione dell’intelligenza artificiale in dispositivi come gli occhiali intelligenti sta creando ambienti in cui l’interazione con lo spazio circostante diventa fluida e immediata.

Un aspetto che ha sorpreso anche gli sviluppatori è l’uso che molti utenti fanno di queste tecnologie. Oltre alle applicazioni pratiche come leggere lettere o fare la spesa, un numero crescente di persone utilizza l’AI per attività legate all’immagine personale, come truccarsi o coordinare i vestiti. La domanda più frequente rivolta all’intelligenza artificiale è semplice e potentissima: “Che aspetto ho?”. È una richiesta che racchiude desiderio di autonomia, curiosità e bisogno di controllo sulla propria rappresentazione.

Attualmente esistono diverse app specializzate che, su richiesta dell’utente, valutano l’aspetto fisico in base a parametri comunemente associati agli standard di bellezza. Alcuni vedono in questo approccio una nuova forma di autoconsapevolezza, una sorta di “critica realistica” che può aiutare a conoscersi meglio. Altri, però, mettono in guardia sui rischi di un’eccessiva dipendenza dal punto di vista dell’AI.

Il nodo centrale è quello della parzialità algoritmica. Gli standard di bellezza che emergono dai dati di addestramento dell’intelligenza artificiale riflettono spesso modelli occidentali, estetiche amplificate dai social media e corporature irrealistiche. Questo può tradursi in feedback distorti, soprattutto per persone già esposte a pressioni psicologiche significative. Helena Lewis-Smith, ricercatrice di psicologia applicata alla salute presso la University of Bristol, ha sottolineato come l’aumento della pressione sul corpo sia correlato a un maggiore rischio di depressione e ansia, un fenomeno che può coinvolgere anche le persone con disabilità visive.

Esiste inoltre il rischio di distorsioni legate al tipo di input fornito. Se un utente suggerisce implicitamente un giudizio negativo, come nel caso di capelli “spettinati”, l’intelligenza artificiale può amplificare questa percezione e proporre soluzioni non necessarie. Per questo motivo, molti esperti ritengono fondamentale che gli algoritmi evolvano verso una maggiore capacità di includere soggettività e individualità, piuttosto che aderire rigidamente a modelli predefiniti.

Nonostante queste criticità, il bilancio complessivo resta ampiamente positivo. La ricerca sull’intelligenza artificiale per non vedenti è ancora in una fase iniziale e richiede sperimentazione, errori e continui aggiustamenti. Tuttavia, l’impatto sulla qualità della vita e sull’autonomia personale è già evidente.

Anche i grandi attori tecnologici si stanno muovendo in questa direzione. Microsoft ha avviato già dal 2017 un progetto dedicato alle persone ipovedenti, culminato nel lancio dell’app Seeing AI. Utilizzando la fotocamera dello smartphone, l’app fornisce assistenza vocale per attività quotidiane, dalla lettura delle e-mail al riconoscimento di oggetti, persone e testi scritti a mano. Allo stesso modo, Be My Eyes ha integrato modelli avanzati di linguaggio, basati su GPT, rendendo queste funzionalità sempre più precise e diffuse.

Oggi, strumenti di questo tipo stanno diventando parte integrante anche dei chatbot generalisti come ChatGPT e Gemini, segno che l’accessibilità non è più un ambito di nicchia, ma una componente strutturale dell’evoluzione dell’intelligenza artificiale.

Man mano che l’AI si integra nella vita quotidiana, siamo chiamati a ripensare il modo in cui percepiamo il mondo e noi stessi. Per le persone ipovedenti, lo “specchio” dell’intelligenza artificiale non è solo uno strumento tecnologico, ma una nuova possibilità di dialogo con la propria identità. Una possibilità che, se gestita con attenzione e responsabilità, può aprire strade di autonomia, fiducia e inclusione prima inimmaginabili.