Valutazione di DeepMind sul Progresso verso l’AGI

Il cammino verso il raggiungimento dell’Intelligenza Generale Artificiale (AGI), sistemi con capacità pari o superiori a quelle umane nella maggior parte dei compiti, rimane un argomento di dibattito tra gli scienziati. Le opinioni variano dall’AGI ancora distante, alla possibilità di emergere entro un decennio, fino alle “scintille di AGI” già visibili negli attuali modelli linguistici di grandi dimensioni (LLM). Alcuni ricercatori affermano addirittura che gli LLM di oggi rappresentino AGI.

Un team di Google DeepMind, incluso il capo scienziato AGI Shane Legg, ha proposto un nuovo quadro per classificare le capacità e il comportamento dei sistemi AGI e dei loro precursori. Sottolineano la necessità per la comunità di ricerca in intelligenza artificiale di riflettere esplicitamente su cosa si intenda per “AGI” e di aspirare a quantificare attributi come prestazioni, generalità e autonomia dei sistemi AI.

Principi dell’AGI

Una delle principali sfide dell’AGI è stabilire una definizione chiara. I ricercatori di DeepMind hanno analizzato nove diverse definizioni di AGI, compreso il test di Turing, il test del caffè, misure di coscienza, misure economiche e capacità relative ai compiti. Hanno evidenziato le carenze di ogni definizione nel catturare l’essenza dell’AGI.

Ad esempio, gli attuali LLM potrebbero superare il test di Turing, ma generare un testo convincente da soli è chiaramente insufficiente per l’AGI. Determinare se le macchine possiedano attributi di coscienza rimane un obiettivo poco chiaro e sfuggente. Inoltre, sebbene il fallimento in alcuni compiti (come preparare il caffè in una cucina casuale) possa indicare che un sistema non sia AGI, superarli non conferma necessariamente il suo status AGI.

Per fornire un quadro più completo per l’AGI, i ricercatori propongono sei criteri per misurare l’intelligenza artificiale:

- Le misure dell’AGI dovrebbero concentrarsi sulle capacità piuttosto che su qualità come la comprensione, la coscienza o la sensibilità umana.

- Le misure dell’AGI dovrebbero considerare sia la generalità che i livelli di prestazione, assicurando che i sistemi AGI possano eseguire un’ampia gamma di compiti eccellentemente.

- L’AGI dovrebbe richiedere compiti cognitivi e metacognitivi, ma l’incarnazione e i compiti fisici non dovrebbero essere considerati prerequisiti per l’AGI.

- Il potenziale di un sistema per eseguire compiti a livello AGI è sufficiente, anche se non implementabile, poiché i requisiti di implementazione introducono ostacoli non tecnici come considerazioni legali e sociali, oltre a potenziali problemi etici e di sicurezza.

- Le metriche AGI dovrebbero concentrarsi sui compiti del mondo reale che le persone apprezzano, descritti come “ecologicamente validi”.

- L’AGI non è un singolo punto finale ma un percorso, con vari livelli di AGI lungo la strada.

Profondità e Ampiezza dell’Intelligenza

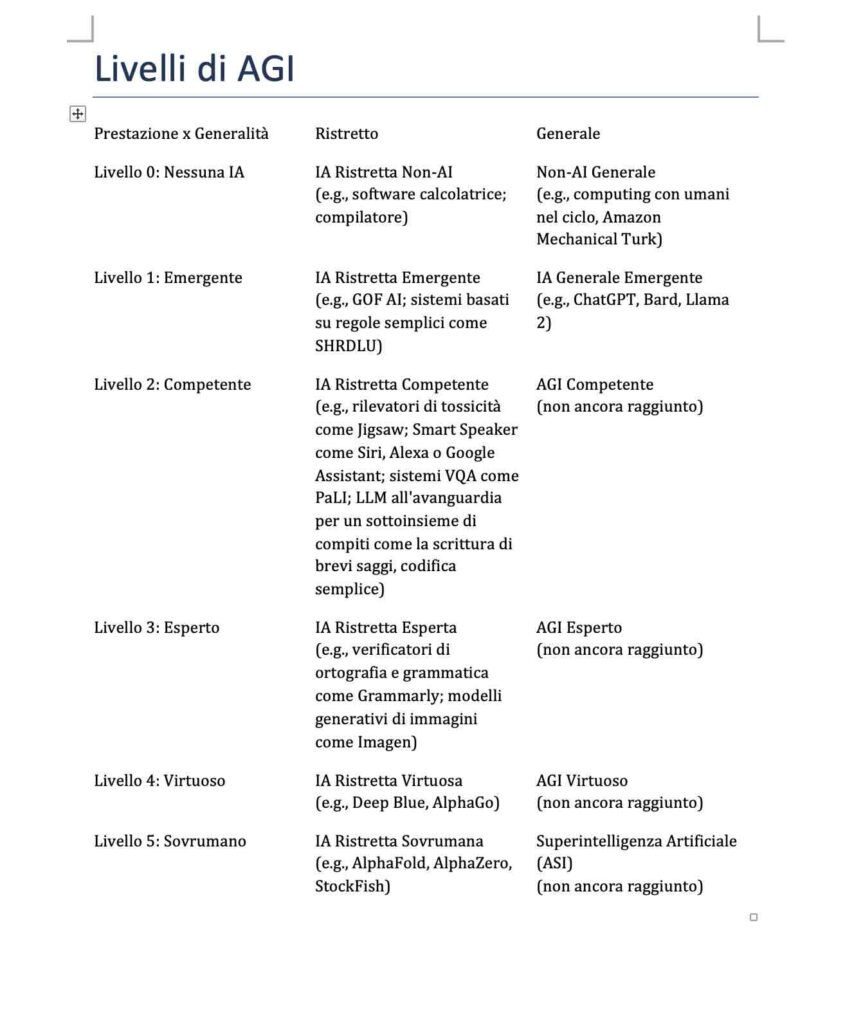

DeepMind presenta una matrice che misura “prestazioni” e “generalità” su cinque livelli, che vanno dall’assenza di intelligenza artificiale all’AGI sovrumana, un sistema di intelligenza artificiale generale che supera tutti gli esseri umani in tutti i compiti. Le prestazioni si riferiscono a come le capacità di un sistema di intelligenza artificiale si confrontano con quelle umane, mentre la generalità denota l’ampiezza delle capacità del sistema di intelligenza artificiale o la gamma di compiti per i quali raggiunge il livello di prestazione specificato nella matrice.

La matrice distingue anche tra IA ristretta e generale. Ad esempio, abbiamo già sistemi di intelligenza artificiale sovrumani come AlphaZero e AlphaFold, che eccellono in compiti molto specifici. Questa matrice consente la classificazione dei sistemi di IA a diversi livelli. I modelli linguistici avanzati come ChatGPT, Bard e Llama 2 sono “competenti” (Livello 2) in alcuni compiti ristretti, come la scrittura di saggi brevi e la codifica semplice, ed “emergenti” (Livello 1) in altri, come abilità e compiti matematici che richiedono ragionamento e pianificazione.

Autonomia e Rischio

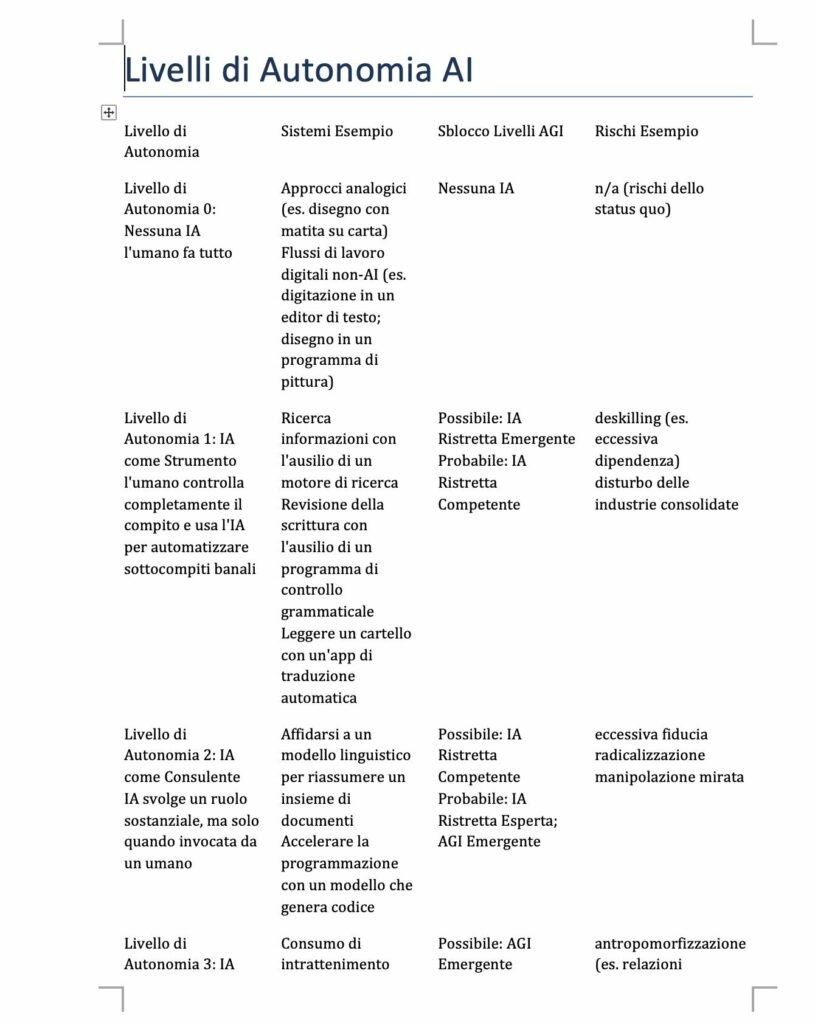

DeepMind introduce una matrice separata per misurare l’autonomia e il rischio nei sistemi di intelligenza artificiale, che vanno dal livello 0, in cui un essere umano esegue tutti i compiti, al livello 5, che rappresenta un’intelligenza artificiale completamente autonoma, con vari livelli intermedi in cui gli esseri umani e l’intelligenza artificiale condividono compiti e autorità.

I rischi associati ai sistemi di intelligenza artificiale variano a seconda del loro livello di autonomia. Ai livelli più bassi, dove l’intelligenza artificiale agisce come un potenziatore delle competenze umane, i rischi includono la dequalificazione e lo sconvolgimento delle industrie attuali. Con l’aumento dell’autonomia, i rischi possono comportare manipolazioni mirate attraverso contenuti personalizzati, disagi sociali più ampi e danni più gravi causati dal disallineamento di agenti completamente autonomi con i valori umani.

Il framework di DeepMind, come tutte le cose riguardanti AGI, avrà i suoi difetti e detrattori. Ma rappresenta una guida completa per valutare a che punto siamo nel viaggio verso lo sviluppo di sistemi di intelligenza artificiale in grado di superare le capacità umane.