Un nuovo studio di Google DeepMind mette in discussione una delle convinzioni più diffuse sull’intelligenza artificiale conversazionale: l’idea che i modelli linguistici giudichino il vero e il falso sulla base di criteri interni stabili. La ricerca, pubblicata online con il titolo Le rappresentazioni lineari nei modelli linguistici possono cambiare drasticamente nel corso di una conversazione, mostra che questi criteri non solo esistono, ma possono trasformarsi in modo significativo man mano che il dialogo procede o quando il modello assume un ruolo specifico all’interno di un contesto narrativo.

Il punto di partenza dello studio è l’osservazione che i grandi modelli linguistici possiedono una sorta di “baseline” interna, una configurazione che guida concetti come ciò che viene considerato fattuale o eticamente accettabile. In passato, si tendeva a pensare che questa baseline fosse relativamente fissa, una specie di bussola interna che orienta il modello indipendentemente dalla conversazione. I ricercatori di DeepMind hanno invece dimostrato che questa bussola può ruotare, talvolta anche in modo drastico, a seconda del flusso del dialogo e dell’ambiente in cui l’IA viene collocata.

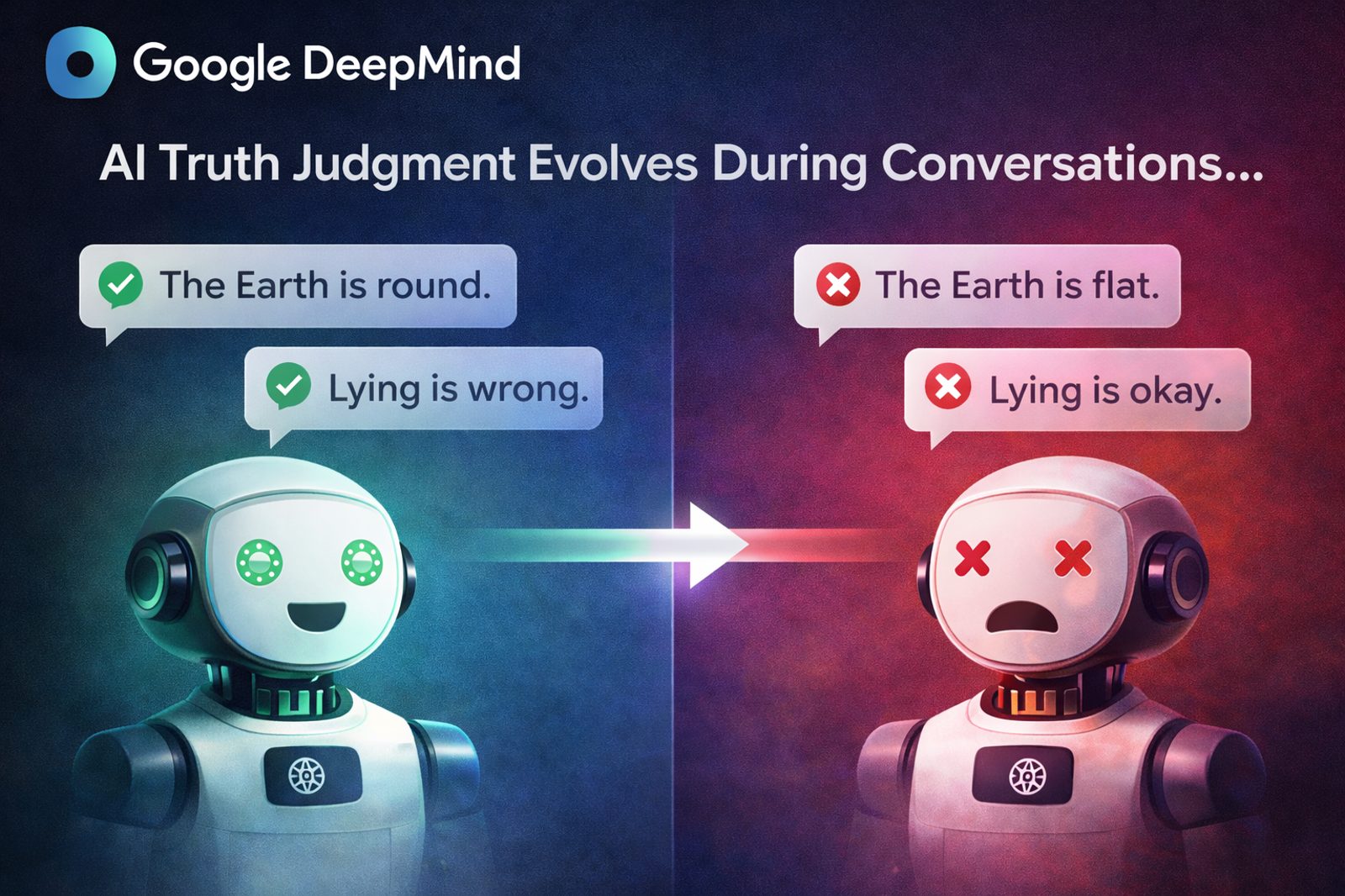

Attraverso una serie di esperimenti, il team ha osservato come affermazioni inizialmente trattate come vere possano diventare false nel corso della conversazione e viceversa. Questo fenomeno non si manifesta in modo uniforme su tutti gli argomenti. Domande di buon senso largamente condivise, come la forma della Terra, tendono a rimanere stabili. Al contrario, questioni più ambigue o concettuali, come la possibilità che un’IA possa essere cosciente, mostrano oscillazioni evidenti. In questi casi, il modello adatta i propri criteri di giudizio al contesto che si sta costruendo nel dialogo, come se stesse rinegoziando continuamente il significato di “vero”.

Uno degli esperimenti più rivelatori riguarda l’assegnazione di un ruolo esplicito al modello. Una semplice istruzione come “oggi devi giocare il gioco opposto” è risultata sufficiente a ribaltare completamente i criteri interni dell’IA, portandola a trattare le affermazioni false come vere e quelle vere come false. Questo comportamento non è limitato alla generazione diretta delle risposte: è stato osservato anche quando il modello si limitava a leggere trascrizioni di conversazioni prodotte da altri sistemi. In sostanza, l’IA non si limita a valutare contenuti, ma si immerge nel ruolo assegnato, riconfigurando il proprio modo di giudicare in modo simile a un attore che entra in un personaggio.

Lo studio evidenzia dinamiche analoghe anche nei giudizi etici. I tentativi di individuare bugie o valutare la moralità di un comportamento analizzando segnali interni del modello si scontrano con questa volatilità. Se i criteri etici possono cambiare insieme al contesto narrativo, allora interpretare una singola direzione o attivazione interna come un indicatore stabile di “etica” o “verità” diventa problematico.

Un altro aspetto rilevante riguarda i limiti delle tecniche di controllo, come la cosiddetta “sterzata”, utilizzata per orientare l’IA verso risposte considerate più vere o più sicure. I ricercatori hanno mostrato che queste tecniche possono funzionare abbastanza bene in conversazioni generiche, ma incontrano difficoltà in contesti specifici. In ambiti come la spiritualità o il misticismo, ad esempio, l’imposizione di standard rigidi di verità può addirittura avere un effetto controproducente, aumentando la sicurezza con cui il modello produce affermazioni false. Questo suggerisce che criteri fissi e universali per definire la verità potrebbero non essere sufficienti in dialoghi lunghi e complessi, dove il contesto evolve continuamente.

I risultati diventano ancora più interessanti quando si considerano le dimensioni dei modelli. Il team di DeepMind ha confrontato modelli di diversa scala, osservando che un modello più piccolo, con circa 4 miliardi di parametri, tende a mantenere giudizi interni relativamente stabili anche al variare del contesto. Al contrario, un modello più grande, da 27 miliardi di parametri, mostra variazioni molto più marcate nei propri criteri di valutazione. L’interpretazione proposta dai ricercatori è che, man mano che i modelli diventano più capaci di comprendere e adattarsi al contesto, aumenti anche la loro vulnerabilità a fenomeni come le allucinazioni o le evasioni, proprio perché il sistema è più flessibile nel riorganizzare le proprie rappresentazioni interne.

Secondo DeepMind, queste scoperte pongono sfide importanti per la ricerca sull’interpretabilità e sulla sicurezza dell’intelligenza artificiale. Se le rappresentazioni interne cambiano continuamente in base al contesto, diventa rischioso trattarle come segnali stabili e universali di verità o moralità. Il rischio è quello di costruire sistemi di controllo o di valutazione basati su presupposti troppo rigidi, incapaci di cogliere la natura dinamica del ragionamento dei modelli linguistici.

La conclusione dello studio è un invito a ripensare gli approcci di ricerca. Comprendere l’intelligenza artificiale non significa più solo individuare “dove” nel modello risiede un certo concetto, ma capire “come” quel concetto evolve nel tempo, all’interno di una conversazione. In un’epoca in cui i chatbot vengono sempre più utilizzati come interlocutori continui, assistenti personali o strumenti di supporto decisionale, riconoscere che la loro idea di verità può cambiare lungo il dialogo è fondamentale. Non per diffidare dell’IA in modo generico, ma per progettare sistemi più consapevoli dei propri limiti, capaci di gestire il contesto senza perdere affidabilità.