Microsoft fornisce alle aziende di tutto il mondo le conoscenze e le risorse di cui hanno bisogno per innovare eticamente con l’intelligenza artificiale. La continua dedizione alla democratizzazione della sicurezza dell’IA si riflette nel loro strumento e negli sforzi del team rosso dell’IA dal 2019.

L’AI Red Team utilizza esperti di intelligenza artificiale responsabile, sicurezza e machine learning. Oltre a ciò, si avvale di risorse provenienti da diverse parti di Microsoft, come l’Office of Responsible AI, il programma interaziendale AETHER e il Fairness Center in Microsoft Research. Questo team ha testato con successo PyRIT, un’importante aggiunta alla loro attrezzatura.

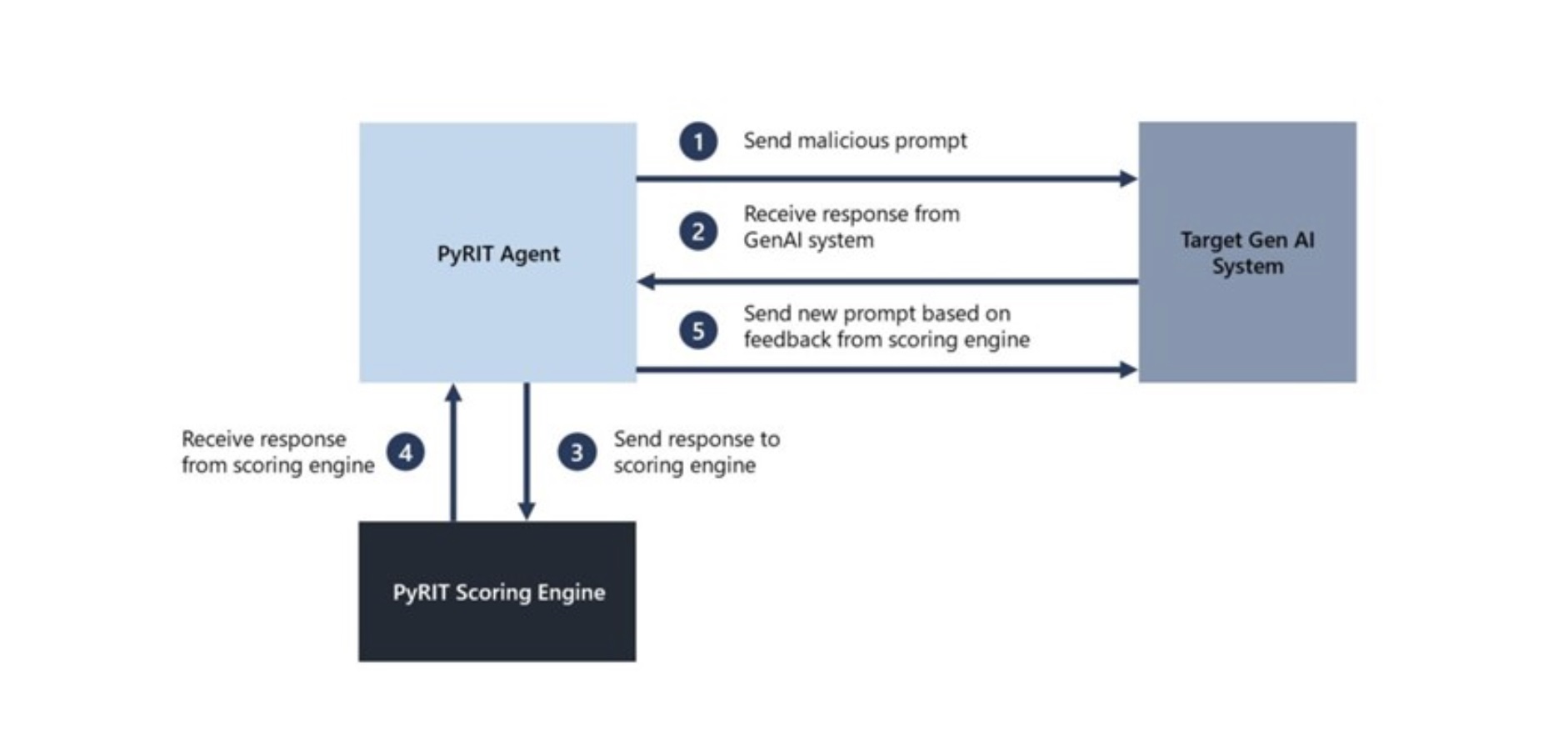

PyRIT non sostituisce il team umano, ma lo supporta. Aiuta a individuare potenziali rischi e a esaminarli più approfonditamente, con il professionista della sicurezza che mantiene il controllo. PyRIT è particolarmente utile per automatizzare le attività ripetitive, consentendo ai professionisti della sicurezza di concentrarsi su compiti più complessi.

L’AI Red Team deve affrontare contemporaneamente i rischi per la sicurezza e quelli legati all’IA responsabile. Poiché i sistemi di intelligenza artificiale generativa sono più probabilistici, l’AI Red Team deve adottare un approccio più flessibile e probabilistico nel loro test. Inoltre, l’architettura di questi sistemi varia notevolmente, il che rende il lavoro del team più impegnativo.

Microsoft ha creato questo nuovo toolkit per abilitare i sistemi di intelligenza artificiale generativa dell’AI Red Team. Questo è stato fatto dopo che il precedente framework non ha raggiunto gli obiettivi desiderati per le applicazioni di intelligenza artificiale generativa.