Uno strumento di annotazione delle immagini basato su browser per set di dati di visione artificiale

I ricercatori finlandesi hanno sviluppato uno strumento di etichettatura delle immagini basato su browser destinato a migliorare la facilità e la velocità dei noiosi processi di annotazione delle immagini per i set di dati di visione artificiale. Installato come estensione indipendente dal sistema operativo per i motori di browser più diffusi, il nuovo strumento consente agli utenti di “annotare durante la navigazione libera”, piuttosto che dover inserire una sessione di etichettatura nel contesto di una configurazione dedicata o eseguire client codice laterale e altre circostanze speciali.

Intitolato BRIMA (Low-Overhead BRowser-only IMage Annotation tool), il sistema è stato sviluppato presso l’Università di Jyväskylä. Elimina la necessità di raschiare e compilare set di dati in directory locali o remote e può essere configurato per ricavare dati utili dai vari parametri di dati disponibili su qualsiasi piattaforma pubblica.

In questo modo BRIMA (che sarà presentato a ICIP 2021 , quando sarà reso disponibile anche il codice ) ovvia ai potenziali ostacoli che possono sorgere quando i sistemi automatizzati di web-scraping vengono bloccati tramite range IP o altri metodi, e impedita la raccolta dei dati – uno scenario destinato a diventare più comune man mano che la protezione IP diventa sempre più importante, come ha recentemente fatto con lo strumento di generazione di codice basato sull’intelligenza artificiale di Microsoft, Copilot.

Poiché BRIMA è destinato esclusivamente all’annotazione basata sull’uomo, è anche meno probabile che il suo utilizzo attivi altri tipi di blocchi stradali, come le sfide CAPTCHA o altri sistemi automatizzati destinati a bloccare gli algoritmi di raccolta dei dati.

Capacità adattive di raccolta dati

BRIMA è implementato tramite un componente aggiuntivo di Firefox o un’estensione di Chrome su Windows, OSX o Linux e può essere configurato per acquisire dati salienti in base a punti dati che una particolare piattaforma può scegliere di esporre. Ad esempio, quando si annotano le immagini in Google Street View, il sistema può tenere conto dell’orientamento e del punto di vista dell’obiettivo e registrare l’esatta geolocalizzazione dell’oggetto specificato sotto l’attenzione dell’utente.

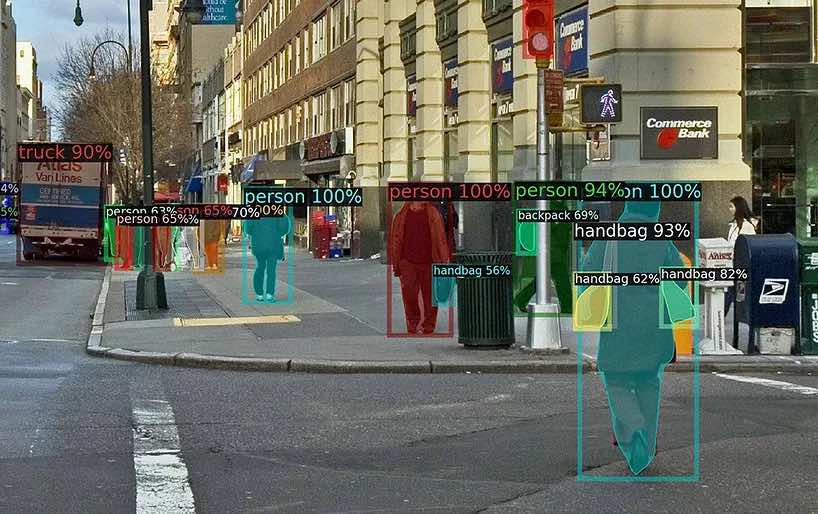

BRIMA è stato testato nel settembre del 2020 dai suoi creatori, durante la collaborazione su un’iniziativa di crowdsourcing per generare un set di dati di rilevamento di oggetti per oggetti CCTV (telecamere di videosorveglianza montate in spazi pubblici o visibili da spazi pubblici).

Il sistema è composto da un’installazione lato client JavaScript leggera sotto forma di estensione del browser e un aspetto lato server che riceve e compila i dati di annotazione. Le implementazioni di riferimento dell’installazione lato server sono state scritte in Python e PHP con Flask e Swagger/OpenAPI, ma i ricercatori sottolineano che l’architettura di elaborazione centrale può essere facilmente trasferita in altri linguaggi e configurazioni.

L’estensione del browser e il server comunicano tramite richieste API RESTful e HTTP/XHR, con i dati lato client inviati a casa in un formato JSON compatibile con MS COCO. Ciò significa che i dati sono immediatamente utilizzabile con una varietà dei più popolari framework di rilevamento di oggetti, tra cui diversi back-end per tensorflow, come ad esempio di Facebook Detectron2 e CenterMask2 .

Strumenti specifici per il progetto

Nonostante la natura generica di BRIMA, può essere configurato in configurazioni di raccolta dati altamente specifiche, inclusa l’imposizione di menu a discesa e altri tipi di input contestuali relativi a un particolare dominio. Nell’immagine sottostante vediamo che in BRIMA è stato scritto un menu a discesa relativo alle informazioni sulla fotocamera, in modo che un gruppo di annotatori possa fornire informazioni dettagliate e rilevanti per il progetto.

Questi strumenti aggiuntivi possono essere configurati localmente. L’estensione offre anche una facile installazione e scorciatoie da tastiera configurabili, insieme a elementi dell’interfaccia utente codificati a colori.

Il lavoro si basa su una serie di tentativi negli ultimi anni per migliorare la facilità di annotazione delle immagini per i dati ottenuti sul Web o di pubblico dominio. Lo strumento PhotoStuff , supportato da DARPA, offre annotazioni online tramite un portale web dedicato e può essere eseguito sul web semantico o come applicazione autonoma; nel 2004 UC Berkeley ha proposto l’ annotazione fotografica su un telefono con fotocamera , che sfruttava pesantemente i metadati, a causa delle limitazioni della copertura di rete e dei limiti di visualizzazione dell’epoca; Anche il progetto LabelMe del MIT del 2005 si è avvicinato all’annotazione basata su browser, facendo affidamento sugli strumenti MATLAB;

Dalla sua uscita nel 2015, il framework FOSS Python/QT LabelImg ha guadagnato popolarità negli sforzi di annotazione crowdsourcing, con un’installazione locale dedicata. Tuttavia, i ricercatori di BRIMA osservano che LabelImg si concentra sugli standard PascalVOC e YOLO, non supporta il formato MS COCO JSON ed evita gli strumenti di contorno poligonali a favore di semplici regioni di cattura rettangolari (che richiederanno una successiva segmentazione).