Se vuoi lavorare e fare ricerche nell’arena del Machine Learning, questi sono gli 8 termini chiave che non puoi ignorare. Siete pronti?

1.Algoritmo

Gli algoritmi sono un elemento fondamentale nel mondo del Machine Learning. Un algoritmo è una sequenza logica di istruzioni che descrivono passo dopo passo come risolvere un problema.

Molto spesso, l’algoritmo funziona come una sequenza di semplici istruzioni if → then. Altri sono più complessi e includono equazioni o formule matematiche.

L’obiettivo di un algoritmo di Machine Learning è definire i passaggi necessari per apprendere dai dati e risolvere un problema in autonomia.

Alcune famose famiglie di algoritmi di Machine Learning sono algoritmi di clustering, regressione o raccomandazione.

2 Apprendimento profondo – DEEP LEARNING

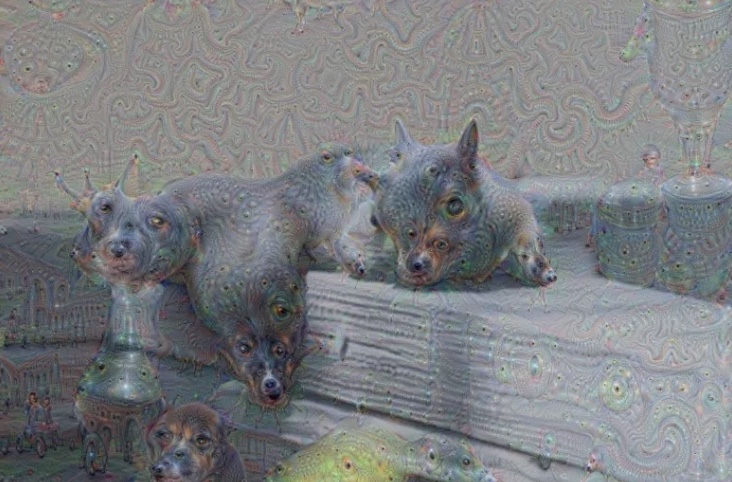

Il Deep Learning è un insieme di algoritmi che cercano di riprodurre gli stessi risultati del cervello umano.

Gli algoritmi seguono una logica di processi stratificati che simulano il funzionamento di base del cervello attraverso i neuroni. Nel Deep Learning questi neuroni sono conosciuti come “strati”.

Proprio come il nostro cervello impara quando dobbiamo imparare qualcosa di nuovo, come parlare, andare in bicicletta, ecc. gli algoritmi cercano questa imitazione imparando a riconoscere schemi di ripetizione, parole specifiche, comportamenti frequenti, in modo che siano in grado di rispondere automaticamente ai dati di input, proprio come il nostro cervello risponde a qualsiasi input.

3 Reti neurali – Neural networks

Le reti neurali sono una classe di algoritmi di apprendimento automatico utilizzati per modellare modelli complessi in set di dati utilizzando più livelli nascosti e funzioni di attivazione non lineari.

Una rete neurale riceve un input, lo trasmette attraverso più strati di neuroni nascosti e genera una previsione che rappresenta l’input combinato di tutti i neuroni.

Le reti neurali vengono addestrate in modo iterativo utilizzando tecniche di ottimizzazione come la discesa del gradiente. Dopo ogni ciclo di addestramento, viene calcolata una metrica di errore in base alla differenza tra la previsione e l’obiettivo.

Le derivate di questa metrica di errore vengono calcolate e propagate attraverso la rete utilizzando una tecnica chiamata backpropagation. I coefficienti (pesi) di ciascun neurone vengono regolati in base a quanto hanno contribuito all’errore totale.

Questo processo viene ripetuto iterativamente finché l’errore di rete non scende al di sotto di una soglia accettabile.

4 Elaborazione del linguaggio naturale (PNL) Natural Language Processing

Natural Language Processing è un termine molto ampio che comprende tutte le tecniche relative all’elaborazione delle comunicazioni umane, sia in linguaggio orale che scritto.

Tradizionalmente, l’analisi della PNL era basata su regole lessicografiche. Con l’avvento del machine learning, possono essere combinati con nuovi strumenti di intelligenza artificiale come il deep learning. Tra questi, possiamo evidenziare le reti LSTM.

Le applicazioni pratiche della PNL sono molte e hanno conosciuto una crescita spettacolare grazie alle nuove tecniche di Machine Learning.

Esistono più applicazioni NLP, tra le quali possiamo evidenziare: traduzione di testo, da parlato a testo, da testo a parlato, estrazione di entità, classificazione, analisi del sentiment ed emozioni e persino chat bot e assistenti virtuali come Alexa o Siri.

5 Regressione

I problemi di regressione cercano di modellare il comportamento di una variabile quantitativa (variabile obiettivo) sulla base di altre variabili predittive (componenti o caratteristiche) che possono essere quantitative o qualitative con il solito obiettivo di fare previsioni o stime.

Esistono diversi algoritmi per risolvere questo tipo di problema. Tra questi, spiccano i seguenti:

- Regressione lineare: comprende una serie di coefficienti e un termine indipendente che, applicato ai valori delle variabili componenti, consentono di generare approssimativamente il valore della variabile target. Richiede l’utilizzo di variabili quantitative e si distingue per la facilità di interpretazione.

- Alberi decisionali: il campione viene partizionato in base alla profondità dell’albero e viene calcolata la media dei valori della variabile obiettivo nei nodi foglia. La sua interpretazione è semplice e funziona con variabili componenti sia qualitative che quantitative.

- Random Forest e Gradient-Boosted Trees: questi modelli, disponibili anche nei problemi di classificazione, possono essere utilizzati in regressione per ottenere un migliore adattamento della variabile target, rendendo difficile l’interpretazione dei modelli.

- 6 Apprendimento per rinforzo reinforcement learnings

L’apprendimento per rinforzo è uno dei tre tipi in cui sono solitamente raggruppati i tipi di apprendimento (insieme all’apprendimento supervisionato e non supervisionato). Si differenzia dagli altri tipi in quanto si occupa di algoritmi orientati agli obiettivi. L’algoritmo deve imparare come raggiungere un obiettivo complesso oa lungo termine attraverso diversi passaggi.

I seguenti concetti devono essere chiaramente identificati

-Agent: l’elemento che esegue le azioni.

- Policy: la strategia che decide quali azioni vengono eseguite in base a uno stato.

- Ambiente: il mondo in cui si muove l’agente.

- Premio: la misura sulla quale si decide la bontà di un’azione.

- Stato: la situazione dell’ambiente in un momento specifico.

- Azione: uno dei numerosi atti che l’agente può eseguire.

7 Tensorflow

Tensorflow è la libreria open source sviluppata da Google per realizzare progetti di Machine Learning.

TensorFlow è stato creato dal team di Google Brain e rilasciato nel 2015 con la licenza Apache 2.0. Oggi è uno degli strumenti più diffusi nel mondo del Machine Learning, in particolare per la costruzione di reti di neuroni.

Sebbene TensorFlow sia utilizzato principalmente nell’area Machine Learning, può essere utilizzato anche per altri tipi di algoritmi che richiedono attività di calcolo numerico mediante grafici di dati.

Ci sono altre alternative a TensorFlow sul mercato come PyTorch di Facebook e MXNet di Amazon.

8 Visione artificiale Computer Vision

La visione artificiale è un’ampia area di competenza che mira a descrivere il mondo che vediamo in una o più immagini e a ricostruirne le proprietà, come forma, illuminazione e distribuzioni dei colori. È sorprendente che gli esseri umani e gli animali lo facciano così facilmente, mentre gli algoritmi di visione artificiale sono così soggetti a errori. Alcune applicazioni nella vita reale sono:

- Riconoscimento ottico dei caratteri (OCR): lettura di codici postali scritti a mano sulle lettere

- Ispezione della macchina: ispezione rapida delle parti per la garanzia della qualità utilizzando la visione stereo con illuminazione specializzata per misurare le tolleranze su ali di aeromobili o parti di carrozzeria o ricerca di difetti nei getti di acciaio utilizzando la visione a raggi X.

- Retail: riconoscimento oggetti per corsie di cassa automatizzate

- Costruzione di modelli 3D (fotogrammetria): costruzione completamente automatizzata di modelli 3D da fotografie aeree utilizzate in sistemi come Google Maps.

- Imaging medico: registrazione di immagini preoperatorie e intraoperatorie o esecuzione di studi a lungo termine sulla morfologia del cervello delle persone con l’età.

- Sicurezza automobilistica: rilevamento di ostacoli imprevisti come i pedoni sulla strada, in condizioni in cui le tecniche di visione attiva come radar o lidar non funzionano bene.

- Match Move: fusione di immagini generate dal computer (CGI) con riprese di azioni dal vivo monitorando i punti caratteristici nel video sorgente per stimare il movimento della telecamera 3D e la forma dell’ambiente. Tali tecniche sono ampiamente utilizzate a Hollywood (ad esempio, in film come Jurassic Park) in stuoie precise per inserire nuovi elementi tra elementi in primo piano e sfondo.

- Motion capture (mocap): utilizzo di marker retroriflettenti visualizzati da più telecamere o altre tecniche basate sulla visione per catturare attori per l’animazione al computer;

- Sorveglianza: monitoraggio degli intrusi, analisi del traffico autostradale e monitoraggio delle piscine per le vittime di annegamento.

- Riconoscimento delle impronte digitali e biometria: per l’autenticazione automatica dell’accesso e per le applicazioni forensi.