AI ha imparato a usare gli strumenti dopo quasi 500 milioni di giochi a nascondino

Neiprimi giorni di vita sulla Terra, organismi biologici erano estremamente semplici. Erano microscopiche creature unicellulari con poca o nessuna capacità di coordinarsi. Eppure miliardi di anni di evoluzione attraverso la competizione e la selezione naturale hanno portato alle complesse forme di vita che abbiamo oggi, così come alla complessa intelligenza umana.

I ricercatori di OpenAI, il laboratorio di ricerca sull’intelligenza artificiale a scopo di lucro con sede a San Francisco, stanno ora testando un’ipotesi: se potessi imitare quel tipo di competizione in un mondo virtuale, darebbe origine anche a un’intelligenza artificiale molto più sofisticata?

L’esperimento si basa su due idee esistenti sul campo: l’apprendimento multi-agente, l’idea di mettere più algoritmi in competizione o coordinamento per provocare comportamenti emergenti e l’ apprendimento di rinforzo , la specifica tecnica di apprendimento automatico che impara a raggiungere un obiettivo attraverso la prova e errore. (DeepMind ha reso popolare quest’ultimo con il suo rivoluzionario programma AlphaGo, che ha battuto il miglior giocatore umano nell’antico gioco da tavolo cinese Go.)

In un nuovo articolo pubblicato oggi, OpenAI ha ora rivelato i suoi risultati iniziali. Attraverso un semplice gioco a nascondino centinaia di milioni di volte, due team opposti di agenti di intelligenza artificiale hanno sviluppato complessi nascondigli e strategie di ricerca che hanno comportato l’uso e la collaborazione degli strumenti. La ricerca offre inoltre informazioni sulla strategia di ricerca dominante di OpenAI: ridimensionare in modo significativo le tecniche di intelligenza artificiale esistenti per vedere quali proprietà emergono.

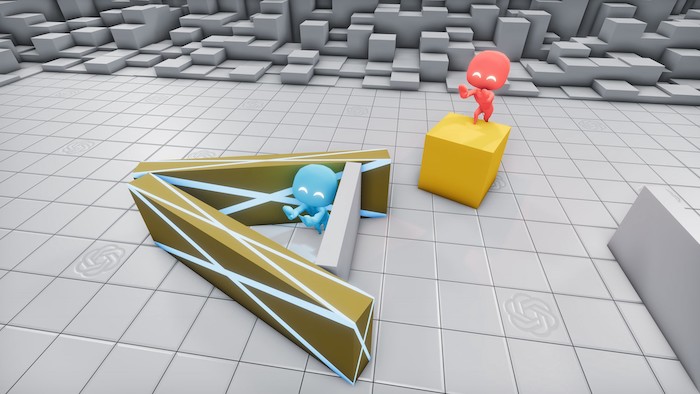

2 robot blu si nascondono da 3 robot rossi in un forte triangolare composto da 3 lunghe scatole rettangolari.

Dopo circa 25 milioni di round di nascondino, i cacciatori hanno imparato a costruire forti per vincere la partita.

Sei fasi della strategia

Per creare il gioco, i ricercatori hanno progettato un ambiente virtuale che consisteva in uno spazio chiuso con vari oggetti come blocchi, rampe e barriere mobili e immobili. Gli agenti stessi erano controllati da algoritmi di apprendimento del rinforzo. Per ogni partita, gli agenti sono stati divisi in due squadre: i cacciatori sono stati premiati o penalizzati per aver evitato o fallito di evitare i cercatori, rispettivamente; i cercatori venivano anche ricompensati o penalizzati per aver trovato o non trovato i cacciatori. Come in un classico gioco a nascondino, anche i cacciatori hanno avuto un vantaggio di pochi secondi. I ricercatori non hanno dato agli agenti altre istruzioni.

Nel corso di centinaia di milioni di round di gioco, gli agenti hanno sviluppato diverse strategie e controstrategie. Durante la prima fase, i cacciatori e i cercatori hanno sviluppato strategie molto grossolane per evitare e inseguire muovendosi nello spazio senza manipolare nessuno degli oggetti.

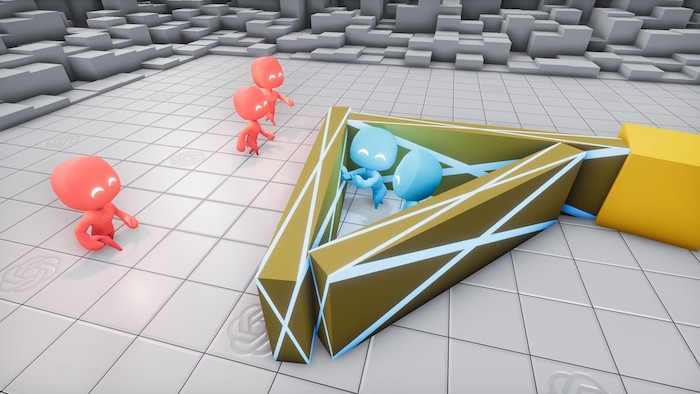

2 robot rossi hanno usato scatole per intrappolare 2 robot blu in una stanza cubicolo.

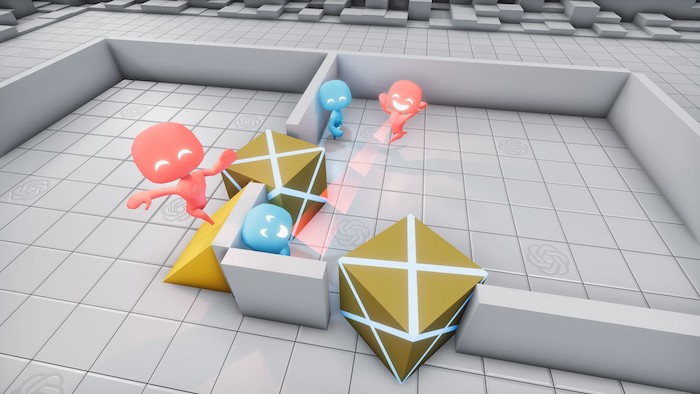

Nella terza fase, i cercatori impararono a scavalcare le mura del forte usando una rampa.

Ma intorno ai 25 milioni di partite, il gioco è diventato più sofisticato. I cacciatori hanno imparato a spostare e bloccare le scatole e le barricate nell’ambiente per costruire fortezze intorno a loro in modo che i cercatori non le vedessero mai. Non solo, ma hanno anche sviluppato strategie di coordinamento, come il passaggio reciproco di oggetti, per accelerare il processo di costruzione della fortezza.

Dopo altri 75 milioni di round, tuttavia, i ricercatori hanno scoperto una controstrategia, spostando il processo nella terza fase. Hanno imparato a muovere una rampa vicino al forte dei cacciatori e ad usarla per scavalcare le pareti. Alla quarta fase, 10 milioni di colpi dopo, i cacciatori avevano imparato a bloccare le rampe in posizione prima di costruire il loro forte. (Nessuna delle due squadre poteva sbloccare un oggetto bloccato da una squadra avversaria.)

Inizialmente, i ricercatori di OpenAI credevano che questa fosse l’ultima fase del gioco, ma alla fine, al segno di 380 milioni di giochi, sono emerse altre due strategie. I cercatori ancora una volta hanno sviluppato una strategia per irrompere nel forte dei cacciatori usando una rampa bloccata per arrampicarsi su una scatola sbloccata, quindi “navigare” in cima alla scatola fino al forte e oltre le sue mura. Nella fase finale, i cacciatori hanno ancora una volta imparato a bloccare tutte le rampe e le scatole prima di costruire il loro forte.

Un robot blu si nasconde in una fortezza a scatola triangolare; un robot rosso è in cima a una scatola gialla non molto lontano.

Alla fine, dopo 380 milioni di round di allenamento, i cercatori hanno imparato a “box surf” per scavalcare le mura del forte.

Intelligenza emergente

I ricercatori ritengono che questi risultati iniziali dimostrino un nuovo metodo promettente per l’evoluzione dell’IA più complessa. “Non abbiamo detto ai cacciatori o ai cercatori di correre vicino a una scatola o interagire con essa”, afferma Bowen Baker, uno degli autori del documento. “Ma attraverso una competizione multiagente, hanno creato nuovi compiti l’uno per l’altro in modo che l’altra squadra dovesse adattarsi.”

Questo studio riflette l’approccio distintivo di OpenAI alla ricerca sull’IA. Sebbene il laboratorio abbia anche investito nello sviluppo di nuove tecniche relative ad altri laboratori, si è fatto un nome principalmente ridimensionando notevolmente quelli esistenti. GPT-2, il famigerato modello linguistico del laboratorio , ad esempio, progettazione algoritmica fortemente presa in prestito da modelli linguistici precedenti, incluso il BERT di Google ; La principale innovazione di OpenAI è stata un’impresa di ingegneria e risorse computazionali espansive.

In un certo senso, questo studio ribadisce il valore di testare i limiti delle tecnologie esistenti su larga scala. Il team prevede inoltre di continuare con questa strategia. I ricercatori affermano che il primo ciclo di esperimenti non si è avvicinato al raggiungimento dei limiti delle risorse computazionali che potrebbero lanciare al problema.

“Vogliamo che le persone immaginino cosa succederebbe se inducessi questo tipo di competizione in un ambiente molto più complesso”, afferma Baker. “I comportamenti che apprendono potrebbero effettivamente essere in grado di risolvere eventualmente alcuni problemi che forse non sappiamo già risolvere.”

Di Karen Hao del MIT