Gli algoritmi di rilevamento di Deepfake non saranno mai sufficienti

Spotting fakes è solo l’inizio di una battaglia molto più grande

Potresti aver visto notizie la scorsa settimana su ricercatori che sviluppano strumenti in grado di rilevare deepfakes con una precisione superiore al 90%. È confortante pensare che con una ricerca come questa, il danno causato dai falsi generati dall’IA sarà limitato. Esegui semplicemente i tuoi contenuti attraverso un rilevatore Deepfake e batti, la disinformazione è sparita!

Ma i software in grado di individuare i video manipolati da IA forniranno sempre una soluzione parziale a questo problema, dicono gli esperti. Come con i virus dei computer o le armi biologiche, la minaccia dei deepfakes è ora una caratteristica permanente del paesaggio. E anche se è discutibile se i deepfakes siano o meno un pericolo enorme dal punto di vista politico , stanno sicuramente danneggiando la vita delle donne qui e ora attraverso la diffusione di finti nudi e pornografia.

Hao Li, un esperto in computer vision e professore associato presso la University of Southern California, dice a The Verge che qualsiasi rilevatore di deepfake funzionerà solo per un breve periodo. Infatti, dice, “ad un certo punto è probabile che non sarà possibile rilevare [falsi AI]. Quindi sarà necessario un diverso tipo di approccio per risolvere questo problema. “

INDIVIDUARE I DEEPFAKES È COME INDIVIDUARE I VIRUS: UNA SFIDA IN CONTINUA EVOLUZIONE

Li dovrebbe sapere – fa parte del team che ha aiutato a progettare uno di quei recenti rilevatori di deepfake . Lui ei suoi colleghi hanno costruito un algoritmo in grado di individuare le modifiche AI di video di famosi politici come Donald Trump ed Elizabeth Warren, seguendo piccoli movimenti facciali unici per ogni individuo.

Questi marcatori sono conosciuti come “dati biometrici soft” e sono troppo sottili per l’AI al momento imitare. Questi includono come Trump stringe le labbra prima di rispondere a una domanda, o come Warren alza le sopracciglia per enfatizzare un punto. L’algoritmo impara a individuare questi movimenti studiando le riprese del passato di individui, e il risultato è uno strumento accurato almeno al 92% per individuare diversi tipi di deepfake.

Li, però, dice che non ci vorrà molto prima che il lavoro sia inutile. Come lui e i suoi colleghi hanno delineato nel loro articolo, la tecnologia deepfake si sta sviluppando con una dinamica antivirus / anti-virus.

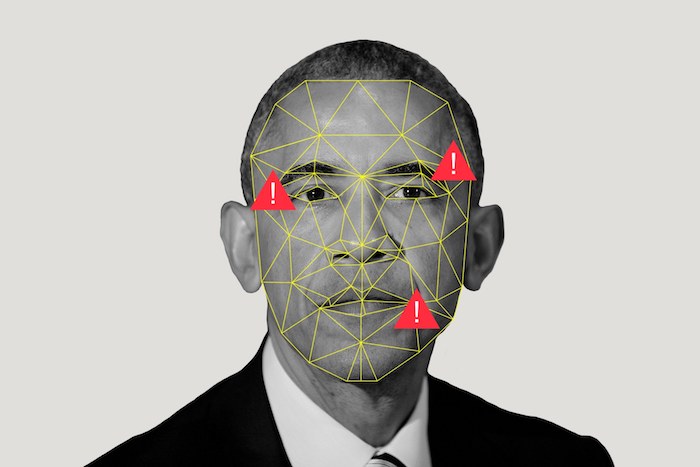

Un algoritmo di rilevamento deepfake funziona rilevando movimenti sottili nella faccia del bersaglio.

Fai battere le palpebre. Nel giugno del 2018, i ricercatori hanno scoperto che, poiché i sistemi di Deepfake non venivano addestrati su filmati di persone con gli occhi chiusi, i video che producevano presentavano schemi di lampeggiamento innaturali. I cloni di AI non lampeggiavano abbastanza frequentemente o, a volte, non lampeggiavano affatto – caratteristiche che potevano essere facilmente individuate con un semplice algoritmo.

Ma quello che è successo dopo era piuttosto prevedibile. “Poco tempo dopo che questa tecnica forense è stata resa pubblica, la prossima generazione di tecniche di sintesi incorporate lampeggiava nei loro sistemi”, ha scritto Li e i suoi colleghi. In altre parole: ciao ciao, rivelatore di Deepfake.

Ironia della sorte, questo avanti e indietro imita la tecnologia al centro di deepfakes: la rete generativa del contraddittorio, o GAN. Questo è un tipo di sistema di apprendimento automatico composto da due reti neurali che operano in concerto. Una rete genera il falso e l’altro cerca di rilevarlo, con il contenuto che rimbalza avanti e indietro e migliora con ogni raffica. Questa dinamica viene replicata nel più ampio panorama della ricerca, in cui ogni nuovo documento di rilevamento deepfake fornisce ai produttori di deepfake una nuova sfida da superare.

Delip Rao, VP della ricerca presso la Fondazione AI, concorda sul fatto che la sfida è di gran lunga superiore alla semplice rilevazione e afferma che questi documenti devono essere messi in prospettiva.

Un algoritmo di rilevamento deepfake svelato la scorsa settimana ha vantato un’accuratezza del 97%, ad esempio, ma come nota Rao, quel 3% potrebbe ancora essere dannoso quando si pensa alla scala delle piattaforme internet. “Supponiamo che Facebook disponga di questo algoritmo e ipotizzando che Facebook ottenga circa 350 milioni di immagini al giorno, ci sono molte immagini errate”, dice Rao. “Con ogni falso positivo del modello, stai compromettendo la fiducia degli utenti.”

LE PIATTAFORME DI SOCIAL MEDIA COME FACEBOOK NON HANNO UNA CHIARA POLITICA DI DEEPFAKE

È incredibilmente importante sviluppare tecnologie in grado di individuare i falsi, afferma Rao, ma la sfida più grande è rendere questi metodi utili. Le piattaforme sociali non hanno ancora definito con chiarezza le loro politiche sui deepfakes, come ha recentemente mostrato il fasullo di Facebook con un falso video di Mark Zuckerberg , e un divieto assoluto sarebbe poco saggio.

“Come minimo, i video dovrebbero essere etichettati se qualcosa viene rilevato come manipolato, basato su sistemi automatici”, afferma Li. Dice che è solo una questione di tempo, però, prima che i falsi non siano rilevabili. “I video sono solo pixel, in definitiva.”

Rao ei suoi colleghi della Fondazione AI stanno lavorando su approcci che incorporano il giudizio umano, ma altri sostengono che la verifica di video e immagini reali dovrebbe essere il punto di partenza, piuttosto che individuare falsi. A tal fine, hanno sviluppato programmi che possono automaticamente filigranare e identificare le immagini scattate con le fotocamere, mentre altri hanno suggerito di utilizzare la tecnologia blockchain per verificare il contenuto da fonti attendibili .

Nessuna di queste tecniche “risolverà” il problema, però; non mentre Internet esiste nella sua forma attuale. Come abbiamo visto con notizie false, solo perché un contenuto può essere facilmente sfatato non significa che non sarà cliccato, letto e condiviso online.

Più di ogni altra cosa, le dinamiche che definiscono il web – la condivisione senza attriti e la monetizzazione dell’attenzione – significano che i deepfakes troveranno sempre un pubblico.

Prendi la recente notizia di uno sviluppatore che crea un’app che consente a chiunque di fare finti nudi di fotografie di donne vestite. Le immagini risultanti sono ovviamente fabbricazioni. Quando li guardi da vicino la pelle e la carne sono sfocate e indistinte. Ma sono abbastanza convincenti a colpo d’occhio, ea volte è tutto ciò che serve.