Da quando Android è nato per la prima volta nel 2008, è diventata la più grande piattaforma mobile al mondo in termini di popolarità e numero di utenti. Nel corso degli anni, gli sviluppatori Android hanno realizzato progressi nell’apprendimento automatico, funzionalità come il riconoscimento vocale sul dispositivo, l’interattività video in tempo reale e miglioramenti in tempo reale quando si scatta una foto / selfie.

Inoltre, il riconoscimento delle immagini con l’apprendimento automatico può consentire agli utenti di puntare la fotocamera dello smartphone verso il testo e di tradurlo dal vivo in 88 lingue diverse con l’aiuto di Google Translate. Gli utenti Android possono persino puntare la fotocamera verso un bellissimo fiore, utilizzare Google Lens per identificare il tipo di fiore che è, quindi impostare un promemoria per ordinare un bouquet per qualcuno. Google Lens è in grado di utilizzare modelli di visione artificiale per espandere e accelerare la ricerca sul Web e l’esperienza mobile.

Google ha lavorato a lungo per rendere i dispositivi Android adatti anche a piccoli modelli ML. I progetti Mobile ML comportano sfide uniche nel convertire e implementare i modelli nei dispositivi giusti al momento giusto. Questi si concentrano solitamente sull’uso di modelli pre-addestrati o sulla riqualificazione di quelli esistenti. Ma l’azienda ha assicurato che esiste anche spazio per i modelli personalizzati.

TensorFlow Lite

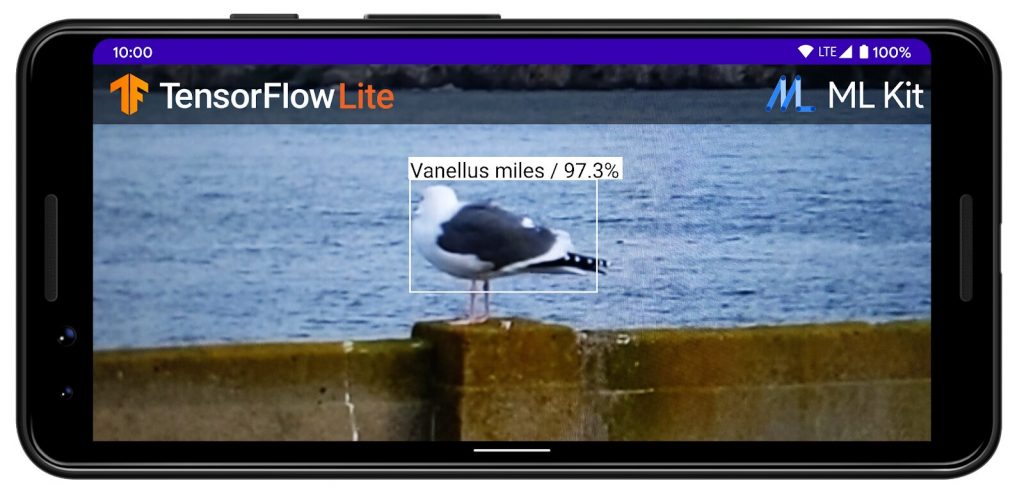

TensorFlow Lite è un popolare framework di deep learning open source, che può essere utilizzato sull’inferenza mobile su dispositivo. In seguito all’annuncio da parte di Apple di Core ML, Google ha rilasciato TensorFlow Lite , la prossima evoluzione di TensorFlow Mobile, che ha promesso prestazioni migliori essendo in grado di sfruttare l’accelerazione hardware sui dispositivi che la supportano.

Questo framework di Google può eseguire modelli di machine learning su dispositivi Android e iOS. Oggi, TensorFlow Lite viene utilizzato su miliardi di dispositivi in tutto il mondo e il suo set di strumenti viene utilizzato per tutti i tipi di app legate alla rete neurale, dal rilevamento di immagini al riconoscimento vocale.

TensorFlow Lite consente di eseguire gran parte dell’elaborazione ML sul dispositivo, utilizzando modelli meno intensivi, che non devono fare affidamento su un server o data center. Tali modelli funzionano più velocemente, offrono un potenziale miglioramento della privacy, consumano meno energia e, in alcuni casi, non hanno bisogno di una connessione Internet. Su Android come le ultime versioni del dispositivo, TensorFlow Lite sfrutta acceleratori mobili specializzati attraverso l’API della rete neurale, fornendo prestazioni migliori riducendo al minimo il consumo energetico previsto durante l’allenamento dei set di dati.

Kit ML

ML Kit è la soluzione di Google per l’integrazione dell’apprendimento automatico personalizzato nelle applicazioni mobili ed è stato lanciato nel 2018 durante la sua conferenza I / O. ML Kit offre l’ innovazione di apprendimento automatico su dispositivo di Google agli sviluppatori di app mobili, per aiutarli a creare esperienze personalizzate nelle loro applicazioni, che include strumenti come la traduzione linguistica, il riconoscimento del testo, il rilevamento di oggetti, ecc. ML Kit aiuta a identificare, analizzare, comprendere visivi e dati di testo in tempo reale e in modo focalizzato sulla privacy dell’utente, poiché i dati rimangono sul dispositivo. Secondo il direttore della gestione dei prodotti di Google, “Rende l’apprendimento automatico molto più accessibile”.

Gli sviluppatori possono utilizzare le API Vision in ML Kit per le API di analisi video e immagini per etichettare immagini e rilevare codici a barre, testo, volti e oggetti. Può essere utilizzato per lo sviluppo di varie applicazioni avanzate e l’integrazione ML come scansione di codici a barre, rilevamento di volti, etichettatura di immagini, rilevamento di oggetti e tracciamento. Inoltre, esistono API per l’elaborazione del linguaggio naturale per identificare e tradurre tra 58 lingue e fornire suggerimenti di risposta. Di conseguenza, oggi oltre 25.000 applicazioni su Android e iOS utilizzano le funzionalità di ML Kit.

La versione originale di ML Kit è stata strettamente integrata con Firebase e per una maggiore flessibilità, durante l’implementazione in app, Google ha recentemente annunciato che stava rendendo disponibili tutte le API sul dispositivo in un nuovo SDK ML Kit autonomo che non richiede più un progetto Firebase . Ciò offre agli sviluppatori l’accesso ai vantaggi esclusivi offerti dal dispositivo rispetto a quelli offerti dal cloud ML.

Secondo Google, se ML Kit non soddisfa completamente le esigenze degli sviluppatori, gli sviluppatori possono cercare modelli alternativi e come addestrare e utilizzare modelli ML personalizzati nella tua app Android. “Se le soluzioni ML chiavi in mano non soddisfano le tue esigenze, TensorFlow Hub dovrebbe essere il tuo primo punto di riferimento. È un repository di modelli ML di Google e della più ampia comunità di ricerca. I modelli sul sito sono pronti per l’uso nel cloud, in un browser Web o in un’app sul dispositivo “, secondo Google

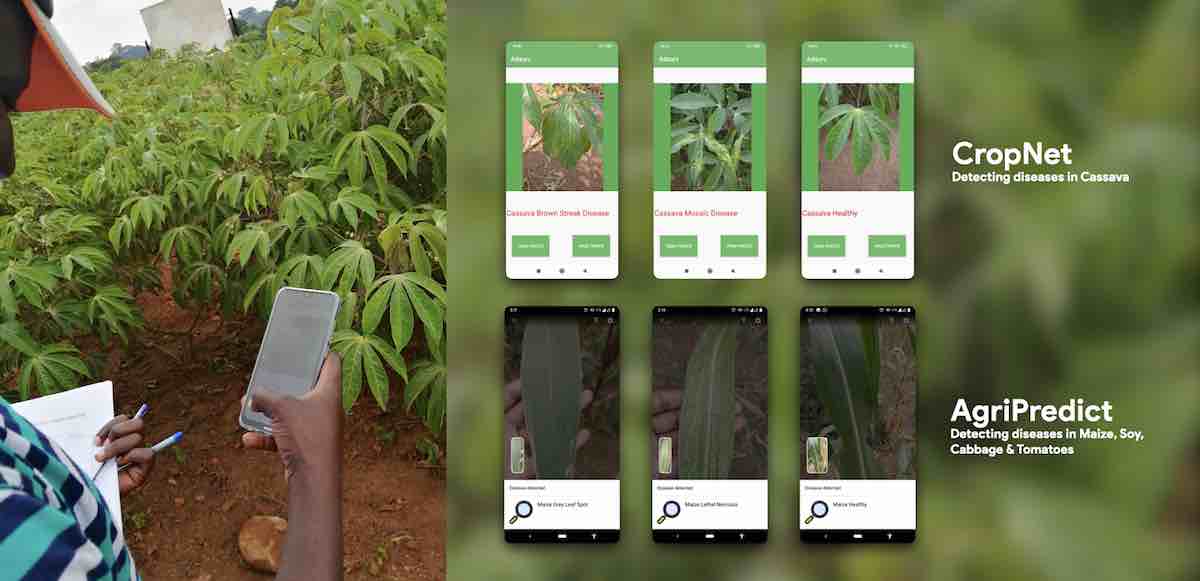

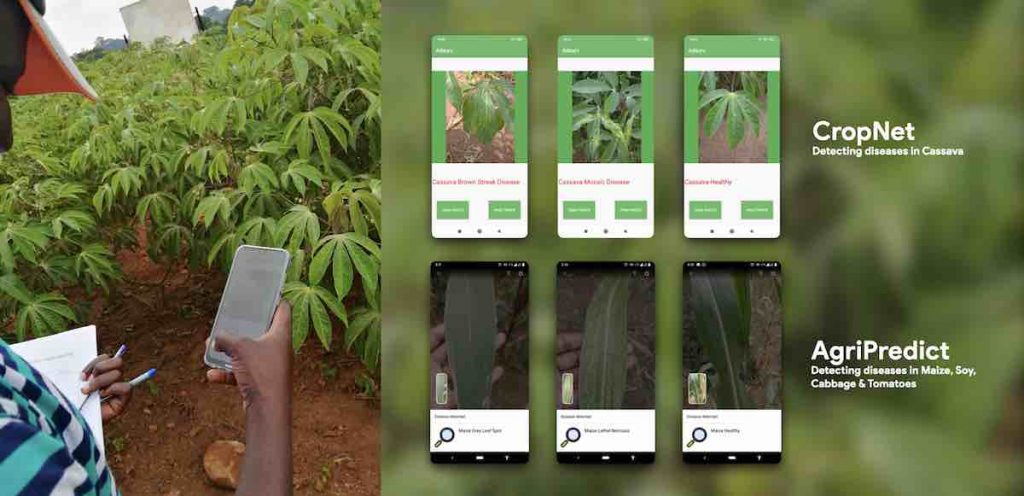

Oltre ai modelli di visione chiave come MobileNet ed EfficientNet, il repository vanta anche modelli basati sulle ultime ricerche come la classificazione dei vini per 400.000 vini popolari, la classificazione dei prodotti dei supermercati statunitensi per 100.000 prodotti, il riconoscimento dei punti di riferimento su base per continente, il modello CropNet di Brain Accra per il riconoscimento della malattia delle foglie di manioca, riconoscimento delle malattie delle piante da parte di AgriPredict che rileva malattie nelle piante di mais e pomodoro.

Inoltre, con l’ampio archivio di modelli di base, gli sviluppatori possono anche addestrare i propri modelli. Strumenti disponibili per gli sviluppatori sono disponibili per molti casi d’uso comuni. Oltre all’AutoML Vision Edge di Firebase, il team TensorFlow ha lanciato TensorFlow Lite Model Maker all’inizio di quest’anno per offrire agli sviluppatori una scelta più ampia rispetto al modello base che supporta più casi d’uso. TensorFlow Lite Model Maker attualmente supporta due attività ML comuni, ovvero la classificazione di testo e immagini.

TensorFlow Lite Model Maker può essere eseguito sul tuo computer di sviluppo o sui notebook di apprendimento automatico online di Google Colab. In futuro, il team di Android prevede di migliorare le offerte esistenti e di aggiungere nuovi casi d’uso.

Una volta che gli sviluppatori hanno selezionato un modello o addestrato il loro modello, ci sono nuovi strumenti facili da usare per aiutarli a integrarli nella loro app Android senza dover convertire tutto in ByteArrays, con il collegamento del modello ML con Android Studio 4.1. Ciò consente agli sviluppatori di importare qualsiasi modello TFLite, leggere la firma di input / output del modello e utilizzarlo con poche righe di codice che chiama la libreria di supporto Android TensorFlow Lite open source.