Imagen vs DALL.E 2: chi vince?

Imagen è stato testato meglio degli altri modelli con un ampio margine sia per la fedeltà dell’immagine che per l’allineamento del testo dell’immagine.

La generazione da testo a immagine sta avendo il suo momento nell’IA. Solo un mese fa, OpenAI ha annunciato DALL.E 2, un successore del proprio DALL.E, che potrebbe generare immagini altamente realistiche attorno a pochi prompt. DALL.E 2 è stata una svolta tra i generatori di testo in immagini. Potrebbe disegnare immagini che suonavano non plausibili in una gamma di stili diversi, come una fotografia o un dipinto. Lo strumento estendeva i limiti dell’immaginazione umana e poteva produrre una scena in pochi secondi. Ma sembra che DALL.E 2 dovrà passare il testimone a Imagen di GoogleAI , che è stato rilasciato all’inizio di questa settimana.

Il Brain Team di Google Research ha pubblicato un documento intitolato “Modelli fotorealistici di diffusione da testo a immagine con profonda comprensione del linguaggio” insieme all’annuncio. Il team ha testato il modello e lo ha confrontato con un gruppo di altri concorrenti text-to-image come DALL.E 2, CLIP e VQ-GAN+CLIP. Dimostrando un fotorealismo superiore, Imagen ha surclassato i suoi rivali di un miglio. Imagen ha utilizzato un codificatore T5-XXL congelato per mappare il testo di input in incorporamenti e un modello di diffusione dell’immagine , che quindi sfocia in due modelli di diffusione a super risoluzione, che quindi generano le immagini.

Confronto con GLIDE e DALL.E 2

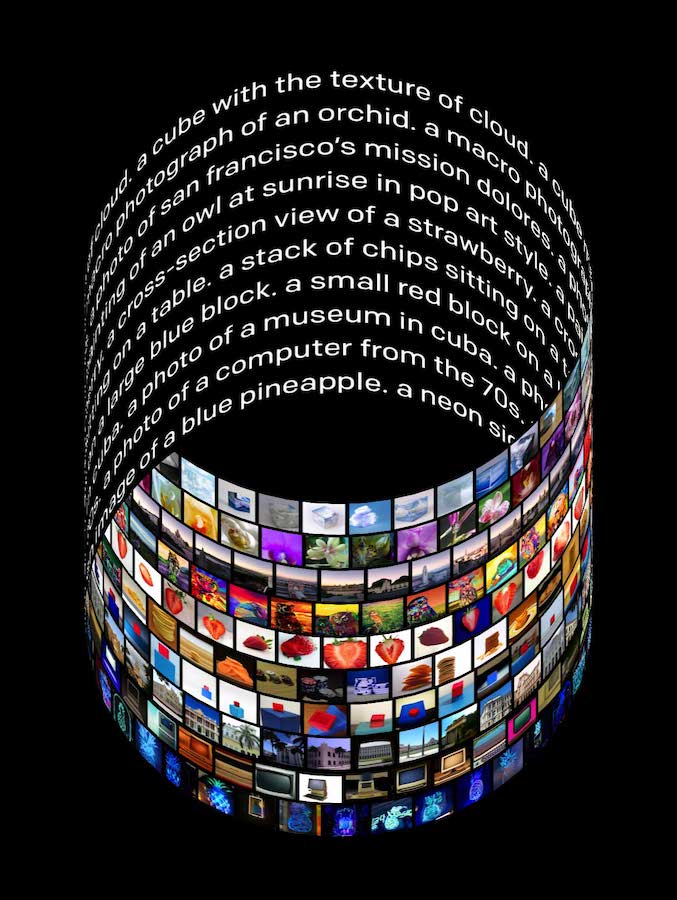

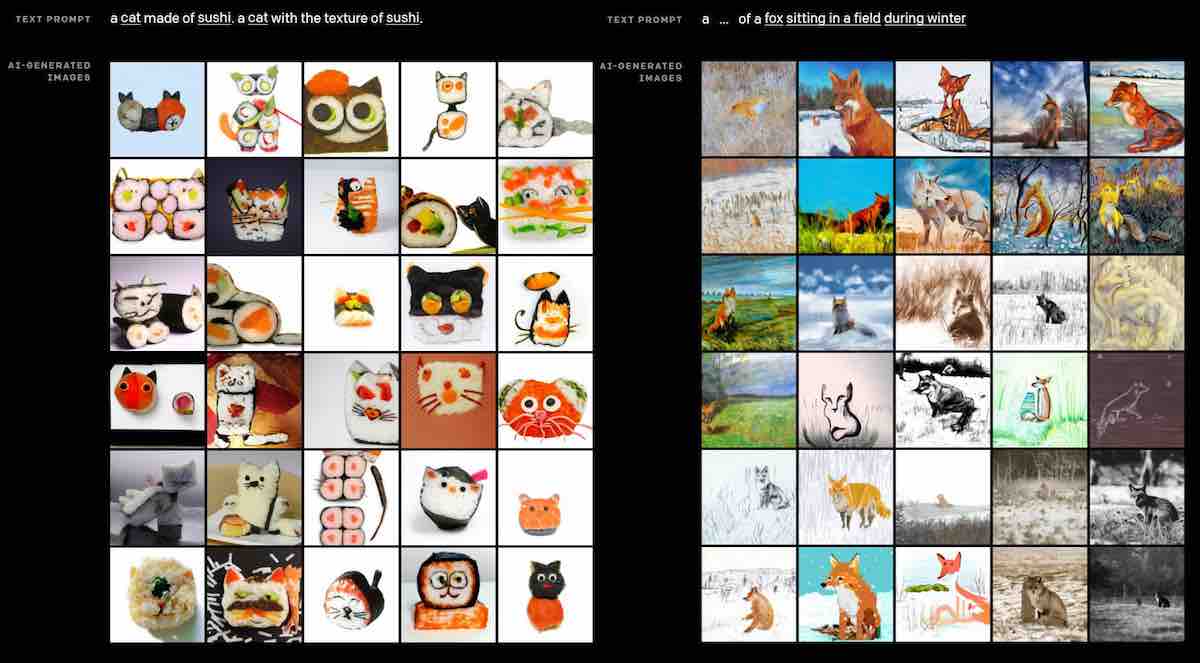

Lo studio ha introdotto una nuova serie di categorie per i prompt di testo denominata DrawBench per valutare la qualità dei modelli da testo a immagine. Il nuovo benchmark è completo e giudica i molti aspetti dei modelli, come la composizionalità, la cardinalità e le relazioni spaziali, sulla base di 11 parametri. Questi parametri sono suddivisi in diversi colori, il numero di oggetti nella scena, qualsiasi testo nella scena e l’interazione tra gli oggetti.

DrawBench utilizza inoltre costantemente prompt più complicati e creativi o con parole usate raramente in modo che il modello conosca bene questi comandi. Ciò spinge anche la capacità del modello di generare immagini più fantasiose e stravaganti.

Imagen ha superato DALL.E 2, GLIDE , VQ-GAN, che funziona utilizzando CLIP, e Latent Diffusion, su punteggi dati da valutatori umani. Imagen è stato testato meglio degli altri modelli con un ampio margine sia per la fedeltà dell’immagine che per l’allineamento del testo dell’immagine.

I modelli sono stati testati anche sulla base del benchmark standard per giudicare i modelli text-to-image, il set di valutazione COCO. La metrica principale per misurare le prestazioni dei modelli era la FID, o Frechet Inception Distance, che viene utilizzata per calcolare la fedeltà dell’immagine, l’allineamento dell’immagine-testo e il punteggio CLIP. Per entrambi i benchmark DrawBench e COCO, la valutazione è stata effettuata da valutatori umani perché FID non può giudicare completamente la qualità percettiva e CLIP è limitato nel conteggio.

Ai tester umani è stata quindi fornita un’immagine di riferimento e un’immagine generata dal modello e gli è stato chiesto di scegliere l’immagine più fotorealistica tra le due. La percentuale è stata calcolata sul numero di volte in cui le persone hanno preferito l’immagine generata dal modello rispetto all’immagine di riferimento. Per l’allineamento testo-immagine, alle persone è stato chiesto di valutare sia l’immagine di riferimento che l’immagine generata dal modello in base alla corrispondenza con la didascalia.

Sebbene Imagen non sia stato addestrato su COCO, ha ottenuto un punteggio FID zero-shot all’avanguardia a 7,27, che era superiore a DALL.E 2 e altri modelli che sono stati addestrati su COCO. In FID zero-shot, Imagen ha ottenuto un punteggio di -30.000, per i quali 30.000 prompt sono stati estratti casualmente dal set di riferimento. I campioni generati dal modello per questi prompt sono stati confrontati con le immagini di riferimento del set completo. Ha anche ottenuto un tasso di preferenza del 39,2% rispetto ad altri modelli nel fotorealismo. Nelle scene senza persone, tuttavia, il tasso di preferenza di Imagen è salito al 43,6%, il che ha dimostrato che la capacità del modello è limitata quando si tratta di generare immagini fotorealistiche delle persone. Il test COCO non offre una visione approfondita delle differenze tra i modelli, motivo per cui è stato sviluppato DrawBench.

In che modo Imagen ha battuto DALL.E 2?

Ci sono un certo numero di cose che Imagen ha fatto in modo diverso per superare altri modelli text-to-image, come il notevole DALL.E 2 . Imagen è stato addestrato utilizzando il più grande codificatore di testo di Google AI , T5-XXL, che ha 4,6 miliardi di parametri. La ricerca mostra essenzialmente che il ridimensionamento della dimensione del codificatore di testo migliora in larga misura l’allineamento testo-immagine e la fedeltà dell’immagine. In effetti, dimostra che ridimensionare la dimensione del codificatore di testo preaddestrato è molto più utile che ridimensionare la dimensione del modello di diffusione. Mentre il ridimensionamento delle dimensioni del modello di diffusione U-Net si traduce in una migliore qualità del campione, un codificatore di testo più grande ha un impatto complessivo maggiore.

Lo studio ha anche introdotto il concetto di soglia dinamica, una nuova tecnica di campionamento per diffusione, che viene eseguita in ogni fase di campionamento per evitare la saturazione dei pixel. Il metodo ha reso le immagini più fotorealistiche, specialmente nel caso di grandi pesi guida privi di classificatore nei campioni.

Imagen ha utilizzato anche un’altra tecnica di diffusione chiamata aumento del condizionamento del rumore che aiuta i modelli a diventare consapevoli della quantità di rumore che è stata aggiunta e di conseguenza li rende più robusti. La tecnica ha portato a una migliore fedeltà dell’immagine e ha contribuito ai punteggi FID e CLIP più elevati di Imagen.

Imagen ha utilizzato l’architettura U-Net per il modello di diffusione di base 64*64 e l’ha modificata in qualche modo per renderlo più efficiente. L’architettura U-Net utilizza meno memoria, converge più velocemente e offre una migliore qualità del campione con tempi di inferenza più rapidi.

Tuttavia, proprio come DALL.E 2, anche Imagen non è stato rilasciato al pubblico e con buone ragioni. Lo studio ha rilevato che i rischi associati ai pregiudizi nei modelli linguistici di grandi dimensioni permangono e la formazione di generatori di testo in immagini su questi set di dati ha riprodotto i pericolosi stereotipi. Thomas Wolf , co-fondatore e Chief Strategy Officer di Hugging Face , ha commentato al riguardo, affermando come ciò abbia ostacolato la ricerca nell’area del text-to-image. Wolf ha suggerito che fosse possibile e persino preferibile che i set di dati potessero essere resi pubblici in modo che potessero essere migliorati con uno sforzo collettivo.