La pandemia ha accelerato l’adozione dell’edge computing, ovvero il calcolo e l’archiviazione dei dati che si trova vicino a dove è necessario. Secondo il rapporto State of the Edge della Linux Foundation, è particolarmente probabile che le aziende sanitarie, manifatturiere e al dettaglio digitali espandano il loro uso dell’edge computing entro il 2028. Ciò è in gran parte dovuto alla capacità della tecnologia di migliorare i tempi di risposta e risparmiare banda consentendo analisi dei dati meno vincolata.

Sebbene solo il 10% circa dei dati generati dall’azienda sia attualmente creato ed elaborato al di fuori di un data center o cloud tradizionale, si prevede che aumenterà fino al 75% entro il 2022, afferma Gartner . Si prevede che i soli dispositivi Internet of Things (IoT) creeranno oltre 175 zettabyte di dati nel 2025. E secondo Grand View Research, si prevede che il mercato globale dei computer varrà 61,14 miliardi di dollari entro il 2028.

L’edge computing rappresenta un potente cambiamento di paradigma, ma ha il potenziale per diventare ancora più utile se combinato con l’IA. “Edge AI” descrive le architetture in cui i modelli AI vengono elaborati localmente, su dispositivi ai margini della rete. Poiché le configurazioni di edge AI in genere richiedono solo un microprocessore e sensori, non una connessione Internet, possono elaborare i dati e fare previsioni in tempo reale (o quasi).

Il valore aziendale dell’IA edge potrebbe essere sostanziale. Secondo Markets and Markets, si prevede che il mercato globale del software edge AI crescerà da 590 milioni di dollari nel 2020 a 1,83 miliardi di dollari entro il 2026. Deloitte stima che ad oggi siano stati venduti più di 750 milioni di chip AI edge che eseguono attività sul dispositivo, pari a 2,6 dollari. miliardi di entrate.

Cos’è l’IA edge?

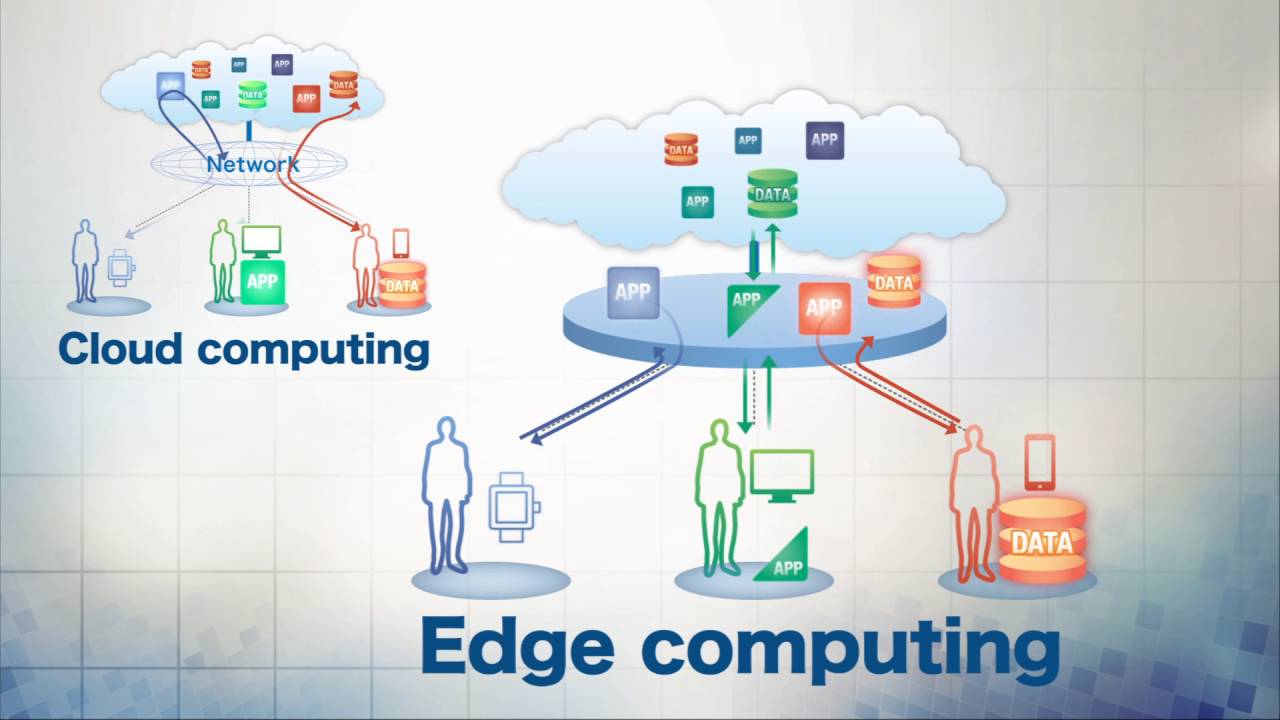

La maggior parte dei processi di intelligenza artificiale viene eseguita utilizzando data center basati su cloud che richiedono una notevole capacità di calcolo. Queste spese possono sommarsi rapidamente. Secondo Amazon, il costo dell’inferenza, ovvero quando un modello fa previsioni, costituisce fino al 90% dei costi dell’infrastruttura di apprendimento automatico. E un recente studio condotto da RightScale ha rilevato che il risparmio sui costi era alla base delle iniziative cloud in oltre il 60% delle organizzazioni intervistate.

Edge AI, al contrario, richiede poca o nessuna infrastruttura cloud oltre la fase di sviluppo iniziale. Un modello può essere addestrato nel cloud ma distribuito su un dispositivo perimetrale, dove viene eseguito senza (o principalmente senza) infrastruttura server.

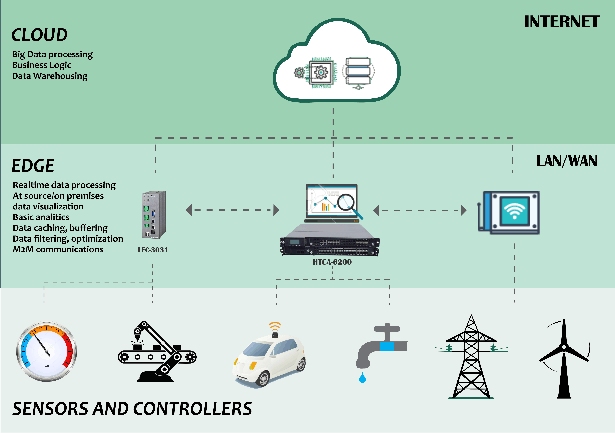

Come osserva Machine Learning Quant , l’hardware AI edge generalmente rientra in una delle tre categorie: (1) server AI on-premise, (2) gateway intelligenti e (3) dispositivi edge. I server di intelligenza artificiale sono macchine con componenti specializzati progettati per supportare una gamma di applicazioni di addestramento e inferenza di modelli. I gateway si trovano tra dispositivi perimetrali, server e altri elementi della rete. E i dispositivi perimetrali eseguono l’inferenza dell’intelligenza artificiale e le funzioni di addestramento, sebbene l’addestramento possa essere delegato al cloud con solo l’inferenza eseguita sul dispositivo.

Le motivazioni per l’implementazione di hardware AI all’edge sono una miriade, ma spesso si concentrano sulla trasmissione dei dati, sull’archiviazione e su considerazioni sulla privacy. Ad esempio, in un’impresa industriale o manifatturiera con migliaia di sensori, di solito non è pratico inviare grandi quantità di dati dei sensori al cloud, eseguire l’analisi e restituire i risultati al luogo di produzione. L’invio di tali dati richiederebbe enormi quantità di larghezza di banda, oltre a spazio di archiviazione cloud, e potrebbe potenzialmente esporre informazioni sensibili.

Edge AI apre anche le porte all’utilizzo di dispositivi connessi e applicazioni AI in ambienti in cui Internet affidabile potrebbe non essere scontato, come su un impianto di perforazione in acque profonde o su una nave da ricerca. La sua bassa latenza lo rende anche adatto per attività sensibili al tempo, come il rilevamento predittivo dei guasti e i sistemi di scaffali intelligenti per la vendita al dettaglio che utilizzano la visione artificiale.

Edge AI in pratica

In pratica, edge AI incorpora un sensore, ad esempio un accelerometro, giroscopio o magnetometro, collegato a una piccola unità microcontrollore (MCU), Johan Malm, Ph.D. e specialista in analisi numerica presso Imagimob, spiega in un whitepaper. L’MCU è caricato con un modello che è stato addestrato sugli scenari tipici che il dispositivo incontrerà. Questa è la parte di apprendimento, che può essere un processo continuo attraverso il quale il dispositivo apprende quando incontra cose nuove.

Ad esempio, alcune fabbriche utilizzano sensori montati su motori e altre apparecchiature configurate per trasmettere segnali, in base a temperatura, vibrazioni e corrente, a una piattaforma di intelligenza artificiale perimetrale. Invece di inviare i dati al cloud, l’intelligenza artificiale analizza i dati continuamente e localmente per fare previsioni su quando un particolare motore sta per guastarsi.

Un altro caso d’uso per edge AI e computer vision è l’ispezione ottica automatizzata sulle linee di produzione. In questo caso, i componenti assemblati vengono inviati attraverso una stazione di ispezione per l’analisi visiva automatizzata. Un modello di visione artificiale rileva le parti mancanti o disallineate e fornisce i risultati a un dashboard in tempo reale che mostra lo stato dell’ispezione. Poiché i dati possono tornare nel cloud per ulteriori analisi, il modello può essere regolarmente riaddestrato per ridurre i falsi positivi.

Stabilire un circolo virtuoso per la riqualificazione è un passaggio essenziale nell’implementazione dell’IA. Secondo un recente rapporto di Alation, una chiara maggioranza dei dipendenti (87%) considera i problemi di qualità dei dati il motivo per cui le loro organizzazioni non sono riuscite a implementare con successo l’IA e l’apprendimento automatico . E il 34% degli intervistati a un sondaggio Rackspace del 2021 ha citato la scarsa qualità dei dati come motivo del fallimento della ricerca e sviluppo dell’IA.

“Molti dei nostri clienti implementano letteralmente centinaia di migliaia di sensori… In questi scenari IoT, non è solo una questione di IoT: è IoT più elaborazione intelligente in modo che l’apprendimento automatico possa essere applicato per ottenere informazioni che migliorano la sicurezza e l’efficienza”, Amazon CTO Werner Vogels ha dichiarato a VentureBeat in una precedente intervista . “C’è molta elaborazione che avviene nel cloud perché la maggior parte [della formazione sui modelli di intelligenza artificiale] è molto laboriosa, ma l’elaborazione avviene spesso ai margini. Il calcolo massiccio e pesante [avrà un posto] nel cloud per l’addestramento dei modelli e cose del genere. Tuttavia, i loro carichi di lavoro non sono critici in tempo reale per la maggior parte del tempo. Per le nostre operazioni critiche in tempo reale, i modelli devono essere spostati su dispositivi perimetrali”.

Sfide

Edge AI offre vantaggi rispetto alle tecnologie AI basate su cloud, ma non è esente da sfide. Conservare i dati a livello locale significa più luoghi da proteggere, con un maggiore accesso fisico che consente diversi tipi di attacchi informatici. (Alcuni esperti sostengono che la natura decentralizzata dell’edge computing porta a una maggiore sicurezza.) La potenza di calcolo è limitata all’edge, il che limita il numero di attività di intelligenza artificiale che possono essere eseguite. E i modelli grandi e complessi di solito devono essere semplificati prima di essere implementati nell’hardware AI edge, in alcuni casi riducendo la loro precisione.

Fortunatamente, l’hardware emergente promette di alleviare alcune delle limitazioni di elaborazione ai margini. Le startup Sima.ai , AIStorm , Hailo , Esperanto Technologies , Quadric , Graphcore , Xnor e Flex Logix stanno sviluppando chip personalizzati per i carichi di lavoro AI — e sono tutt’altro che gli unici. Mobileye, la società di Tel Aviv acquisita da Intel per 15,3 miliardi di dollari nel marzo 2017, offre una soluzione di elaborazione di visione artificiale per AV nella sua linea di prodotti EyeQ. E Baidu lo scorso luglio ha presentato Kunlun, un chip per l’edge computing su dispositivi e nel cloud tramite datacenter.

Oltre ai chip, è disponibile un numero crescente di schede madri di sviluppo, tra cui Edge TPU di Google e Jetson Nano di Nvidia . Microsoft, Amazon, Intel e Asus offrono anche piattaforme hardware per l’implementazione di edge AI, come la videocamera wireless DeepLens di Amazon per il deep learning.

Questi sono tra gli sviluppi che incoraggiano le imprese ad andare avanti. Secondo un rapporto del 2019 di Gartner, oltre il 50% delle grandi organizzazioni implementerà almeno un caso d’uso di edge computing per supportare IoT o esperienze immersive entro la fine del 2021, rispetto a meno del 5% nel 2019. Il numero di edge computing i casi d’uso aumenteranno ulteriormente nei prossimi anni, con Gartner che prevede che oltre la metà delle grandi imprese avrà almeno sei casi d’uso di edge computing distribuiti entro la fine del 2023.

I vantaggi di Edge AI rendono la sua implementazione una saggia decisione aziendale per molte organizzazioni. Insight prevede un ROI medio del 5,7% dalle implementazioni edge intelligenti nei prossimi tre anni. In segmenti come quello automobilistico, sanitario, manifatturiero e persino della realtà aumentata, l’intelligenza artificiale all’estremità può ridurre i costi supportando al contempo una maggiore scalabilità, affidabilità e velocità.