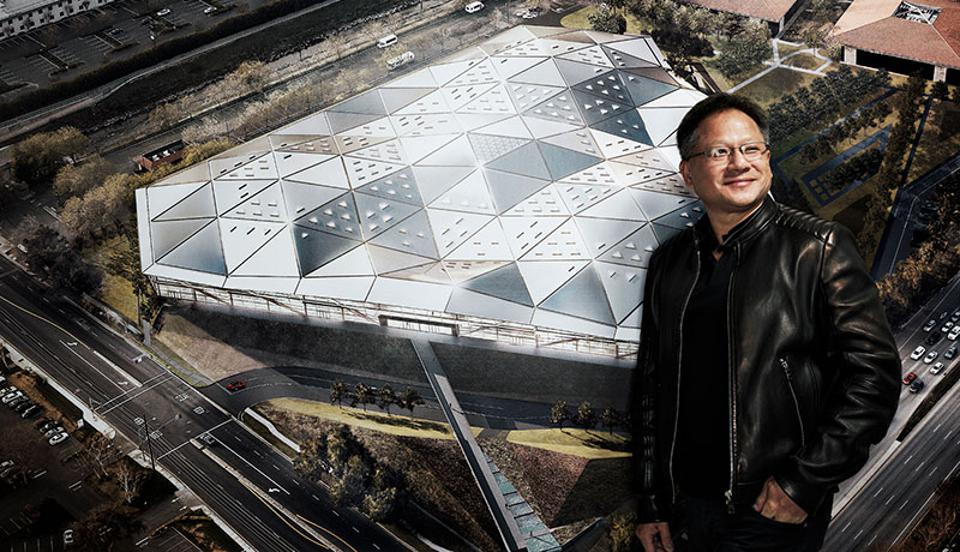

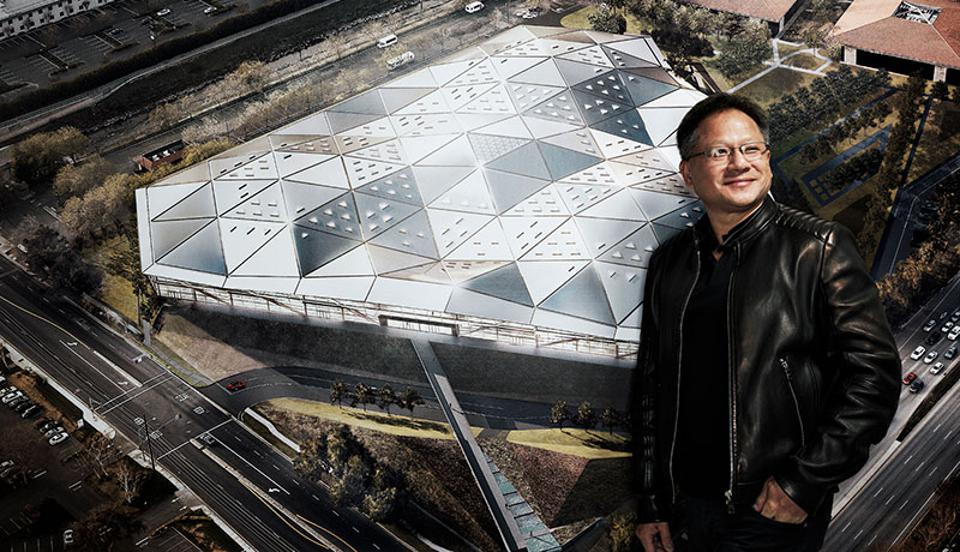

The DeanBeat: il CEO di Nvidia Jensen Huang afferma che l’IA popolerà automaticamente le immagini 3D del metaverso

Ci vogliono tipi di intelligenza artificiale per creare un mondo virtuale. Il CEO di Nvidia Jensen Huang ha dichiarato questa settimana durante una sessione di domande e risposte all’evento online GTC22 che l’IA popolerà automaticamente le immagini 3D del metaverso.

Crede che l’IA farà il primo passo nella creazione degli oggetti 3D che popolano i vasti mondi virtuali del metaverso, e poi i creatori umani prenderanno il controllo e li perfezioneranno a loro piacimento. E mentre questa è una grande affermazione su quanto sarà intelligente l’IA, Nvidia ha una ricerca per sostenerla.

Da Honeywell alle startup Come i leader stanno guidando una crescita prevedibile con l’IA

Nvidia Research ha annunciato questa mattina che un nuovo modello di intelligenza artificiale può aiutare a contribuire agli enormi mondi virtuali creati da un numero crescente di aziende e creatori che potrebbero essere popolati più facilmente con una vasta gamma di edifici 3D, veicoli, personaggi e altro ancora.

Questo tipo di immagini banali rappresenta un’enorme quantità di lavoro noioso. Nvidia ha affermato che il mondo reale è pieno di varietà: le strade sono fiancheggiate da edifici unici, con diversi veicoli che sfrecciano e folle diverse che passano. La modellazione manuale di un mondo virtuale 3D che lo rifletta richiede molto tempo, rendendo difficile la compilazione di un ambiente digitale dettagliato.

Questo tipo di attività è ciò che Nvidia vuole rendere più semplice con i suoi strumenti Omniverse e il servizio cloud. Spera di semplificare la vita degli sviluppatori quando si tratta di creare applicazioni metaverse. E l’auto-generazione dell’arte, come abbiamo visto accadere con modelli come DALL-E e altri modelli di intelligenza artificiale quest’anno, è un modo per alleviare il peso della costruzione di un universo di mondi virtuali come in Snow Crash o Ready Player One .

Ho chiesto a Huang in una sessione di domande e risposte alla stampa all’inizio di questa settimana che cosa potrebbe rendere il metaverso più veloce. Ha alluso al lavoro di Nvidia Research, anche se la società non ha rivelato i fagioli fino ad oggi.

“Innanzitutto, come sai, il metaverse è creato dagli utenti. E o è stato creato da noi a mano, o è stato creato da noi con l’aiuto dell’IA”, ha detto Huang. “Ed, e in futuro, è molto probabile che descriveremo qualche caratteristica di una casa o caratteristica di una città o qualcosa del genere. Ed è come questa città, o come Toronto, o come New York City, e crea una nuova città per noi. E forse non ci piace. Possiamo dargli ulteriori suggerimenti. Oppure possiamo semplicemente continuare a premere “invio” fino a quando non ne genera automaticamente uno da cui vorremmo iniziare. E poi da quello, da quel mondo, lo modificheremo. E quindi penso che l’IA per la creazione di mondi virtuali si stia realizzando mentre parliamo”.

Formato utilizzando solo immagini 2D, Nvidia GET3D genera forme 3D con trame ad alta fedeltà e dettagli geometrici complessi. Questi oggetti 3D sono creati nello stesso formato utilizzato dalle popolari applicazioni software di grafica, consentendo agli utenti di importare immediatamente le loro forme in renderer 3D e motori di gioco per ulteriori modifiche.

Gli oggetti generati potrebbero essere utilizzati in rappresentazioni 3D di edifici, spazi esterni o intere città, progettati per settori quali giochi, robotica, architettura e social media.

GET3D può generare un numero virtualmente illimitato di forme 3D in base ai dati su cui è stato addestrato. Come un artista che trasforma un pezzo di argilla in una scultura dettagliata, il modello trasforma i numeri in complesse forme 3D.

“Al centro di ciò c’è proprio la tecnologia di cui parlavo solo un secondo fa, chiamata modelli linguistici di grandi dimensioni”, ha affermato. “Poter imparare da tutte le creazioni dell’umanità ed essere in grado di immaginare un mondo 3D. E così dalle parole, attraverso un grande modello linguistico, usciranno un giorno triangoli, geometrie, trame e materiali. E poi da quello, lo modificheremmo. E poiché nessuno di essi è pre-cotto e nessuno di esso è pre-renderizzato, tutta questa simulazione della fisica e tutta la simulazione della luce deve essere eseguita in tempo reale. Ed è per questo che le ultime tecnologie che stiamo creando per quanto riguarda il neuro rendering RTX sono così importanti. Perché non possiamo farlo con la forza bruta. Abbiamo bisogno dell’aiuto dell’intelligenza artificiale per farlo”.

Con un set di dati di allenamento di immagini di auto 2D, ad esempio, crea una raccolta di berline, camion, auto da corsa e furgoni. Quando viene addestrato su immagini di animali, esce con creature come volpi, rinoceronti, cavalli e orsi. Date le sedie, il modello genera sedie girevoli assortite, sedie da pranzo e comode poltrone reclinabili.

“GET3D ci avvicina alla democratizzazione della creazione di contenuti 3D basata sull’intelligenza artificiale”, ha affermato Sanja Fidler, vicepresidente della ricerca sull’intelligenza artificiale presso Nvidia e leader del laboratorio di intelligenza artificiale con sede a Toronto che ha creato lo strumento. “La sua capacità di generare istantaneamente forme 3D strutturate potrebbe essere un punto di svolta per gli sviluppatori, aiutandoli a popolare rapidamente mondi virtuali con oggetti vari e interessanti”.

GET3D è uno degli oltre 20 articoli e workshop firmati da Nvidia accettati alla conferenza NeurIPS AI, che si terrà a New Orleans e virtualmente, dal 26 novembre al 26 dicembre. 4.

Nvidia ha affermato che, sebbene più veloci dei metodi manuali, i precedenti modelli di IA generativa 3D erano limitati nel livello di dettaglio che potevano produrre. Anche i recenti metodi di rendering inverso possono generare solo oggetti 3D basati su immagini 2D prese da varie angolazioni, richiedendo agli sviluppatori di costruire una forma 3D alla volta.

GET3D può invece sfornare circa 20 forme al secondo quando esegue l’inferenza su una singola unità di elaborazione grafica (GPU) di Nvidia, lavorando come una rete contraddittoria generativa per immagini 2D, generando oggetti 3D. Più ampio e diversificato è il set di dati di addestramento da cui viene appreso, più vario e dettagliato sarà l’output.

I ricercatori di Nvidia hanno addestrato GET3D su dati sintetici costituiti da immagini 2D di forme 3D catturate da diverse angolazioni della telecamera. Il team ha impiegato solo due giorni per addestrare il modello su circa un milione di immagini utilizzando GPU Nvidia A100 Tensor Core.

GET3D prende il nome dalla sua capacità di generare mesh 3D testurizzate esplicite, il che significa che le forme che crea hanno la forma di una mesh triangolare, come un modello di cartapesta, ricoperta da un materiale strutturato. Ciò consente agli utenti di importare facilmente gli oggetti in motori di gioco, modellatori 3D e renderizzatori di film e modificarli.

Una volta che i creatori esportano le forme generate da GET3D in un’applicazione grafica, possono applicare effetti di luce realistici mentre l’oggetto si muove o ruota in una scena. Incorporando un altro strumento di intelligenza artificiale di NVIDIA Research, StyleGAN-NADA, gli sviluppatori possono utilizzare i messaggi di testo per aggiungere uno stile specifico a un’immagine, come modificare un’auto renderizzata in modo che diventi un’auto bruciata o un taxi, o trasformare una normale casa in un infestato uno.

I ricercatori osservano che una versione futura di GET3D potrebbe utilizzare tecniche di stima della posa della telecamera per consentire agli sviluppatori di addestrare il modello su dati del mondo reale anziché su set di dati sintetici. Potrebbe anche essere migliorato per supportare la generazione universale, il che significa che gli sviluppatori potrebbero addestrare GET3D su tutti i tipi di forme 3D contemporaneamente, piuttosto che doverlo addestrare su una categoria di oggetti alla volta.

Quindi l’IA genererà mondi, ha detto Huang. Quei mondi saranno simulazioni, non solo animazioni. E per gestire tutto questo, Huang prevede la necessità di creare un “nuovo tipo di data center in tutto il mondo”. Si chiama Rete Display di Google, non CDN. È una rete di distribuzione grafica, testata in battaglia tramite il servizio di cloud gaming GeForce Now di Nvidia. Nvidia ha preso quel servizio e lo utilizza per creare Omniverse Cloud, una suite di strumenti che possono essere utilizzati per creare applicazioni Omniverse, sempre e ovunque. La Rete Display di Google ospiterà giochi cloud e gli strumenti metaverse di Omniverse Cloud.

Questo tipo di rete potrebbe fornire l’elaborazione in tempo reale necessaria per il metaverso.

“Questa è un’interattività essenzialmente istantanea”, ha detto Huang.

Qualche sviluppatore di giochi lo sta chiedendo? Beh, in effetti, ne conosco uno che lo è. Brendan Greene, creatore del gioco battle royale PlayerUnknown’s Productions, ha chiesto questo tipo di tecnologia quest’anno quando ha annunciato Prologue e poi ha rivelato Project Artemis , un tentativo di creare un mondo virtuale delle dimensioni della Terra. Ha detto che potrebbe essere costruito solo con una combinazione di design del gioco, contenuti generati dagli utenti e intelligenza artificiale.