La lettura delle labbra da parte delle auto a guida autonoma con intelligenza artificiale è allarmante o geniale

Lettura labiale abilitata all’intelligenza artificiale e l’avvento delle auto a guida autonoma.

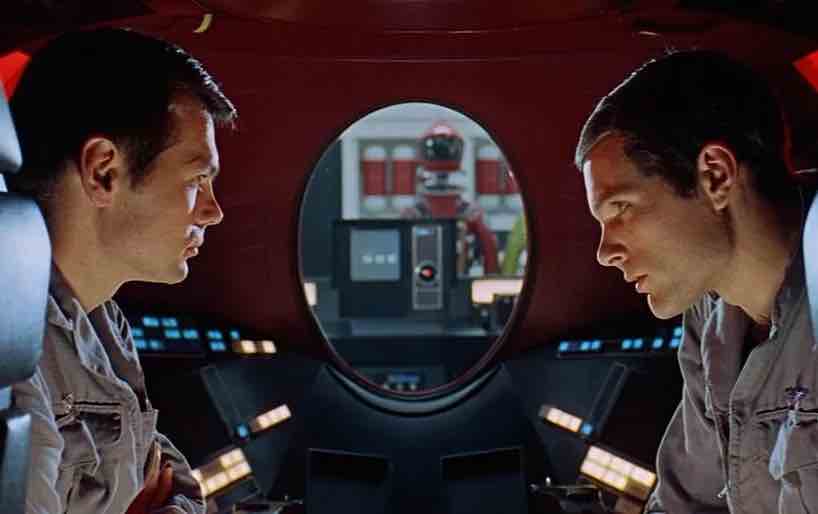

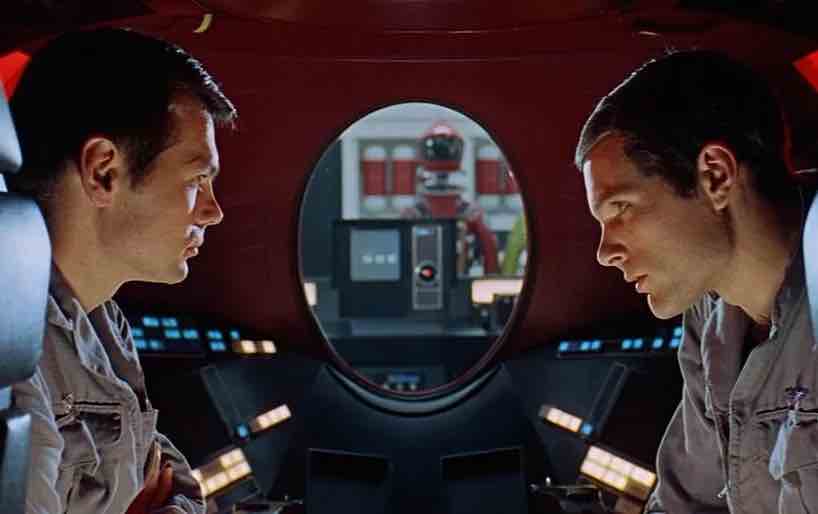

I film di spionaggio includevano un momento cruciale che coinvolgeva un agente segreto che leggeva di nascosto le labbra di qualcuno seduto a un tavolo mentre si trovava dietro una lastra di vetro come in un ristorante lontano o in un grattacielo. Dopo aver decifrato abilmente le parole di ciò che la persona stava dicendo, l’agente segreto avrebbe finalmente saputo la verità su una questione cruciale.

Tale è la gloria di poter leggere le labbra.

La capacità di leggere le labbra è considerata un’abilità decantata e che può essere difficile da padroneggiare. Questa capacità di eseguire la lettura vocale è piuttosto complicata in una miriade di modi.

Innanzitutto, devi essere in grado di vedere visivamente le labbra della persona che stai cercando di decifrare. Potrebbe sembrare un requisito ovvio, ma il punto è che a volte le labbra non sono particolarmente facili da vedere. La persona che sta parlando potrebbe avere le mani in alto verso la bocca, coprendo parzialmente le labbra alla vista. Lo vedi accadere intenzionalmente nelle partite di baseball quando il ricevitore esce sul monte per parlare con il lanciatore, ed entrambi si coprono la bocca con i guanti da baseball.

Oltre a cercare di vedere le labbra di chi parla, fa davvero una bella differenza se riesci a vedere anche la sua intera bocca, i suoi denti, la sua mascella, la sua testa, il suo collo e così via. Si scopre che i meccanismi di consegna del parlare sono suscettibili di coinvolgere tutti quegli elementi anatomici. Le labbra da sole sono in qualche modo limitanti in termini di discernimento di ciò che qualcuno sta dicendo.

Un altro fattore fondamentale riguarda la lingua utilizzata dall’oratore. Se non hai familiarità con la lingua che qualcuno sta usando, le probabilità di avere un senso dal movimento delle loro labbra non sono particolarmente alte. In genere è necessario sapere quale lingua stanno usando ed essere fluenti in quella lingua, per aumentare le probabilità di eseguire la lettura delle labbra con precisione.

Agli aspetti ardui si aggiunge il potenziale contesto delle parole pronunciate. Nel caso dei giocatori di baseball, tu apparentemente sai che stanno parlando della partita di baseball e di quello che sarà il prossimo lancio (a meno che, ovviamente, i giocatori in piedi sul monte non decidano di fare semplicemente delle chiacchiere pettegole, un aspetto rappresentato comicamente in molti film orientati al baseball). Per i film di spionaggio, di solito, il contesto è che l’oratore sta discutendo alcuni piani top secret o divulgando un codice segreto che sblocca un caveau di una banca inattaccabile.

L’illuminazione disponibile o associata alla persona che parla è un altro elemento chiave. Se la loro bocca e la loro testa sono nascoste nell’oscurità, le possibilità di vedere le loro labbra muoversi sono basse. Potresti provare a usare altri mezzi come dispositivi a infrarossi e simili. Non credo che la maggior parte di noi si porti dietro questo tipo di aggeggi, anche se è certamente il tipo di cosa che ci aspetteremmo che James Bond portasse.

Possiamo aggiungere alla scoraggiante lista di fattori che la distanza dall’argomento di interesse può rendere più difficile la leggibilità delle labbra. Presumibilmente, più sei lontano come lettore labiale, meno chiaramente puoi vedere le labbra della persona. E c’è il fattore tempo che indubbiamente entra in gioco. Parlare è un atto che si svolge nel tempo. Devi guardare abbastanza a lungo per vedere una serie di parole, e poi cercare di capire come quelle parole vengono usate nelle frasi e, in definitiva, come tutto si unisce in una qualche forma di narrativa generale.

Whoa, sono molte difficoltà e mostrano perché la lettura delle labbra è un’abilità difficile da padroneggiare.

Al giorno d’oggi, ci sono modi automatizzati per aiutare nella lettura delle labbra.

L’avvento del riconoscimento facciale da parte dei computer ha anche portato all’emergere del riconoscimento vocale facciale, noto anche come lettura digitale delle labbra (che potrebbe sembrare strano se si parlasse di labbra come digitali, ma il significato è che il computer o un sistema sta eseguendo la lettura labiale, piuttosto che un essere umano che esegue la lettura labiale).

Questo è stato particolarmente avanzato grazie all’uso di tecniche e tecnologie di intelligenza artificiale (AI).

I modelli computazionali della bocca umana sono diventati relativamente sofisticati e possono rendere le capacità di conversazione-testo piuttosto impressionanti. Probabilmente uno dei maggiori passi avanti è venuto dall’uso del Machine Learning (ML) e del Deep Learning (DL). L’uso di ML/DL è essenzialmente un pattern matching statistico e computazionale in grado di rilevare pattern ricorrenti, che in questo caso consistono nel movimento delle labbra.

Se inseriamo nel ML/DL una sfilza di esempi che hanno una persona che dice determinate parole e poi molte persone che affermano anche quelle parole, i calcoli matematici possono tentare di accertare un tipo di correlazione tra il modo in cui si muovono le labbra e le parole che venivano pronunciate. A volte, tuttavia, una difficoltà è che il ML/DL può superare i dati utilizzati, diventando in grado di rilevare le parole pronunciate solo dal tipo di lingua e dai parlanti scelti per il set di dati di addestramento.

Pertanto, l’intelligenza artificiale che esegue la lettura del labiale potrebbe non funzionare bene quando esamina chiunque stia usando quelle stesse parole e potrebbe essere matematicamente vincolata solo a quelle che forse corrispondono al set di allenamento originale.

Simile in qualche modo alle difficoltà umane di lettura delle labbra, c’è una parvenza di accuratezza statistica coinvolta. Forse una parola qua o là non può essere decifrata. Alcune parole vengono rilevate ma non sono completamente decifrabili e quindi hanno una probabilità associata a ciò che potrebbe essere la parola. Durante una sequenza parlata, forse la lettura labiale ottiene solo una percentuale delle parole e manca o “indovina” del tutto le parole che erano indecifrabili.

Ecco perché il contesto è vitale e anche perché è significativo anche il tempo concesso per assistere al discorso. Generalmente, più lungo è il tempo di osservazione dell’oratore, la probabilità di capire le parole tende ad aumentare di solito, e allo stesso modo conoscere il contesto può aiutare a riempire gli spazi vuoti. Ad esempio, tornando a quei giocatori di baseball, se uno di loro dice la parola “casa” puoi praticamente prevedere che la parola successiva potrebbe essere “piatto” come riferito alla base in cui si troverà il ricevitore.

Qualcosa che voglio subito chiarire è che i sistemi di lettura labiale basati sull’intelligenza artificiale non sono senzienti. Cito questo perché ci sono titoli che continuano a insistere sul fatto che l’IA di oggi è in qualche modo simile all’uomo o addirittura sovrumana nelle sue capacità. Questo è abbastanza fuorviante e una sfortunata esagerazione di ciò che la tecnologia AI può attualmente fare.

Un essere umano che legge le labbra di un’altra persona sarà in grado di valutare cognitivamente la natura della discussione o il modo di parlare che la persona sta intraprendendo. Questa valutazione cognitiva può essere un grande fattore determinante per dare un senso alla stringa di parole che vengono rilevate. Un sistema basato sull’intelligenza artificiale che esegue la lettura delle labbra non ha quel tipo di cognizione. In questo senso, l’intelligenza artificiale è in netto svantaggio nell’esecuzione del compito talk-to-text.

Detto questo, il sistema basato sull’intelligenza artificiale ha alcuni vantaggi rispetto a un essere umano che cerca di leggere le labbra.

L’IA non si stancherà del compito. Un umano potrebbe annoiarsi nell’attesa di vedere qualcuno dire qualcosa, o forse potrebbe distogliere lo sguardo o sussultare proprio quando arriva il momento in cui la persona pronuncia una parola vitale, come il codice segreto per aprire quella cassaforte blindata carica di lingotti d’oro.

Un sistema di intelligenza artificiale utilizzerebbe telecamere per osservare la persona che sta parlando. Quelle fotocamere possono avere obiettivi specializzati ed essere in grado di vedere le immagini a grande distanza, possibilmente anche migliorare la messa a fuoco e gestire anche una scarsa illuminazione. L’occhio umano è una cosa grandiosa e sorprendente, ma in qualche modo è meno capace delle fotocamere truccate.

Un altro aspetto è la possibilità di addestrare il sistema di lettura labiale AI per decifrare in più lingue. Un essere umano che cerca di leggere le labbra potrebbe essere ingannato se la persona che sta parlando passa improvvisamente a un’altra lingua, cercando di allontanare gli osservatori. È relativamente facile addestrare un sistema di lettura labiale basato sull’intelligenza artificiale per comprendere una moltitudine di lingue e potenzialmente essere in grado di analizzare quasi tutte le lingue conosciute dall’umanità.

Al giorno d’oggi ci sono app che leggono le labbra e possono ottenere risultati ragionevolmente buoni. Le probabilità sono che se il talk-to-text può ottenere parte del modo in cui si esegue la lettura delle labbra, un essere umano che esamina i risultati può potenzialmente riempire il resto. In altre parole, supponiamo che l’app ottenga solo alcune delle parole, un essere umano che legge il testo risultante può applicare la propria consapevolezza cognitiva del mondo e potenzialmente divinare ciò che l’oratore potrebbe aver detto in generale.

Ecco perché alcune di queste app moderne sono utilizzate da coloro che hanno problemi di udito o potrebbero essere sordi. L’app può potenzialmente fornire funzionalità aggiuntive per la lettura delle labbra. Ovviamente, dover tenere in mano uno smartphone e puntarlo verso qualcuno che parla è considerato forse un po’ maleducato in determinate circostanze, e quindi potresti non essere prontamente in grado di utilizzare tale funzione. Tieni presente, tuttavia, che siamo sul punto di avere i cosiddetti occhiali intelligenti, simili ai Google Glass offerti in precedenza, e in questo modo l’uso di questo tipo di app per la lettura delle labbra potrebbe essere meno appariscente di conseguenza ( poiché gli occhiali sono già “naturalmente” rivolti a chi parla).

Oltre a cercare di capire la lettura labiale di persona e in tempo reale, un altro approccio prevede la registrazione dell’attività orale su video e quindi l’applicazione degli algoritmi di lettura labiale agli aspetti registrati. L’utilizzo di una registrazione può essere particolarmente utile poiché il video può essere riprodotto e riprodotto, ripetutamente, consentendo più tentativi di discernere le parole pronunciate.

Come gli appassionati di cinema sanno, a volte un agente segreto si trovava seduto in un’auto e veniva parcheggiato fuori da un locale frequentato dal soggetto. Seduto con nonchalance nell’auto parcheggiata, l’agente segreto stava guardando con fervore l’argomento e tentando di leggere le labbra. Stare all’interno dell’auto era una comoda copertura e un mezzo per non sembrare fissi o comunque fuori posto.

Parlando di auto, il futuro delle auto consiste nelle auto a guida autonoma (per la mia ampia copertura, vedere il link qui ).

Questo è un ingegnoso seguito in una considerazione piuttosto interessante sulla lettura delle labbra. Le auto a guida autonoma saranno piene di dispositivi sensoriali elettronici come videocamere, radar, LIDAR, unità a ultrasuoni, immagini termiche e simili.

Una domanda intrigante è questa: le vere auto a guida autonoma basate sull’intelligenza artificiale saranno potenzialmente in grado di leggere le labbra e, in tal caso, cosa potrebbe presagire?

Disfacciamo la faccenda e vediamo.

Comprendere i livelli delle auto a guida autonoma

Come chiarimento, le vere auto a guida autonoma sono quelle che l’IA guida l’auto da sola e non c’è alcuna assistenza umana durante il compito di guida.

Questi veicoli senza conducente sono considerati di Livello 4 e Livello 5 (vedi la mia spiegazione a questo link qui ), mentre un’auto che richiede che un guidatore umano condivida lo sforzo di guida è solitamente considerata al Livello 2 o al Livello 3. Le auto che co- condividere il compito di guida sono descritti come semi-autonomi e in genere contengono una varietà di componenti aggiuntivi automatizzati denominati ADAS (Sistemi avanzati di assistenza alla guida).

Non esiste ancora una vera auto a guida autonoma al Livello 5, che non sappiamo ancora nemmeno se sarà possibile realizzarla, né quanto tempo ci vorrà per arrivarci.

Nel frattempo, gli sforzi del Livello 4 stanno gradualmente cercando di ottenere un po’ di trazione sottoponendosi a prove su strade pubbliche molto strette e selettive, anche se c’è polemica sul fatto che questo test debba essere consentito di per sé (siamo tutti cavie della vita o della morte in un esperimento che si svolgono sulle nostre autostrade e strade secondarie, alcuni sostengono, vedere la mia copertura a questo link qui ).

Poiché le auto semi-autonome richiedono un guidatore umano, l’adozione di questi tipi di auto non sarà molto diversa dalla guida di veicoli convenzionali, quindi non c’è molto di nuovo da trattare su questo argomento (anche se, come vedrai in un momento, i punti che seguono sono generalmente applicabili).

Per le auto semi-autonome, è importante che il pubblico debba essere avvertito di un aspetto inquietante che sta emergendo ultimamente, vale a dire che nonostante quei conducenti umani che continuano a postare video in cui si addormentano al volante di un’auto di livello 2 o di livello 3 , dobbiamo tutti evitare di essere indotti in errore nel credere che il guidatore possa distogliere l’attenzione dal compito di guida mentre guida un’auto semi-autonoma.

Sei la parte responsabile delle azioni di guida del veicolo, indipendentemente da quanta automazione potrebbe essere lanciata in un Livello 2 o Livello 3.

Auto a guida autonoma e lettura labiale

Per i veri veicoli a guida autonoma di livello 4 e livello 5, non ci sarà un guidatore umano coinvolto nell’attività di guida.

Tutti gli occupanti saranno passeggeri.

L’intelligenza artificiale sta guidando.

Un aspetto da discutere immediatamente implica il fatto che l’IA coinvolta negli odierni sistemi di guida dell’IA non è senziente (simile ai miei punti precedenti sull’argomento senzienza). In altre parole, l’intelligenza artificiale è un insieme di programmi e algoritmi basati su computer, e sicuramente non è in grado di ragionare nello stesso modo degli umani.

Perché questa enfasi aggiunta sul fatto che l’IA non sia senziente?

Perché voglio sottolineare che quando discuto del ruolo del sistema di guida dell’intelligenza artificiale, non sto attribuendo qualità umane all’intelligenza artificiale. Per favore, tieni presente che c’è una tendenza continua e pericolosa in questi giorni ad antropomorfizzare l’IA. In sostanza, le persone stanno assegnando una sensibilità simile a quella umana all’intelligenza artificiale di oggi, nonostante il fatto innegabile e indiscutibile che tale intelligenza artificiale non esiste ancora.

Con questo chiarimento, puoi immaginare che il sistema di guida dell’intelligenza artificiale non conosca nativamente in qualche modo il significato di qualsiasi cosa possa essere detta da qualcuno che è oggetto di un algoritmo di lettura delle labbra. Le parole potrebbero essere determinabili in una certa misura come se fossero blob di movimento visualizzato che vengono matematicamente associati a blob che sono parole di testo. Questi blob possono essere raccolti insieme in frasi. L’uso delle funzionalità di elaborazione del linguaggio naturale (NLP) può tentare di scovare la natura della narrazione, anche se ti rendi conto che questa è la capacità limitata che sperimenti quando usi Alexa o Siri.

Tornando al focus sulle auto a guida autonoma, ti starai chiedendo cosa ha a che fare la lettura delle labbra con le auto a guida autonoma.

Come notato, le auto a guida autonoma avranno videocamere, spesso di qualità e calibro piuttosto elevati. Le videocamere montate sul veicolo hanno lo scopo di rilevare la scena di guida e l’ambiente circostante l’auto a guida autonoma. Il sistema di guida AI riceve i dati da quelle telecamere, esegue varie elaborazioni delle immagini e cerca di capire dove si trova la strada, dove sono i pedoni, dove sono le altre auto, ecc.

Questo sarebbe il motivo principale per le videocamere. Renditi conto, però, che quelle videocamere stanno catturando qualunque cosa gli capiti di vedere. Ho esortato nelle mie colonne che c’è un’era in anticipo rispetto a quello che chiamo l’occhio itinerante (vedi la mia copertura a questo link qui ). Avremo auto a guida autonoma tutt’intorno a noi, girovagando e guidando qua e là, nel frattempo, quelle videocamere possono catturare le nostre attività quotidiane.

Immagina un’auto a guida autonoma che percorre la strada del tuo quartiere. La videocamera riprende la scena della strada, mostrando dove sono parcheggiate le auto, se dei cani stanno correndo in mezzo alla strada e così via. Allo stesso tempo, il video mostra che tu e i tuoi figli state giocando a palla con una palla da baseball nel vostro giardino. Questo presumibilmente ha poco a che fare con il compito di guida dell’auto a guida autonoma, e fa semplicemente parte della scena generale e tuttavia catturato dalle videocamere.

I dati delle videocamere potrebbero essere conservati a bordo del veicolo e successivamente caricati nel cloud dell’operatore della flotta o della casa automobilistica tramite l’uso di comunicazioni elettroniche OTA (Over-The-Air). Come verrà utilizzato quel video? Forse potrebbe essere analizzato per considerare gli aspetti immobiliari in una data area, come l’aspetto delle case e lo stato del quartiere. Esistono numerosi modi per monetizzare potenzialmente quei dati.

Potremmo anche anticipare che ci saranno problemi relativi alla privacy. Chi ha il controllo di tutto quel video? Per rendere le cose ancora più imponenti, renditi conto che ci saranno molte auto a guida autonoma che passeranno davanti a casa tua, nel corso di una giornata normale. In teoria, il video potrebbe essere messo insieme per dare un resoconto relativamente completo del tuo andirivieni da casa tua (vedi la mia colonna per le discussioni su queste questioni sulla privacy).

Mettendo da parte per un momento questi scrupoli, consideriamo come gli aspetti della lettura labiale entrano nel quadro, per così dire.

Un’auto a guida autonoma è seduta a un semaforo rosso, in attesa che il semaforo diventi verde. Le persone in piedi sul marciapiede nelle vicinanze parlano a bassa voce, in modo tale che altrimenti non possono essere ascoltate. Sono però alla vista della videocamera.

Presumibilmente, un programma di lettura delle labbra basato sull’intelligenza artificiale potrebbe analizzare le loro labbra e tentare di accertare cosa stanno dicendo. Questo potrebbe essere convertito istantaneamente in testo o parlato ad alta voce dal sistema di intelligenza artificiale meccanizzato. Un passeggero all’interno dell’auto a guida autonoma potrebbe facilmente “ascoltare” la conversazione di quei pedoni, sfruttando le capacità dell’auto a guida autonoma.

Mi rendo conto che chiunque sviluppi un sistema di guida con intelligenza artificiale probabilmente si sta innervosendo per questa rappresentazione e affermerebbe con veemenza che fare la lettura delle labbra non rientra nella loro descrizione del lavoro. Sicuramente, l’idea di includere una capacità di lettura labiale in un sistema di guida IA o non è nell’elenco dei progetti da intraprendere, o se appare in un tale elenco sarebbe considerato un caso marginale ed essere piuttosto basso sulla lista.

In effetti, alcuni potrebbero insistere sul fatto che non c’è assolutamente motivo di avere una capacità di lettura delle labbra inclusa nel sistema di guida AI.

Beh, non è del tutto così.

Ci sono infatti modi in cui una struttura per la lettura delle labbra potrebbe essere utile.

Ad esempio, supponiamo che un operaio edile stradale si trovi davanti all’auto a guida autonoma e si trovi a lato della strada, dirigendo il traffico intorno a un’attività di riparazione della strada. Il lavoratore potrebbe rivolgere parole a un guidatore umano, cercando di trasmettere qualcosa su quale direzione guidare. Stanno parlando ad alta voce, ma non possono essere facilmente ascoltati per il frastuono dei lavori di costruzione in corso.

Un guidatore umano probabilmente farebbe una variante della lettura quotidiana delle labbra e capirebbe che il lavoratore sta dicendo di spostarsi a sinistra e rallentare. Probabilmente, il lavoratore potrebbe anche tenere in mano un cartello e salutare, quindi ci sono una varietà di aspetti visivi che entrano in gioco. La messa in bocca delle parole non è probabilmente l’unica forma di comunicazione, eppure è un’altra modalità che può contribuire a far capire al guidatore cosa sta succedendo e cosa dovrebbe fare al volante del veicolo.

Sembra certamente che vorremmo che il sistema di guida AI sia in grado di capire allo stesso modo la scena di guida in uno scenario del genere. La funzionalità aggiuntiva di leggere le labbra in tempo reale potrebbe essere utile. Sì, questo è un po’ un caso limite, su questo non c’è dubbio. Il punto è che affermare che non ci sono basi per avere una capacità di lettura labiale come parte delle capacità dell’auto a guida autonoma è immediatamente sminuito dall’apparente esempio che mostra che c’è qualche merito (che, puoi quindi discutere su come meritorio o no).

Possiamo anche eludere in qualche modo l’argomento sul fatto che la lettura labiale sia incorporata nel sistema di guida dell’intelligenza artificiale osservando i casi d’uso al di là dell’atto di guidare in sé.

Supponiamo che i passeggeri all’interno di un’auto a guida autonoma abbiano problemi di udito. L’auto a guida autonoma arriva in un parcheggio. I passeggeri abbassano il finestrino per chiacchierare con un parcheggiatore. Supponiamo che l’addetto al parcheggio dica ai passeggeri che un buon punto di consegna è vicino all’ingresso principale del centro commerciale. Sfortunatamente, a causa delle loro difficoltà uditive, non riescono a capire cosa dice il parcheggiatore.

L’auto a guida autonoma potrebbe avere un programma di lettura delle labbra che farebbe il talk-to-text e poi mostrerebbe il testo su uno schermo all’interno del veicolo. Quei passeggeri avrebbero quindi letto lo schermo e avrebbero potuto istruire il sistema di guida AI di lasciarli cadere all’ingresso principale.

In questo esempio, la lettura labiale non è necessariamente incorporata nel sistema di guida AI. Sarebbe al di fuori del regno degli aspetti di guida e potrebbe essere paragonato ad altre caratteristiche di un’auto come i sistemi di infotainment. L’app per la lettura delle labbra sarebbe a beneficio dei passeggeri.

Conclusione

Ci sono ulteriori colpi di scena su questo argomento.

Piuttosto che l’app per la lettura digitale delle labbra a bordo del veicolo, potrebbe essere utilizzata nel cloud.

Ciò significa che il video dell’auto a guida autonoma che è stato caricato nel cloud potrebbe essere ispezionato e potenzialmente utilizzato per rivelare ciò che dicevano le persone nelle vicinanze dell’auto a guida autonoma. Perché mai dovrebbe essere usato? Alcuni indicano il potenziale per la lotta alla criminalità. Altri temono che questo sia un ponte troppo lontano e che verrà utilizzato alla maniera del Grande Fratello.

Ecco un’ultima intuizione per ora e che potresti trovare estremamente allarmante o forse considerare piuttosto utile e geniale.

Siete pronti?

Oltre alle videocamere puntate verso l’esterno, puoi aspettarti che le auto a guida autonoma abbiano anche videocamere puntate verso l’interno. Questo può essere utile per fare sessioni online interattive simili a Zoom mentre guidi in un’auto a guida autonoma. Le videocamere possono anche essere utilizzate per dissuadere le persone dallo scrivere graffiti nel veicolo o strappare l’interno.

Quelle videocamere rivolte verso l’interno possono anche essere utilizzate per leggere le labbra.

Inizieremo coprendo la versione al rialzo di questo uso. Ci sono diversi passeggeri all’interno dell’auto a guida autonoma. Alcuni dei passeggeri hanno problemi di udito e non sono nemmeno esperti nel leggere le labbra. In quanto tale, un ulteriore servizio o caratteristica dell’auto a guida autonoma è che può tentare di eseguire la lettura delle labbra e consentire ai passeggeri di conversare essenzialmente tra loro, aiutati dal programma di lettura delle labbra.

Bello!

Il rovescio della medaglia è che potresti avere conversazioni nell’auto a guida autonoma e non essere desideroso che quelle conversazioni vedano mai la luce del giorno. Potresti pensare che se tagli o copri i microfoni all’interno dell’auto a guida autonoma, le tue chat non verranno mai scoperte. Ovviamente, la videocamera, se abilitata, catturerebbe visivamente la tua conversazione.

Un problema più ampio riguarderà cosa e quando verranno attivate le videocamere rivolte verso l’interno. Inoltre, cosa accadrà al video che è stato così registrato? Fino ad ora, questa non è una preoccupazione evidente poiché poche auto sono dotate di videocamere rivolte verso l’interno. Per le auto a guida autonoma, puoi scommettere che ci saranno videocamere del genere e le probabilità sono che anche le nuove auto convenzionali avranno anche le telecamere incluse.

C’è una frase abbastanza famosa del presidente Theodore Roosevelt che afferma che dovresti parlare a bassa voce e portare un grosso bastone. Se non ti piace tutta questa lettura digitale delle labbra, forse potresti seguire il suo consiglio e usare quel bastoncino per coprirti la bocca quando non vuoi che le tue parole vengano lette dalle labbra.

Qualcosa a cui forse pensare in silenzio , questo è certo.