Neural Magic open source una versione potata del modello del linguaggio BERT

Neural Magic, con sede negli Stati Uniti, in collaborazione con Intel Corporation, ha creato la propria versione “potata” di BERT-Large che è otto volte più veloce e 12 volte più piccola in termini di dimensioni e spazio di archiviazione.

In una sorta di tendenza inversa, i ricercatori sono ora alla ricerca di modi per ridurre l’enorme costo computazionale e le dimensioni dei modelli linguistici senza ostacolarne l’accuratezza.

In questo sforzo, Neural Magic, con sede negli Stati Uniti, in collaborazione con Intel Corporation, ha sviluppato la propria versione “potata” di BERT-Large che è otto volte più veloce e 12 volte più piccola in termini di dimensioni e spazio di archiviazione. Per raggiungere questo obiettivo, i ricercatori hanno combinato i processi di potatura e sparcing nella fase di pre-addestramento per creare architetture generali sparse, ottimizzate e quantizzate su set di dati per attività standard come SQuAD per la risposta alle domande. Questo metodo ha prodotto reti altamente compresse senza notevoli deviazioni in termini di accuratezza rispetto ai modelli non ottimizzati. Come parte della loro ricerca, Intel ha rilasciato i modelli Prune OFA su Hugging Face.

Distribuzione con DeepSpace

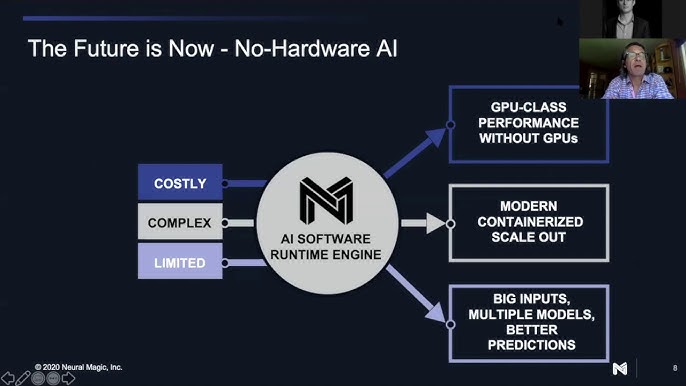

Il motore DeepSparse è progettato specificamente per accelerare le reti sparse e sparse. Questo approccio sfrutta la scarsità per ridurre il calcolo complessivo e sfruttare le grandi cache della CPU per accedere alla memoria a un ritmo più veloce. Con questo metodo, è possibile ottenere prestazioni di classe GPU su CPU di fascia alta. La combinazione di DeepSparse con i modelli a quantizzazione sparsa Prune Once for All produce prestazioni 11 volte migliori in termini di throughput e prestazioni 8 volte migliori per le applicazioni basate sulla latenza, battendo la base BERT e raggiungendo prestazioni di livello DistilBERT senza sacrificare la precisione.

Il grafico sopra evidenzia la relazione tra le reti per il ridimensionamento delle loro dimensioni strutturate rispetto alla loro sparsificazione per rimuovere le ridondanze. Il modello DistilBERT performante ha il minor numero di strati e canali e la precisione più bassa. Con più livelli e canali aggiunti, BERT-base è meno performante e più preciso. Infine, BERT-Large è il più accurato con la dimensione maggiore ma l’inferenza più lenta. Nonostante il numero ridotto di parametri, il BERT-Large sparso ha una precisione vicina alla versione densa e inferenze 8 volte più veloci. Quindi, mentre lo spazio di ottimizzazione più ampio ha aiutato durante l’allenamento, non tutti questi percorsi erano necessari per mantenere l’accuratezza. Le ridondanze in queste reti più grandi emergono ancora di più quando si confrontano le dimensioni dei file necessarie per archiviare questi modelli, come mostrato nel grafico seguente.