Può questo minuscolo modello di linguaggio sconfiggere il gigantesco GPT3?

Mentre GPT-3 si è vantato di ottenere prestazioni all’avanguardia su compiti complessi di PNL con centinaia di miliardi di parametri, i ricercatori della LMU di Monaco, in Germania, hanno proposto un modello linguistico in grado di mostrare risultati simili con molti meno parametri.

GPT-3 è stato addestrato su 175 miliardi di parametri e quindi ha mostrato notevoli capacità di pochi colpi, e riformulando alcune attività e suggerendo input, ha anche mostrato capacità immense sul benchmark SuperGLUE. Tuttavia presenta due svantaggi più significativi: i modelli di grandi dimensioni non sono sempre fattibili per scenari del mondo reale e con la finestra di contesto di questi modelli mostruosi è limitata a poche centinaia di gettoni, non scala più di pochi esempi.

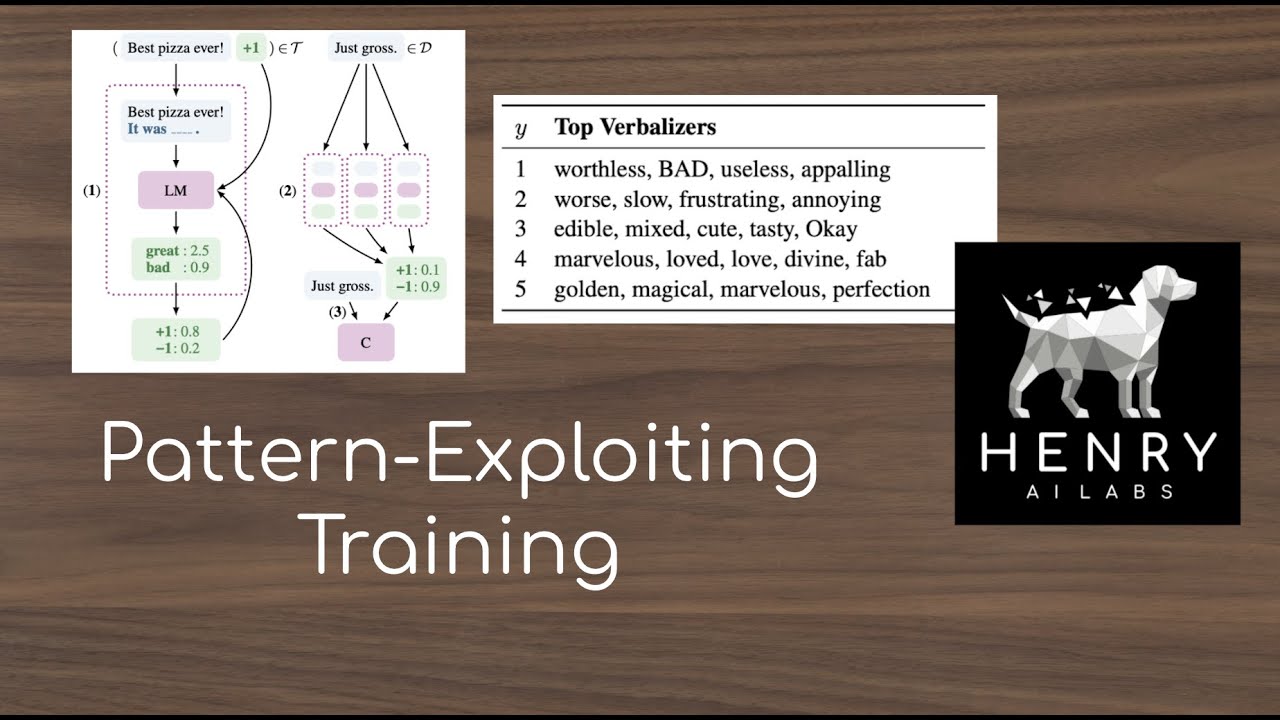

E così, i ricercatori hanno proposto un’alternativa al priming, cioè Pattern Exploiting Training (PET), che fonde il mare di riformulare i compiti con le domande di Cloze insieme alla regolare regolazione fine basata sul gradiente. Il PET richiedeva dati senza etichetta, che è più facile da raccogliere rispetto ai dati etichettati, rendendolo così utilizzabile per applicazioni del mondo reale. Il vantaggio più significativo che fornisce è quando il risultato previsto da questi grandi modelli linguistici come GPT-3 corrisponde a un singolo token nel suo vocabolario, che diventa difficile per molte attività di PNL.

Pattern Exploiting Training (PET)

In questo studio, i ricercatori hanno modificato il PET per prevedere più di un token per superare GPT-3 su SuperGLUE con 32 esempi di allenamento e solo lo 0,1% dei suoi parametri. I ricercatori hanno mostrato come il PET sfrutti i modelli linguistici mascherati per assegnare probabilità alle sequenze di testi.

Per facilitare ciò, i ricercatori hanno considerato di mappare gli input agli output per i quali il PET richiedeva coppie di pattern-verbaliser (PVP), che consistono in un modello che mappa gli input alle domande Cloze contenenti una singola maschera e un verbalizzatore che mappa ogni output su un singolo token rappresentare compiti.

Applicazione di coppie di pattern-verbalizzatore per il riconoscimento del coinvolgimento testuale: un input viene convertito in una domanda cloze per ogni output è derivato dalla probabilità di essere una scelta plausibile per la posizione mascherata.

Il PET deve derivare la probabilità di essere l’output accurato dalla probabilità di essere il token corretto nella posizione mascherata. Per il compito dato, rilevare PVP che si comportano bene è stato un compito impegnativo con l’assenza di un ampio set di sviluppo, ed è per questo che l’addestramento che sfrutta i pattern è stata la scelta preferita per abilitare una combinazione di più PVP.

Per questo, per ogni PVP, un modello di linguaggio mascherato viene messo a punto su esempi di addestramento e l’insieme di MLM ottimizzati viene quindi utilizzato per annotare una serie di dati senza etichetta con etichette morbide sulla distribuzione di probabilità. Inoltre, il set di dati con etichetta soft viene utilizzato per l’addestramento di un classificatore di sequenze regolare.

Durante lo svolgimento, i ricercatori hanno notato che il PET viene fornito con una limitazione del verbalizzatore in cui fatica a mappare ogni possibile output su un singolo token per molte attività. E così, i ricercatori hanno generalizzato i verbalizzatori alla funzione che ha richiesto alcune modifiche sull’inferenza e sull’addestramento.

Leggi anche: Il GPT-3 non così aperto di OpenAI può influire sulla sua efficacia

PET vs GPT-3 su SuperGLUE

Per confrontare le prestazioni tra GPT-3 e PET, i ricercatori hanno scelto SuperGLUE come punto di riferimento. Durante lo svolgimento, i ricercatori hanno notato che i cannoni PET vengono valutati sugli stessi identici dati di allenamento di GPT-3. Questo è molto perché GPT-3 sfrutta diversi dati di allenamento per attività diverse. Quindi, per creare condizioni di parità, i ricercatori hanno creato un nuovo set di dati di formazione di 32 esempi, selezionati casualmente utilizzando il seme casuale fisso per ciascuna attività.

In aggiunta a ciò, i ricercatori hanno anche sviluppato una serie di 20.000 esempi senza etichetta per ciascuna attività, rimuovendo tutte le etichette. E il set di esempi risultante che verrà utilizzato per l’addestramento e gli esempi senza etichetta come FewGLUE.

Per eseguire le attività, i ricercatori hanno utilizzato BoolQ, un’attività di controllo qualità; CB e RTE, i compiti relativi al testo; Compito COPA; MultiRC, un’altra attività di controllo qualità; ReCoRD, un compito di domande di Cloze. E come modello di base considerevole per la PET, i ricercatori hanno optato per ALBERT .

PET viene quindi eseguito sul set di addestramento FewGLUE per tutte le attività SuperGLUE; tuttavia, per COPA, WSC e ReCoRD, i ricercatori hanno proposto una modifica della PET. Il metodo proposto viene quindi addestrato su tutte le attività tranne COPA, ESC e ReCoRD, che hanno semplicemente ripreso i risultati regolari della PET.

Dopo la sperimentazione, i risultati evidenziano che ALBERT con PET evidenzia prestazioni simili a GPT-3 , che è maggiore di un fattore 785. In media, il metodo proposto fornisce prestazioni migliori di 18 punti rispetto a GPT-3. Mostrando la suddivisione dei risultati, il modello proposto – PET, simile a GPT-3, non funziona su WiC e, solo per l’attività ReCoRD, GPT-3 ha mostrato prestazioni costanti migliori del PET.

Con questo studio, i ricercatori hanno mostrato come sia possibile ottenere prestazioni di pochi colpi su compiti di PNL simili al risultato GPT-3 utilizzando PET. Il PET riformula i compiti mentre Cloze interroga e addestra i modelli per diverse riformulazioni. Per far sì che ciò accada, i ricercatori hanno modificato la PET da utilizzare per attività che richiedono più gettoni.

Sebbene i risultati evidenzino che il metodo proposto ha sovraperformato GPT-3 su molte attività, non è riuscito a mostrare risultati più sorridenti su ogni attività data. Tuttavia, un tale studio apre effettivamente canali e opportunità per spingere i confini dell’IA con un hardware modesto.