Nel 1997, The Simpsons profetizzò che per le guerre future, “la maggior parte dei combattimenti effettivi sarà svolta da piccoli robot” con i soldati responsabili solo di “costruire e mantenere quei robot”. Sebbene il track record del fumetto con le previsioni sia discutibile, pochi sosterranno che i robot hanno svolto un ruolo fondamentale nei combattimenti negli ultimi dieci anni. Che si tratti di un drone Predator che pattuglia una zona interdetta al volo o di un Packbot che diffonde una bomba, i robot hanno reso nota la loro presenza sul campo di battaglia.

Tuttavia, alcuni sosterranno la veridicità della previsione dei Simpson sul ruolo dei soldati in relazione ai robot. In particolare, quale sarà la relazione uomo-robot per completare il compito di combattimento più elementare: uccidere il nemico? Con i robot attuali, un operatore umano deve dire direttamente a un robot di ingaggiare e uccidere un nemico.

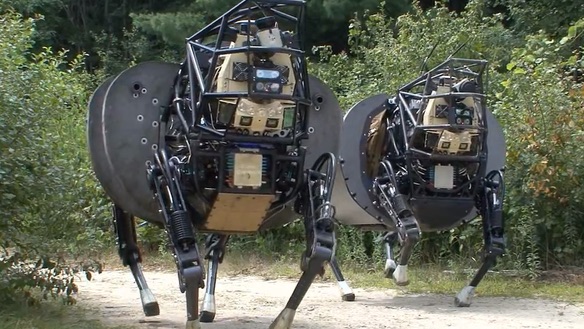

Nel frattempo, i film di Terminator prevedono che entro il 2029 i robot saranno in grado di rintracciare e uccidere autonomamente. In combattimento, questa capacità sarebbe utile. Un gran numero di robot avrebbe potuto pattugliare autonomamente le strade di Fallujah o eseguire rischiosi raid attraverso le grotte in Afghanistan, piuttosto che mettere i soldati in queste situazioni.

Sorge rapidamente la domanda su quali sfide esistono per lo sviluppo di questi robot killer. A un livello molto primitivo, un robot di uccisione autonomo potrebbe consistere in una mitragliatrice montata su un Roomba che rotola e uccide indiscriminatamente. Ma affinché il robot sia effettivamente utile in combattimento, deve anche essere in grado di distinguere un nemico da un non combattente e quindi prendere la decisione di uccidere. Questi due passaggi forniscono le sfide principali per il dispiegamento di un esercito di robot killer.

Il primo passo, l’identificazione del bersaglio, può essere realizzato attraverso progressi nella biometria e nel rilevamento. Se il bersaglio è noto, il robot può riconoscerlo tramite riconoscimento facciale, riconoscimento vocale, analisi dell’andatura o persino il segnale del cellulare. Diventa più difficile quando il bersaglio non è noto, come se un robot stesse cercando i nemici. Se un nemico ingaggia per primo il robot, il robot potrebbe semplicemente rispondere al fuoco usando la triangolazione acustica per identificare la fonte del colpo. Nel caso in cui il nemico non spari, il robot dovrebbe fare affidamento sul campo emergente di previsione dell’intento, in cui una persona con cattive intenzioni viene identificata attraverso firme biometriche tra cui frequenza cardiaca, pupillometria e temperatura della pelle.

Il passo successivo, decidere di impegnarsi, ha tradizionalmente coinvolto il giudizio umano per due ragioni. In primo luogo, con la nebbia di guerra, c’è sempre l’incertezza legata all’identificazione di un obiettivo. Secondo, il tiratore deve soppesare qualsiasi danno collaterale associato all’ingaggio. Tuttavia, i progressi nella visione artificiale dovrebbero consentire a un robot di osservare l’ambiente e prendere queste decisioni sulla base di una serie di algoritmi complessi.

Sebbene fattibile, la tecnologia associata a questi processi è abbastanza immatura e inaffidabile. Tuttavia, con il miglioramento degli algoritmi di rilevamento e della visione artificiale, queste sfide verranno risolte. Poiché la tecnologia presto non sarà il fattore limitante, ci sono due questioni più ampie che limiteranno lo sviluppo di robot killer.

La prima questione riguarda l’identificazione di come un nemico potrebbe contrastare questi robot assassini; il contatore più logico sarebbe creare robot che uccidono i robot. In tal modo, questo scatenerà una corsa agli armamenti per l’autonomia, in cui diversi militari competono per creare il robot con il tempo di uccisione più veloce. Le corse agli armamenti sono in genere costose e indesiderabili. Inoltre, poiché i tempi di uccisione si riducono per un robot, la probabilità di danni collaterali aumenterebbe intrinsecamente.

Il problema più grande è l’etica di consentire a un robot di decidere di uccidere. In particolare, chi sarebbe ritenuto responsabile se la società non fosse d’accordo con la decisione di un robot di impegnarsi? Supponiamo che un robot distrugga un edificio, uccidendo più civili, dopo aver erroneamente identificato un civile come nemico. Il programmatore che ha scritto l’algoritmo sarebbe ritenuto responsabile? Oppure la persona che ha assegnato la missione al robot? O il comandante che tecnicamente possiede il robot? Questo enigma etico costituisce la logica alla base di una mossa della comunità internazionale per vietare i robot di uccisione completamente autonomi.

E le organizzazioni terroristiche che non aderiscono alle convenzioni internazionali e non sono preoccupate per una corsa agli armamenti o per danni collaterali? Fortunatamente, le organizzazioni terroristiche non hanno accesso alla tecnologia necessaria per realizzare questi robot assassini, almeno quelli che funzionerebbero in modo affidabile. Inoltre, vedrebbero pochi vantaggi da un robot che agisce in modo completamente autonomo rispetto a essere azionato a distanza.

Senza dubbio, i robot continueranno a svolgere un ruolo fondamentale nel campo di battaglia. Tuttavia, la funzione principale del combattimento – uccidere il nemico – richiederà il coinvolgimento umano. Sebbene tecnicamente fattibile con la tecnologia attuale, l’etica e le implicazioni sociali dei robot assassini ne precluderanno l’utilizzo dal campo di battaglia, almeno per ora.