Man mano che sempre più industrie portano casi d’uso ML in produzione, la necessità di pratiche coerenti per la gestione del ML in produzione e l’ottimizzazione dell’iterazione del ciclo di vita ML è cresciuta rapidamente. L’anno scorso, alcuni di noi hanno collaborato con USENIX per guidare la prima conferenza Industria / Accademica dedicata alle sfide e alle innovazioni nella gestione del ML nella produzione. OpML 2019 è stato un grande successo: ha riunito esperti, professionisti, ingegneri e ricercatori per discutere le ultime e più importanti operazioni ML. Puoi trovare un riepilogo di OpML 2019 qui . Quest’anno, grazie a COVID19, OpML 2020 è diventata una conferenza virtuale con presentazioni video e discussioni aperte su Slack .

Questo articolo copre ciò che abbiamo visto nelle operazioni ML all’avanguardia a OpML 2020 e l’evoluzione del ML di produzione come si è visto tra OpML 2019 e OpML 2020.

Come si sono evolute le operazioni ML finora?

Osservando l’evoluzione di OpML dal 2019 al 2020, erano visibili diverse tendenze:

La comunità sta crescendo. Le esperienze vengono ora condivise non solo da società web all’avanguardia, ma anche da aziende più classiche. Il mondo accademico sta iniziando a sviluppare soluzioni alle sfide del ML Ops

Sfide come la distribuzione dei modelli, già in primo piano nel 2019, continuano nel 2020, con progressi guidati dall’esperienza / best practice e nuovi approcci per scalabilità, velocità e iterazione.

Il set di strumenti e le opzioni hardware disponibili sono in continua espansione e il ML di produzione deve stare al passo con i progressi del ML stesso.

Stiamo assistendo a esperienze e tecniche per affrontare il machine learning all’edge

Pregiudizi, etica, privacy e altre preoccupazioni umane stanno diventando in primo piano, generando nuove soluzioni e pratiche da parte di aziende e ricercatori.

Cosa c’è di nuovo e interessante in ML Ops?

Allora, cosa c’era in OpML2020? OpML 2020 ha messo in mostra lo stato dell’arte nel ML di produzione, presentato dall’industria e dal mondo accademico e curato dal Comitato del programma OpML, esperti di software ML, pratiche di produzione, infrastruttura scale-out, hardware e applicazioni. Vale la pena notare i seguenti punti salienti:

Raccomandato per te

Model Lifecycle Management

Addestrare, o anche correre, i tuoi modelli in produzione non è sufficiente. I modelli con apprendimento automatico hanno dipendenze complesse, inclusi i dati di addestramento, le versioni di funzioni derivate e incorporamenti, l’inclinazione tra le versioni offline e online delle funzioni e più versioni dello stesso modello in esecuzione in produzione. Mantenere questo funzionamento fluido e su larga scala è come dirigere un’orchestra. Le aziende che hanno eseguito e ridimensionato con successo il ML nella produzione hanno molte informazioni da offrire alla comunità. Walmart Labs ha descritto il loro approccio per aiutare i data scientist a portare i modelli dalle loro macchine locali alla loro piattaforma di produzione . Netflix ha discusso del proprio sistema che gestisce oltre duemila modelli in produzione con funzionalità che vanno dalla scoperta del modello, monitoraggio e protezione e rollback della distribuzione.

Non importa quanto siano bravi i tuoi team di data science e machine learning se non puoi eseguire i tuoi modelli in produzione! Che tu stia lavorando con la data del cliente personalizzata, il rilevamento in tempo reale o la ricerca e il posizionamento, le funzionalità in rapida evoluzione e la complessità combinatoria spesso escludono il solo calcolo offline. Model Deployment (chiamato anche Model Serving) è la sfida di ML Ops su come fornire modelli in tempo reale o quasi in tempo reale. Tre società Internet di alto livello, Intuit, Netflix e Adobe, hanno descritto le loro esperienze nella distribuzione di modelli, dall’inferenza marginale, ai compromessi tra strategie di esecuzione del modello e formati intermedi come ONNX, tecniche per la gestione e l’esecuzione di modelli di produzione su larga scala e come abilitare data scientist e altri per portare i loro modelli in produzione senza una profonda esperienza dei sistemi. L’aeronautica degli Stati Uniti e la Clarkson University hanno mostrato le tecniche per eseguire direttamente i modelli PyTorch come endpoint RESTful .

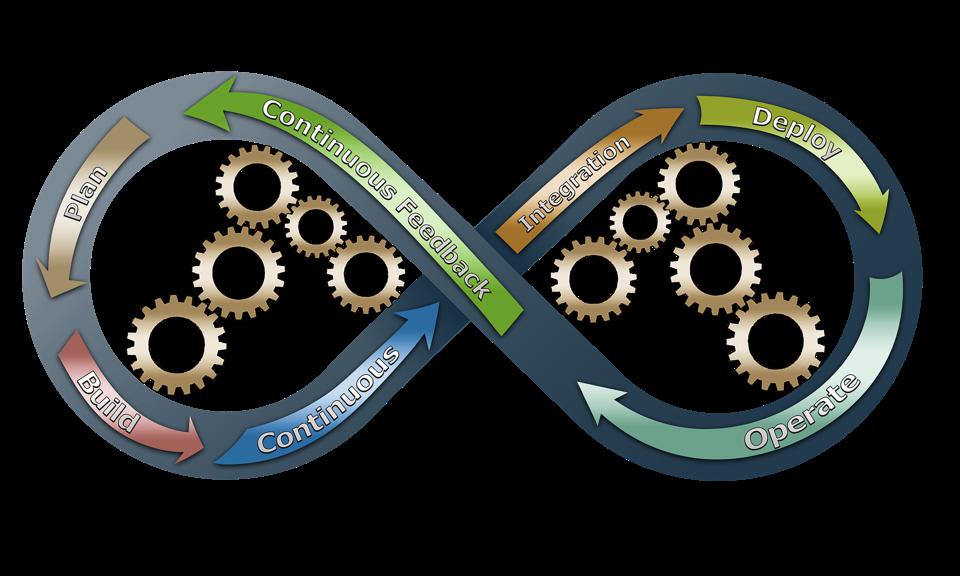

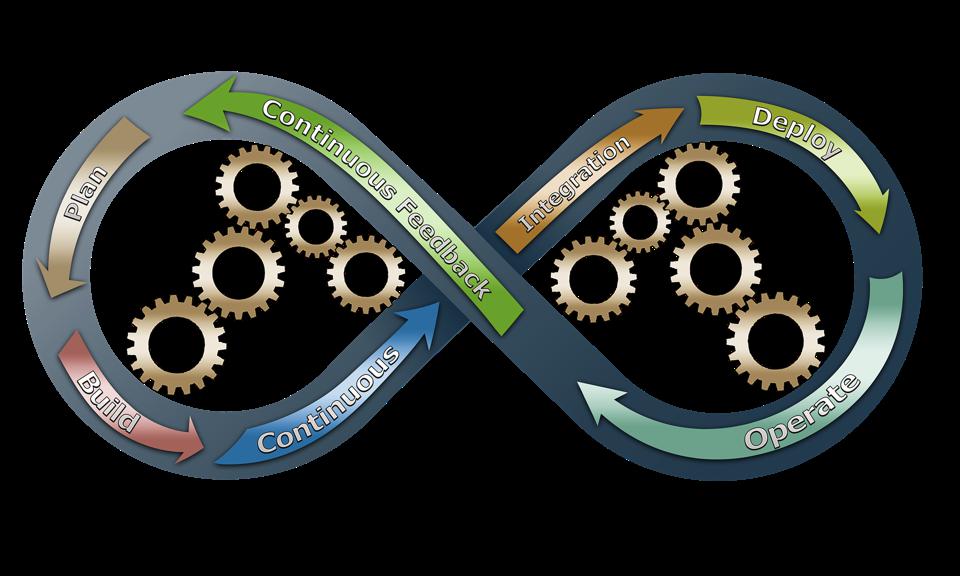

Algoritmi, infrastruttura e scala

Nuove piattaforme ML emergono ogni giorno e nel nostro campo nuove innovazioni possono diventare realtà produttive in tempi record, portando con sé nuove sfide di produzione. Le sfide del ML Ops includono implementazione e iterazione rapide e scalabili, come aumentare l’automazione e ridurre la dipendenza umana e quindi distribuire nuovi modelli più velocemente, come rendere il ML adattivo con l’apprendimento incrementale, ecc. LinkedIn ha descritto i metodi per rimuovere l’essere umano nel ciclo nel ML Lifecycle , mentre Intel ha descritto due metodi per la scalabilità ML nella produzione, Cluster Model Serving – Distributed Inference e Time Series AutoML all’interno della Ray Platform . Una collaborazione tra l’Università della California e Virginia Tech ha descritto approcci per l’ apprendimento incrementale sui dispositivi mobili.

Esperienze pratiche e buone pratiche

Il ML operativo è uno spazio ad ampio raggio in cui sono disponibili molte tecnologie, piattaforme e approcci. Alcune sfide non possono essere viste fino a quando non le provi effettivamente. I primi utenti e le loro soluzioni sono ottimi modelli di progettazione da seguire e da cui imparare! Mercari , Google , VMware e Nvidia hanno descritto le operazioni di ML nella vita reale e le esperienze, le best practice e le soluzioni all’interno. Queste best practice hanno mostrato che le operazioni ML nel mondo reale funzionano su larga scala e in applicazioni che vanno dall’e-commerce alle auto a guida autonoma.

Modello di formazione

L’attenzione alla produzione non elimina la necessità di formazione. La riqualificazione e la formazione su scala di produzione sono entrambi fattori, poiché la complessità dei modelli di apprendimento automatico e la quantità grezza di dati da cui vengono addestrati sono in costante aumento. Intuit ha descritto come gestire l’ infrastruttura Spark e Kubernetes non elaborata per addestrare modelli su larga scala . SigOpt ha descritto gli approcci di ottimizzazione bayesiana per migliorare continuamente l’ efficienza dell’addestramento del modello nel tempo . Google ha condiviso le informazioni apprese da quindici anni di formazione sui modelli e interruzioni dell’esecuzione dei modelli .

Normativa, gestione dei dati, spiegabilità

Poiché il ML di produzione viene utilizzato in più settori, le aziende devono capire come le pipeline di ML si intersecano con le preoccupazioni dei clienti come la gestione dei dati, la fiducia e la privacy. A livello tecnico, il modo in cui le funzionalità vengono costruite, valutate e gestite è fondamentale, così come la capacità di monitorare e spiegare il machine learning in produzione. ServiceNow ha descritto esperienze pratiche nell’aiutare le proprie organizzazioni a determinare il modo migliore per utilizzare i dati e le funzionalità per Production ML e la ricerca di IBM , KTH – Institute of Technology e SnT University of Luxembourg ha mostrato nuovi modi per esplorare e analizzare le opzioni per le pipeline di produzione.

Bias, etica e privacy

Poiché sempre più modelli entrano in produzione, le aziende devono gestire il rischio aziendale. Non è sufficiente ottenere ottime prestazioni di modellazione e gestire bene le pipeline: con una grande potenza di modellazione derivano grandi responsabilità. Chi tralasciano i nostri modelli? A chi stanno danneggiando? Come proteggiamo la privacy dei nostri membri e clienti come aziende? Anche se i dati sono protetti, le informazioni private possono fuoriuscire attraverso i modelli stessi? Capital One ha discusso di vari attacchi (e difese) contro modelli di machine learning per dedurre i dati di addestramento e i segreti aziendali con accesso solo al modello o ai suoi iperparametri. Facebook ha descritto il loro approccio per la proprietà standardizzata a livello aziendale delle risorse ML, fondamentale per far rispettare la privacy dei dati.

Apprendimento approfondito e sfide di produzione specifiche per GPU

Nuove innovazioni DL stanno arrivando rapidamente e le pipeline DL tendono a utilizzare hardware costoso come le GPU che beneficiano di un’attenta ottimizzazione. I ricercatori dell’Università dell’Illinois a Urbana Champaign hanno descritto una specifica di compatibilità per facilitare la condivisione e la riproduzione dei lavori DL . Nvidia ha descritto l’ uso della GPU oltre la formazione DL e attraverso una pipeline di data science end-to-end.

Mentre affrontiamo le sfide di COVID 19 – abbiamo avuto una grande opportunità, il contenuto tecnico di OpML 2020 è disponibile per tutti – gratuitamente. È possibile accedere a tutte le diapositive del discorso, i documenti, i video di presentazione breve e lungo di tutte le sessioni qui . C’è anche un canale slack per le discussioni nella comunità slack di OpML .

In conclusione..

Osservando questa evoluzione, è chiaro che ML Ops è qui per restare. Solo un anno ha visto la comunità espandersi, risolvere le sfide attuali e trovarne di nuove. Negli anni futuri, io per primo, prevedo l’emergere di un focus sulla sicurezza del modello, l’adattabilità e l’automazione. Non vedo l’ora di vedere cosa porterà il prossimo anno di ML Ops!