PRIMI 6 PREGIUDIZI COMUNI NEI MODELLI ML

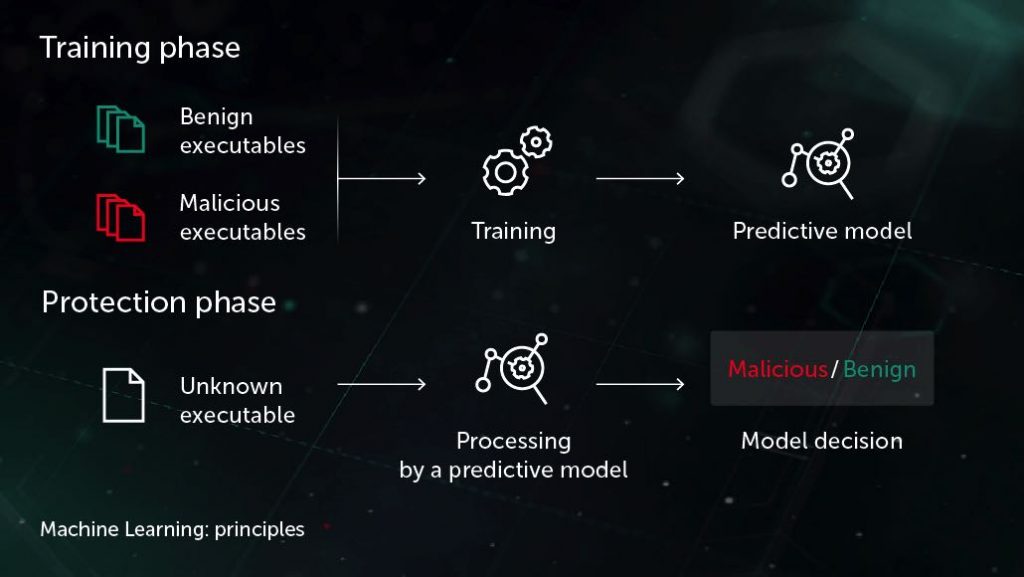

L’apprendimento automatico non riguarda solo le macchine. Almeno non ancora. C’è ancora un elemento umano nel loop e sembra che questo continuerà per qualche tempo. In altre parole, l’intelligenza generale artificiale (AGI) è un sogno lontano. Poiché gli esseri umani interferiscono nei processi di apprendimento dei modelli ML, i pregiudizi sottostanti emergono sotto forma di risultati imprecisi.

Avere un modello imparziale è quasi impossibile poiché gli umani generano i dati e un modello è buono solo quanto i dati che viene alimentato. Quindi, è compito del tecnico dei dati tenere d’occhio i modi in cui i pregiudizi possono entrare nel sistema. Secondo il team di sviluppatori di Google, i seguenti sono i pregiudizi comunemente riscontrati durante l’addestramento di un modello di apprendimento automatico:

Bias di automazione

Si ritiene che il pregiudizio di automazione si verifichi quando un decisore umano favorisce le raccomandazioni formulate da un sistema decisionale automatizzato sulle informazioni fatte senza automazione, anche quando si scopre che la versione automatizzata sta producendo errori.

Bias di conferma

La tendenza a cercare o interpretare le informazioni in modo da confermare i propri pregiudizi (ipotesi). Gli sviluppatori di machine learning a volte tendono a raccogliere dati o etichettarli in modo da soddisfare i loro pregiudizi irrisolti. Questi pregiudizi penetrano nei risultati e talvolta esplodono su larga scala.

Questo pregiudizio deriva anche da un’altra forma di pregiudizio noto come pregiudizio da sperimentatore, in cui lo scienziato di dati avrebbe addestrato un modello fino a quando la sua ipotesi precedentemente sostenuta è stata confermata.

Distorsione da attribuzione di gruppo

Questo pregiudizio si verifica comunemente quando l’assunto che ciò che è buono per una persona è buono per il gruppo è preso troppo sul serio. Gli effetti di questa distorsione possono peggiorare ulteriormente se si utilizza un campionamento pratico per la raccolta dei dati. Le attribuzioni fatte in questo modo raramente riflettono la realtà.

Distorsione da omogeneità fuori dal gruppo

Considera due gruppi di famiglie. Un gruppo ha un paio di gemelli, mentre l’altro no. Quando viene chiesto a una famiglia non gemella di distinguere tra i gemelli, potrebbero vacillare, mentre i genitori del gemello si identificheranno facilmente e potrebbero persino dare una descrizione sfumata. Quindi, per la famiglia non gemella, questi gemelli sono quasi tutti uguali. La brevità con cui vengono fatte ipotesi su gruppi esterni ai nostri porta a distorsioni dell’omogeneità fuori dal gruppo. Allo stesso modo, esiste anche la distorsione all’interno del gruppo, che funziona al contrario.

Distorsione di selezione

La distorsione di selezione è il risultato di errori nel modo in cui viene eseguito il campionamento. Ad esempio, dobbiamo costruire un modello ML che preveda i sentimenti del pubblico riguardo ai film. Come parte della raccolta di dati, se il pubblico viene consegnato un modulo di sondaggio, possono apparire le seguenti forme di pregiudizio:

Distorsione da copertura: quando la popolazione rappresentata nel set di dati non corrisponde alla popolazione su cui il modello di apprendimento automatico sta facendo previsioni. Prendendo lo stesso esempio del film sopra, campionando da una popolazione che ha scelto di vedere il film, le previsioni del modello potrebbero non generalizzare a persone che non hanno già espresso quel livello di interesse per il film.

Distorsione da campionamento: ciò si verifica quando il campione non è casuale o diversificato. Supponiamo che vengano prese solo le recensioni delle persone in prima fila in un teatro anziché un gruppo casuale, quindi, inutile dirlo, difficilmente afferreremo i sentimenti del pubblico.

Distorsione da mancata risposta: questa distorsione è generalmente dalla fine dei dati. Un sospiro di sollievo per i raccoglitori di dati. Questo pregiudizio si verificherà quando determinate sezioni del pubblico scelgono di non rivedere il film. Supponiamo che il pubblico neutrale si allontani dalla revisione e solo quelli con opinioni forti, di solito i fan, si accumulano nelle recensioni, quindi i risultati si appoggeranno a favore del film. Questo pregiudizio è anche noto come pregiudizio alla partecipazione.

Leggi anche Strong AI? I maggiori del settore si stanno riprendendo dal pregiudizio di genere negli strumenti AI

Bias di segnalazione

Supponiamo che un modello NLP sia addestrato sul set di dati che contiene notizie degli ultimi decenni. Sebbene chiamare notizie distorte sia un eufemismo, esiste un particolare tipo di pregiudizio che emerge dal modo in cui le azioni sono documentate. Ad esempio, se la parola “riso” è più diffusa di “respiro” in una storia, allora un modello di apprendimento automatico che tiene conto della frequenza delle parole concluderà che ridere è più comune del respiro!