In ambito di modelli linguistici generativi (LLM, Large Language Models), una delle criticità che emerge spesso è il fenomeno detto mode collapse, cioè la tendenza del modello a produrre risposte ripetitive, prevedibili, affini ai pattern più “sicuri” appresi durante il fine-tuning (specialmente in fasi di allineamento con feedback umano). Un recente lavoro illustra come un semplice accorgimento a livello di prompt — definito dai ricercatori Verbalized Sampling (VS) — possa attenuare questo vincolo e far emergere una gamma più ampia di risposte plausibili.

Per capire l’innovazione, occorre riflettere sul meccanismo interno dei modelli linguistici: durante la generazione di testo, il modello calcola una distribuzione di probabilità sulle possibili next-token (o sequenze) e ne “campiona” una (o più) in base a meccanismi di decodifica (temperature, top-k, nucleus sampling, ecc.). Tuttavia, durante la fase di allineamento (ad esempio con RLHF, Reinforcement Learning from Human Feedback), il modello viene ottimizzato affinché generi risposte che gli esseri umani giudicano migliori, favorendo scelte più “convenzionali”, ovvero regioni ad alta probabilità della distribuzione. Questo induce una compressione della varietà generativa: le risposte meno frequenti o “inaspettate” vengono sistematicamente penalizzate, pur restando presenti come possibilità latenti nel modello.

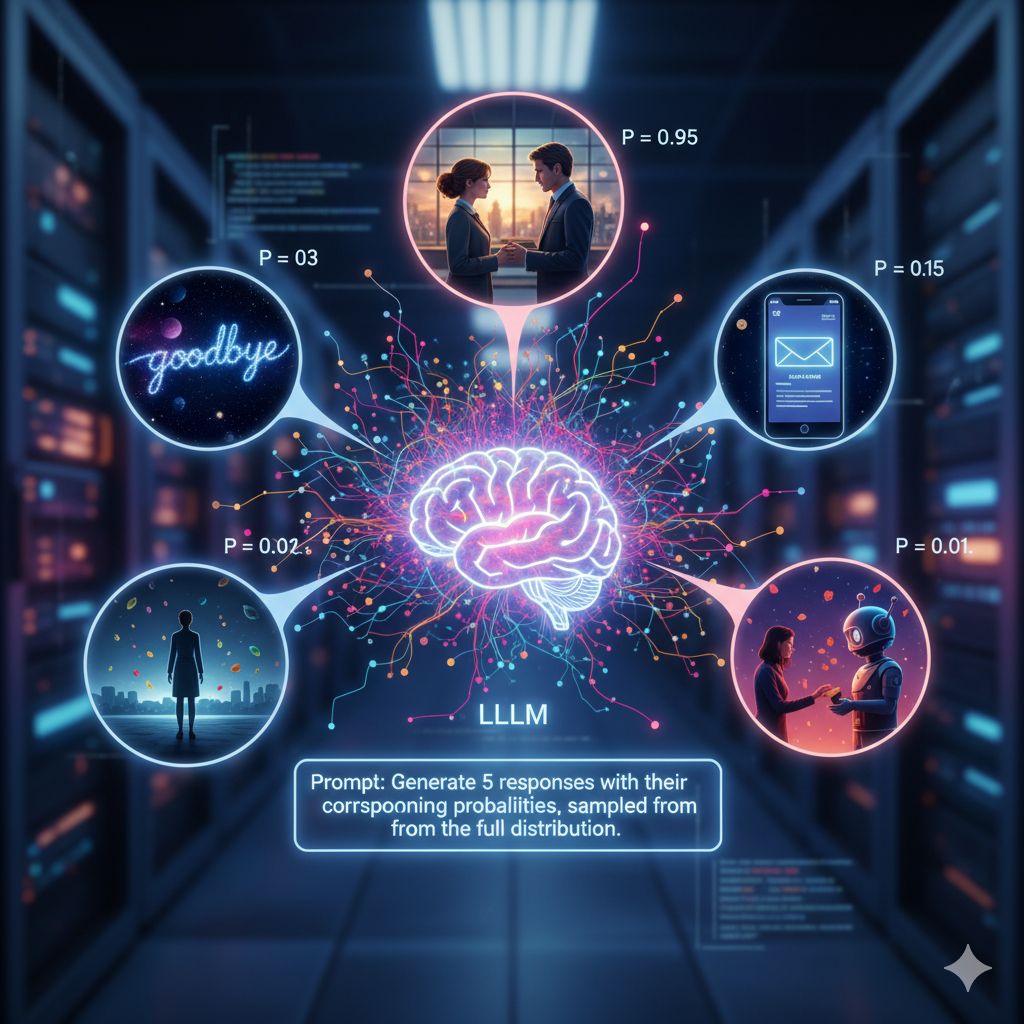

Quel che Verbalized Sampling propone è di bypassare — almeno in parte — questa penalizzazione implicita. Invece di chiedere al modello “fornisci una risposta ottimale”, si chiede di “verbalizzare” — ossia esprimere verbalmente — un set di possibili risposte con le rispettive probabilità, tutte estratte dalla distribuzione interna completa. In particolare, la frase aggiuntiva tipica è: “Generate 5 responses with their corresponding probabilities, sampled from the full distribution.”

Questa istruzione induce il modello a non “ridurre” mentalmente le opzioni, ma a esporle tutte, poi scegliere da quel ventaglio. Di fatto, VS trasforma il processo “nascosto” della decodifica probabilistica in una forma esplicita di output.

I ricercatori hanno testato Verbalized Sampling su diversi compiti. Nel dominio della scrittura creativa, l’uso di VS ha aumentato metriche di diversità del testo fino a 2,1× rispetto al prompting standard, mantenendo — e in alcuni casi migliorando — la qualità percepita. Un prompt narrativo “senza un addio” che con una richiesta tradizionale tendeva a cadere su rotture sentimentali canoniche, sotto VS generava storie con eventi cosmici, email silenziose, momenti sospesi, elementi fuori schema.

Analogamente, in simulazioni dialogiche, VS consente di generare risposte con esitazioni, cambi di opinione, resistenze — caratteristiche tipiche del dialogo umano — migliorando l’allineamento con dati reali di comportamento (ad esempio nelle simulazioni di donazioni). Nel contesto delle interrogazioni aperte (open-ended QA), VS produce risposte che coprono una gamma più ampia di possibili soluzioni (es. elenchi di stati o concetti), avvicinandosi meglio alla distribuzione reale dei dati. Infine, nella generazione di dati sintetici (per esempio problemi matematici), VS migliora la varietà dei dati prodotti e, cosa importante, migliora le performance su benchmark matematici rispetto a dati generati con prompting convenzionale.

Un aspetto importante è che VS risulta tunable: è possibile controllare quanto “in profondità” nella coda probabilistica si voglia esplorare (impostando soglie di probabilità, numero di risposte, ecc.), senza dover modificare la decodifica del modello o agire internamente sui pesi. In esperimenti con Gemini-2.5-Flash, abbassando la soglia da 1 a 0,001 si è visto un aumento progressivo della diversità, con VS che supera prompt diretti e sequenziali su tutti i valori testati. Inoltre, l’effetto è risultata più marcato sui modelli più grandi (come GPT-4.1, Claude-4) rispetto a modelli più piccoli: VS aiuta a sbloccare capacità latenti che diventano maggiormente evidenti nelle architetture complesse.

Verbalized Sampling si inserisce nello spettro degli approcci di prompt engineering, un’area che negli ultimi anni ha acquisito crescente importanza perché consente di modificare il comportamento dei LLM a livello di input, senza toccare architettura né pesi. Altri esempi famosi includono il chain-of-thought prompting, che incoraggia il modello a “pensare per passi”. Nel prompting CoT, si aggiunge al prompt una frase tipo “Let’s think step by step” per spingere il modello a esplicitare ragionamenti intermedi prima della risposta.

Un’altra tecnica è il prompting con esempi (few-shot) che guida il modello mostrando input/risposta attesi. Analogamente, in VS si sfrutta la struttura della decodifica probabilistica — ma la si rende trasparente. Ciò che distingue VS è che non cerca di manipolare indirettamente le scelte del modello tramite esempi o istruzioni parziali, bensì chiede di esporre la propria “visione interna” probabilistica, e da lì campionare più risposte. In termini concettuali, VS trasforma un processo interno implicito (la scelta del max nella distribuzione) in un processo esplicito di campionamento verbale.

In pratica, è come chiedere a un sistema probabilistico di mostrarti tutto ciò che considera plausibile e la relativa probabilità, anziché chiedere direttamente la sua “opinione migliore”.

Nonostante le evidenze promettenti, VS presenta delle problematiche. Un primo ostacolo è che alcuni modelli, specie in setting con filtri di sicurezza o modelli che rilevano istruzioni complesse come potenziali jailbreak, possono rifiutarsi di generare le risposte richieste se il prompt appare troppo “strutturato” o simile a un attacco. I ricercatori consigliano di usare versioni system-level del prompt (istruzioni che fanno parte della “missione” del modello) per migliorarne l’adesione. Se un’istanza rifiuta, suggeriscono di riprogrammare l’istruzione con frasi più semplici e chiare, come “Sei un assistente che per ogni query genera cinque risposte tra tag separate, ciascuna con probabilità < 0,10”.

Un altro limite è che VS può introdurre rumore: se le risposte “secondarie” hanno probabilità molto basse, alcune di esse potrebbero essere incoerenti, contraddittorie o errate. Bisogna regolare con attenzione le soglie, il numero di risposte e potenzialmente filtrare manualmente i risultati. Inoltre, se la complessità del prompt (o l’istruzione VS) induce il modello a “pensare troppo”, potrebbero emergere errori di coerenza o incongruenze tra le risposte.

Infine, è importante ricordare che VS non modifica il modello né ne amplia la conoscenza: semplicemente sfrutta meglio le opzioni già presenti. Se il modello non ha diversità latente (ad esempio su un dominio molto specializzato in cui la probabilità è fortemente concentrata), VS non potrà “creare” risposte che non siano già potenzialmente presenti.

Verbalized Sampling appare come un metodo elegante e pratico per estendere la creatività dei LLM senza necessità di riaddestramento. In scenari reali — chat avanzate, assistenza creativa, generazione di contenuti, simulazioni, data augmentation — potrebbe rapidamente entrare negli strumenti standard di chi utilizza LLM. La sua compatibilità con integrazioni come LangChain è già prevista (c’è un pacchetto Python “verbalized-sampling” che può essere installato via pip) e la libreria fornisce interfacce per regolare k (numero di risposte), la soglia di probabilità e altri parametri. Questo sistema è distribuito con licenza Apache 2.0 su GitHub, con notebook e documentazione.