Una delle frontiere più ambiziose è rendere gli agenti capaci di imparare da sé, ossia senza dipendere da istruzioni umane, ricompense esplicite o lunghe dimostrazioni. È questa la promessa del recente metodo presentato dai laboratori Meta SuperIntelligence Labs (MSL), noto con il nome “Early Experience” (Esperienza Precoce), che punta a colmare il divario tra l’apprendimento per imitazione e il rinforzo autonomo.

L’idea alla base è radicale nella sua semplicità concettuale: piuttosto che imporre un percorso di apprendimento guidato da ricompense esterne (come nell’apprendimento per rinforzo) o costringere l’agente a copiare esempi umani (apprendimento per imitazione), si lascia che l’agente esplori, agisca, raccolga i risultati delle sue azioni e — da questi risultati — tragga segnali utili per affinare le sue politiche. In altre parole, l’autodidatta diventa parte integrante del processo: l’esperienza generata dall’agente stesso diventa materia prima per l’apprendimento.

Questa proposta, dettagliata sotto il titolo Agent Learning via Early Experience, è appena uscita su arXiv e sarà probabilmente un testo di riferimento nelle prossime settimane. I ricercatori riconoscono che il metodo non rimpiazza il rinforzo (RL) quando è applicabile, ma che lo precede: crea una base iniziale più robusta, con una migliore generalizzazione, che rende il successivo RL più efficace.

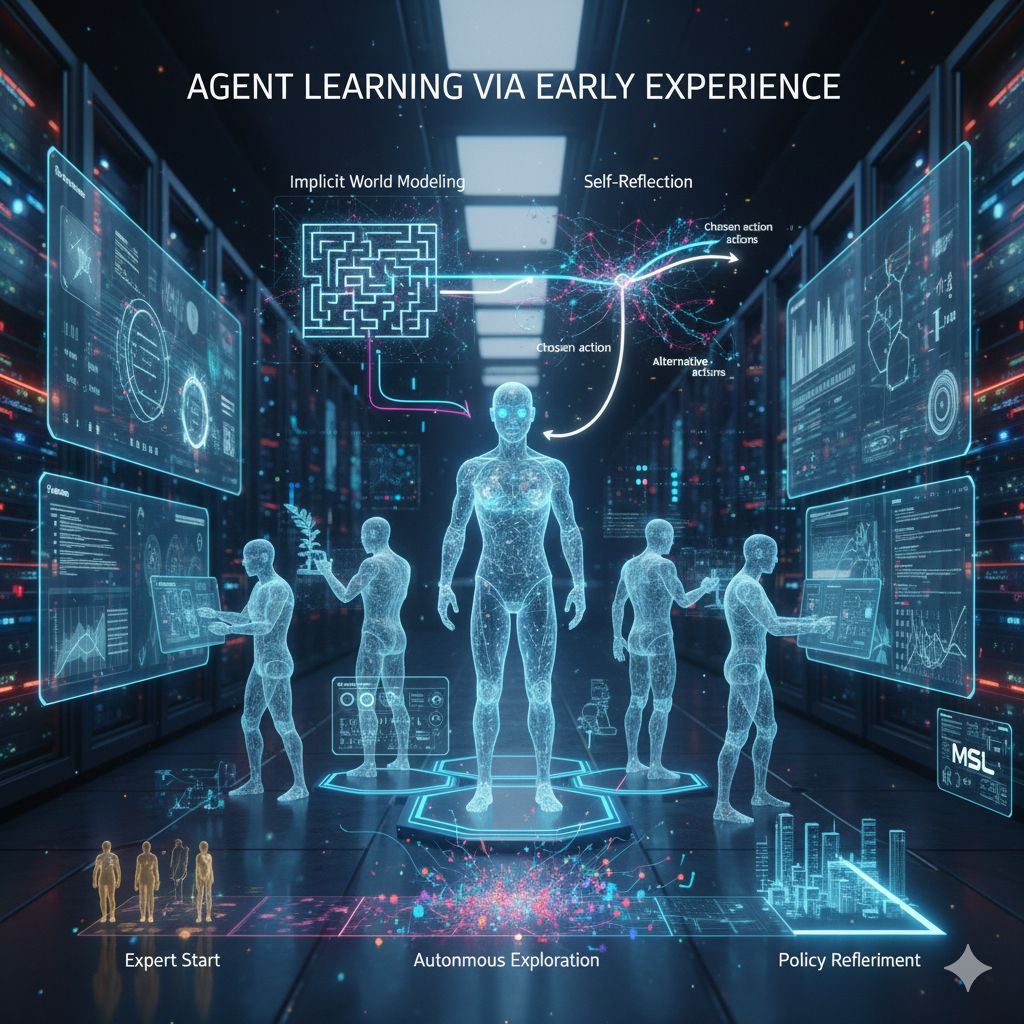

Per trasformare l’esperienza dell’agente in conoscenza utile, i ricercatori adottano due strategie complementari. La prima è l’Implicit World Modeling (IWM). Qui, l’agente utilizza le proprie azioni e gli stati risultanti per apprendere un modello implicito dell’ambiente: dato uno stato e un’azione, prevede quale sarà lo stato successivo. Questo rafforza la sua “comprensione interna” del mondo, riducendo la discrepanza tra ciò che la policy pensa e ciò che effettivamente accade in esecuzione.

La seconda strategia è l’autoriflessione (Self-Reflection, SR): l’agente compara l’azione che ha scelto con l’azione che avrebbe potuto scegliere (magari seguendo un esperto) nello stesso stato, valutando in che misura le azioni alternative avrebbero potuto portare esiti migliori. In questo modo impara non solo cosa fare, ma perché certe azioni sono migliori. Le alternative all’azione scelta forniscono contrappesi che orientano il miglioramento della policy stessa.

Entrambe le tecniche operano con lo stesso costo computazionale e negli stessi ambienti rispetto all’apprendimento per imitazione tradizionale: la differenza è che le dati supervisionati non provengono da esperti umani, ma dall’esperienza raccolta dall’agente in esplorazione. Questa è forse la chiave: la fonte del dato supervisionato non è esterna, ma interna all’agente.

L’approccio di “esperienza precoce” si articola in tre fasi. Nella prima, l’agente parte da uno stato “esperto” (stati identificati tramite dati umani) e sperimenta azioni alternative, raccogliendo stati successivi. Nella seconda, applica IWM per apprendere la transizione dallo stato e azione allo stato successivo. Nella terza fase, applica la Self-Reflection: confronta le azioni esperte con quelle proprie nelle stesse condizioni, orientando la policy verso azioni più efficaci in base ai risultati osservati.

I ricercatori hanno messo alla prova questo approccio su otto ambienti agentici legati al linguaggio, che includono compiti di navigazione web, pianificazione a lungo termine, workflow che integrano chiamate API multiple e attività scientifiche complesse. I risultati mostrano un miglioramento costante rispetto all’apprendimento per imitazione, con un vantaggio medio di +9,6 punti nelle metriche di successo e +9,4 punti nella generalizzazione “fuori dominio” (cioè quando l’agente è testato su situazioni non viste durante l’addestramento).

Un altro dato significativo riguarda l’uso dell’RL: inizializzare l’RL con modelli derivati da Early Experience porta a un tasso di successo migliore fino al 6,4% rispetto all’RL partito da policy imitate tradizionalmente. Ciò suggerisce che l’esperienza precoce non è solo un addestramento alternativo, ma può fungere da ponte efficace verso l’apprendimento per rinforzo.

È interessante notare che, su ambienti specifici, l’agente ha raggiunto prestazioni comparabili (o superiori) all’apprendimento per imitazione impiegando una quantità molto più ridotta di dati dimostrativi umani. Ad esempio, nell’ambiente “WebShop”, ha superato interamente il training derivato dall’apprendimento per imitazione usando soltanto un ottavo dei dati; in “ALF World” ha raggiunto pari prestazioni con metà dei dati dimostrativi.

Questa efficienza della dimostrazione è centrale perché uno dei limiti dell’apprendimento per imitazione è proprio la difficoltà di ottenere una grande quantità di dati esperti ben coperti. Se un agente riesce a “imparare da sé” con pochi esempi umani, si aprono scenari di scalabilità molto più ampi.

Tuttavia, è cruciale riconoscere che l’esperienza precoce non è una forma di RL priva di ricompense nel senso classico: è un metodo supervisionato dove le etichette sono implicite nei risultati dell’esperienza dell’agente. In ambienti in cui le ricompense sono verificabili, l’integrazione con RL rimane una strada potente.

Un potenziale scenario a cui guardare con interesse è quello dei sistemi multimodali o agenti che manipolano ambienti fisici (robotica). Se l’agente può esplorare e recuperare dati sui suoi effetti in ambienti reali, l’esperienza precoce potrebbe diventare un meccanismo potente per autopotenziarsi. Un’altra direzione è combinare esperienza precoce con tecniche meta-learning o apprendimento auto-supervisionato per accelerare l’adattamento a nuovi compiti.