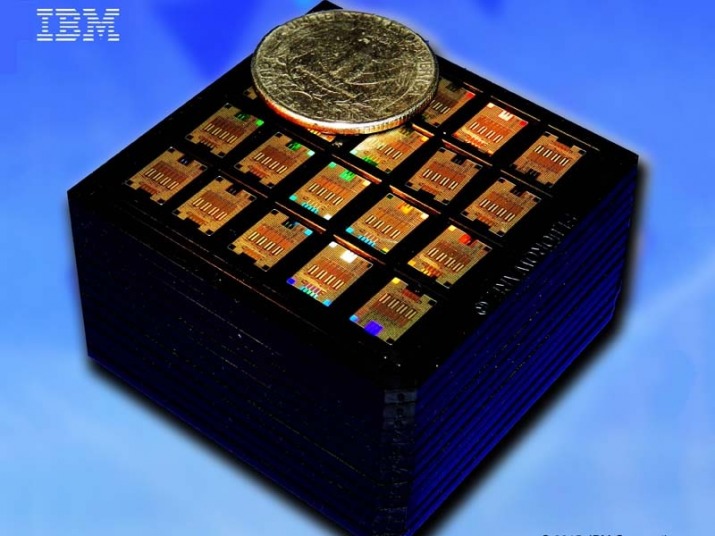

IBM afferma di aver sviluppato uno dei primi chip al mondo ad alta efficienza energetica per l’inferenza e l’addestramento dell’IA costruito con tecnologia a 7 nanometri. In un documento presentato alla conferenza virtuale internazionale sui circuiti a stato solido del 2021 all’inizio di febbraio, un team di ricercatori dell’azienda ha descritto in dettaglio un acceleratore hardware che supporta una gamma di tipi di modelli ottenendo un’efficienza energetica “leader” su tutti loro.

Gli acceleratori di intelligenza artificiale sono un tipo di hardware specializzato progettato per accelerare le applicazioni di intelligenza artificiale, in particolare le reti neurali, il deep learning e il machine learning. Hanno un design multicore e si concentrano su calcoli aritmetici o in memoria a bassa precisione, entrambi i quali possono aumentare le prestazioni di grandi algoritmi di intelligenza artificiale e portare a risultati all’avanguardia nell’elaborazione del linguaggio naturale, visione artificiale e altri domini.

IBM afferma che il suo chip a quattro core, che rimane nelle fasi di ricerca, è ottimizzato per carichi di lavoro a bassa precisione con una serie di diversi modelli di intelligenza artificiale e apprendimento automatico. Le tecniche a bassa precisione richiedono meno spazio e potenza di silicio rispetto alle loro controparti ad alta precisione, consentendo un migliore utilizzo della cache e riducendo i colli di bottiglia della memoria. Ciò porta spesso a una diminuzione del tempo e del costo energetico dell’addestramento dei modelli di IA.

Il chip acceleratore AI di IBM è tra i pochi a incorporare formati ” ibridi FP8 ” a bassissima precisione per l’addestramento di modelli di deep learning in un pacchetto basato su litografia ultravioletta estrema . È anche uno dei primi a presentare la gestione dell’alimentazione, con la capacità di massimizzare le prestazioni rallentando durante le fasi di calcolo con elevato consumo energetico. E offre un utilizzo elevato e prolungato che si traduce apparentemente in prestazioni di applicazioni reali superiori.

Negli esperimenti, IBM afferma che il suo chip AI ha regolarmente raggiunto più dell’80% di utilizzo per la formazione e oltre il 60% di utilizzo per l’inferenza. Inoltre, le prestazioni e l’efficienza energetica del chip superavano quelle di altri chip di inferenza e addestramento dedicati.

L’obiettivo di IBM nei prossimi 2-3 anni è applicare commercialmente il nuovo design del chip AI a una gamma di applicazioni, tra cui formazione su larga scala nel cloud, privacy, sicurezza e veicoli autonomi. “Il nostro nuovo core e chip AI può essere utilizzato per molte nuove applicazioni cloud to edge in più settori”, hanno scritto in un post sul blog i ricercatori IBM Ankur Agrawal e Kailash Gopalakrishnan. “Ad esempio, possono essere utilizzati per l’addestramento sul cloud di modelli di deep learning su larga scala nell’elaborazione della visione, della parola e del linguaggio naturale utilizzando formati a 8 bit (rispetto ai formati a 16 e 32 bit attualmente utilizzati nel settore). Possono anche essere utilizzati per applicazioni di inferenza cloud, come servizi AI da parlato a testo, servizi AI da testo a parlato, servizi di elaborazione del linguaggio naturale,