Cerebras prende l’Hyperscaling in una nuova direzione

Una delle maggiori sfide con l’elaborazione AI è la curva di crescita esponenziale dei set di dati. Mentre i benchmark di machine learning e intelligenza artificiale (ML/AI) possono terminare in minuti o addirittura secondi, i carichi di lavoro di grandi dimensioni possono richiedere ore, giorni o addirittura mesi. Di conseguenza, la capacità di scalare le prestazioni di elaborazione con le dimensioni dei dati sta diventando fondamentale. Per la maggior parte ciò significa aggiungere un altro server con un altro processore AI personalizzato o schede con GPU, FPGA, NPU o qualche altra forma di acceleratore AI. La società di avvio di chip e sistemi AI Cerebras ha adottato un approccio diverso costruendo un enorme processore AI, un wafer completo da 300 mm pieno di core e memoria configurata in un enorme processore per l’esattezza. Ciò ha consentito all’azienda di gestire grandi quantità di dati in modo più rapido ed efficiente rispetto alle configurazioni server tradizionali, ma limita la dimensione del set di dati a ciò che può essere caricato nel processore e nella memoria. Tuttavia, proprio come l’azienda ha superato enormi ostacoli ingegneristici per produrre i chip Cerebras WSE e i sistemi CS, l’azienda ha ora superato i problemi della scalabilità con un approccio innovativo.

Il metodo tradizionale per ridimensionare un carico di lavoro consiste nel suddividere il carico di lavoro complessivo in attività ed eseguire le singole attività o gruppi di attività in parallelo. Questo è efficace ma ha un impatto sulla velocità di esecuzione a causa della tempistica delle attività. Potrebbe essere possibile ottenere una quantità limitata di parallelismo, che potrebbe limitare il carico e l’efficienza complessivi del sistema. Inoltre, il processo di suddivisione del carico di lavoro in attività parallele può essere lungo e si adatterà alle dimensioni del carico di lavoro. Per superare questi problemi, Cerebras ha progettato una soluzione che parallelizza i dati anziché il carico di lavoro. Utilizzando più sistemi CS-2 caricati con lo stesso modello AI e collegati a un’unica soluzione di memoria a larghezza di banda elevata, l’azienda può aumentare le prestazioni di esecuzione di carichi di lavoro ancora più grandi senza lunghi tempi di configurazione e con una scalabilità delle prestazioni quasi lineare. In un certo senso, è una forma di apprendimento federato all’interno di un’unica piattaforma.

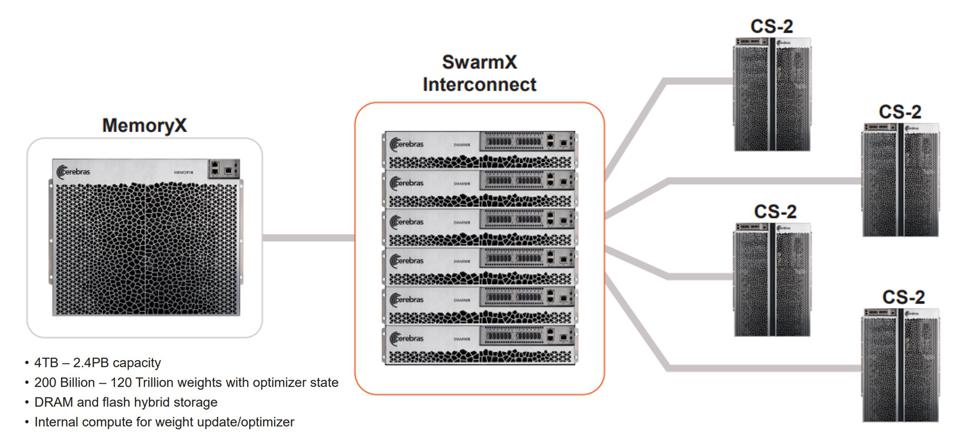

La soluzione prevede l’utilizzo di più sistemi CS-2 collegati tra loro e un nuovo server di memoria chiamato MemoryX tramite un’interconnessione chiamata SwarmX. Il MemoryX può essere configurato con 4 TB fino a 2,4 PB (petabyte) di DRAM combinata e storage ibrido flash ed è completamente indipendente dalla capacità di calcolo dei sistemi CS-2. Lo SwarmX è la salsa segreta nell’equazione. Non solo interconnette CS-2 alla memoria, ma contiene anche nodi di elaborazione ai risultati/gradienti dai sistemi CS-2. L’azienda non sta rivelando molte informazioni sugli elementi di elaborazione o sulle capacità di SwarmX, a parte quelle che possono scalare fino a sistemi di configurazione molto grandi. Attualmente hanno una configurazione che utilizza 32 sistemi CS-2 attivi e funzionanti.

Secondo l’azienda, la configurazione è in grado di fornire un ridimensionamento quasi lineare e, proprio come l’utilizzo di un singolo CS-2, le configurazioni più grandi sono ideali per gestire la scarsità di dati, nonché set di dati estremamente grandi. La società prevede di pubblicare i dati sulle prestazioni entro la fine dell’anno. Tuttavia, il più grande vantaggio è il tempo di installazione. Poiché i dati vengono parallelizzati invece del carico di lavoro, il parallelismo viene eseguito tutto dal compilatore in pochi minuti.

L’unico limite potrebbe essere il costo del sistema. Cerebras ha affermato che il costo del CS-2 è di un paio di milioni e non ha rivelato i prezzi per MemoryX o SwarmX, ma non sarà così economico come aggiungere un server aggiuntivo con alcune schede GPU. Le prestazioni avranno un prezzo. Tuttavia, questo è un prezzo che molti rischiano di pagare. I sistemi Cerebras sono già in uso in una varietà di applicazioni con il governo degli Stati Uniti e nel settore farmaceutico. E, se non altro, devi essere colpito dal livello di innovazione tecnica di Cerebras. Almeno noi di Tirias Research siamo impressionati da Cerebras. L’azienda ha cambiato non solo il modo in cui l’industria pensa all’elaborazione dell’intelligenza artificiale, ma anche il modo in cui pensiamo all’architettura e alla costruzione di server e data center futuri.