Il Mixture of Experts (MoE) è un modello di apprendimento automatico che combina diverse reti neurali o “esperti” per migliorare le prestazioni in compiti complessi. Questo approccio è stato proposto per la prima volta da Michael Jordan e altri nel 1991 ed è stato successivamente sviluppato e applicato in vari contesti.

Il MoE funziona suddividendo un problema complesso in sotto-problemi più semplici e affidando ognuno di questi sotto-problemi a un “esperto”. Ogni esperto è una rete neurale specializzata che è addestrata per risolvere specifiche porzioni del problema generale. Gli esperti possono essere reti neurali semplici o complesse, a seconda delle esigenze del compito.

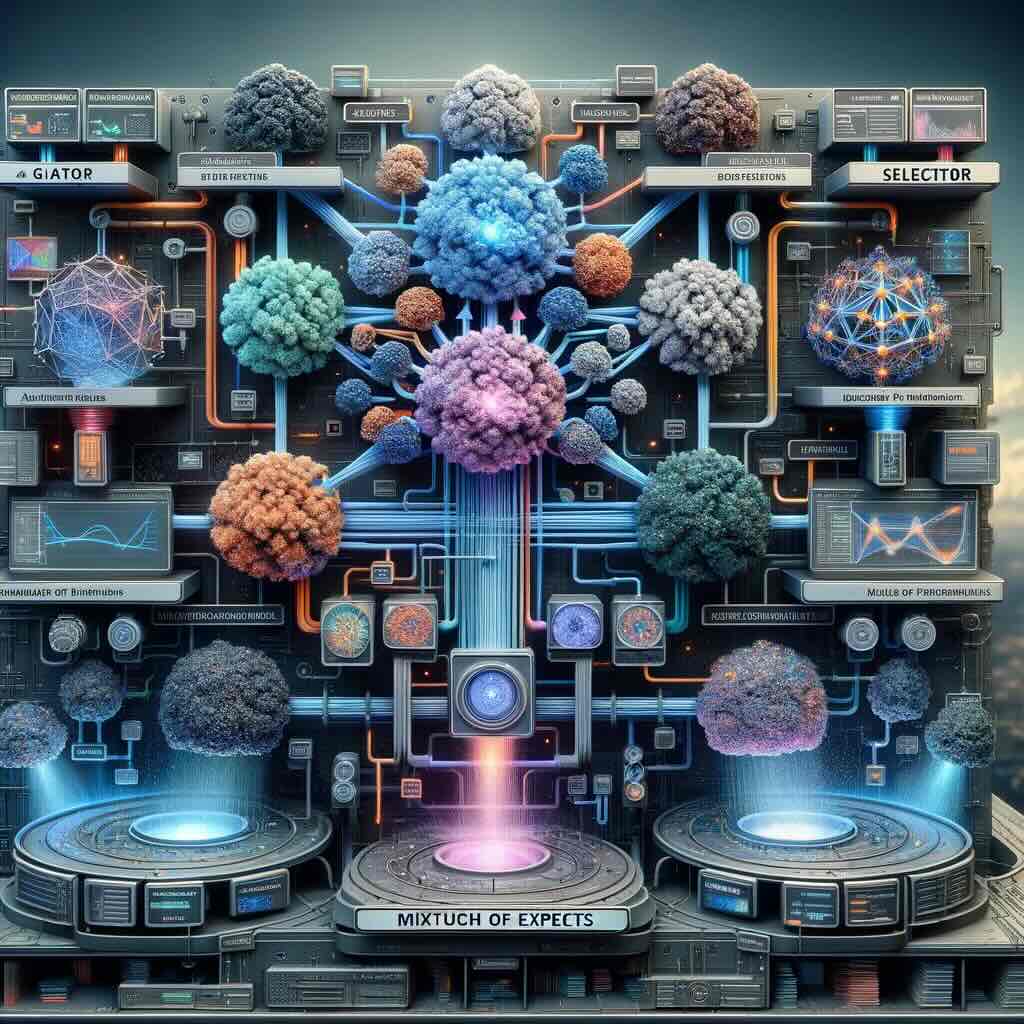

La chiave del MoE è l’uso di un “gate”, spesso chiamato “selettore”, che determina quale esperto dovrebbe essere utilizzato per una determinata istanza o input. Il selettore è un’altra rete neurale o meccanismo che valuta l’input e decide quale esperto dovrebbe essere attivato in base a questa valutazione. Quindi, il selettore controlla come le uscite degli esperti vengono combinate per produrre l’output finale del modello.

Il MoE può essere utilizzato in vari contesti, ad esempio nell’elaborazione del linguaggio naturale (NLP), nella visione artificiale, nella raccomandazione di contenuti e in molti altri. È particolarmente utile quando il compito è complesso e può beneficiare dell’approccio di decomposizione in sotto-problemi gestibili e specializzati.

In sintesi, il MoE è un approccio di apprendimento automatico che sfrutta l’abilità di diverse reti neurali specializzate (esperti) e un meccanismo di selezione (selettore) per combinare le loro uscite e migliorare le prestazioni complessive su compiti complessi.

L’era dei modelli Mixture of Experts (MoE) in GPT-4

La comunità AI ha visto un cambiamento significativo verso l’implementazione dei modelli Mixture of Experts (MoE), un concetto particolarmente pertinente all’architettura GPT-4 di OpenAI. Questo cambiamento rappresenta un’evoluzione cruciale nella progettazione di modelli linguistici di grandi dimensioni (LLM), affrontando alcuni dei limiti e delle inefficienze intrinseche delle architetture precedenti.

Comprendere il concetto del MoE

L’architettura del MoE introduce un cambiamento di paradigma nel modo in cui le reti neurali sono strutturate e gestite. Tradizionalmente, modelli come GPT-3 erano densi, il che significa che ogni parte della rete neurale era impegnata nell’elaborazione di ogni informazione. Sebbene efficace, questo approccio era intensivo dal punto di vista computazionale e meno efficiente, soprattutto con l’aumento delle dimensioni del modello.

Immagine estratta dal video di DotCSV. https://www.youtube.com/watch?v=Sfnu5OmAITA

I modelli MoE, tuttavia, adottano una strategia diversa. Invece di utilizzare un’unica rete densa, il MoE divide il modello in diversi sottomodelli o “esperti”, ciascuno specializzato in diversi compiti o aspetti dell’elaborazione dei dati. Questa struttura consente un calcolo più mirato ed efficiente, poiché solo gli esperti pertinenti vengono attivati in base alla natura dell’input.

Implementazione del MoE da parte di GPT-4

Sebbene OpenAI non abbia confermato ufficialmente le specifiche, esistono ipotesi credibili secondo cui GPT-4 utilizza un’architettura MoE. Questa ipotesi è supportata da varie fughe di notizie e analisi del settore, che suggeriscono che GPT-4 potrebbe rappresentare un allontanamento significativo dalla densa architettura del modello dei suoi predecessori.

Se GPT-4 fosse effettivamente basato su un framework MoE, potrebbe rappresentare un punto di svolta in termini di efficienza e capacità. Si ipotizza che il modello abbia un vasto numero di parametri, forse nell’ordine dei trilioni, distribuiti su più moduli esperti. Ciascun modulo, con il suo focus specialistico, potrebbe gestire tipi specifici di attività in modo più efficace rispetto a un modello denso di dimensioni comparabili.

Questa struttura non solo migliorerebbe le prestazioni complessive del modello, ma lo renderebbe anche più efficiente in termini di risorse. Attivando solo parti rilevanti della rete per compiti specifici, GPT-4 potrebbe potenzialmente fornire prestazioni IA di alto livello con un sovraccarico computazionale ridotto.

Implicazioni del MoE nello sviluppo dell’intelligenza artificiale

L’adozione di modelli MoE come GPT-4 segna una pietra miliare significativa nello sviluppo dell’IA. Affronta il dilemma dell’ampliamento dei modelli di intelligenza artificiale, bilanciando la necessità di sistemi più estesi e più capaci con i limiti pratici delle risorse computazionali e dell’efficienza.

Inoltre, i modelli MoE aprono nuove strade per la ricerca e l’applicazione dell’IA. Offrono un modo per costruire sistemi di intelligenza artificiale più sofisticati e versatili in grado di adattarsi in modo più dinamico a un’ampia gamma di attività. Questa flessibilità è fondamentale poiché l’intelligenza artificiale continua a permeare diversi settori e applicazioni.