Il servizio che utilizza l’IA per identificare il genere in base ai nomi sembra incredibilmente distorto

Meghan Smith è una donna, ma il dottor Meghan Smith è un uomo, dice Genderify

Alcune aziende tecnologiche fanno un salto quando lanciano, altre sembrano far saltare se stesse.

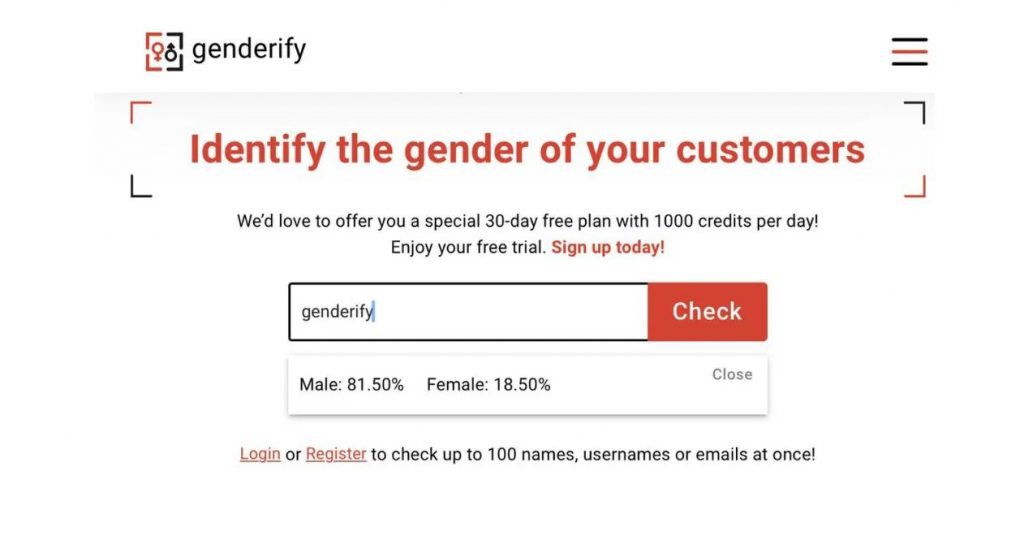

Genderify , un nuovo servizio che ha promesso di identificare il genere di qualcuno analizzando il loro nome, indirizzo e-mail o nome utente con l’aiuto AI, sembra fermamente essere in quest’ultimo campo. La società ha lanciato Product Hunt la scorsa settimana, ma ha attirato molta attenzione sui social media quando gli utenti hanno scoperto errori e imprecisioni nei suoi algoritmi.

Digita il nome “Meghan Smith” in Genderify, ad esempio, e il servizio offre la valutazione: “Uomo: 39,60%, Donna: 60,40%”. Cambia quel nome in “Dr. Meghan Smith “, tuttavia, e la valutazione passa a:” Maschio: 75,90%, femmina: 24,10% “. Altri nomi con il prefisso “Dr” producono risultati simili mentre gli input sembrano generalmente distorcere il maschio. “Test@test.com” si dice che sia maschio al 96,90 per cento , mentre “Mrs Joan smith” è maschio al 94,10% .

La protesta contro il servizio è stata così grande che Genderify dice a The Verge che si sta chiudendo del tutto. “Se la comunità non lo vuole, forse è stato giusto”, ha detto un rappresentante via e-mail. Genderify.com è stato messo offline e la sua API gratuita non è più accessibile.

Sebbene questo tipo di pregiudizi compaia regolarmente nei sistemi di apprendimento automatico, la sconsideratezza di Genderify sembra aver sorpreso molti esperti del settore. La risposta di Meredith Whittaker, co-fondatrice dell’AI Now Institute, che studia l’impatto dell’IA sulla società, era in qualche modo tipica. “Siamo stati trollati?” lei chiese. “È uno psyop pensato per distrarre il mondo della tecnologia + giustizia? È già il giorno del pesce d’aprile?

FARE IPOTESI SUL GENERE DELLE PERSONE SU VASTA SCALA POTREBBE ESSERE DANNOSO

Il problema non è che Genderify abbia formulato ipotesi sul genere di qualcuno in base al loro nome. Le persone lo fanno sempre, e talvolta commettono errori nel processo. Ecco perché è educato scoprire come le persone si identificano da sole e come vogliono essere affrontate. Il problema con Genderify è che ha automatizzato questi presupposti; applicandoli su larga scala mentre ordinano gli individui in un binario maschio / femmina (e quindi ignorando gli individui che si identificano come non binari) rafforzando nel contempo gli stereotipi di genere nel processo (come: se sei un medico, probabilmente sei un uomo).

Il potenziale danno di ciò dipende da come e dove Genderify è stato applicato. Se il servizio è stato integrato in un chatbot medico, ad esempio, i suoi presupposti sui sessi degli utenti potrebbero aver portato il chatbot a fornire consigli medici fuorvianti.

Per fortuna, Genderify non sembrava mirare ad automatizzare questo tipo di sistema, ma era principalmente progettato per essere uno strumento di marketing. Come creatore di Genderify, Arevik Gasparyan, ha dichiarato su Product Hunt: “Genderify può ottenere dati che ti aiuteranno con l’analisi, il miglioramento dei dati dei clienti, la segmentazione del database di marketing, le statistiche demografiche, ecc.”

Nella stessa sezione dei commenti, Gasparyan ha riconosciuto le preoccupazioni di alcuni utenti riguardo ai pregiudizi e all’ignorare individui non binari, ma non ha fornito risposte concrete.

Un utente ha chiesto: “Diciamo che scelgo di identificare né maschio né femmina, come ti avvicini a questo? Come evitare la discriminazione di genere? Come affronti il pregiudizio di genere? ” A cui Gasparyan ha risposto che il servizio prende le sue decisioni sulla base di “database binari di nome / genere già esistenti” e che la società “stava attivamente cercando modi per migliorare l’esperienza dei visitatori transgender e non binari” “separando i concetti di nome / nome utente / email dall’identità di genere. ” È una risposta confusa dato che l’intera premessa di Genderify è che questi dati sono un proxy affidabile per l’identità di genere.

La società ha detto a The Verge che il servizio era molto simile alle società esistenti che usano database di nomi per indovinare il genere di un individuo, sebbene nessuno di loro usi l’IA.

“Comprendiamo che il nostro modello non fornirà mai risultati ideali e che l’algoritmo necessita di miglioramenti significativi, ma il nostro obiettivo era quello di costruire un’intelligenza artificiale di autoapprendimento che non fosse distorta come qualsiasi soluzione esistente”, ha affermato un rappresentante via e-mail. “E per farlo funzionare, abbiamo fatto molto affidamento sul feedback dei visitatori transgender e non binari per aiutarci a migliorare al meglio i nostri algoritmi di rilevamento di genere per la comunità LGBTQ +.”