Il “linguaggio senza senso” che potrebbe sovvertire i sistemi di moderazione della sintesi delle immagini

Una nuova ricerca della Columbia University suggerisce che le salvaguardie che impediscono ai modelli di sintesi delle immagini come DALL-E 2, Imagen e Parti di produrre immagini dannose o controverse sono suscettibili a una sorta di attacco contraddittorio che coinvolge parole “inventate”.

L’autore ha sviluppato due approcci che possono potenzialmente ignorare le misure di moderazione del contenuto in un sistema di sintesi delle immagini e ha scoperto che sono notevolmente robusti anche in diverse architetture, indicando che la debolezza è più che solo sistemica e potrebbe incidere su alcuni dei principio fondamentale della sintesi da testo a immagine.

Il primo, e il più forte dei due, è chiamato suggerimento macaron . Il termine ‘macaron’ originariamente si riferisce a una miscela di più lingue, come si trova in esperanto o unwinese . Forse l’esempio culturalmente più diffuso sarebbe l’ urdu-inglese , un tipo di “combinazione di codice” comune in Pakistan, che mescola abbastanza liberamente sostantivi inglesi e suffissi in urdu.

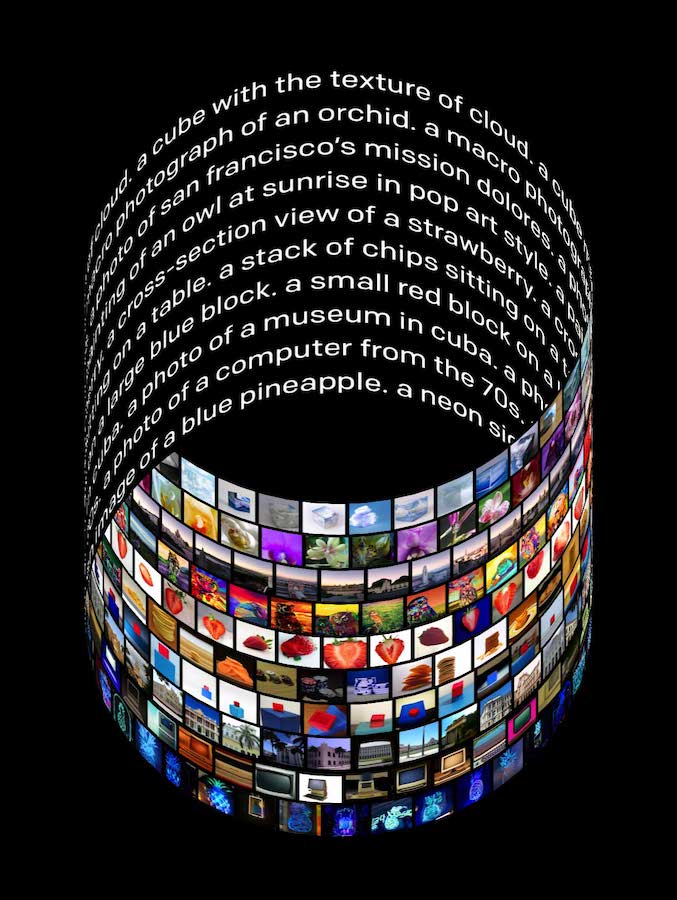

Suggerimento maccheroni compositivo in DALL-E 2. Fonte: https://arxiv.org/pdf/2208.04135.pdf

In alcuni degli esempi precedenti, frazioni di parole significative sono state incollate insieme, usando l’inglese come ‘scaffold’. Altri esempi nel documento utilizzano più lingue in un unico prompt.

Il sistema risponderà in modo semanticamente significativo a causa della relativa mancanza di cura nelle fonti web su cui il sistema è stato addestrato. Tali fonti molto spesso saranno arrivate complete di etichette multilingue (cioè da dataset non specificamente progettati per un’attività di sintesi di immagini), e ogni parola ingerita, in qualunque lingua, diventerà un ‘token’; ma allo stesso modo parti di quelle parole diventeranno “sottoparole” o token frazionari. In Natural Language Processing (NLP), questo tipo di “stemming” aiuta a distinguere l’etimologia di parole derivate più lunghe che possono sorgere nelle operazioni di trasformazione, ma crea anche un enorme “set Lego” lessicale che può sfruttare i suggerimenti “creativi”.

Le parole portmanteau monolingui sono efficaci anche per ottenere immagini attraverso un linguaggio indiretto o non prosaico, con risultati molto simili spesso ottenibili su architetture diverse, come DALL-E 2 e DALL-E Mini (Craiyon).

Nel secondo tipo di approccio, chiamato suggerimento evocativo , alcune delle parole congiunte hanno un tono simile al filone più giovanile di “latino da scolaro” dimostrato in Monty Python’s Life of Brian (1979).

Non è uno scherzo: il finto latino spesso riesce a far emergere una risposta significativa da DALL-E 2.

L’autore afferma:

“Una preoccupazione ovvia con questo metodo è l’elusione dei filtri dei contenuti basati su prompt nella lista nera. In linea di principio, i suggerimenti maccheroni potrebbero fornire un modo semplice e apparentemente affidabile per aggirare tali filtri al fine di generare contenuti dannosi, offensivi, illegali o altrimenti sensibili, comprese immagini violente, odiose, razziste, sessiste o pornografiche e forse immagini che violano proprietà intellettuale o raffiguranti individui reali.

‘Le aziende che offrono la generazione di immagini come servizio hanno prestato molta attenzione nel prevenire la generazione di tali output in conformità con la loro politica sui contenuti. Di conseguenza, la richiesta di maccheroni dovrebbe essere sistematicamente studiata come una minaccia ai protocolli di sicurezza utilizzati per la generazione di immagini commerciali.’

L’autore suggerisce una serie di rimedi contro questa vulnerabilità, alcuni dei quali ammette potrebbero essere considerati eccessivamente restrittivi.

La prima soluzione possibile è la più costosa: curare le immagini di addestramento della sorgente in modo più accurato, con una supervisione più umana e meno algoritmica. Tuttavia, l’articolo ammette che ciò non impedirebbe al sistema di sintesi delle immagini di creare una congiunzione offensiva tra due concetti di immagine che sono di per sé potenzialmente innocui.

In secondo luogo, il documento suggerisce che i sistemi di sintesi delle immagini potrebbero eseguire il loro output effettivo attraverso un sistema di filtri, intercettando eventuali associazioni problematiche prima che vengano fornite all’utente. È possibile che DALL-E 2 attualmente utilizzi tale filtro, sebbene OpenAI non abbia rivelato esattamente come funziona la moderazione dei contenuti di DALL-E 2.

Infine, l’autore considera la possibilità di una “lista bianca del dizionario”, che consentirebbe solo a parole controllate e approvate di recuperare e rendere i concetti, ma ammette che ciò potrebbe rappresentare una restrizione eccessivamente severa sull’utilità del sistema.

Sebbene il ricercatore abbia sperimentato solo cinque lingue (inglese, tedesco, francese, spagnolo e italiano) nella creazione di assemblee rapide, ritiene che questo tipo di “attacco contraddittorio” potrebbe diventare ancora più “criptico” e difficile da scoraggiare estendendo il numero di lingue, dato che i modelli iperscalabili come DALL-E 2 sono addestrati su più linguaggi (semplicemente perché è più facile usare input leggermente filtrati o “grezzi” piuttosto che considerare l’enorme spesa per curarli, e perché è probabile che la dimensionalità extra per aumentare l’utilità del sistema).

Il documento si intitola Adversarial Attacks on Image Generation With Made-Up Words e proviene da Raphaël Millière alla Columbia University.

Linguaggio criptico in DALL-E 2

In precedenza è stato suggerito che le parole senza senso che DALL-E 2 emette ogni volta che tenta di rappresentare il linguaggio scritto potrebbe essere di per sé un “vocabolario nascosto” . Tuttavia, la precedente ricerca su questo misterioso linguaggio non ha offerto alcun modo per sviluppare stringhe nonce che possano evocare immagini specifiche.

Del lavoro precedente , il documento afferma:

‘[It] non offre un metodo affidabile per trovare stringhe nonce che suscitano immagini specifiche. La maggior parte del testo incomprensibile incluso da DALL-E 2 nelle immagini non sembra essere associato in modo affidabile a concetti visivi specifici quando trascritto e utilizzato come prompt. Ciò limita la fattibilità di questo approccio come modo per aggirare la moderazione di contenuti dannosi o offensivi; in quanto tale, non è un rischio particolarmente preoccupante per l’uso improprio dei modelli di generazione di immagini guidate dal testo.’

Invece, i due metodi dell’autore sono elaborati come mezzi attraverso i quali le sciocchezze possono evocare immagini correlate e significative mentre aggirano l’etichetta convenzionale che ora si sta sviluppando in una pronta ingegneria .

A titolo di esempio, l’autore considera la parola per ‘uccelli’ nelle cinque lingue che rientrano nell’ambito del lavoro: Vögel in tedesco, uccelli in italiano, oiseaux in francese e pájaros in spagnolo.

Con la tokenizzazione BPE ( byte-pair encoding ) utilizzata dall’implementazione di CLIP integrata in DALL-E 2 , le parole vengono tokenizzate in un inglese non accentato e possono essere “combinate in modo creativo” per formare parole nonce che sembrano incomprensibili per noi, ma conservano il loro significato incollato per DALL-E 2, consentendo al sistema di esprimere l’intento percepito:

Nell’esempio sopra, due delle parole “straniere” per uccello sono incollate insieme in una stringa senza senso. Grazie al peso frazionario delle sottoparole, il significato viene mantenuto.

L’autore sottolinea che è possibile ottenere risultati significativi anche senza aderire ai confini della segmentazione delle sottoparole, presumibilmente perché DALL-E 2 (lo studio principale dell’articolo) si è generalizzato abbastanza bene da lasciare che i confini delle sottoparole si offuschino senza distruggerne significato.

Per dimostrare ulteriormente gli approcci sviluppati, il documento offre esempi di suggerimenti maccheroni in diversi domini, utilizzando l’elenco di parole simboliche illustrato di seguito (con parole ibridate senza senso all’estrema destra).

L’autore afferma che i seguenti esempi di DALL-E 2 non sono “scelti a piacimento”:

Lingua franca

Il documento osserva inoltre che molti di questi esempi funzionano ugualmente bene, o almeno in modo molto simile, sia su DALL-E 2 che su DALL-E Mini (ora Craiyon ), e che questo è sorprendente, poiché DALL-E 2 è un modello di diffusione e DALL-E Mini non lo è; i due sistemi sono addestrati su dataset differenti; e DALL-E Mini utilizza un tokenizer BART invece del tokenizer CLIP preferito da DALL-E 2.

Risultati notevolmente simili di DALL-E Mini, rispetto all’immagine precedente, che presentava i risultati dello stesso input “nonsense” di DALL-E 2.

Come si vede nella prima delle immagini sopra, i suggerimenti maccheroni possono anche essere assemblati in frasi sintatticamente sonore per generare scene più complesse. Tuttavia, ciò richiede l’uso dell’inglese come “impalcatura” per assemblare i concetti, rendendo più probabile che la procedura venga intercettata dai sistemi di censura standard in un quadro di sintesi delle immagini.

L’articolo osserva che l’ibridazione lessicale, l'”incollare insieme” di parole per ottenere contenuti correlati da un sistema di sintesi di immagini, può essere realizzata anche in un’unica lingua, mediante l’uso di parole portmanteau .

Suggestivo richiamo

L’approccio “suggerimento evocativo” descritto nel documento dipende dall'”evocare” una risposta più ampia dal sistema con parole che non sono strettamente basate su sottoparole o sotto-token o etichette parzialmente condivise.

Un tipo di suggestione evocativa è la pseudolatina, che può, tra gli altri usi, generare immagini di farmaci fittizi, anche senza alcuna specificazione che DALL-E 2 dovrebbe recuperare il concetto di “medicina”:

I suggerimenti evocativi funzionano particolarmente bene anche con suggerimenti senza senso che si riferiscono ampiamente a possibili posizioni geografiche e funzionano in modo abbastanza affidabile tra le diverse architetture di DALL-E 2 e DALL-E Mini:

Le parole usate per questi suggerimenti per DALL-E 2 e DALL-E Mini ricordano nomi reali, ma sono di per sé una totale sciocchezza. Tuttavia, i sistemi hanno “raccolto l’atmosfera” delle parole.

Sembra esserci un incrocio tra suggestioni maccheroni ed evocative. Il documento afferma:

“Sembra che le differenze nei dati di addestramento, nella dimensione del modello e nell’architettura del modello possano far sì che modelli diversi analizzino prompt come voiscellpajaraux e eidelucertlagarzard in modo “maccheronico” o “evocativo”, anche quando è dimostrato che questi modelli rispondono a entrambi i metodi di prompt .’

Il documento conclude:

“Sebbene varie proprietà di questi modelli, tra cui dimensioni, architettura, tokenizzazione [procedura] e dati di addestramento, possano influenzare la loro vulnerabilità agli attacchi del contraddittorio basati su testo, le prove preliminari discusse in questo lavoro suggeriscono che alcuni di questi attacchi potrebbero comunque funzionare in modo piuttosto affidabile su Modelli.’

Probabilmente il più grande ostacolo alla vera sperimentazione su questi metodi è il rischio di essere segnalato e bandito dal sistema host. DALL-E 2 richiede un numero di telefono associato per ogni account utente, limitando il numero di “account masterizzatori” che sarebbero probabilmente necessari per testare veramente i confini di questo tipo di hacking lessicale, in termini di sovvertimento dei metodi di moderazione esistenti. Attualmente, la protezione principale di DALL-E 2 rimane la volatilità dell’accesso.

Martin Anderson da Unite.ai