Un nuovo strumento software – Fawkes – maschera le tue immagini per ingannare gli algoritmi di riconoscimento facciale

Concetto di riconoscimento facciale

L’uso di sistemi di riconoscimento facciale da parte di grandi aziende ha gravi conseguenze per la privacy personale. Fawkes, uno strumento gratuito degli scienziati informatici di UChicago, è un modo per reagire.

Un nuovo strumento per proteggersi dal software di riconoscimento facciale progettato dai ricercatori dell’Università di Chicago .

Il rapido aumento dei sistemi di riconoscimento facciale ha inserito la tecnologia in molti aspetti della nostra vita quotidiana, che lo sappiamo o meno. Ciò che potrebbe sembrare innocuo quando Facebook identifica un amico in una foto caricata diventa più minaccioso in aziende come Clearview AI, una società privata che ha addestrato il suo sistema di riconoscimento facciale su miliardi di immagini raschiate senza consenso dai social media e da Internet.

Ma finora, le persone hanno avuto poche protezioni contro questo uso delle loro immagini, a parte non condividere le foto pubblicamente.

Un nuovo progetto di ricerca del Dipartimento di Informatica dell’Università di Chicago fornisce un nuovo potente meccanismo di protezione. Chiamato Fawkes, lo strumento software “maschera” le foto per ingannare i modelli di computer di apprendimento profondo che potenziano il riconoscimento facciale, senza cambiamenti evidenti visibili all’occhio umano. Con un numero sufficiente di foto occultate in circolazione, un osservatore del computer non sarà in grado di identificare una persona nemmeno da un’immagine inalterata, proteggendo la privacy individuale da intrusioni non autorizzate e dannose. Lo strumento è destinato all’uso non autorizzato di immagini personali e non ha alcun effetto sui modelli costruiti utilizzando immagini ottenute legittimamente, come quelle utilizzate dalle forze dell’ordine.

“Si tratta di offrire alle persone la possibilità di agire”, ha detto Emily Wenger, studentessa di dottorato del terzo anno e co-leader del progetto con lo studente di dottorato del primo anno Shawn Shan. “Non ci illudiamo che questo risolverà tutte le violazioni della privacy e probabilmente ci sono soluzioni sia tecniche che legali per aiutare a respingere l’abuso di questa tecnologia. Ma lo scopo di Fawkes è fornire alle persone il potere di reagire a se stesse, perché in questo momento non esiste niente del genere “.

“Lo scopo di Fawkes è fornire alle persone il potere di reagire a se stesse, perché in questo momento non esiste niente del genere.”

—Studente di dottorato Emily Wenger

La tecnica si basa sul fatto che le macchine “vedono” le immagini in modo diverso dagli umani. Per un modello di apprendimento automatico, le immagini sono semplicemente numeri che rappresentano ogni pixel, che i sistemi noti come reti neurali organizzano matematicamente in caratteristiche che usano per distinguere tra oggetti o individui. Quando vengono alimentati con un numero sufficiente di foto diverse di una persona, questi modelli possono utilizzare queste caratteristiche uniche per identificare la persona in nuove foto, una tecnica utilizzata per i sistemi di sicurezza, gli smartphone e, sempre di più, le forze dell’ordine, la pubblicità e altre applicazioni controverse.

Con Fawkes, che prende il nome dalla maschera di Guy Fawkes usata dai rivoluzionari nella graphic novel V per Vendetta, Wenger e Shan con i collaboratori Jiayun Zhang, Huiying Li e i professori di UChicago Ben Zhao e Heather Zheng sfruttano questa differenza tra percezione umana e computer per proteggere la privacy . Modificando una piccola percentuale dei pixel per alterare drasticamente il modo in cui la persona viene percepita dall ‘”occhio” del computer, l’approccio inquina il modello di riconoscimento facciale, in modo tale da etichettare le foto reali dell’utente con l’identità di qualcun altro. Ma per un osservatore umano, l’immagine appare invariata.

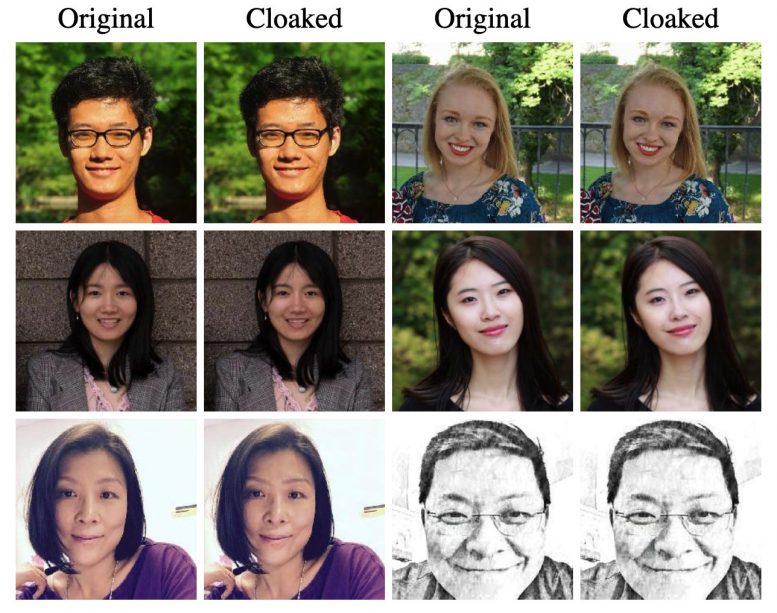

Immagini mascherate per bloccare il riconoscimento facciale

I colpi alla testa originali e mascherati degli autori dello studio dimostrano come le modifiche introdotte da Fawkes siano invisibili agli spettatori umani mentre interrompono il software di riconoscimento facciale. Credito: immagine per gentile concessione del SAND Lab di UChicago

In un documento che sarà presentato al simposio sulla sicurezza USENIX il mese prossimo, i ricercatori hanno scoperto che il metodo era quasi efficace al 100% nel bloccare il riconoscimento da parte di modelli all’avanguardia di Amazon, Microsoft e altre società. Sebbene non possa interrompere i modelli esistenti già addestrati su immagini inalterate scaricate da Internet, la pubblicazione di immagini occultate può eventualmente cancellare l ‘”impronta” online di una persona, hanno detto gli autori, rendendo i modelli futuri incapaci di riconoscere quell’individuo.

“In molti casi, non controlliamo tutte le immagini di noi stessi online; alcuni potrebbero essere pubblicati da una fonte pubblica o pubblicati dai nostri amici “, ha detto Shan. “In questo scenario, Fawkes ha successo quando il numero di immagini occultate supera quello delle immagini non occultate. Quindi, per gli utenti che hanno già molte immagini online, un modo per migliorare la loro protezione è pubblicare ancora più immagini di se stessi, tutte mascherate, per bilanciare il rapporto. “

All’inizio di agosto, Fawkes è apparso sul New York Times . Tuttavia, i ricercatori hanno chiarito alcuni punti del pezzo. Al 3 agosto, lo strumento aveva accumulato quasi 100.000 download e il team aveva aggiornato il software per evitare le distorsioni significative descritte dall’articolo, in parte dovute ad alcuni campioni anomali in un set di dati pubblico.

Zhao ha anche risposto all’affermazione del CEO di Clearview Hoan Ton-That’s secondo cui era troppo tardi perché una tecnologia del genere fosse efficace, dati i miliardi di immagini che l’azienda aveva già raccolto, e che la società avrebbe potuto utilizzare Fawkes per migliorare la capacità del suo modello di decifrare immagini alterate.

“Fawkes si basa su un attacco avvelenato”, ha detto Zhao. “Ciò che il CEO di Clearview ha suggerito è simile all’addestramento avversario, che non funziona contro un attacco di avvelenamento. Addestrare il suo modello su immagini occultate corromperà il modello, perché il suo modello non saprà quali foto sono occultate per ogni singolo utente, tanto meno le centinaia di milioni a cui mirano.

“Per quanto riguarda i miliardi di immagini già online, queste foto sono diffuse tra molti milioni di utenti. Le foto di altre persone non influiscono sull’efficacia del tuo mantello, quindi il numero totale di immagini è irrilevante. Nel tempo, le tue immagini occultate supereranno in numero le immagini più vecchie e il cloaking avrà l’effetto desiderato. “

Per utilizzare Fawkes, gli utenti applicano semplicemente il software di cloaking alle foto prima di pubblicarle su un sito pubblico. Attualmente, lo strumento è gratuito e disponibile sul sito Web del progetto per gli utenti che hanno familiarità con l’utilizzo dell’interfaccia della riga di comando sul proprio computer. Il team lo ha anche reso disponibile come software per sistemi operativi Mac e PC e spera che le piattaforme di condivisione di foto o social media possano offrirlo come opzione ai propri utenti.

“Fondamentalmente ripristina la barra per la sorveglianza di massa … Uniforma il campo di gioco solo un po ‘.”

-Prof. Ben Zhao

“Fondamentalmente ripristina la barra per la sorveglianza di massa ai giorni del modello di riconoscimento facciale pre-deep learning. Uniforma un po ‘il campo di gioco, per evitare che aziende ricche di risorse come Clearview interrompano davvero le cose “, ha affermato Zhao, professore di informatica a Neubauer ed esperto di sicurezza dell’apprendimento automatico. “Se questo viene integrato nel più ampio ecosistema di social media o Internet, potrebbe davvero essere uno strumento efficace per iniziare a respingere questo tipo di algoritmi intrusivi”.

Dato l’ampio mercato del software di riconoscimento facciale, il team si aspetta che gli sviluppatori di modelli cercheranno di adattarsi alle protezioni di cloaking fornite da Fawkes. Ma a lungo termine, la strategia offre la promessa come ostacolo tecnico per rendere il riconoscimento facciale più difficile e costoso per le aziende da eseguire efficacemente senza il consenso dell’utente, rimettendo la scelta di partecipare nelle mani del pubblico.

“Penso che potrebbero esserci contromisure a breve termine, in cui le persone escogitano piccole cose per rompere questo approccio”, ha detto Zhao. “Ma a lungo termine, credo che strumenti di modifica delle immagini come Fawkes continueranno ad avere un ruolo significativo nel proteggerci da sistemi di apprendimento automatico sempre più potenti”.