I ricercatori creano ologrammi 3D in tempo reale basati sull’intelligenza artificiale sugli smartphone

Gli smartphone potrebbero presto essere in grado di generare ologrammi 3D fotorealistici, grazie in parte a un modello AI sviluppato dai ricercatori del MIT . Il sistema AI sviluppato dal team del MIT determina il modo migliore per generare ologrammi da una serie di immagini di input.

I ricercatori del MIT hanno recentemente progettato modelli di intelligenza artificiale che consentono la generazione di ologrammi 3D fotorealistici. La tecnologia potrebbe avere applicazioni per cuffie VR e AR e gli ologrammi possono anche essere generati da uno smartphone.

A differenza dei tradizionali display 3D e VR, che producono semplicemente l’illusione della profondità e che possono causare nausea e mal di testa, i display olografici possono essere visti dalle persone senza affaticare gli occhi. Un importante ostacolo alla creazione di supporti olografici è la gestione dei dati necessari per generare effettivamente l’olografo. Ogni ologramma è composto da un’enorme quantità di dati, necessari per creare la “profondità” dell’ologramma. Per questo motivo, la generazione di dati olografici richiede in genere un’enorme quantità di potenza di calcolo. Per rendere la tecnologia olografica più pratica, il team del MIT ha applicato reti neurali convoluzionali profonde al problema, creando una rete in grado di generare rapidamente ologrammi basati su immagini di input.

L’approccio tipico per la generazione di ologrammi generava essenzialmente molti blocchi di ologrammi e quindi utilizzava simulazioni fisiche per combinare i blocchi in una rappresentazione completa di un oggetto o di un’immagine. Ciò differisce dall’approccio tipico utilizzato per generare ologrammi. Nel metodo tradizionale, le immagini vengono separate e una serie di tabelle di ricerca viene utilizzata per unire i blocchi di ologramma, poiché le tabelle di ricerca segnano i confini dei diversi blocchi di ologramma. Il processo di definizione dei confini dei blocchi olografici con le tabelle di visualizzazione è piuttosto dispendioso in termini di tempo e di elaborazione.

Secondo IEEE Spectrum , il team del MIT ha progettato un altro metodo per generare ologrammi. Sfruttando la potenza delle reti di apprendimento profondo , sono stati in grado di suddividere le immagini in blocchi che potrebbero essere riconfezionati in ologrammi utilizzando molte meno “sezioni”. Le nuove tecniche sfruttano la capacità delle reti neurali convoluzionali di analizzare le immagini e separare le immagini in blocchi discreti. Questo nuovo metodo di analisi e suddivisione delle immagini riduce notevolmente il numero di operazioni totali che un sistema deve eseguire.

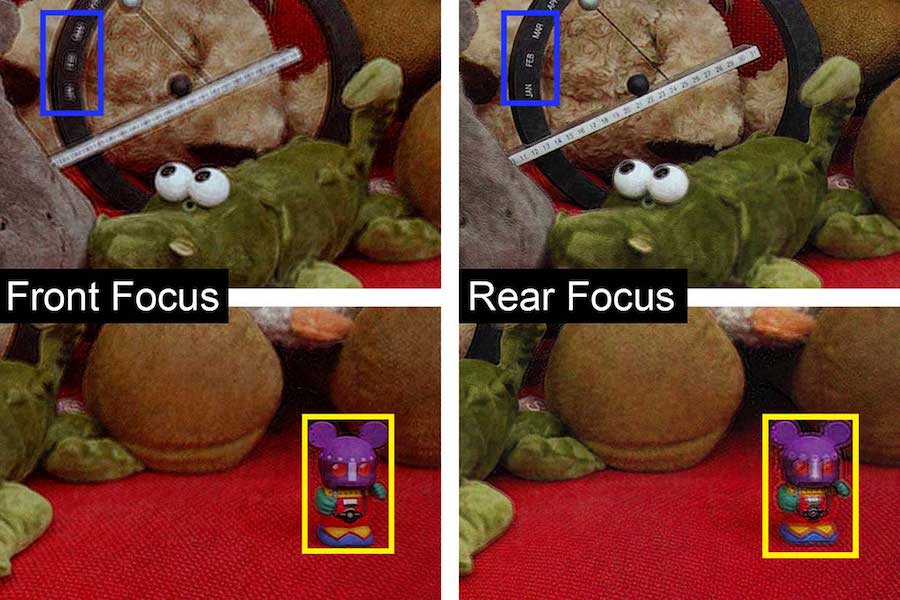

Per progettare il loro generatore olografico basato sull’intelligenza artificiale, il team di ricerca ha iniziato costruendo un database composto da circa 4000 immagini generate al computer, con un ologramma 3D corrispondente assegnato a ciascuna di queste immagini. La rete neurale convoluzionale è stata addestrata su questo set di dati, imparando come ciascuna delle immagini era collegata al suo ologramma e il modo migliore per utilizzare le funzionalità per generare gli ologrammi. Quando al sistema di intelligenza artificiale sono stati forniti dati invisibili con informazioni di profondità, è stato possibile generare nuovi ologrammi da questi dati. Le informazioni sulla profondità vengono fornite tramite l’uso di sensori lidar o di schermi multi-camera e sono rappresentate come un’immagine generata dal computer. Alcuni nuovi iPhone hanno questi componenti, il che significa che potrebbero potenzialmente generare gli ologrammi se collegati al giusto tipo di display.

Il nuovo sistema ologramma guidato dall’intelligenza artificiale richiede molta meno memoria rispetto ai metodi classici. Il sistema può generare ologrammi 3D a 60 fotogrammi al secondo a colori con una risoluzione di 1920 x 1080 utilizzando circa 620 kilobyte di memoria durante l’esecuzione su una singola GPU comunemente disponibile. I ricercatori sono stati in grado di eseguire i loro sistemi su un iPhone 11 producendo circa 1 ologramma al secondo, mentre un Google Edge TPU il sistema potrebbe eseguire il rendering di 2 ologrammi al secondo. Ciò suggerisce che il sistema potrebbe essere adattato a smartphone, dispositivi AR e dispositivi VR in generale. Il sistema potrebbe anche avere applicazioni per la stampa 3D volumetrica o nella progettazione di microscopi olografici.

In futuro, i miglioramenti alla tecnologia potrebbero introdurre hardware e software per il tracciamento degli occhi, consentendo agli ologrammi di ridimensionarsi dinamicamente in risoluzione mentre l’utente guarda luoghi particolari.