Un nuovo documento di quattro ricercatori di Google propone un sistema “esperto” in grado di rispondere in modo autorevole alle domande degli utenti senza presentare un elenco di possibili risultati di ricerca, simile al paradigma di domande e risposte che è giunto all’attenzione del pubblico con l’avvento di GPT-3 nel passato anno.

Il documento , intitolato Rethinking Search: Making Experts out of Dilettantes , suggerisce che lo standard attuale di presentare all’utente un elenco di risultati di ricerca in risposta a una richiesta è un “ carico cognitivo ” e propone miglioramenti nelle capacità di un linguaggio naturale sistema di elaborazione (PNL) per fornire una risposta autorevole e definitiva.

Il documento, guidato da Donald Metzler di Google Research, propone miglioramenti nel tipo di risposte oracolari multi-dominio che possono essere attualmente ottenute da modelli di linguaggio autoregressivo di apprendimento profondo come GPT-3. I principali miglioramenti previsti sono a) che il modello sarebbe in grado di citare accuratamente le fonti che hanno informato la risposta eb) che al modello sarebbe impedito di “ allucinare ” risposte o inventare materiale sorgente inesistente, che è attualmente un problema con tali architetture.

Formazione e capacità multi-dominio

Inoltre, il modello linguistico proposto, caratterizzato nel documento come “Un unico modello per tutte le attività di recupero delle informazioni”, verrebbe addestrato su una varietà di domini, comprese le immagini e il testo. Avrebbe anche bisogno di una comprensione della provenienza della conoscenza, che manca nelle architetture in stile GPT-3.

“Per sostituire gli indici con un modello unico e unificato, deve essere possibile per il modello stesso conoscere l’universo degli identificatori di documenti, allo stesso modo degli indici tradizionali. Un modo per ottenere questo risultato è allontanarsi dai LM tradizionali e puntare a modelli corpus che modellano congiuntamente le relazioni termine-termine, termine-documento e documento-documento “.

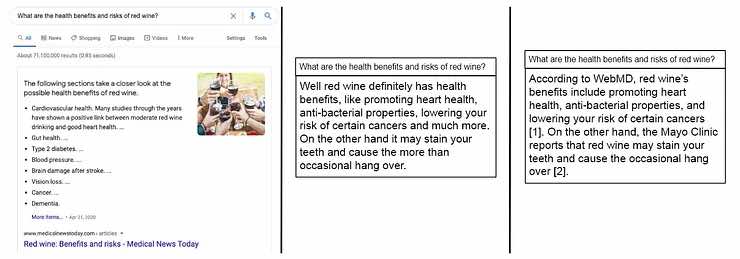

Nell’immagine sopra, dal documento, tre approcci in risposta a una richiesta dell’utente: a sinistra, i modelli linguistici impliciti nei risultati di ricerca algoritmica di Google hanno scelto e dato la priorità a una “risposta migliore”, ma l’hanno lasciata come il risultato principale di molti. Center, una risposta conversazionale in stile GPT-3, che parla con autorità, ma non giustifica le sue affermazioni o cita fonti. A destra, il sistema esperto proposto incorpora la “migliore risposta” dai risultati di ricerca classificati direttamente in una risposta didattica, con citazioni di note a piè di pagina in stile accademico (non raffigurate nell’immagine originale) che indicano le fonti che informano la risposta.

Rimozione di risultati velenosi e imprecisi

I ricercatori osservano che la natura dinamica e costantemente aggiornata degli indici di ricerca è una sfida da replicare interamente in un modello di apprendimento automatico di questa natura. Ad esempio, se una fonte un tempo attendibile è stata addestrata direttamente alla comprensione del mondo da parte del modello, rimuovere la sua influenza (ad esempio, dopo che è stata screditata) potrebbe essere più difficile della semplice rimozione di un URL dalle SERP, poiché i concetti di dati possono diventare astratto e ampiamente rappresentato durante l’assimilazione nella formazione.

Inoltre, un tale modello dovrebbe essere continuamente addestrato al fine di fornire lo stesso livello di reattività a nuovi articoli e pubblicazioni attualmente fornito dal costante scambio di fonti di Google. In effetti, ciò significa implementazione continua e automatizzata, in contrasto con il regime attuale, in cui vengono apportate modifiche minori ai pesi e alle impostazioni dell’algoritmo di ricerca in formato libero, ma l’algoritmo stesso viene solitamente aggiornato solo raramente.

Superfici di attacco per un Oracle esperto centralizzato

Un modello centralizzato che assimila e generalizza costantemente nuovi dati potrebbe trasformare la superficie di attacco per le richieste di ricerca.

Attualmente, un utente malintenzionato può ottenere vantaggi ottenendo un posizionamento elevato per domini o pagine che contengono informazioni errate o codice dannoso. Sotto gli auspici di un oracolo “esperto” più opaco, l’opportunità di reindirizzare gli utenti ai domini di attacco è notevolmente ridotta, ma la possibilità di iniettare attacchi di dati velenosi è notevolmente aumentata.

Questo perché il sistema proposto non elimina l’algoritmo di ranking della ricerca, ma lo nasconde all’utente, automatizzando efficacemente la priorità del / i risultato / i principale / i e trasformandolo (o loro) in una dichiarazione didattica. Gli utenti dannosi sono stati a lungo in grado di orchestrare attacchi contro l’algoritmo di ricerca di Google, vendere prodotti falsi , indirizzare gli utenti a domini di diffusione di malware o per scopi di manipolazione politica , tra molti altri casi d’uso.

Non AGI

I ricercatori sottolineano che è improbabile che un tale sistema possa qualificarsi come Artificial General Intelligence (AGI) e colloca la prospettiva di un responder esperto universale nel contesto dell’elaborazione del linguaggio naturale, soggetto a tutte le sfide che tali modelli devono affrontare attualmente.

Il documento delinea cinque requisiti per una risposta di “alta qualità”:

1: Autorità

Come con gli attuali algoritmi di classificazione, “autorità” sembra derivare da citazioni da domini di alta qualità che sono considerati autorevoli di per sé. I ricercatori osservano:

Le risposte dovrebbero generare contenuti attingendo a fonti altamente autorevoli. Questo è un altro motivo per cui è fondamentale stabilire connessioni più esplicite tra sequenze di termini e metadati del documento. Se tutti i documenti in un corpus sono annotati con un punteggio di autorevolezza, tale punteggio dovrebbe essere preso in considerazione durante l’addestramento del modello, la generazione delle risposte o entrambi. “

Sebbene i ricercatori non suggeriscano che i risultati delle SERP tradizionali non sarebbero disponibili se un oracolo esperto di questo tipo fosse risultato performante e popolare, l’intero articolo presenta il sistema di classificazione tradizionale e gli elenchi dei risultati di ricerca, alla luce di un ‘decenni vecchio e antiquato sistema di recupero delle informazioni.

“Il fatto stesso che la classificazione sia una componente critica di questo paradigma è un sintomo del sistema di recupero che fornisce agli utenti una selezione di potenziali risposte, che induce un carico cognitivo piuttosto significativo per l’utente. Il desiderio di restituire risposte invece di elenchi ordinati di risultati è stato uno dei fattori motivanti per lo sviluppo di sistemi di risposta alle domande. ‘

2: Trasparenza

I ricercatori commentano:

«Ogniqualvolta possibile, la provenienza delle informazioni presentate all’utente dovrebbe essere messa a loro disposizione. Questa è la principale fonte di informazioni? In caso negativo, qual è la fonte primaria? “

3: Gestire i

pregiudizi Il documento rileva che i modelli linguistici pre-addestrati sono progettati non per valutare la verità empirica, ma per generalizzare e dare la priorità alle tendenze dominanti nei dati. Ammette che questa direttiva apre il modello all’attacco (come è avvenuto con ilchatbot involontariamente razzista di Microsoftnel 2016) e che saranno necessari sistemi ancillari per salvaguardarsi da tali risposte di sistema distorte.

4: Abilitare diversi punti di vista

Il documento propone anche meccanismi per garantire una pluralità di punti di vista:

“Le risposte generate dovrebbero rappresentare una gamma di prospettive diverse ma non dovrebbero essere polarizzanti. Ad esempio, per domande su argomenti controversi, entrambi i lati dell’argomento dovrebbero essere trattati in modo equo ed equilibrato. Questo ovviamente ha stretti legami con il pregiudizio del modello. ‘

5: Lingua accessibile

Oltre a fornire traduzioni accurate nei casi in cui la risposta ritenuta autorevole è in una lingua diversa, il documento suggerisce che le risposte incapsulate dovrebbero essere “scritte nei termini più chiari possibili”.