I dati sintetici non proteggono in modo affidabile la privacy, affermano i ricercatori

Una nuova collaborazione di ricerca tra Francia e Regno Unito mette in dubbio la crescente fiducia dell’industria che i dati sintetici possano risolvere i problemi di privacy, qualità e disponibilità (tra gli altri problemi) che minacciano il progresso nel settore dell’apprendimento automatico .

Tra i vari punti chiave affrontati, gli autori affermano che i dati sintetici modellati da dati reali conservano abbastanza informazioni autentiche da non fornire alcuna protezione affidabile da inferenze e attacchi di appartenenza, che cercano di deanonimizzare i dati e riassociarli a persone reali.

Inoltre, gli individui più a rischio di tali attacchi, compresi quelli con condizioni mediche critiche o spese ospedaliere elevate (nel caso dell’anonimizzazione della cartella clinica), sono, a causa della natura “anomala” della loro condizione, più facilmente identificabili da queste tecniche.

Il documento osserva:

“Dato l’accesso a un set di dati sintetico, un avversario strategico può dedurre, con grande sicurezza, la presenza di un record di destinazione nei dati originali.”

Il documento rileva inoltre che i dati sintetici differenzialmente privati , che oscurano la firma dei singoli record, proteggono effettivamente la privacy degli individui, ma solo paralizzando significativamente l’utilità dei sistemi di recupero delle informazioni che li utilizzano.

Semmai, osservano i ricercatori, approcci differenzialmente privati – che utilizzano informazioni “reali” “in una sola volta” tramite dati sintetici – rendono lo scenario di sicurezza peggiore di quanto sarebbe stato altrimenti:

‘I set di dati [sintetici] non danno alcuna trasparenza su questo compromesso. È impossibile prevedere quali caratteristiche dei dati verranno preservate e quali modelli verranno soppressi.’

Il nuovo documento , intitolato Synthetic Data – Anonymisation Groundhog Day , arriva da due ricercatori dell’École Polytechnique Fédérale de Lausanne (EPFL) di Parigi e da un ricercatore dell’University College London (UCL).

I ricercatori hanno condotto test sugli algoritmi di addestramento dei modelli generativi privati esistenti e hanno scoperto che alcune decisioni di implementazione violano le garanzie formali sulla privacy fornite nei framework, lasciando diversi record esposti ad attacchi di inferenza.

Gli autori offrono una versione rivista di ciascun algoritmo che potenzialmente mitiga queste esposizioni e stanno rendendo il codice disponibile come libreria open source. Sostengono che ciò aiuterà i ricercatori a valutare i vantaggi sulla privacy dei dati sintetici e a confrontare utilmente i metodi di anonimizzazione più diffusi. Il nuovo framework incorpora due metodi di attacco alla privacy pertinenti che possono essere applicati a qualsiasi algoritmo di training del modello generativo.

Dati sintetici

I dati sintetici vengono utilizzati per addestrare i modelli di apprendimento automatico in vari scenari, compresi i casi in cui la mancanza di informazioni complete può essere potenzialmente riempita da dati surrogate. Un esempio di ciò è la possibilità di utilizzare volti generati in CGI per fornire foto di volti “difficili” o poco frequenti per set di dati di sintesi di immagini, in cui immagini di profilo, angoli acuti o espressioni insolite sono spesso viste raramente nel materiale di partenza.

Altri tipi di immagini CGI sono stati utilizzati per popolare set di dati che verranno eseguiti su dati non sintetici, come set di dati che presentano mani e mobili .

In termini di protezione della privacy, i dati sintetici possono essere generati da dati reali da sistemi di Generative Adversarial Network (GAN) che estraggono caratteristiche dai dati reali e creano record simili e fittizi che probabilmente si generalizzeranno bene a dati successivi (non visti, reali), ma hanno lo scopo di offuscare i dettagli di persone reali presenti nei dati di origine.

Metodologia

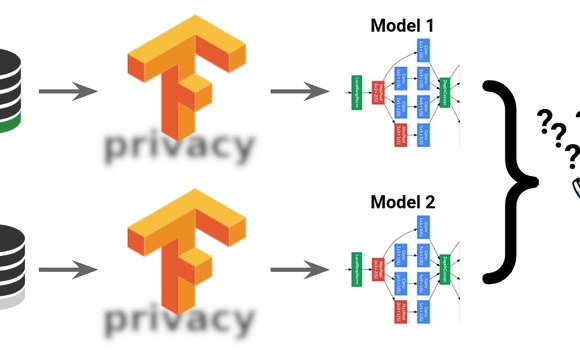

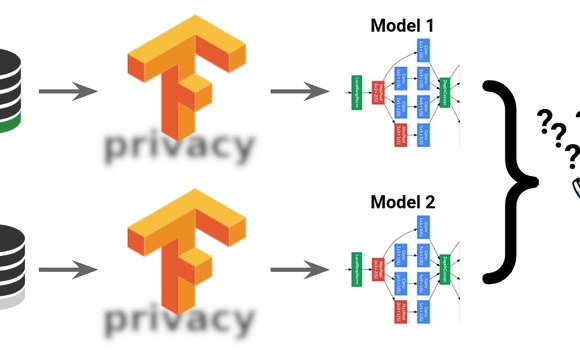

Ai fini della nuova ricerca, gli autori hanno valutato i guadagni sulla privacy attraverso cinque algoritmi di addestramento del modello generativo. Tre dei modelli non offrono una protezione esplicita della privacy, mentre gli altri due sono dotati di garanzie di privacy differenziate. Questi modelli tabulari sono stati scelti per rappresentare un’ampia gamma di architetture.

I modelli attaccati erano BayNet , PrivBay (una derivazione di PrivBayes/BayNet), CTGAN , PATEGAN e IndHist .

Il framework di valutazione per i modelli è stato implementato come una libreria Python con due classi principali: GenerativeModels e PrivacyAttacks . Quest’ultimo presenta due aspetti: un avversario di inferenza di appartenenza e un attacco di inferenza di appartenenza. Il framework è anche in grado di valutare i vantaggi in termini di privacy dei dati “sanitized” (ossia resi anonimi) e dei dati sintetici.

I due set di dati utilizzati nei test erano il set di dati per adulti dell’UCI Machine Learning Repository e il file di dati per l’uso pubblico dei dati di dimissione ospedaliera del Dipartimento dei servizi sanitari dello Stato del Texas. La versione del set di dati del Texas utilizzata dai ricercatori contiene 50.000 record campionati dai record dei pazienti per l’anno 2013.

Attacchi e risultati

L’obiettivo generale della ricerca è quello di stabilire la ‘linkability’ (la riassociazione di dati reali con dati sintetici a cui si è ispirata). I modelli di attacco utilizzati nello studio includono i classificatori Logistic Regression, Random Forests e K-Nearest Neighbors .

Gli autori hanno selezionato due gruppi target costituiti da cinque record selezionati casualmente per le categorie “minoritarie” della popolazione, poiché è più probabile che siano suscettibili a un attacco di linkage. Hanno anche selezionato i record con “valori di attributi categoriali rari” al di fuori di tale quantile di attributi al 95%. Gli esempi includono record relativi ad alto rischio di mortalità, elevate spese ospedaliere totali e gravità della malattia.

Sebbene il documento non approfondisca questo aspetto, dal punto di vista dei probabili aggressori del mondo reale, questi sono esattamente il tipo di pazienti “costosi” o “ad alto rischio” che più probabilmente saranno presi di mira dall’inferenza dell’appartenenza e da altri tipi di approcci di esfiltrazione. alle cartelle dei pazienti.

Diversi modelli di attacco sono stati addestrati contro le informazioni di riferimento pubblico per sviluppare “modelli ombra” su dieci obiettivi. I risultati di una serie di esperimenti (come descritto in precedenza) indicano che un certo numero di record era “altamente vulnerabile” agli attacchi di collegamento diretti contro di loro dai ricercatori. I risultati hanno anche scoperto che il 20% di tutti i target negli studi ha ricevuto un guadagno di privacy pari a zero dai dati sintetici prodotti dai metodi GAN.

I ricercatori osservano che i risultati variano a seconda del metodo utilizzato per generare dati sintetici, del vettore di attacco e delle caratteristiche del set di dati mirato. Il rapporto rileva che in molti casi, un’efficace soppressione dell’identità attraverso approcci di dati sintetici riduce l’utilità dei sistemi risultanti. In effetti, l’utilità e l’accuratezza di tali sistemi possono in molti casi essere un indice diretto di quanto siano vulnerabili agli attacchi di reidentificazione.

I ricercatori concludono:

‘Se un set di dati sintetico conserva le caratteristiche dei dati originali con elevata precisione, e quindi conserva l’utilità dei dati per i casi d’uso per cui è pubblicizzato, consente contemporaneamente agli avversari di estrarre informazioni sensibili sugli individui.

“Un alto guadagno in termini di privacy attraverso uno qualsiasi dei meccanismi di anonimizzazione che abbiamo valutato può essere ottenuto solo se la versione sintetica o igienizzata pubblicata dei dati originali non trasporta il segnale dei singoli record nei dati grezzi e in effetti sopprime il loro record.”