L’architettura neurale del linguaggio: la modellazione integrativa converge sull’elaborazione predittiva

Una nuova ricerca del Massachusetts Institute of Technology suggerisce che la funzione sottostante dei modelli computazionali di “previsione della parola successiva” assomiglia alla funzione dei centri di elaborazione del linguaggio nel cervello umano.

Significato del linguaggio

I nuovi modelli linguistici predittivi potrebbero imparare qualcosa sul significato sottostante del linguaggio, il che sarebbe un enorme passo avanti nel campo. I modelli prevedono la parola che verrà dopo, ma svolgono anche compiti che richiedono un grado di comprensione genuina. Queste attività includono la risposta alle domande, il riepilogo del documento e il completamento della storia.

I modelli sono stati progettati per ottimizzare le prestazioni per la previsione del testo senza tentare di imitare nulla riguardo al modo in cui il cervello umano comprende il linguaggio. Tuttavia, il team di neuroscienziati del MIT suggerisce che sta accadendo qualcosa in questo senso.

Una delle intuizioni più interessanti di questa ricerca è che i modelli di computer che funzionano bene su altri tipi di compiti linguistici non mostrano questa somiglianza con il cervello umano. Questo è visto come una prova che il cervello umano potrebbe utilizzare la previsione della parola successiva per eseguire l’elaborazione del linguaggio.

Nancy Kanwisher è Walter A. Rosenblith Professore di Neuroscienze Cognitive. È anche membro del McGovern Institute for Brain Research e del Center for Brains, Minds and Machines (CBMM) del MIT e autrice dello studio.

“Più il modello è in grado di prevedere la parola successiva, più si adatta al cervello umano”, afferma Kanwisher. “È incredibile che i modelli si adattino così bene e ciò suggerisce molto indirettamente che forse ciò che sta facendo il sistema del linguaggio umano è prevedere cosa accadrà dopo”.

Lo studio è apparso negli Atti della National Academy of Sciences .

Comprendeva anche gli autori senior Joshue Tenenbaum, professore di scienze cognitive al MIT e membro del CBMM e dell’Intelligenza Artificiale del MIT (CSAIL); ed Eveline Fedorenko, Frederick A. e Carole J. Middleton Professore Associato di Neuroscienze per lo sviluppo della carriera e membro del McGovern Institute. Il primo autore dell’articolo è stato Martin Schrimpf, uno studente laureato del MIT.

Lo studio

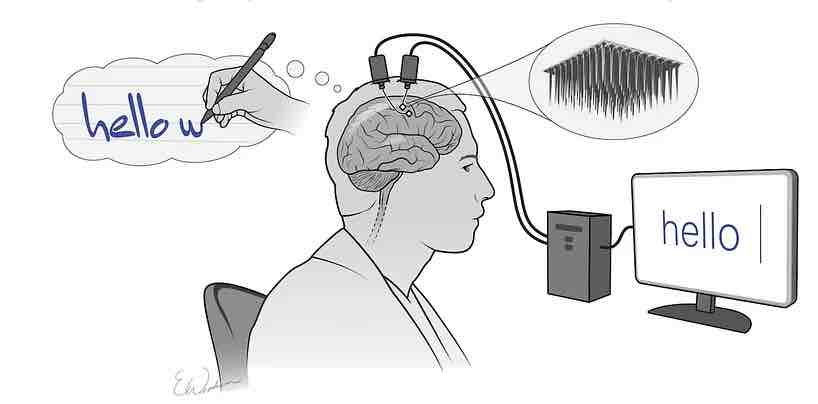

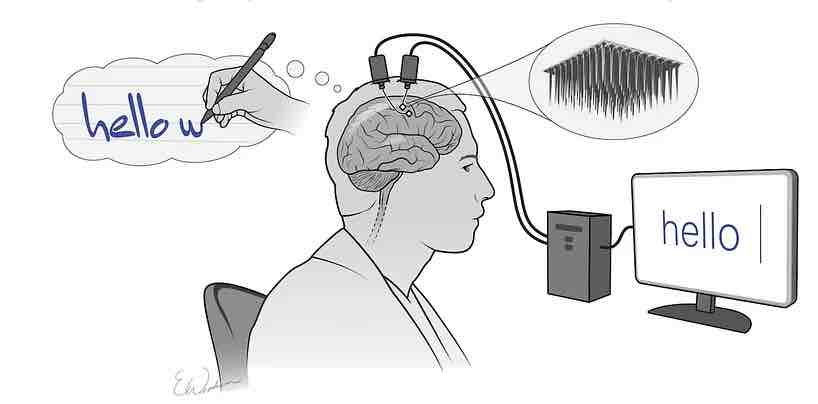

Il team del MIT ha confrontato i centri di elaborazione del linguaggio nel cervello umano con modelli di elaborazione del linguaggio. Hanno analizzato 43 modelli linguistici diversi, inclusi quelli ottimizzati per la previsione della parola successiva, come GPT-3. Altri modelli sono stati progettati per eseguire compiti linguistici diversi, come riempire uno spazio vuoto.

Ad ogni modello è stata presentata una stringa di parole e i ricercatori hanno misurato l’attività dei nodi che compongono la rete. I modelli sono stati quindi confrontati con l’attività nel cervello, che è stata misurata in soggetti che svolgono tre compiti linguistici: ascoltare storie, leggere le frasi una alla volta e leggere le frasi in cui viene rivelata una parola alla volta.

I set di dati umani includevano dati di risonanza magnetica funzionale (fMRI) e misurazioni elettrocorticografiche intracraniche che sono state prese da persone sottoposte a chirurgia cerebrale per epilessia.

I ricercatori hanno scoperto che i modelli di previsione della parola successiva più performanti avevano modelli di attività che assomigliavano molto a quelli osservati nel cervello umano. Quegli stessi modelli hanno anche dimostrato un’attività altamente correlata con misure di misure comportamentali umane come la velocità con cui le persone possono leggere il testo.

“Abbiamo scoperto che i modelli che predicono bene le risposte neurali tendono anche a prevedere meglio le risposte del comportamento umano, sotto forma di tempi di lettura. E poi entrambi sono spiegati dalle prestazioni del modello sulla previsione della parola successiva. Questo triangolo collega davvero tutto”, afferma Schrimpf.

I ricercatori ora cercheranno di costruire varianti dei modelli di elaborazione del linguaggio, che potrebbero consentire loro di vedere come piccoli cambiamenti nella loro architettura influenzano le prestazioni e la loro capacità di adattarsi ai dati neurali umani.