I modelli multimodali stanno rapidamente diventando una realtà: al diavolo le conseguenze

Circa un anno fa, abbiamo scritto sui progressi nel campo dell’intelligenza artificiale e dell’apprendimento automatico verso lo sviluppo di modelli multimodali o modelli in grado di comprendere il significato di testo, video, audio e immagini insieme nel contesto. A quei tempi, il lavoro era agli inizi e affrontava sfide formidabili, non ultime delle quali riguardavano i pregiudizi amplificati nei set di dati di addestramento. Ma sono state fatte scoperte.

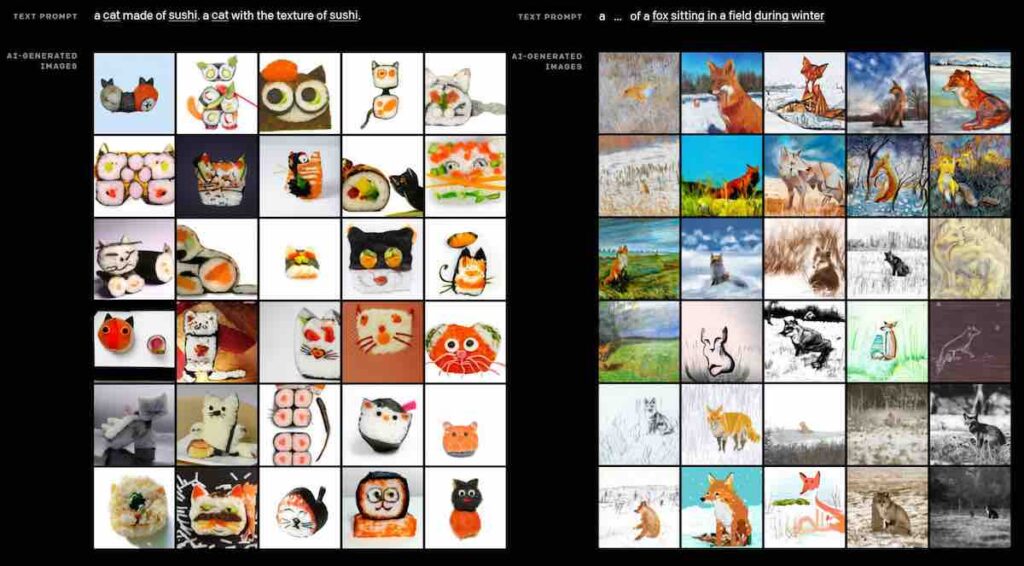

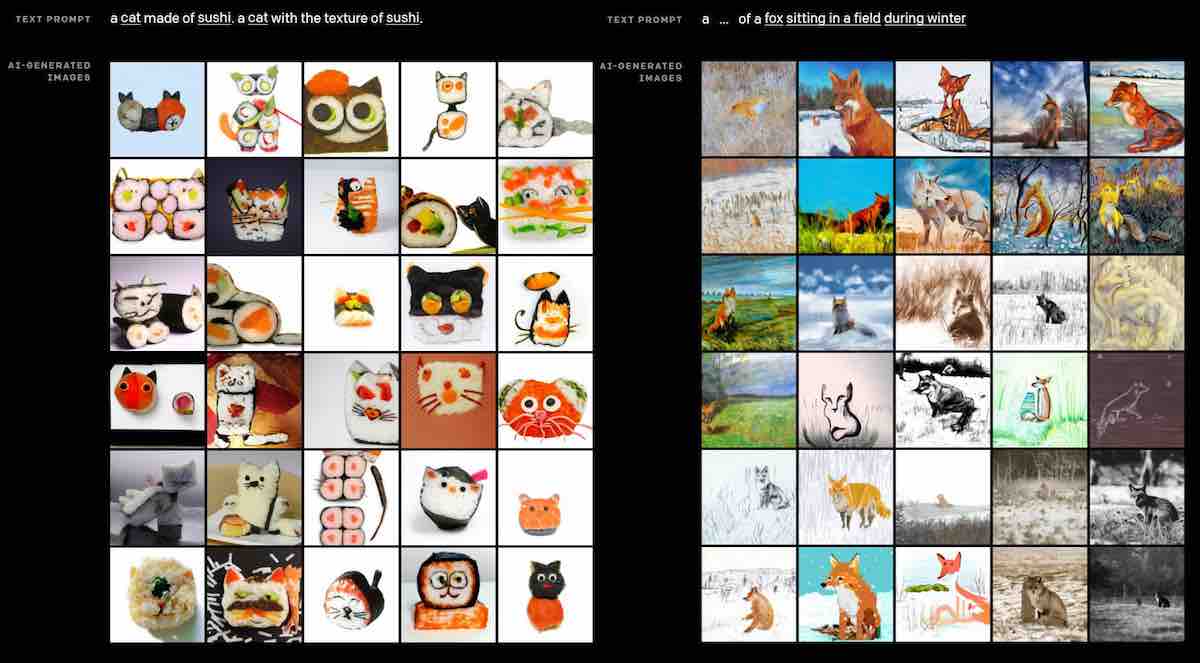

Quest’anno, OpenAI ha rilasciato DALL-E e CLIP , due modelli multimodali che i laboratori di ricerca affermano essere “un passo verso sistemi con [una] comprensione più profonda del mondo”. DALL-E, ispirato dall’artista surrealista Salvador Dalí, è stato addestrato a generare immagini da semplici descrizioni di testo. Allo stesso modo, CLIP (per “Pre-formazione lingua-immagine contrastante”) è stato addestrato ad associare concetti visivi al linguaggio, attingendo a foto di esempio abbinate a didascalie raschiate dal web pubblico.

DALL-E e CLIP sono solo la punta dell’iceberg. Diversi studi hanno dimostrato che un singolo modello può essere addestrato per apprendere le relazioni tra audio, testo, immagini e altre forme di dati. Alcuni ostacoli devono ancora essere superati, come il bias del modello. Ma già, modelli multimodali sono stati applicati ad applicazioni del mondo reale, incluso il rilevamento dell’incitamento all’odio.

Promettendo nuove direzioni

Gli esseri umani comprendono gli eventi nel mondo contestualmente, eseguendo ragionamenti multimodali nel tempo per fare inferenze sul passato, presente e futuro. Ad esempio, dato un testo e un’immagine che sembra innocua se considerati separatamente – ad esempio, “Guarda quante persone ti amano” e l’immagine di un deserto arido – le persone riconoscono che questi elementi assumono connotazioni potenzialmente dannose quando sono accoppiati o giustapposti .

Sopra: Merlot può capire la sequenza degli eventi nei video, come dimostrato qui.

Anche i migliori sistemi di intelligenza artificiale faticano in questo settore. Ma quelli come l’Allen Institute for Artificial Intelligence e i Multimodal Neural Script Knowledge Models (Merlot) dell’Università di Washington mostrano fino a che punto è arrivata la letteratura. Merlot, che è stato dettagliato in un documento pubblicato all’inizio dell’anno, impara ad abbinare le immagini nei video con le parole e segue gli eventi nel tempo guardando milioni di video di YouTube trascritti. Fa tutto questo in modo non supervisionato, il che significa che i video non devono essere etichettati o classificati: il sistema impara dalle strutture intrinseche dei video.

“Speriamo che il Merlot possa ispirare il lavoro futuro per l’apprendimento della visione e delle rappresentazioni linguistiche in un modo più simile a quello umano rispetto all’apprendimento dalle didascalie letterali e dalle immagini corrispondenti”, hanno scritto i coautori in un articolo pubblicato la scorsa estate. “Il modello raggiunge ottime prestazioni su attività che richiedono un ragionamento a livello di evento su video e immagini statiche”.

In questa stessa ottica, Google a giugno ha introdotto MUM , un modello multimodale addestrato su un set di dati di documenti dal web in grado di trasferire la conoscenza tra le lingue. MUM, a cui non è necessario insegnare esplicitamente come completare le attività, è in grado di rispondere a domande in 75 lingue, tra cui “Voglio fare un’escursione al Monte Fuji il prossimo autunno – cosa devo fare per prepararmi?” pur rendendosi conto che “prepararsi” potrebbe comprendere cose come il fitness e il tempo.

Un progetto più recente di Google, Video-Audio-Text Transformer (VATT), è un tentativo di costruire un modello multimodale ad alta capacità addestrando attraverso set di dati contenenti trascrizioni video, video, audio e foto. VATT può fare previsioni per più modalità e set di dati da segnali grezzi, non solo sottotitolando con successo gli eventi nei video, ma richiamando i video in base a una richiesta, classificando i clip audio e riconoscendo gli oggetti nelle immagini.

“Volevamo esaminare se esiste un modello in grado di apprendere rappresentazioni semantiche di diverse modalità e set di dati contemporaneamente (da segnali multimodali grezzi)”, ha detto a VentureBeat via e-mail Hassan Akbari, un ricercatore di Google che ha sviluppato in codice VATT. “All’inizio non ci aspettavamo nemmeno che convergesse, perché stavamo costringendo un modello a elaborare segnali grezzi diversi da modalità diverse. Abbiamo osservato che non solo è possibile addestrare un modello a farlo, ma le sue attivazioni interne mostrano modelli interessanti. Ad esempio, alcuni livelli del modello si specializzano [in] una modalità specifica saltando altre modalità. Gli strati finali del modello trattano tutte le modalità (semanticamente) allo stesso modo e le percepiscono quasi allo stesso modo”.

Da parte loro, i ricercatori di Meta, ex Facebook, affermano di aver creato un modello multimodale che raggiunge “prestazioni impressionanti” su 35 diversi compiti di visione, linguaggio e visione e linguaggio crossmodali e multimodali. Chiamato FLAVA, i creatori notano che è stato addestrato su una raccolta di set di dati disponibili apertamente circa sei volte più piccoli – decine di milioni di coppie testo-immagine – rispetto ai set di dati utilizzati per addestrare CLIP, a dimostrazione della sua efficienza.

“Il nostro lavoro indica la via da seguire verso modelli generalizzati ma aperti che si comportano bene su un’ampia varietà di attività multimodali”, tra cui il riconoscimento delle immagini e la generazione di didascalie, hanno scritto gli autori nel documento accademico che introduce FLAVA. “La combinazione di informazioni provenienti da diverse modalità in un’unica architettura universale è promettente non solo perché è simile al modo in cui gli umani danno un senso al mondo, ma anche perché può portare a una migliore efficienza del campione e a rappresentazioni molto più ricche”.

Per non essere da meno, un team di ricercatori della Microsoft Research Asia e della Peking University ha sviluppato NUWA , un modello che secondo loro può generare immagini e video nuovi o modificarli esistenti per varie attività di creazione di media. Formatosi su set di dati di testo, video e immagini, i ricercatori affermano che NUWA può imparare a sputare immagini o video in base a uno schizzo o a un messaggio di testo (ad esempio “Un cane con gli occhiali sta fissando la telecamera”), prevedere la scena successiva in un video da alcuni fotogrammi di metraggio o riempi automaticamente gli spazi vuoti in un’immagine parzialmente oscurata.

“[Le tecniche precedenti] trattano immagini e video separatamente e si concentrano sulla generazione di entrambi. Ciò limita i modelli a beneficiare sia dei dati di immagine che di quelli video”, hanno scritto i ricercatori in un articolo. “NUWA mostra capacità zero-shot sorprendentemente buone non solo sulla manipolazione delle immagini guidata dal testo, ma anche sulla manipolazione dei video guidata dal testo.”

Il problema del pregiudizio

I modelli multimodali, come altri tipi di modelli, sono suscettibili di distorsione, che spesso deriva dai set di dati utilizzati per addestrare i modelli.

In uno studio della University of Southern California e della Carnegie Mellon, i ricercatori hanno scoperto che un modello multimodale open source, VL-BERT, tende ad associare in modo stereotipato determinati tipi di abbigliamento, come i grembiuli, alle donne. OpenAI ha esplorato la presenza di bias nei neuroni multimodali, i componenti che costituiscono i modelli multimodali, incluso un neurone “terrorismo/Islam” che risponde a immagini di parole come “attacco” e “horror” ma anche “Allah” e “musulmano”. “

CLIP mostra anche dei pregiudizi, a volte classificando in modo orribile le immagini dei neri come “non umani” e degli adolescenti come “criminali” e “ladri”. Secondo OpenAI, il modello è anche pregiudizievole nei confronti di alcuni generi, associando termini che hanno a che fare con l’aspetto (es. “capelli castani”, “biondo”) e occupazioni come “tata” con immagini di donne.

Come il CLIP, i ricercatori dell’Allen Institute e dell’Università di Washington osservano che il Merlot può mostrare pregiudizi indesiderabili perché è stato addestrato solo su dati inglesi e segmenti di notizie in gran parte locali, che possono passare molto tempo a coprire storie di criminalità in modo sensazionale . Gli studi hanno dimostrato una correlazione tra guardare le notizie locali e avere convinzioni più esplicite e razzializzate sul crimine. È “molto probabile” che addestrare modelli come Merlot su contenuti per lo più di notizie possa indurli ad apprendere modelli sessisti e modelli razzisti, ammettono i ricercatori, dato che gli YouTuber più popolari nella maggior parte dei paesi sono uomini .

Al posto di una soluzione tecnica, OpenAI raccomanda “l’esplorazione della comunità” per comprendere meglio modelli come CLIP e sviluppare valutazioni per valutarne le capacità e il potenziale di uso improprio (ad esempio, la generazione di disinformazione). Questo, dicono, potrebbe aiutare ad aumentare la probabilità che i modelli multimodali vengano utilizzati in modo vantaggioso, facendo luce sul divario di prestazioni tra i modelli.

Applicazioni del mondo reale

Sebbene alcuni lavori rimangano saldamente nelle fasi di ricerca, aziende come Google e Facebook stanno attivamente commercializzando modelli multimodali per migliorare i loro prodotti e servizi.

Ad esempio, Google afferma che utilizzerà MUM per potenziare una nuova funzionalità in Google Lens, la tecnologia di riconoscimento delle immagini dell’azienda, che trova oggetti come l’abbigliamento in base a foto e descrizioni di alto livello. Google afferma inoltre che MUM ha aiutato i suoi ingegneri a identificare più di 800 varianti di nome COVID-19 in oltre 50 lingue.

In futuro, afferma Pandu Nayak, vicepresidente della ricerca di Google, MUM potrebbe connettere gli utenti alle aziende facendo emergere prodotti e recensioni e migliorando “tutti i tipi” di comprensione della lingua, sia a livello di servizio clienti che in un ambiente di ricerca. “La MAMMA può capire che quello che stai cercando sono le tecniche per aggiustare e qual è quel meccanismo”, ha detto a VentureBeat in una precedente intervista. “Il potere della MUM è la sua capacità di comprendere le informazioni a un livello ampio… Questo è il genere di cose che promettono i [modelli] multimodali”.

Meta, nel frattempo, riferisce che sta utilizzando modelli multimodali per riconoscere se i meme violano i suoi termini di servizio. L’azienda ha recentemente costruito e implementato un sistema, Few-Shot Learner (FSL), in grado di adattarsi per agire su tipi in evoluzione di contenuti potenzialmente dannosi in oltre 100 lingue. Meta afferma che, su Facebook, FSL ha aiutato a identificare contenuti che condividono informazioni fuorvianti in un modo che scoraggerebbe le vaccinazioni COVID-19 o che si avvicinano all’incitamento alla violenza.

I futuri modelli multimodali potrebbero avere implicazioni anche di più vasta portata.

I ricercatori della UCLA, della University of Southern California, di Intuit e della Chan Zuckerberg Initiative hanno rilasciato un set di dati chiamato Multimodal Biomedical Experiment Method Classification (Melinda) progettato per vedere se gli attuali modelli multimodali possono curare studi biologici e revisori umani. La cura degli studi è un processo importante, ma ad alta intensità di lavoro, eseguito dai ricercatori nelle scienze della vita che richiede il riconoscimento di metodi sperimentali per identificare i protocolli sottostanti che mettono in rete le cifre pubblicate negli articoli di ricerca.

Anche i migliori modelli multimodali disponibili hanno faticato su Melinda. Ma i ricercatori sperano che il benchmark possa motivare un ulteriore lavoro in questo settore. “Il set di dati Melinda potrebbe fungere da buon banco di prova per il benchmarking [perché] il riconoscimento [compito] è fondamentalmente multimodale [e impegnativo], in cui la giustificazione dei metodi dell’esperimento prende in considerazione sia le cifre che le didascalie”, hanno scritto in un articolo.

Per quanto riguarda DALL-E, OpenAI prevede che un giorno potrebbe aumentare o addirittura sostituire i motori di rendering 3D. Ad esempio, gli architetti potrebbero utilizzare lo strumento per visualizzare gli edifici, mentre gli artisti grafici potrebbero applicarlo alla progettazione di software e videogiochi. In un altro punto a favore di DALL-E, lo strumento potrebbe combinare idee disparate per sintetizzare oggetti, alcuni dei quali è improbabile che esistano nel mondo reale, come un ibrido tra una lumaca e un’arpa.

Aditya Ramesh, un ricercatore che lavora nel team DALL-E, ha dichiarato a VentureBeat in un’intervista che OpenAI si è concentrato negli ultimi mesi sul miglioramento delle capacità principali del modello. Il team sta attualmente studiando modi per ottenere risoluzioni delle immagini e fotorealismo più elevati, nonché modi in cui la prossima generazione di DALL-E – che Ramesh ha chiamato “DALL-E v2” – potrebbe essere utilizzata per modificare le foto e generare immagini più rapidamente .

Un documento che Ramesh ha scritto insieme ad altri ricercatori OpenAI offre uno sguardo su questo futuro. Descrive un modello multimodale chiamato Guided Language to Image Diffusion for Generation and Editing (GLIDE), che — come DALL-E — può creare foto con una breve didascalia. Ma GLIDE può anche essere messo a punto per modificare le immagini esistenti, ad esempio scambiando una foresta intorno a un’auto con una tundra abbinando lo stile e l’illuminazione dell’immagine originale. Nel documento, i coautori mostrano come GLIDE potrebbe essere utilizzato per creare una scena complessa generando un’immagine (ad esempio, con il suggerimento “un accogliente soggiorno”); aggiungere un quadro alla parete, un tavolino da caffè e un vaso di fiori sul tavolino; e spostando il muro fino al divano.

Sopra: GLIDE di OpenAI può apportare modifiche a foto esistenti o generare nuovi oggetti nelle foto in base a un prompt di testo.

“Molti dei nostri sforzi sono andati a rendere questi modelli implementabili nella pratica e [il] genere di cose su cui dobbiamo lavorare per renderlo possibile”, ha detto Ramesh. “Vogliamo assicurarci che, se a un certo punto questi modelli vengono resi disponibili a un vasto pubblico, lo facciamo in modo sicuro”.

Conseguenze di vasta portata

“DALL-E mostra creatività, producendo immagini concettuali utili per il prodotto, la moda e l’interior design”, ha scritto in un recente articolo di opinione Gary Grossman, responsabile globale del Centro di eccellenza AI di Edelman . “DALL-E potrebbe supportare il brainstorming creativo… sia con spunti di riflessione sia, un giorno, producendo immagini concettuali finali. Il tempo dirà se questo sostituirà le persone che svolgono questi compiti o sarà semplicemente un altro strumento per aumentare l’efficienza e la creatività”.

È solo l’inizio, ma l’ultimo punto di Grossman – che i modelli multimodali potrebbero sostituire, piuttosto che aumentare, gli esseri umani – è probabile che diventi sempre più rilevante man mano che la tecnologia diventa più sofisticata. (Entro il 2022, si stima che 5 milioni di posti di lavoro in tutto il mondo andranno persi a causa delle tecnologie di automazione, con il 47% dei posti di lavoro negli Stati Uniti a rischio di automazione.) Un’altra domanda correlata non affrontata è come le organizzazioni con meno risorse saranno in grado di sfruttare i modelli multimodali, dato i costi di sviluppo relativamente elevati dei modelli.

Un’altra questione irrisolta è come impedire che i modelli multimodali vengano abusati da attori malintenzionati, dai governi e criminali ai cyberbulli. In un articolo pubblicato dall’Institute for Human-Centered Artificial Intelligence (HAI) di Stanford, i coautori sostengono che i progressi nei modelli multimodali come DALL-E si tradurranno in contenuti di qualità superiore generati dalle macchine che saranno più facili da personalizzare per “l’uso improprio”. fini” – come pubblicare articoli fuorvianti mirati a diversi partiti politici, nazionalità e religioni.

“[I modelli multimodali] potrebbero… impersonare il discorso, i movimenti o la scrittura e potenzialmente essere utilizzati in modo improprio per mettere in imbarazzo, intimidire ed estorcere le vittime”, hanno scritto i coautori . “Le immagini deepfake generate e la disinformazione comportano maggiori rischi poiché la capacità semantica e generativa dei modelli di fondazione della visione continua a crescere”.

Ramesh afferma che OpenAI ha studiato metodi di filtraggio che potrebbero, almeno a livello di API, essere utilizzati per limitare il tipo di contenuto dannoso generato da modelli come DALL-E. Non sarà facile: a differenza delle tecnologie di filtraggio implementate da OpenAI per il suo modello GPT-3 di solo testo, i filtri di DALL-E dovrebbero essere in grado di rilevare elementi problematici nelle immagini e nel linguaggio che non avevano mai visto prima. Ma Ramesh crede che sia “possibile”, a seconda dei compromessi che il laboratorio decide di fare.

“C’è uno spettro di possibilità per quello che potremmo fare. Ad esempio, potresti persino filtrare tutte le immagini delle persone dai dati, ma il modello non sarebbe molto utile per un gran numero di applicazioni: probabilmente non saprebbe molto su come funziona il mondo”, ha affermato Ramesh. . “Pensare ai compromessi e a quanto lontano andare in modo che il modello sia dispiegabile, ma comunque utile, è qualcosa su cui ci siamo impegnati molto”.

Alcuni esperti sostengono che l’inaccessibilità dei modelli multimodali minaccia di ostacolare i progressi in questo tipo di ricerca di filtraggio. Ramesh ha ammesso che, con modelli generativi come DALL-E, il processo di formazione “sarà sempre piuttosto lungo e relativamente costoso”, specialmente se l’obiettivo è un singolo modello con un insieme diversificato di capacità.

Come si legge nell’articolo di Stanford HAI: “[L]e effettiva formazione dei modelli [multimodali] non è disponibile per la stragrande maggioranza dei ricercatori di intelligenza artificiale, a causa del costo computazionale molto più elevato e dei complessi requisiti ingegneristici … Il divario tra i modelli privati che l’industria possono allenarsi e quelli che sono aperti alla comunità rimarranno probabilmente grandi se non cresceranno… La fondamentale natura centralizzante dei modelli [multimodali] significa che la barriera all’ingresso per svilupparli continuerà a salire, in modo che anche le startup, nonostante la loro agilità , avrà difficoltà a competere, una tendenza che si riflette nello sviluppo dei motori di ricerca”.

Ma come ha dimostrato l’anno scorso, i progressi stanno avanzando, le conseguenze vadano al diavolo.