Gli assistenti basati sull’intelligenza artificiale come Siri, Cortana, Alexa e Google Assistant sono pervasivi. Ma affinché questi assistenti coinvolgano gli utenti e li aiutino a raggiungere i loro obiettivi, devono esibire un comportamento sociale appropriato e fornire risposte informative. Gli studi dimostrano che gli utenti rispondono meglio al linguaggio sociale, nel senso che sono più reattivi e più propensi a completare le attività. Ispirati da questo, i ricercatori affiliati a Uber e Carnegie Mellon hanno sviluppato un modello di apprendimento automatico che inietta il linguaggio sociale nelle risposte di un assistente preservandone l’integrità.

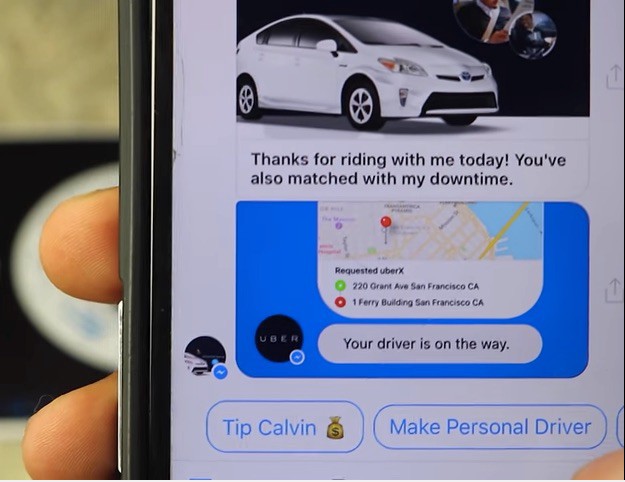

I ricercatori si sono concentrati sul dominio del servizio clienti, in particolare un caso d’uso in cui il personale del servizio clienti ha aiutato i conducenti a registrarsi con un fornitore di condivisione di corse come Uber o Lyft. In primo luogo hanno condotto uno studio per scoprire la relazione tra l’uso di un linguaggio amichevole da parte dei rappresentanti del servizio clienti per la reattività dei conducenti e il completamento del loro primo viaggio in condivisione. Quindi, hanno sviluppato un modello di apprendimento automatico per un assistente che include una componente di comprensione del linguaggio sociale e generazione del linguaggio.

Nel loro studio, i ricercatori hanno scoperto che il “livello di cortesia” dei messaggi rappresentativi del servizio clienti era correlato alla reattività del conducente e al completamento del loro primo viaggio. Basandosi su questo, hanno addestrato il loro modello su un set di dati di oltre 233.000 messaggi dei conducenti e le risposte corrispondenti dei rappresentanti del servizio clienti. Le risposte avevano etichette che indicavano quanto fossero generalmente educate e positive, principalmente secondo il giudizio dei valutatori umani.

Dopo la formazione, i ricercatori hanno utilizzato tecniche automatizzate e guidate dall’uomo per valutare la gentilezza e la positività dei messaggi del loro modello. Hanno scoperto che poteva variare la gentilezza delle sue risposte preservando il significato dei suoi messaggi, ma che aveva meno successo nel mantenere la positività generale. Lo attribuiscono a una potenziale discrepanza tra ciò che pensavano di misurare e manipolare e ciò che hanno effettivamente misurato e manipolato.

“Una spiegazione comune per l’associazione negativa della positività con la reattività del conducente in … e la mancanza di un effetto di miglioramento della positività sulle risposte degli agenti generate … potrebbe essere una discrepanza tra il concetto di positività del linguaggio e la sua operazionalizzazione come sentimento positivo”, hanno scritto i ricercatori in un documento che descrive in dettaglio il loro lavoro. “[Nonostante ciò, crediamo] i servizi di assistenza clienti possono essere migliorati utilizzando il modello per fornire risposte suggerite ai rappresentanti del servizio clienti in modo che possano (1) rispondere più rapidamente e (2) aderire alle migliori pratiche (ad esempio utilizzando più educato e un linguaggio positivo) pur raggiungendo l’obiettivo condiviso dai conducenti e dai fornitori di servizi di condivisione delle auto, ovvero portare i conducenti sulla strada “.

Il lavoro arriva poiché Gartner prevede che entro il 2020 solo il 10% delle interazioni cliente-azienda sarà condotto tramite voce . Secondo la ricerca dell’Aspect Consumer Experience Index del 2016 , il 71% dei consumatori desidera la capacità di risolvere la maggior parte dei problemi del servizio clienti da solo, con un aumento di 7 punti rispetto all’indice del 2015. E secondo lo stesso rapporto Aspect, il 44% ha affermato che preferirebbe utilizzare un chatbot per tutte le interazioni con il servizio clienti rispetto a un essere umano.