Alcuni di noi sanno esattamente perché: DL non può generalizzare

Gli esperti di intelligenza artificiale non dovrebbero offendersi quando i ricercatori AGI si lamentano delle inadeguatezze del deep learning. Nessuno vuole davvero sbarazzarsi di DL. Sebbene sia vero che l’avvento di AGI renderà DL obsoleto in alcuni campi, riteniamo che probabilmente continuerà ad essere utile per molte attività di automazione anche dopo che AGI sarà risolto. Ma, per fare progressi verso la risoluzione dell’AGI, i ricercatori devono sottolineare che DL non è solo inadeguato per risolvere l’AGI, è inutile. E alcuni di noi sanno esattamente perché è inutile.

Nessuna generalizzazione, nessuna AGI

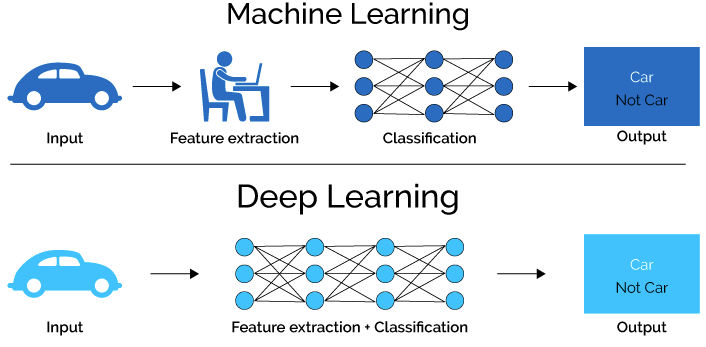

Il problema più grande con DL è la sua intrinseca incapacità di generalizzare efficacemente. Senza generalizzazione, i casi limite sono un problema insormontabile, qualcosa che l’industria dei veicoli autonomi ha scoperto nel modo più duro dopo aver sprecato più di $ 100 miliardi scommettendo su DL.

Una rete neurale profonda non può percepire questa bicicletta a meno che non sia stata precedentemente addestrata a riconoscerla.

La generalizzazione è la capacità di un sistema intelligente di percepire qualsiasi oggetto o modello senza riconoscerlo. Un indiano amazzonico, ad esempio, può percepire istantaneamente una bicicletta anche se non ne ha mai vista una prima. Può vedere istantaneamente la sua forma 3D, le dimensioni, i bordi, i colori, le sue varie parti, la sua posizione rispetto ad altri oggetti, se è simmetrico, opaco, trasparente o parzialmente occlusivo, ecc. Può percepire tutte queste cose perché il suo cervello ha la capacità di generalizzare. Inoltre, la sua percezione della bicicletta è automaticamente invariante rispetto alle trasformazioni del suo campo visivo. I bordi rimangono affilati e, se la bicicletta viene spostata in un altro luogo o cade a terra, rimane consapevole del fatto che sta ancora osservando lo stesso oggetto dopo la trasformazione. Sia l’invarianza che la continuità della percezione durante le trasformazioni sono componenti intrinseche della capacità di generalizzare. Pertanto, per generalizzare, un sistema intelligente deve essere in grado di riutilizzare istantaneamente i suoi blocchi cognitivi esistenti per percepire oggetti o schemi completamente nuovi senza doverli apprendere, cioè senza dover creare nuovi blocchi appositamente per loro.

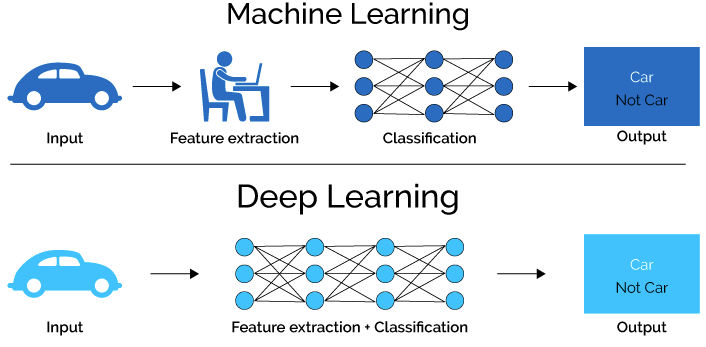

Con DL, la percezione è impossibile senza riconoscimento, cioè senza precedenti rappresentazioni apprese degli oggetti da percepire. Questo è un difetto fatale se l’obiettivo è risolvere AGI. Alcuni potrebbero sottolineare che, anche se l’indiano amazzonico nel nostro esempio sopra è in grado di percepire la bicicletta, non saprà a cosa serve una bicicletta. Questo è in parte vero, ma nemmeno una rete neurale profonda, anche dopo essere stata addestrata con milioni di immagini di diversi tipi di biciclette.La classificazione non è comprensione, nemmeno vicino.

Hubert Dreyfus, Martin Heidegger e la generalizzazione

La generalizzazione è la condizione sine qua non dell’intelligenza perché ci offre la capacità di percepire istantaneamente un’infinita varietà di oggetti, scene e modelli. Memorizzare rappresentazioni per tutto (l’approccio DL) è poco pratico, costoso e, in una parola, sciocco. A differenza delle rappresentazioni permanenti di DL, in un sistema con percezione generalizzata (ad esempio, il cervello), una volta che un percetto ha raggiunto il suo scopo (circa 10-20 millisecondi), quasi tutto viene dimenticato e sostituito con un nuovo percetto. Solo poche tracce di alto livello del percetto possono essere conservate in modo permanente, se necessario. I piccoli dettagli vengono dimenticati e persi. Ma questa non è una nuova comprensione dell’intelligenza.

Il defunto filosofo esistenzialista e critico irriducibile dell’intelligenza artificiale, Hubert Dreyfus , amava dire che “il mondo è il suo modello” e che “il miglior modello del mondo è il mondo stesso”. Era il suo modo di spiegare che creare rappresentazioni memorizzate per ogni cosa era un errore. Dreyfus ha basato le sue argomentazioni sul lavoro del suo filosofo tedesco preferito, Martin Heidegger , il quale sosteneva che l’essere o l’esistere nel mondo ( In-der-Welt-sein ) fosse sempre legato al contesto . Vale a dire, un sistema intelligente deve essere in grado di percepire istantaneamente e continuamente il mondo mentre cambia. Il mondo è quindi parte integrante e sempre presente del sistema. Dreyfus ha usato il termine inglese ” presenza a portata di mano” (dal tedesco “Vorhandensein” ) per riferirsi a questo principio di intelligenza.

Sosteniamo che il concetto di Heidegger di un’intelligenza legata al contesto, che percepisce continuamente il mondo in ogni istante, è esattamente ciò di cui si occupa la percezione generalizzata. Progettare un sistema intelligente che utilizza il mondo come proprio modello è il modo corretto per risolvere AGI. Certo, il cervello ha un “modello” di alto livello di come funziona il mondo memorizzato nella sua memoria, ma questo modello non è equivalente a ciò che percepiamo su base continua. Altrimenti, saremmo in grado di funzionare senza occhi, orecchie e altri organi sensoriali.

Il ridimensionamento è una falsa pista

L’incapacità di generalizzazione del deep learning è la ragione principale per cui l’industria automobilistica autonoma non è riuscita a produrre un’auto completamente autonoma. Devono incolpare solo se stessi perché un certo numero di pensatori ha scritto sui problemi con DL quando è diventato popolare. Alcuni nella comunità dell’IA insistono sul fatto che l’incapacità di generalizzare di DL può essere aggirata dal ridimensionamento, ma questo ovviamente non è vero. Il ridimensionamento è esattamente ciò che hanno fatto i ricercatori nel settore delle auto a guida autonoma. Non funziona. Il costo e i molti lunghi anni necessari per accumulare dati sufficienti diventano insostenibili perché i casi limite sono infiniti.

La fragilità delle reti neurali profonde non è dissimile da quella dei sistemi esperti basati su regole del secolo scorso. Se a uno di questi sistemi viene presentata una nuova situazione (o anche una leggera variazione di una situazione precedentemente appresa) per la quale non esiste alcuna regola o rappresentazione esistente, il sistema fallirà catastroficamente. I modelli contraddittori rimangono un grosso problema per DL. Le reti neurali profonde dovrebbero essere viste come sistemi esperti sotto steroidi. L’unico modo per aggirare la maledizione della dimensionalità è generalizzare.

Il cervello di un’ape è troppo piccolo per immagazzinare milioni di rappresentazioni.

Alcuni esperti in Large Language Models (LLM) hanno avanzato l’idea che, dati dati sufficienti, un LLM potrebbe iniziare a generalizzare. Non siamo esattamente sicuri di come si aspettino che la generalizzazione emerga dall’accumulo di enormi quantità di dati, ma è ovviamente un errore. La capacità di generalizzare non ha nulla a che fare con il ridimensionamento. È una capacità innata o incorporata. Anche i piccoli insetti generalizzano. Devono perché i loro minuscoli cervelli non possono immagazzinare milioni di rappresentazioni apprese di tutti gli oggetti e gli schemi che potrebbero incontrare nel corso della loro vita. In altre parole, la generalizzazione è esattamente ciò che è necessario quando il ridimensionamento è troppo costoso o non è un’opzione.

Cracking AGI non richiederà grandi computer e tasche profonde

Quasi tutti nella comunità dell’IA credono che l’unico modo per risolvere l’AGI sia con vaste risorse informatiche che costano molti milioni di dollari. A loro avviso, AGI può essere sviluppato solo da grandi aziende o istituti di ricerca governativi. Al contrario, crediamo che sia possibile craccare AGI su un normale computer desktop che costa meno di $ 1000. La generalizzazione percettiva non richiede miliardi di neuroni. Come abbiamo detto in articoli precedenti, un’umile ape ha meno di 1 milione di neuroni eppure può navigare e sopravvivere in ambienti 3D altamente complessi. L’ape può farlo perché può generalizzare. Emulare la capacità di generalizzazione del minuscolo cervello di un’ape equivarrebbe a risolvere l’AGI. Rompere la percezione generalizzata da sola sarebbe un risultato monumentale. Ridimensionamento e aggiunta del controllo del motore, un comportamento orientato agli obiettivi e una capacità di apprendimento delle lingue sarebbero un gioco da ragazzi in confronto. Non c’è motivo per cui la generalizzazione non possa essere raggiunta e dimostrata su piccola scala con poche migliaia di neuroni.

La maggior parte dei nostri futuri robot intelligenti non richiederà intelligenza a livello umano.

Sulla base delle nostre osservazioni sul comportamento degli insetti, stimiamo che la piena guida autonoma possa probabilmente essere raggiunta con meno di 50 milioni di neuroni. Un robot domestico in grado di imparare a pulire la casa, fare il bucato, preparare i pasti e curare il giardino può probabilmente essere fatto con meno di 100 milioni di neuroni. In altre parole, la maggior parte delle nostre future macchine intelligenti non richiederà intelligenza a livello umano.

Sì, il ridimensionamento a piena intelligenza a livello umano o oltre sarà costoso, ma sarà un problema di ingegneria con una soluzione nota. Non è un requisito per risolvere il problema AGI. Inoltre, ci sono buone ragioni per credere che il ridimensionamento dell’intelligenza a livello umano richiederà solo una piccola frazione degli 86 miliardi circa di neuroni nel cervello umano. Meno di un miliardo sarà probabilmente sufficiente per quasi tutti i compiti. La ragione di ciò è che il numero di neuroni in un cervello, artificiale o no, è una funzione del numero dei suoi sensori ed effettori. I nostri futuri robot avranno pochissimi sensori ed effettori rispetto a esseri umani e animali.

Tutto questo significa che l’AGI può essere violato da un anticonformista solitario che lavora a casa? La risposta è si.

Il tempismo e la simmetria sono alla base di tutto nell’intelligenza

Un certo numero di luminari nella comunità di ricerca DL, e anche alcuni critici esterni di DL, hanno proposto che la via da seguire sia quella di modificare DL in modo tale da dargli la capacità di generalizzare e ragionare in modo causale. Alcuni, come lo psicologo Gary Marcus e i suoi colleghi, credono che il modo per farlo sia con un’intelligenza ibrida che combini DL con AI simbolica, il modello AI fallito del 20° secolo. Non c’è alcun dubbio nelle nostre menti che questo approccio fallirà.

La generalizzazione non può essere un ripensamento o un’aggiunta ai modelli esistenti. Deve essere una parte essenziale dell’intelligenza a livello fondamentale. Ogni componente di un sistema intelligente generalizzato deve essere progettato tenendo presente la generalizzazione e, a nostro avviso, ciò include sensori ed effettori. La retina umana, ad esempio, non è un semplice sensore fotografico. Consiste in molti piccoli campi ricettivi centro-circondati progettati per rilevare piccoli bordi a varie angolazioni. Ipotizziamo che questi rilevatori di bordo siano i mattoni fondamentali della percezione visiva generalizzata. Allo stesso modo, supponiamo che la percezione uditiva generalizzata dovrebbe essere costruita con analoghi rivelatori di bordo di frequenza.

Proponiamo che l’intelligenza generalizzata sia basata sulla temporizzazione e sulla simmetria del segnale. Non è un caso che i neuroni biologici, compresi i sensori, emettano picchi. Un picco è un indicatore temporale di breve durata che indica che si è appena verificato un evento. L’apprendimento Hebbian ( STDP ), che si basa sulla tempistica dei picchi, è il metodo principale di apprendimento associativo utilizzato nel cervello. Inoltre, non è un caso che i sensori biologici siano disponibili in coppie complementari. Le cellule della retina rilevano bordi positivi (da scuro a chiaro) e negativi (da chiaro a scuro). Questa simmetria yin-yang può essere osservata nel cablaggio di tutte le cortecce sensoriali ed è evidente anche nella corteccia motoria. Il controllo motorio si basa su segnali neuronali complementari (picchi eccitatori e inibitori) che avviano un’attivazione motoria o la arrestano.

Fortunatamente, non siamo soli nella nostra ricerca di un meccanismo percettivo universale in grado di generalizzare. Un certo numero di ricercatori nel campo delle neuroscienze computazionali ha lavorato su un concetto che alcuni chiamano generalizzazione sistematica , la capacità delle mappe cognitive flessibili di modificarsi istantaneamente per ogni nuova eventualità nel loro ambiente. Questo è l’approccio corretto all’AGI a nostro avviso. È qui che dovrebbe essere spesa la maggior parte del denaro stanziato per la ricerca sull’IA.

Conclusione

In questo articolo, abbiamo sostenuto che il deep learning non ha nulla a che fare con la vera intelligenza a causa della sua intrinseca incapacità di generalizzare. Abbiamo sostenuto che né il ridimensionamento né le aggiunte ai modelli di apprendimento esistenti porteranno all’AGI. Abbiamo ipotizzato che la maggior parte dei nostri sistemi intelligenti non avrà bisogno di operare a livello umano e che la base dell’AGI è la temporizzazione del segnale e la simmetria yin-yang. Stiamo pianificando di rilasciare (in un futuro non troppo lontano) un’applicazione dimostrativa di riconoscimento vocale resistente al rumore (meno di 5 dB SNR) basata sulle nostre idee. Grazie per aver letto.

da Rebel Science