Kalev Leetaru

L’apprendimento profondo di oggi condivide molto in comune con i trucchi da salotto di vecchia data. Date le circostanze ideali, i modelli di apprendimento profondo possono sfornare quelle che sembrano essere imprese straordinarie di intelligenza quasi umana o addirittura superumana. Il problema è che nel mondo reale questo castello di carte correlativo viene rapidamente abbattuto. Piuttosto che “apprendere” il mondo, gli algoritmi odierni si limitano a codificare database di correlazioni statistiche semplicistiche che producono risultati che dipendono interamente dalla somiglianza degli input con i dati di addestramento. Gli algoritmi di traduzione neurale ipotizzati come sostitutivi degli umani nella realtà oscillanoselvaggiamente tra scioltezza umana e indecifrabilità senza senso con il cambio di una sola parola. Le auto senza conducente possono sbattere sui freni o accelerare verso un ostacolo con la minima deviazione dai loro esempi di allenamento, mentre gli algoritmi di comprensione delle immagini sono resi impotenti da alcuni pixel spuri. Mentre le aziende si affrettano a implementare un apprendimento approfondito, stanno costruendo il nostro mondo moderno su un castello di carte straordinariamente fragile. Affinché l’apprendimento profondo possa davvero decollare, dobbiamo andare oltre questi trucchi di lusso per sistemi che possono fare di più che scrivere poche semplici correlazioni nel codice.

Sbuccia tutto l’hype e l’iperbole e c’è molto meno rispetto alle meraviglie dell’apprendimento profondo di oggi che incontra l’occhio.

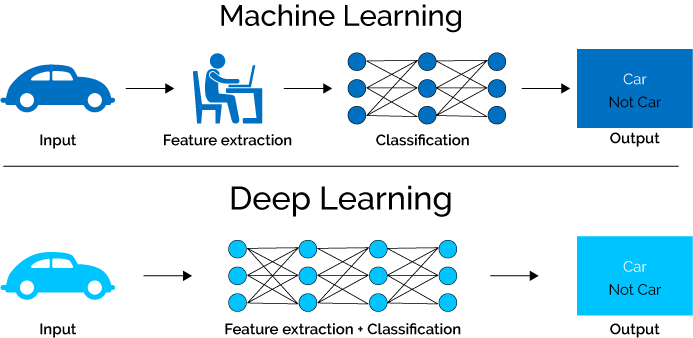

Date le circostanze ideali e dati di input che corrispondono strettamente ai loro dati di allenamento, gli algoritmi odierni possono produrre prestazioni simili a quelle umane. Eppure, al di sotto della stupefacente meraviglia delle macchine che imitano gli umani, la realtà è che questa performance si basa su una semplice raccolta di correlazioni statistiche ingenue codificate nel software.

Proprio come i loro predecessori statistici classici, gli odierni algoritmi di deep learning non “apprendono” il mondo a un livello semantico che consentirebbe ragionamento e astrazione oltre i loro dati di addestramento.

Al contrario, codificano semplicemente i pattern dei loro dati di addestramento nel modo più preciso possibile e tentano di abbinare i dati in arrivo con il modello più simile estratto dai loro esempi di addestramento.

Proprio come potrebbe sembrare una correlazione di Pearson a chi non lo sapesse una prodezza magica di “apprendimento automatico”, anche le raccolte di queste correlazioni che lavorano insieme sembrano rappresentare qualcosa di molto più grande, un’intelligenza di silicio che sta pensando e ragionando sul mondo.

La realtà è che questi cumuli semplicistici di correlazioni non possono andare oltre i confini dei loro dati di allenamento.

Peggio ancora, queste correlazioni mancano della capacità di ragionare sui loro dati di allenamento in termini di relazioni semantiche piuttosto che di semplice coincidenza sintattica. L’immagine di un cane in un parco non è “vista” come un mammifero a quattro zampe coperto di pelliccia in piedi nell’erba, ma piuttosto come un assortimento di pixel di determinati colori e trame in certi arrangiamenti che si trovano più spesso in immagini etichettate come “Cane” rispetto ad altre immagini.

Queste correlazioni primitive significano che i nostri modelli sono straordinariamente fragili e offrono poco più dei trucchi da salotto economici per cui sono conosciuti.

Mentre quei trucchi del parlatorio sono sufficienti per i compiti semplicistici a cui sono applicati oggi gli algoritmi di deep learning, i loro limiti sono uno dei motivi per cui le soluzioni AI falliscono in modo così spettacolare con casi limite sconosciuti.

Soprattutto, sono le ragioni per le quali le compagnie di IA avvolgono i loro algoritmi con così tanto marketing e iperbole e vincolano così attentamente le condizioni in cui vengono utilizzati, al fine di conservare la mistica, il mistero e la magia che sostengono l’interesse del pubblico per l’apprendimento profondo e che sarebbe a rischio se il pubblico capisse veramente quanto siano davvero limitati gli algoritmi attuali.

Significativamente, nelle applicazioni life-or-death di deep learning come auto senza conducente, l’instabilità e la fragilità degli algoritmi di deep learning sono murate con algoritmi tradizionali codificati a mano.

Questo rifiuto di accettare gli enormi limiti dell’apprendimento correlativo di oggi è estremamente dannoso per il futuro del settore in quanto incoraggia le aziende ad adottare algoritmi pericolosamente fragili e instabili che sono spesso molto peggiori degli algoritmi classici e codificati a mano che sostituiscono, creando una crisi di fiducia nella rivoluzione dell’IA.

Mettendo tutto questo insieme, come ho notato l’anno scorso, “ascrivendo le nostre aspirazioni a banali pile di codice, antropomorfizzandole in intelligenze viventi del silicio vivente, piuttosto che rappresentazioni puramente statistiche di modelli nei dati, perdiamo traccia dei loro limiti reali. e pensare in termini di iperbole utopica piuttosto che il vero e proprio calcolo del rischio necessario per garantire la loro sicura e solida integrazione nelle nostre vite. “

Alla fine, per imparare in profondità ad andare oltre i trucchi da salotto economici verso soluzioni che possano realmente far progredire la società, dobbiamo andare oltre gli attuali approcci correlativi e semplicistici trucchetti verso algoritmi che possono effettivamente ragionare semanticamente sul mondo.